Kaum ein netzpolitisches Vorhaben der EU bekommt derzeit so viel Gegenwind wie die sogenannte Chatkontrolle. Um Darstellungen sexualisierter Gewalt gegen Minderjährige im Netz zu bekämpfen, plant die EU drastische Eingriffe in private Kommunikation. So sollen Anbieter auf Anordnung etwa private Chats durchleuchten und Fotos scannen. Selbst die höchsten EU-Datenschutzbehörden haben den Entwurf komplett zerrissen.

Nun zeigt ein internes Stimmungsbild der Rats-Arbeitsgruppe Strafverfolgung, dass es bei einigen Mitgliedstaaten Skepsis gibt – aber auch Zustimmung. Das Papier stammt vom Juli 2022 und kann aus Gründen des Quellenschutzes nicht veröffentlicht werden. Demnach gibt es die schwersten Bedenken bei der Frage, ob Chatkontrolle auch auf verschlüsselte Kommunikation ausgeweitet werden soll.

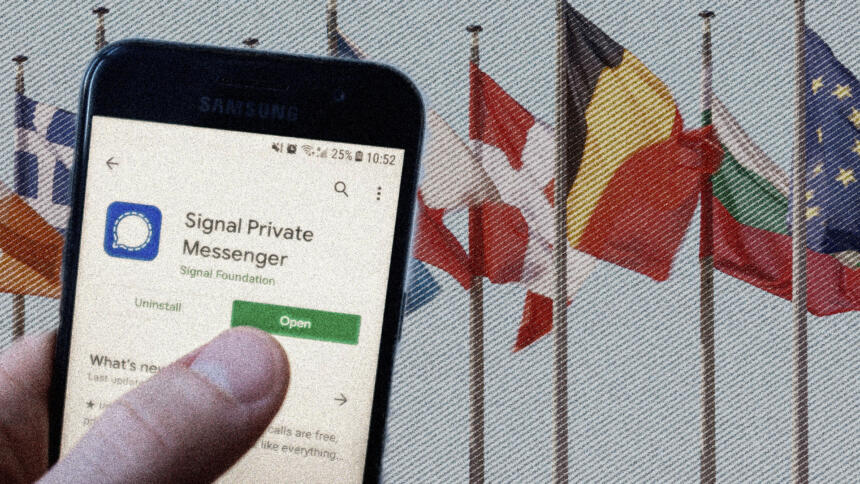

Ende-zu-Ende-verschlüsselte Chats wie WhatsApp, Signal oder Threema stellen sicher, dass nur Sender:in und Empfänger:in eine Nachricht lesen können. Um solche Nachrichten zu scannen, müssten sie entweder bereits auf dem Gerät durchsucht werden oder die Verschlüsselung müsste gebrochen werden.

Für eine solche Chatkontrolle in verschlüsselter Kommunikation gibt es dem Papier zufolge von keinem einzigen Mitgliedstaat eine ausdrückliche Zustimmung. Ausdrücklich dagegen seien Deutschland und Österreich. Unklare Positionen gebe es hierzu bei vier Staaten: Niederlande, Belgien, Griechenland, Frankreich.

Österreich: Massive Bedenken

Österreich habe massive Bedenken in Bezug auf Grundrechte, insbesondere der Verletzung des Rechts auf Privatsphäre, heißt es in dem Dokument. Faktisch könnten die Inhalte von Nachrichten nur mitgelesen werden, wenn die sichere Ende-zu-Ende-Verschlüsselung grundsätzlich gebrochen werde. Die Fehlerrate bei der automatischen Erkennung von Inhalten ist demnach problematisch hoch.

Deutlich mehr Staaten stimmen der eher allgemeinen Frage zu, ob eine umfassende Chatkontrolle eingeführt werden soll – ohne näher zu definieren, ob verschlüsselte Kommunikation auch darunter falle. Fachleute warnen davor, Millionen Nutzer:innen pauschal unter Verdacht zu stellen. Ausdrücklich gut finden das jedoch sieben EU-Staaten: Frankreich, Bulgarien, Ungarn, Rumänien, Niederlande, Lettland, Finnland. Klar dagegen ist dem Papier zufolge nur Österreich.

Deutschland windet sich noch

Die Position von Deutschland geht aus dem Papier nicht klar hervor, generell unterstützt die Bundesregierung den Vorschlag der EU-Kommission wohlmeinend. So weist die deutsche Vertretung darauf hin, dass Maßnahmen dann in Ordnung seien, wenn die Vertraulichkeit von Kommunikation gewahrt werde. Diese dürfe weder rechtlich noch technisch untergraben werden. Dazu solle in der geplanten Verordnung explizit festgehalten werden, dass Verschlüsselung nicht gebrochen werden darf.

Auch stärkere Alterskontrollen heiße Deutschland willkommen, solange anonyme Nutzung garantiert sei. Das geplante Gesetz würde Anbieter dazu verpflichten, verstärkt Alterskontrollen einzuführen. So sollen sie Minderjährige identifizieren und verhindern, dass sich Erwachsene als Kinder ausgeben, um Kontakte anzubahnen. Das nennt man auch Cybergrooming.

Deutschland hatte der EU-Kommission einen langen Fragenkatalog zum geplanten Gesetz geschickt. Darin stellte die Regierung unter anderem kritische Fragen zur geplanten Alterskontrolle oder den Fehlerraten bei der Erkennung. Die EU-Kommission gab die Antworten nur mündlich und teils oberflächlich.

Keine Einigkeit in der Koalition

Hinter der ambivalenten Position von Deutschland steckt wohl auch ein Streit innerhalb der Ampelkoalition. Ende August erteilten die FDP-geführten Justiz- und Digitalministerien den wichtigsten Bausteinen der Chatkontrolle eine Absage. Verantwortlich für die Aushandlung des Gesetzes ist allerdings das SPD-geführte Innenministerium. Aus dem Ministerium von Nancy Faeser sind verschiedene und ambivalente Positionen zu vernehmen, klare Ansagen sind nicht öffentlich dokumentiert.

Aus den Reihen der Grünen haben sich einige Politiker:innen öffentlich kritisch positioniert, unter anderem Familienministerin Lisa Paus. Sie sagte auf einer Konferenz, sie sei gegen eine Chatkontrolle bei privater Kommunikation. Als Bundesministerin ist Paus auch für Kinder und Jugendliche zuständig – also genau die Gruppe, die durch die Chatkontrolle eigentlich geschützt werden sollte.

Die Verhandler:innen in Brüssel unterscheiden zwischen Chatkontrolle im Allgemeinen und Chatkontrolle für private, verschlüsselte Kommunikation. Das könnte ein Hinweis darauf sein, dass eine abgespeckte Version des Vorhabens bereits eine Option ist. Aus dem Stimmungsbild geht allerdings auch hervor, dass viele der 27 Mitgliedstaaten wohl noch keine klare Position bezogen haben. Andere Staaten, die sich in die Debatte eingebracht haben, formulieren teils kritische Rückfragen. So wünschen sich die Niederlande etwa mehr Informationen zum Scannen und Verschlüsseln, Litauen weist auf nötigen Datenschutz hin.

Vergleich mit Spam-Filtern

Weitere Details zu den EU-Plänen liefert ein „Nur für den Dienstgebrauch“ eingestufter Drahtbericht aus einer weiteren Sitzung der Rats-Arbeitsgruppe, den wir im Volltext veröffentlichen. Um bekannte Darstellungen von Gewalt gegen Kinder zu entdecken, sieht die EU-Kommission demnach Technologien wie das Microsoft-Produkt PhotoDNA als geeignet an. Für das Aufspüren von neuem, bislang unbekanntem Material und von Grooming komme „KI, ähnlich der Technologien zum Erkennen von SPAM/Virus-Inhalten“ in Betracht.

Niederlande, Slowenien und Frankreich haben laut Bericht um eine Darstellung der Technologien gebeten, die Inhalte überprüfen können. Laut der geplanten Verordnung soll ein neues EU-Zentrum Anbietern solche Technologien kostenlos zur Verfügung stellen. Erhalten Anbieter eine Anordnung zur sogenannten Chatkontrolle, müssten sie die Technologie anwenden und damit nach Grooming und Bildmaterial suchen.

Fachleute beurteilen die bislang zur Verfügung stehenden Technologien für das Aufspüren von unbekanntem Material und Grooming kritisch. Die EU-Kommission selbst hat zugestanden, dass die Erkennungstechnologien derzeit hohe Fehlerquoten aufweisen, nimmt diese aber in Kauf.

Keine Hintertüren, aber „Kindersicherheit by design“

Eine weitere Frage der Mitgliedstaaten war dem Papier zufolge, ob Anbieter vornherein „Hintertüren“ in ihre Produkte einplanen müssten, noch bevor sie eine Anordnung zur Chatkontrolle erhalten. Laut Kommission seien Anbieter verpflichtet „Kindersicherheit by design“ in ihren Produkten sicherzustellen, also dafür zu sorgen, dass die Risiken von vornherein minimiert werden. Eine „Hintertür“ sei in der Verordnung aber nicht vorgesehen. Anbieter würden auch nicht haften, wenn es für ihre Plattformen keine funktionierende Technologie gebe. In so einem Fall könne keine Anordnung zur Durchsuchung gestellt werden.

Bei der Debatte um Chatkontrolle spielt auch die Zivilgesellschaft eine Rolle. In Deutschland haben Organisationen für Bürger:innenrechte bereits einen Straßenprotest organisiert. Selbst einige Kinderschutz-NGOs kritisieren den EU-Vorstoß scharf.

Hier das Dokument in Volltext:

- Geheimhaltungsgrad: VS-Nur für den Dienstgebrauch

- Datum: 25.07.2022

- Von: Ständige Vertretung EU Brüssel

- An: E11, Leitung

- Kopie: BMI, BMWK, BMDV, BMFSFJ, BMBF, BMG, BMJ, BKAMT

- Betreff: Sitzung der RAG Strafverfolgung (LEWP) am 20.07.2022

- Geschäftszeichen: Pol 350.80/1

I. Zusammenfassung und Wertung

Schwerpunkt der RAG-Sitzung war die die Diskussion der Artikel 8-15 des Entwurfes einer Verordnung zur wirksameren Bekämpfung des sexuellen Missbrauchs von Kindern.

Die nächste Sitzung ist für den 6. September geplant.

II. Im Einzelnen

1. Adoption of the Agenda

Die Tagesordnung wurde ohne Änderungen angenommen.

2. Information by the Presidency

Präs informierte zunächst über die wesentlichen Inhalte des informellen JI-Rates und des informellen COSI. Schwerpunkt der Aussprachen seien jeweils die Folgen des Krieges in der Ukraine gewesen. Als weiteres Thema sei die CSA-VO adressiert worden. Der JI-Rat habe festgestellt, dass die Prävention von CSAM im Vordergrund des VO-E stehe; die Diensteanbieter sollten sich auf die Entfernung illegaler Inhalte fokussieren.

Präs informierte auch über den aktuellen Schengenraumbericht für das Jahr 2022, der am 10.06.2022 verabschiedet worden sei. Soweit die dort identifizierten Themen auch die Arbeit der LEWP beträfen, werde Präs hierzu noch informieren.

Zum Follow-up der „8th round of mutual evaluations (environmental crime)“ habe es zahlreiche Verhandlungen mit COPEN gegeben. Präs werde an FRA-Aktivitäten anknüpfen, es seien allerdings noch etwa 20 follow-up Berichte zu behandeln. Dazu bedürfe es entweder drei gemeinsamer Sitzungen (LEWP und COPEN) zur Behandlung der offenen Berichte sowie einer weiteren zur Behandlung des Abschlussberichts oder nur einer gemeinsamen Sitzung, in der lediglich der Abschlussbericht behandelt und verabschiedet würde. Zu dieser Sitzung würde dann auch EUROPOL eingeladen werden. MS seien eingeladen ihre Berichte vor Verabschiedung des Abschlussberichts öffentlich zu behandeln; MS sollten sich hierfür bis zum 15.9. bei Präs melden bzw. ggf. noch nicht eingereichte Berichte übermitteln. Die Frist des 15.9. sei unbedingt einzuhalten. Präs teilte (noch) nicht mit, welches Vorgehen gewählt werde.

Bzgl. der WIKIPOL-Plattform kündigte Präs an, dass das Generalsekretariat einige zu aktualisierende Dokumente übermitteln werde; Rückmeldefrist sei der 16. September 2022.

3. Proposal for a Regulation of the European Parliament and of the Council laying down rules to prevent and combat child sexual abuse

Präsidentschaft begrüßte zunächst, dass KOM zugesagt habe, eine Übersicht zu den Kompetenzen von Europol bzw. dem geplanten EU-Zentrum zu erstellen und bis September vorzulegen. Es folgte zunächst eine artikel-, dann eine abschnittsweise Diskussion des VO-E.

Zu Artikel 8: BEL (unterstützt durch ESP) fragte nach dem Verhältnis zwischen Kontaktstelle und Hauptniederlassung der Anbieter (Art. 23 bzw. 24 VO-E) und bat um Klarstellung zur in Abs. 3 vorgesehenen Frist. POL und BEL bezogen sich auch auf die in Art. 7 Abs. 9 vorgesehenen Fristen von 24 bzw. 12 Monaten für CSAM bzw. Grooming und baten um Klarstellung, wie ein Anbieter, der einen (einheitlichen) Dienst anbiete, auch vor dem Hintergrund seiner Mitwirkungspflicht 2 Monate vor Ablauf der Anordnung, den unterschiedlichen Fristen Rechnung tragen solle.

FRA hob hervor, den Entwurf – trotz einiger offener Fragen – unbedingt zu unterstützen. Es sei in den weiteren Verhandlungen mehr Flexibilität und Vereinfachung der vorgeschlagenen Verfahren anzustreben. Die Rolle der LEAs müsse im VO-E gestärkt und das Verhältnis zu nationalen Regelungen klargestellt werden. IRL äußerte Zweifel über die Notwendigkeit, eines Gerichts/unabhängiger Behörde als zweite Entscheidungsinstanz. Angesichts der wohl gleichen Entscheidungsgrundlage und der hohen Bedarfe (neuer) Ressourcen und Kapazitäten sei fraglich, ob eine solche zweite Ebene einen echten Mehrwert darstelle. Auch POL betonte erheblichen Ressourcenaufwuchs. Die Rolle von INHOPE sei sowohl im VO-E als auch in dem durch KOM zur Verfügung gestellten Flowchart nicht ausreichend berücksichtigt. EST unterstütze diesen Punkt, grade für kleinere MS seien NGOs wie INHOPE/Safer Internet von großer Bedeutung.

Zum Sprachenregime der Anordnung betonten HUN, BEL, HRV die Vorgaben des DSA. Es sei wichtig, dass neben der Landessprache jedenfalls auch Englisch gewählt werden dürfe – auch aus Kostengründen. GRC äußerte Zweifel an der Notwendigkeit der Errichtung eines EU-Zentrums, dies würde zu Verzögerungen führen. Auch bei Entfernungsanordnungen sei mit Verzögerungen zu rechnen. Auch MLT und POL betonten die fundamentale Bedeutung Inhalte schnell zu entfernen.

KOM führte aus, dass Identifizierungsanordnungen entweder an die Hauptniederlassung, wenn diese in dem anordnenden MS liege oder andernfalls an die Kontaktstelle zu zustellen seien. Angesichts der sich schnell wandelnden digitalen Welt, sei es wichtig, Fristen für die maximale Dauer von Anordnungen vorzusehen. Dabei sei zu beachten, dass der Erlass einer ersten Anordnung i.d.R mehr Zeit in Anspruch nehme, als der Erlass von Folgeanordnungen. Dies gelte u.a. da der Anbieter bereits vor Ablauf einer Anordnung verpflichtet sei zu prüfen, ob bzw. welche Umstände sich geändert hätten. Auf Nachfrage führte KOM aus, dass die Formulierungen „manifest errors“ bzw. „not sufficient Information“ in Art. 8 Abs. 3 der TCO entnommen seien und eine Bewertung vom jeweiligen Einzelfall abhinge. KOM zeigte sich zuversichtlich, dass etablierte nationale Verfahren unter Einhaltung der Standards der CSA-VO aufrecht gehalten werden könnten. Zum Sprachenregime führte KOM aus, dass weitestgehende Standardisierung angestrebt sei; wo möglich bspw. durch „drop-down“ Menüs in den jeweiligen Sprachen.

Aus Gründen der Verhältnismäßigkeit sei es erforderlich, dass die Entscheidung zum Erlass einer Identifizierungsanordnung durch ein Gericht bzw. eine gerichtsähnliche Behörde getroffen werde. Es sei, auch angesichts der Eingriffstiefe, erforderlich, dass die finale Entscheidung durch Gerichte getroffen werde. Hierzu müssten entsprechende (zusätzliche) Kapazitäten bei den nationalen Gerichten aufgebaut werden. Der VO-E sehe nicht vor, dass CSAM an LEAs, sondern an das EU-Zentrum gemeldet werde. Meldungen an LEAs könnten aber durch diese bearbeitetet werden, es gebe keine Vorgabe, dass LEAs an das EU-Zentrum melden müssten.

FRA (unterstützt von EST) wiederholte, ob es zutreffend sei, dass Unternehmen unter der CSA-VO CSAM nicht freiwillig, sondern nur auf Grundlage einer Identifizierungsanordnung, identifizieren könnten. Mit Blick auf Entfernungsanordnungen müsse eine Harmonisierung mit nationalen Prozessen, die zeitnahe Anordnungen bereits ermöglichten, gewährleistet sein.

Zu INHOPE führte KOM aus, dass die Rolle von INHOPE unter der CSA-VO gestärkt werde; bspw. bei der Unterstützung von Betroffenen im gemeinsamen Vorgehen mit den (Koordinierenden Behörden) CA zur Entfernung von CSAM und beim Ausbau von Kapazitäten/Ressourcen in den MS. INHOPE werde in den EG direkt erwählt. Die Dienste, die unter die e-privacy VO fallen, könnten nach August 2024 nicht mehr freiwillig identifizieren. Die CSA-VO sehe vor, dass Identifizierung zukünftig ausschließlich nach gesetzlich gesicherten Standards geschehe. Sofern die Verhandlungen nicht bis August 2024 abgeschlossen würden, bedürfe es einer Übergangsregelung, damit es keine Rückschritte zum Status quo gebe. Dienste, die nicht unter die e-privacy VO fallen könnten nach Maßgaben der DSGVO weiter freiwillig tätig werden. IRL fasste nochmals zusammen, dass die CSA VO also keine Rechtsgrundlage darstelle für freiwillige Identifizierungsmaßnahmen von interpersonellen Kommunikationsdienstleistern.

Section 2: PRT votierte für möglichst detaillierte und bindenden Guidelines. ITA und IRL betonten, dass Guidelines die Aufgaben der LEAs berücksichtigen müssten. BEL fragte nach dem Verhältnis zwischen dem DSC und der CA sowie nach der Aufsicht über den Einsatz bestimmter Technologien. FRA wiederholte, dass Anordnungen ohne zeitliche Verzögerung erlassen werden sollten; die Beschwerdemöglichkeit aller „affected user“ dürfte Behörden vor große Herausforderungen stellen (Unterstützung durch SWE). CYP begrüßte, dass der Vorschlag auch Maßnahmen gegen Grooming vorsehe. Art. 10 müsse technologieneutral gefasst sein. Der Schutz der Kinder stehe über dem Schutz anderer persönlicher Rechte. KOM wurde um Bestätigung gebeten, dass die bestehenden Stellen nach DSA und TCO als CA im Sinne der CSA-VO benannt werden können.

NLD, SVN und FRA baten um Darstellung der nach Art. 10 vorgesehenen Technologien. EST fragte, ob Anbieter verpflichtet würden sog. „backdoors“ mit einzuplanen oder ob sie erst auf Anordnungen reagieren müssten. Es stelle sich auch die Frage nach einer etwaigen Haftung von Anbietern, wenn keine Technologien existierten, die für die von Ihnen angebotenen Dienste eine Identifizierung ermöglichten – insbesondere wenn das EU-Zentrum keine geeigneten Technologien zur Verfügung stellen könne. SWE forderte im Zusammenhang mit Art. 9 mehr Spielraum für die MS zur Bestimmung der jeweils zuständigen Behörde. Die Frist in Art. 10 Abs. 6 (iVm Art. 48) gelte es zu flexibilisieren, um die Belastung der Verwaltung im Blick zu halten. Außerdem sei es wichtig, in diesem Zusammenhang auch das Zusammenspiel mit der Verfolgung andere Straftaten zu beachten. DEU trug weisungsgemäß vor.

KOM führte aus, dass etwaige Konflikte zwischen Datenschutzaufsichtsbehörde und der CSA-VO mit dem umfangreichen Prozess im Vorhinein einer Anordnung begegnet worden sei. Sofern es dennoch zu Konflikten käme, läge die Entscheidung am Ende bei den Gerichten, die die Empfehlungen der Datenschutzaufsichtsbehörden und Datenschutzrecht berücksichtigten. Human oversight stelle sicher, dass Systeme einwandfrei funktionieren. Betroffene Nutzer könnten bereits jetzt gegen freiwillige Maßnahmen vorgehen, es komme dabei regelmäßig nicht zu einer Überlastung der Gerichte. Guidelines würden als delegierte Rechtsakte erlassen werden und sollen zur Einheitlichkeit der Entscheidungen beitragen. Der DSC könne, sofern die Anforderungen nach CSA-VO erfüllt sind, auch als CA fungieren. Sofern es sich um unterschiedliche Behörden handele, sei es wichtig, dass diese eng zusammenarbeiten. Sofern Anbieter Technologien verwenden, die nicht durch das EU-Zentrum zur Verfügung gestellt werden, müssten Anbieter Datenschutzaufsichtsbehörden befassen. EDPB sei daher nicht zwingend (zusätzlich) mit einzubeziehen. Das EU Zentrum müsse alle Meldungen prüfen, die an LEAs bzw. EUROPOL gehen. Die Einstufung von Technologie als Hochrisiko-KI i.S.d. KI-VO stelle einen weiteren „safeguard“ dar, führe aber nicht zu einer Verzögerung von Anordnungen. Es sei erforderlich, neue Technologien, bevor sie durch das EU-Zentrum zur Verfügung gestellt werden, einer Konformitätsprüfung nach KI-VO zu unterziehen.

Geeignete Technologien zum Erkennen von bekanntem CSAM seien Hashwerte und Foto-DNA, für neues CSAM und Grooming werde KI, ähnlich der Technologien zum Erkennen von SPAM/Virus-Inhalten verwendet. Der VO-E sehe Technologieneutralität vor. Wenn keine Technologie zur Verfügung stehe, die einen angemessen Grundrechtsschutz sicherstelle, könne eine Anordnung nicht ergehen. Die Rolle von verschlüsselter Kommunikation sei bei der Verbreitung von CSAM nicht zu unterschätzen. Nach Schätzungen würden 2/3 aller Meldungen entfallen, wenn E2EE in allen Messengern per „default“ vorläge. Daher sei VO-E technologieneutral, um den Schutz der Kinder zu gewährleisten. Anbieter seien verpflichtet, „child safety by design“ sicherzustellen (iRd Risikomanagement), die Einrichtung von „backdoors by design“ sehe der VO-E nicht vor.

Der VO-E sei darauf angelegt, dass auf bestehende Strukturen, wie denen des DSA und der TCO aufgebaut werden könne. Auf Nachfrage stellte KOM klar, dass es nicht Aufgabe der Anbieter sei, die Illegalität von Inhalten festzustellen. Das sei Aufgabe der LEAs Art. 9 Abs. 2 stelle einen weiteren „safeguard“ dar, führe aber nicht zu einem Suspensiveffekt, also auch nicht zu Verzögerung.

Präs kündigte einen TechWorkshop für Ende September/Anfang Oktober an.

Section 3: DEU trug weisungsgemäß vor. AUT legte einen speziellen Prüfvorbehalt für Art. 8 – 24 ein, verbunden mit dem Vorschlag einen speziellen Datenschutzworkshop durchzuführen. Aus Sicht von AUT/FRA/POL/MLT/SVN und HUN, sei die in Art. 12 Abs. 2 UAbs. 2 vorgesehene Frist von 3 Monaten zu kurz, eine bedarfsgerechte Frist sei anzustreben. IRL führte aus, dass für effektive Strafverfolgung, eine Rückverfolgbarkeit von Meldungen erforderlich sei.

FRA und EST äußerten Fragen zum Verhältnis von Art. 12 zu Art. 15a bzw. 14 DSA. NLD forderte, dass Art. 13 (g) nicht nur Informationen über Nutzer, sondern auch über Betroffene berücksichtige. Zu Art. 13 c) d) fragte GRC welche weiteren (Inhalts-) Daten gemeint seien. HRV fragte nach dem Verhältnis zu Meldungen auf Grundlage nationaler Regelungen.

KOM führte zur Formulierung von Art. 12 aus, dass diese gewählt worden sei um, Einheitlichkeit innerhalb der VO zu gewährleisten. Während der Standard kein anderer sei als beim DSA, mache Formulierung dennoch deutlich, dass Provider keine eigene Prüfung vornehme. Der Anbieter erlange Kenntnis, wenn ihm Inhalte gemeldet würden. Als lex specialis zum DSA, gehe die Meldepflicht nach Art. 12 CSA-VO der Meldepflicht des Art. 15a DSA vor. Die Meldungen sollten gem. Art. 13 c) und d) alle Informationen erhalten, die ebenfalls für LEAs relevant sein könnten, sowie auch Informationen über Betroffene beinhalten. Meldungen seien insgesamt Gegenstand höchster Datenschutzstandards. Der Entwurf verhindere nicht, dass MS Meldungen direkt von NCMEC oder anderen Akteuren entgegennehmen.

Section 4: SWE bezog sich i.R.d. Art. 14 Abs. 1 (Abs. 7) auf den grenzüberschreitenden Effekt der Anordnungen. Dieser sei auch bei Art. 8/Art. 31 DSA diskutiert worden. Auch auf Grundlage der CSA-RL gebe es noch Unterschiede im nationalen Recht. Die grenzüberschreitende Komponente führe dazu, dass die jeweiligen nationalen Standards Auswirkungen auf andere MS hätten. Voraussetzungen für Entfernungsanordnungen seien weiter zu diskutieren. FRA befürwortete ein gesondertes Verfahren für grenzüberschreitende Entfernungsanordnungen. ITA bat KOM um eine Übersicht zum Workflow für Entfernungsanordnungen. DEU trug weisungsgemäß vor. AUT stellte fest, die Frist von 6 Wochen in Art. 15 Abs. 4 sei zu kurz. Eine Information an Betroffenen könne nur unter Einbeziehung von Europol bzw. der LEAs erfolgen. Auch aus FRASicht sei es vorzugswürdig, wenn LEAs die Frist zur Aussetzung von Informationspflichten an Betroffenen selber festlegen könnten.

KOM bestätigte, dass freiwilliges Entfernen von Inhalten durch Anbieter unter der CSA-VO zulässig bliebe.

Präs kündigte an, im September eine überarbeitete Fassung des ersten und zweiten Kapitels übermitteln zu wollen. Die nächste Sitzung am 6. September werde sich mit Kapitel 3 des VO-E befassen.

„Auch stärkere Alterskontrollen heiße Deutschland willkommen, solange anonyme Nutzung garantiert sei.“

Alterskontrolle und Anonymität schließen einander aus. Wie will man das Alter einer Person überprüfen, ohne zu wissen, welche Person man da überprüft? Selbst mit einem System wie dem elektronischen Personalausweis erfolgt die Überprüfung immer allerhöchstens pseudonymisiert – man übermittelt eine eID und hat eine Trusted Third Party dazwischengeschaltet, bei welcher der Dienstleister anfragt, ob das Alter stimmt. Der Dienstleister erfährt so nicht mehr, wen er da überprüft, aber die Trusted Third Party weiß, zu welcher Person welche eID gehört, und somit bekommt sie auch mit, wer wo sein Alter verifizieren lassen will. Die Trusted Third Party bekommt nicht mit, was du bei Pornhub machst, das weiß nur Pornhub selbst (und ggf. dein ISP oder VPN-Anbieter), aber sie weiß zumindest, dass du dort registriert bist. Und das will man als User ja gerade nicht.

Ansonsten wäre ich dafür, die Chatkontrolle einschließlich Client-Side-Scanning als Modellversuch zunächst zwei Jahre exklusiv auf allen Endgeräten der EU-Kommission sowie der nationalen Regierungen einzuführen, mit Liveübertragung ins Internet.

1.) Warum werden jene nicht gehört die tagtäglich mit der Problematik zu tun haben, wie Kinderpsychologen und Jugendtherapeuten?

2a.) Wo bleiben die Forderungen nach Geld für die Kind und Jugendpsychologie, Sieht es schon in Österreich schlecht aus. In innigen EU Staaten sind derartig Einrichtungen nicht mal ein Fremdwort.

2b.) Wo bleiben die Forderungen nach Studienplätze für die Kinderpsychologie und Jugendtherapie, um den bestehenden Bedarf abdecken zu können.

3. Ziel dieser Gesetze kann es nicht sein den Schulhof zu kriminalisieren, derartiges wird jedoch bedenkenlos in kauf genommen.

4. Keine Wort und keine Diskussion über die Gefahren von Kriegsberichterstattung, daher ist de Vorwurf einer Ideologisierung des Internets gerechtfertigt.

5. Ebenso jegliche fehlende Diskussion über den angenagelten Herrgott am Kruzifix, das sind ja herere Werte die Kinder verstehen. Sorry, da gibt es nicht mehr viel im Internet das diese Grausamkeit überbietet.

Resümee des ganzen Themenkomplexes, hier schwimmt die Politik auf der Nudelsuppe wenn sie sich von Fundamentalisten derart Instrumentalisieren lassen.

Ohne Ihren Punkt zu schmälern:

Und wo bleibt das Assessment, was man damit kaputtmacht und die Befragung wiederum dieser Betroffener?

Ich sehe das nicht positiv: noch wildere Überwachung statt gepanzerter Fahrzeuge für die liebe Polizei?

@Peter (Wien)

“ … 3. Ziel dieser Gesetze kann es nicht sein den Schulhof zu kriminalisieren, derartiges wird jedoch bedenkenlos in kauf genommen. …“

Diese Problematik sollte noch mal im speziellen von Experten (Juristen und Psychologen) betrachtet wreden. Ich wurde letztes Jahr zufällig in einem Gerichtsflur Zeuge eines Gesprächs unter Richtern und Richterinnen, die sich froh darüber zeigten, dass der wohl unbeliebte Kollege XY den aktuellen Fall sexuellen Missbrauchs verhandelt, weil man selbst damit kaum klar käme, weil die Angeklagten selbst noch alle Jugendliche seien und die ja fast die Hälfte aller Fälle ausmachen würde.

Das Gericht hat einen Einzugsbereich von etwas über 1Mio Einwohner.

Ich finde das erschreckend und würde daher auch den Bereich Minderjähriger, sprich Schulhof nicht per se ausschließen wollen. Die Maßnahme kann natürlich keine pauschale Kriminalisierung sein sondern müsste eher auf Hilfen und der Schaffung von Bewusstsein bei den Jugendlichen hinauslaufen.

Jetzt mal von den ganzen theoretisch juristischen Erwägungen abgesehen soll der Zweck ja sein, Kriminelle zu überführen und da kommen die technischen Möglichkeiten ins Spiel.

Eine eigene Cloud, die auch für Chats genutzt werden kann, auf einem privaten Rechner aufsetzten dauert für den interessierten Laien heute eher Minuten denn Stunden.

Wie denn die Daten/Datenflüsse dort überwacht werden sollen, ohne dass eine Behörde kompletten Zugriff (Hintertür) auf alle privaten Rechner bekommt erschliesst sich mir nicht.

Bei allen anderen Maßnahmen wird man dann wenn es um wirkliche Kriminelle geht, die sich zu schützen wissen oder auch um Kriminalität/Spionage von Drittstaaten, wo entsprechde Geheimdienste die technsichen Voraussetzungen schaffen nur so eine Art Beifang abschöpfen können und die vorgenannten eher darüber lachen.