Twitter wird gegen Fehlverhalten auf seiner Plattform vorgehen, wenn es das Potenzial hat, analogen Schaden anzurichten. Dies kündigte das Unternehmen im Mai diesen Jahres nach massiver Kritik am Umgang mit der QAnon-Bewegung und anderen Verschwörungstheorien an. Zugleich löschte Facebook nach eigenen Angaben fünf Facebook-Seiten, 30 Accounts und sechs Gruppen mit einer Reichweite von insgesamt 133.000 Follower:innen der QAnon-Bewegung. Deplatforming nennt sich das, auf Deutsch: Man nimmt Nutzer:innen, die vermehrt gegen die Richtlinien verstoßen, die Plattform. Indem man ihre Gruppen schließt, ihre Accounts zumacht, ihren Botschaften die Reichweite nimmt.

Wann ist Deplatforming notwendig und sinnvoll, welche Risiken fallen dabei an? Darüber diskutierten im Dezember Bundesjustizministerin Christine Lambrecht, eine Facebook-Vertreterin und Aktivist:innen auf einer Tagung der Amadeu-Antonio-Stiftung. Anlass war eine neue Studie, die das Institut für Demokratie und Zivilgesellschaft veröffentlichte. Finanziert wurde die Studie durch Facebook.

Schweige- und Schreispiralen vermeiden

Warum ist Deplatforming überhaupt notwendig? Weil ohne eingreifende Maßnahmen die Gesellschaft mundtot gemacht wird, sagt Justizministerin Lambrecht. Opfer von Hate Speech und digitaler Gewalt könnten ihren Mut verlieren und sich zurückziehen. Dies kann auch der Forscher Matthias Quent vom IDZ Jena bestätigen. Im vergangenen Jahr führte er eine große Erhebung mit mehr als 7.000 Teilnehmenden durch. 75 Prozent der Befragten gaben an, dass Hass im Netz die Meinungsfreiheit einschränkt, weil sich Nutzer:innen seltener auf Social Media zu ihrer Meinung bekennen. Vor allem junge Menschen hätten aufgrund von Hass im Netz bereits vermehrt ihr Konto deaktiviert, jede:r Vierte in der Studie gab das an.

Aktivist:innen erhalten immer wieder Drohungen, wenn sie sich zu kontroversen Themen wie COVID-19 öffentlich äußern, sagt die Netzaktivistin und Autorin Katharina Nocun. In Bezug auf die Pandemie trauten sich immer weniger Wissenschaftler:innen, öffentlich Stellung zu beziehen. Vor allem Frauen haben Angst vor Drohungen, beispielsweise gegen ihre Familie. Deplatforming könne zwar nicht das Problem beheben, aber eine Maßnahme zum Schutz der Opfer sein. Dabei müsse man genau schauen, inwiefern Deplatforming in der Situation angemessen sei. Der Staat und die Plattformen tragen beide die Verantwortung, findet Nocun.

Abhängigkeit von Sozialen Medien

Deplatforming ist nicht die Lösung gegen rechte Hetze. Das schildern auch Maik Fielitz und Karolin Schwarz in ihrer Studie: „Die Löschung eines Posts oder eines Accounts wird weder die Meinung von Menschen ändern noch Gewalttaten oder Radikalisierung per se verhindern. Und doch hat der Umgang von Plattformen mit rechtsextremen Akteuren einen großen Einfluss auf die Erfolgsbedingungen ihrer Politik und die Verbreitung antidemokratischer Propaganda.“ Rechtsextremist:innen seien stark abhängig von sozialen Medien, da sie hier ihre Ideologien schnell verbreiten können. Zugleich können sie sich hier anhand von geschickter Inszenierung Grauzonen schaffen, in denen Strafverfolgung kompliziert wird. Sprachlich passiert das etwa durch semantische Mimikry-Taktiken: Ein Wort wird zum Platzhalter für ein anderes, nur eingeweihte Personen verstehen dessen wahre Bedeutung.

Die Apps Parler und Gab, die in den USA gerne von Verschwörungstheoretiker:innen als Twitter-Alternative genutzt werden, sehen Fielitz und Schwarz bisher nicht als Problem, da sie in Deutschland vergleichsweise wenig Einfluss haben. Telegram ist hingegen aktuell der Hotspot der untersuchten rechten Akteur:innen. 96 Prozent von ihnen besitzen hier teils hyperaktive Kanäle. „Die meisten verstehen Telegram als ihre kommunikative Basis. Was dieses hybride Medium besonders macht: Es gibt so gut wie keine Moderation der Betreiber:innen, Push-Nachrichten auf das Handydisplay wirken unmittelbarer und es kann leicht zwischen privater Messengerfunktion und öffentlicher Kanalfunktion gewechselt werden.“

Schnellere Strafverfahren

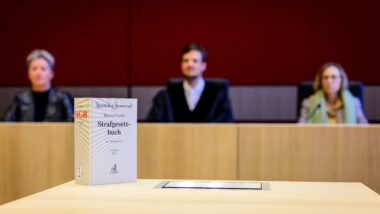

Konstantin Kuhle, innenpolitischer Sprecher der FDP, betrachtet Deplatforming als eine Form von disziplinierenden, vielleicht auch repressiven Maßnahmen. Er betont, dass etwa Online-Drohungen Straftaten sind, auch wenn sie nicht analog stattfinden. Ausschlaggebend sei, die Justiz digital auszustatten. Beim Deplatforming solle auf schnellere, bessere, digitalere Strafverfahren gesetzt werden, sodass die Legitimität einer solchen Maßnahme in der Bevölkerung steigt.

In diesem Zusammenhang geht es vor allem um das Netzwerkdurchsetzungsgesetz (NetzDG): Plattformen sind durch das Gesetz dazu verpflichtet, strafbare Inhalte spätestens 24 Stunden nach Eingang einer Beschwerde zu löschen. Das Problem ist, so die Studienautor:innen, dass Plattformen diesbezüglich unterschiedliche Richtlinien und Grenzen haben. So sperrt Twitter unter Umständen andere Accounts und Beiträge als Facebook. Eine Verschärfung des Gesetzes ist geplant, die für Offizialdelikte eine Meldepflicht an die Behörden vorsieht, bisher müssen Betreiber die Beiträge lediglich entfernen. Das Spannungsfeld zwischen Meinungsfreiheit und der Frage, wie viel Hass erlaubt ist, sei groß, sagt Eva-Maria Kirschsieper als Vertreterin von Facebook Germany. Facebook profitiere nicht von dem Hass, Löschungen unangemessener Inhalte seien im Interesse des Unternehmens, vor allem in Bezug auf Werbetreibende.

Statt immer mehr zu löschen fände ich es sinnvoller den Juristischen Druck weiter zu erhöhen. Beleidigungen und Hetze müssen sehr viel schneller zu heftigen Bußgeldern führen können um so eine Abschreckungswirkung zu entfalten.

Das wäre eine IP Adresse Speicherpflicht der Provider ebenfalls sinnvoll um die Rückerverfolgbarkeit zu vereinfachen. Rechtsextremisten dürfen niemals das Gefühl bekommen Sie könnten anonym im Internet hetzen.

Linksliberaler Antifaschist: Eine IP-Speicherpflicht der Provider – wie von dir gewünscht – ist genau das, wogegen wir hier alle kämpfen. Ausserdem kann sie umgangen werden und auch gegen „linksliberale Antifaschisten „(ab wann ist man das?) eingesetzt werden.

Viel wichtiger und wirksamer ist ein öffentlicher Diskurs darüber, was wann als „Hass“ aufzufassen ist und wie man ihm auf gesellschaftlicher und demokratischer Ebene – und das heisst nicht (!) Totalüberwachung – begegnen bzw. ihm vorbeugen kann.

Vielleicht ist es auch der falsche Weg zu versuchen „Hass“ und „Falschaussagen“ strafrechtlich zu verfolgen. Da könnte dann jeder nach seiner politischen Meinung und Überzeugung das rausfiltern, was ihm nicht passt.

Man kann nun mal online mit Leuten in Berührung kommen, die andere Ansichten haben als man selber und vielleicht unfreundlich sind, sowas hat nichts mit zunehmender Verrohung zu tun, sondern damit das nun fast alle Bevölkerungsschichten und Altersklassen soziale Medien nutzen.

Plattformen, welche sich als neutrale Plattformen sehen, sollten in der Lage sein (mithilfe des deutschen oder des amerikanischen Rechtes) Regeln aufzustellen, welche auf ein DIN A4 Blatt passen (abgesehen von irgendwelchen Filterlisten).

Beispiel:

Beim veröffentlichen von Inhalten muss sich an das Gesetz gehalten werden (damit sind Aufrufe zu Straftaten, Beleidigungen oder Urheberrechtsverletzungen schon mal weg).

Link zu einer Liste der Wörter die gefiltert werden: …

Außerdem sind nicht jugendfreie Inhalte (Nach Jugendschutzgesetz Paragraph XY) nicht erlaubt (damit ist dann Pornografie und Gore auch weg).

Mehr bräuchte es für die meisten Plattformen eigentlich nicht, insofern ein paar Leute eingestellt werden, welche regelmäßig Inhalte löschen.

Wenn es dann Leute gibt die an Echsenmenschen glauben wollen oder die Bundesrepublik für einen Schwindel halten, dann sollte man das als erwachsener Mensch aushalten können.

Oder man guckt mal, wie andere Communities das so handhaben. Im echten Internet, nicht im Fakeflanschbecken der Big Tech.

Da wird man Unterschiede sehen, z.B. weil die meißten Plätze spezifische Kontexte haben. Wie wird dort moderiert?

Wenn man jetzt die Moderation in die Hände der Gruppenleitung legt, auch Benutzer in Eigenregistrierung, die möglichst noch finanziell vom Gruppengeschehen profitiert… nachdenken.

Wer jetzt alle reguliert, und nicht vor allem unmoderiertes (Big) Tech, gehört höchstwahrscheinlich zu den Profiteuren eben solcher Gruppen (kleiner Sprung für den Geist).

Die Angst die eigene Meinung zu sagen besteht auch und vor allem bei allen Nichtlinken. Ebenso dann mit Hass, Hetze und sozialer Isolation rechnen zu müssen. Aber das ist ja dann wohl guter Hass und gute Hetze.

Meinst du die Nichtlinken, die wie Sarrazin, Weidel, von Storch, Höcke, Gauland usw. seit Jahren ständig in Talkshows sitzen und sich ja wirklich kaum trauen, ihre Positionen zu verbreiten? Oder vielleicht die Nichtlinken, die wie Pegida und die Querdenker seit Monaten und Jahren öffentlich demonstrieren? Oder doch eher die Nichtlinken, die nur mit allergrößtem Mut auf Facebook, Twitter und in den Kommentarspalten von Online-Medien unter jedem Beitrag zu den Themen Geschlechtergerechtigkeit, Vielfalt, Geflüchtete und Klimawandel ihre Meinung abladen? Oder vielleicht doch eher die Nichtlinken, die Selfies und Videos davon posten, wie sie das Reichstagsgebäude und das Kapitol stürmen?

Wie schnell würden sich Twitter, FB & Co. endlich an die in Deutschland geltenden Gesetze halten, wenn man den Zugang zu diesen Diensten bei wiederholten Verstößen deutlich erschwert – eine Blockierung für drei Tage wird effektiver sein als der Griff in deren Portokassen.

Ferner muß endlich eine international agierende Einheit geschaffen werden, die die Verfolgung gesetzeswidriger Inhalte und Aktivitäten im Netz auch ebenso international betreiben kann. Damit könnten dann auch Seiten wie imgflip.com, die bislang eher unter dem Radar der Behörden und Medien existieren, endlich das Handwerk gelegt werden.

Zur Erläuterung: im sogenannten „politics stream“ (https://imgflip.com/m/politics) bietet imgflip, vorgeblich ein „meme generator“, eine Plattform für (gewalttätige) Rassisten, Faschisten und Verschwörungstheoretikern – der Betreiber Dylan W. beteiligt und bereichert sich aktiv daran (wenn er nicht gerade mit Cyberbullying behelfs seiner unzähligen alt accounts irgendwelche User terrorisiert…).

Ein Ansatz gegen Filter wären noch offiziell anerkannte mehr oder weniger ehrenamtliche Moderatoren.

Diese können ausgewählt oder gebucht werden (ob direkt persönlich oder via Eigenschaftssuche), und diese profitieren finanziell von der angezeigten Werbung.

Die Moderatoren müssen irgendwie geschickt ausgewählt werden, und ihr Können in verschiedenen Bereichen festgestellt oder zumindest wertbar gemacht werden (Technik, Synthese bei Philosophie, fiese böse Diskurse beruhigen ohne alles kaputtzumachen, Superstreng, Overblocker).

Jede Chatgruppe hat damit mehr oder weniger unabhängige Moderation, und vielleicht geht das sogar mit dem werbegetriebenen Konzept. Da es Anfangs wenige Moderatoren gibt, wird bei großen Plattformen direkt verlangt, dass bei Unfähigkeit ganze Diskurse plattgemacht werden, das ist das Risiko, wenn man Unerfahrene wählt.