Rainer Mühlhoff ist Philosoph am Excellence Cluster Science of Intelligence der Technischen Universität Berlin. Er forscht zu ethischen Fragen der Künstlichen Intelligenz, zu gesellschaftlichen Auswirkungen der Digitalisierung und zu den Affekten autoritärer Politikstile.

Die Corona-Krise hat eine gewaltige Diskursverschiebung in Bezug auf die Nutzung digitaler Dienste und Daten bewirkt. Am deutlichsten vernehmbar ist ein weit geteilter Ruf nach der behördlichen Auswertung von Smartphone-Bewegungsdaten, die bei der Eindämmung des Virus helfen soll. Doch es gibt noch weitere, weniger debattierte Veränderungen: zum Beispiel den nun rapide hochgefahrenen Einsatz von digitalen Lernplattformen an den geschlossenen Schulen, um den Unterricht dort fortzusetzen.

Bei der Interaktion mit diesen Lernplattformen, über die auch Prüfungen abgewickelt und Leistungen bewertet werden, fallen große Mengen Daten an. Diese können – zumindest theoretisch – dazu verwendet werden, detaillierte Leistungs- und Verhaltensprofile der großen Mehrheit unserer Schüler:innen zu erstellen. In Ländern wie den USA ist die kommerzielle Verwendung solcher Daten bereits seit Jahren verbreitet.

Corona provoziert aktuell eine Reihe politischer Tabubrüche, die wahrscheinlich dazu führen, dass das Virus die Gesellschaft dauerhaft transformiert. Ohne gesicherte wissenschaftliche Erkenntnisse über die Wirksamkeit der Handydatenerfassung zur Eindämmung des Virus wäre mit der Bereitstellung dieser Daten eine Aufweichung des Rechts auf informationelle Selbstbestimmung verbunden, für die selten zuvor so leicht eine Mehrheit zu erlangen war. Und ohne eine umfassende datenschutzpolitische Begleitung und Regulierung kann die flächendeckende Erfassung von Verhaltensdaten besonders schützenswürdiger Bevölkerungsgruppen (dazu zählen die Daten über das Lernverhalten von Heranwachsenden) ein irreversibles Datenleck produzieren.

Turbo-Digitalisierung mit Nebenwirkungen

Wird dieser Weg der Turbo-Digitalisierung als Nebeneffekt von Corona im aktuellen Tempo weiter beschritten, kann die politische Debatte um die Folgen dieser Trends kaum Schritt halten und es würde zu grundlegenden Beschneidungen unserer Freiheitsrechte kommen – mit vor allem langfristigen Folgen.

Doch warum ist es so dringend, die Maßnahmen, die nun im Schnelltempo umgesetzt werden, mit einer neuen Diskussion über Datenschutz und digitale Grundrechte zu begleiten? Haben wir nicht mit der Europäischen Datenschutzgrundverordnung (DSGVO) bereits eine der schärfsten und fortschrittlichsten Gesetzgebungen weltweit, auf die wir uns auch jetzt verlassen können, solange alle Maßnahmen damit konform bleiben?

Der Punkt ist, dass die DSGVO hauptsächlich das einzelne Individuum und seine personenbezogenen Daten schützt. Doch die Gefahren durch die nun entstehende Datensammlung und -nutzung liegt nicht hauptsächlich in der digitalen Ausleuchtung Einzelner, sondern in dem Entstehen algorithmischer Verfahren zur Bevölkerungsverwaltung.

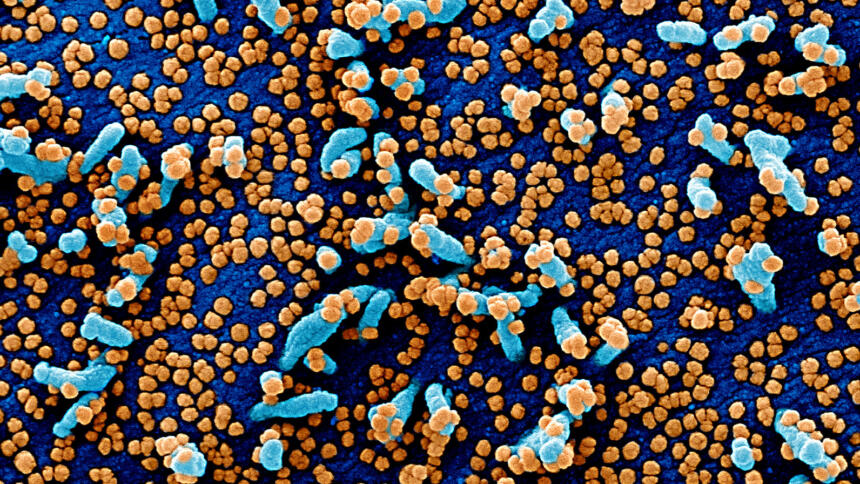

Anonymisierte Massendaten bergen zwar immer die Gefahr der Re-Identifikation einzelner Datensubjekte – und diese ist für sich schon ein Grund zur Besorgnis! –, doch viel gravierender ist die Nutzung solcher Daten zum Training künstlicher Intelligenzen und prädiktiver Analysen. Sie können zum Beispiel darüber entscheiden, welche Bevölkerungsgruppen Zugang zu medizinischen Leistungen, Jobs und Bildungschancen haben, oder Prognosen darüber treffen, wer bei schlechter Gesundheit oder psychisch labil ist, eine potenzielle Gefahr darstellt (predictive policing), potenziell das Virus weiter verbreitet oder einem bestimmten politischen Lager zuzurechnen ist (siehe „Cambridge Analytica“).

Die Unterscheidung von anonymen und personenbezogenen Daten ist überholt

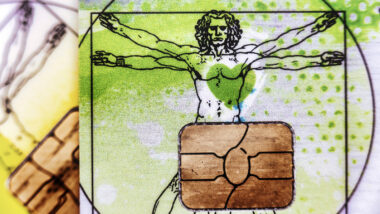

Die DSGVO schützt nicht wirkungsvoll vor der Verwendung anonymisierter Daten für prädiktive algorithmische Entscheidungen, Risikoklassifizierung (Scoring) und verhaltensbasierte Ungleichbehandlung von Individuen oder Gruppen. Denn erstens orientiert sich die DSGVO an einer heute nicht mehr wirkungsvollen Unterscheidung von anonymen und personenbezogenen Daten. Zweitens konzipiert sie Datenschutz und Privatsphäre als Recht auf informationelle Selbstbestimmung, also als das Recht, die Verwendung der eigenen personenbezogenen Daten zu kontrollieren.

Algorithmische Scoring- und Entscheidungsverfahren beruhen aber auf einem anonymen Abgleich mit den Daten viele anderer Individuen, weshalb man durch Weitergabe der eigenen (ggfs. anonymisierten) Daten potenziell anderen Individuen und Gruppen schadet und umgekehrt durch die Datenweitergabe anderer potenziell selbst tangiert wird.

Und schließlich gibt der vergleichsweise fortschrittliche Artikel 22 DSGVO zwar den Betroffenen einer voll-automatisierten algorithmischen Entscheidung bestimmte Rechte an die Hand. Diese Rechte sind in der Praxis aber häufig unwirksam, weil die spezifischen Machtverhältnisse in algorithmischen Entscheidungssituationen die Betroffenen zur Einwilligung in das automatisierte Scoring nötigt.

Wer zum Beispiel als prekäre Person bei einer keiner klassischen Bank keinen Kredit erhält und nur noch die Möglichkeit hat, sich mit seinen Social-Media-Daten auf einen Kurzzeitkredit zu bewerben, der gibt hierfür gezwungenermaßen die Einwilligung. Und schließlich verbietet Artikel 22 gar nicht die Erhebung der für algorithmisches Scoring verwendeten Datensätze und auch nicht ihre Verwendung bei halbautomatischen Entscheidungsabläufen.

Der digitale Kapitalismus verändert sich

Das Corona-Virus – bzw. die Reaktion darauf in Form von Verordnungen und eiliger Gesetzgebung – beschleunigt eine seit Cambridge Analytica bereits sichtbare „biopolitische Wende“ des digitalen Kapitalismus. Damit ist ein Trend gemeint, der bislang vor allem in Bezug auf asiatische Gesellschaften diskutiert wurde, längst aber auch in Europa und den USA sichtbar wird.

Daten und digitale Technologie werden nicht mehr nur dafür benutzt, das Kaufverhalten von Individuen zu beeinflussen, zum Beispiel durch Anzeige persönlich zugemessener Werbung oder durch die Kalkulation individueller Kreditrisiken auf Grundlage von Verhaltensdaten. Sondern datenbasierte Algorithmen vermitteln den Zugang zur sozialen und kulturellen Umgebung (siehe soziale Medien), zu wohlfahrtsstaatlichen Ressourcen wie Sozial- oder Gesundheitsleistungen, und greifen in Prozesse der politischen Kommunikation und Willensbildung ein – bis dahin, dass sie Wahlen entscheiden können.

In dem Moment, wo Verhaltensdaten fast flächendeckend anfallen und (sei es auch anonymisiert) erhoben werden, sind die prädiktiven Modelle, die damit trainiert werden, dazu in der Lage, ganze Populationen in Risikogruppen einzuteilen und algorithmisch zu verwalten. Datenbasierte Algorithmen können die Gesellschaft dann in unsichtbare soziale Klassen einteilen, zum Beispiel in Bezug darauf, wer aufgrund seiner Bewegungsmuster vermeintlich ein besonderes Sicherheits- oder Gesundheitsrisiko darstellt (zum Beispiel weil das Bewegungsprofil erkennen lässt, dass jemand das Virus besonders verbreitet hat), wer prioritären Zugang zu knappen medizinischen Ressourcen wie Beatmungsplätzen verdient, wer aufgrund seines Lernverhaltens an Schule oder Universität für bestimmte Jobs vermeintlich besonders geeignet ist oder welches Kind mit höherer Wahrscheinlichkeit Opfer häuslicher Gewalt wird und deshalb präventiv vom Jugendschutz beobachtet werden sollte.

Kollektiver Datenschutz

Vernetzte Medien sind mittlerweile so verbreitet, dass sich die – gegebenenfalls anonyme – Erhebung alltäglicher Verhaltensdaten über einen kritischen Punkt hinaus verdichtet hat. Es werden so viele Daten produziert, dass für viele Geschäftsmodelle und Anwendungsfälle nicht mehr die personenbezogenen Daten Einzelner im Fokus stehen, sondern hochauflösende aber anonyme Massendaten. Diese Situation fordert eine verschärfende Debatte über digitale Grundrechte.

Hierbei ist in den Blick zu nehmen, dass ein Individuum oder eine Gruppe auf Grundlage der Daten, die andere über sich preisgeben, potenziell ungleich behandelt oder diskriminiert werden kann. Datenschutz ist deshalb keine Privatsache jede:r Einzelnen mehr, sondern ein kollektives Interesse. Man hat mit den Daten, die man weitergibt, potenziell auch Auswirkungen auf andere.

Nur anhand der Daten von Millionen „Normalbürger:innen“, die über sich meinen, „nichts zu verbergen zu haben“, kann man prädiktive Analyse trainieren, die andere Menschen etwa als Abweichler:innen, potenzielle Gefährder:innen, mutmaßlich depressiv oder krank klassifizieren können. Das primäre gesellschaftliche Risiko der großen Datensammlungen ist nicht nur die Preisgabe persönlicher Informationen einzelner, sondern die algorithmischer Selektion gesellschaftlicher Gruppen in Bezug auf den Zugang zu Chancen, Ressourcen und Informationen.

Wir haben es hier also mit einer Form der Datenverwertung zu tun, die soziale Ungleichheiten produziert und stabilisiert, wenn man ihr nicht durch eine Besinnung auf kollektive Datenschutzansprüche begegnet.

Digitale Grundrechte müssen jetzt auf der Tagesordnung stehen

Die politische und gesellschaftliche Reaktion auf die SARS-CoV2-Pandemie führt dazu, dass das Volumen der alltäglichen Datenerhebung und die legitimen Zwecke für ihre Verwendung drastisch ausgeweitet werden. Damit eine gesellschaftliche Diskussion über Datenschutz bei diesem Tempo mithalten kann, sollte das Thema digitale Grundrechte jetzt auf unser aller Tagesordnung stehen.

Vor uns liegt ein Scheidepunkt, an dem wir entweder einen Europäischen Weg in der Handhabung sowohl der Innovationspotenziale als auch der Gefahren digitaler Technologie im Verbund mit starken, kollektiv orientierten Grundrechten artikulieren, oder über die nächsten Jahrzehnte graduell die bevölkerungsverwaltende Ditialtechnologie asiatischer Gesellschaftsmodelle übernehmen. Einige Mitglieder der Bundesregierung diskutieren das Handytracking in einem vergleichsweise autoritären Staat wie Singapur als „Vorbild“ auch für Deutschland. Datenschutzbedenken werden mit dem Hinweis verworfen, jede:r einzelne könne bei uns ja dann freiwillig über die Verwendung einer solchen App entscheiden. Das zeigt wie dringend gerade jetzt eine Diskussion über kollektive Schutzrechte ist.

Ein in der Öffentlichkeit und bei politischen Entscheidungsträger:innen vielfach noch fehlendes Bewusstsein für die Möglichkeiten und Gefahren, die sogar von anonymisierten Massendaten ausgehen, erschwert es, den Ernst der Lage zu erkennen und in verantwortliches anstatt aktionistisches politisches Handeln zu übersetzen.

Ganz wichtiger und guter Beitrag. Die Menschen in den freiheitlichen Demokratien haben leider vergessen, was es bedeutet, Freiheit zu erkämpfen. Die „nix-zu-verbergen-Mentalität ist nun der Nährboden, wie rasant die Freiheit erodiert.

Diese Diskussionen müssen sofort geführt werden, sonst gewinnen die Hardliner. Gesundheitsschutz darf nicht gegen Freiheit ausgespielt werden! Danke für den Artikel,Gastkommentar!

Vielen Dank für den Artikel!

Wir haben für diverse Dinge einen gesellschaftlichen Konsenz uznd Gesetze, die es mir verbietet mit diesen zu handeln/diese zu veräußern, auch wenn sie eigentlich mir gehören. Wenn ich anfange meine Nieren, Gene, Wahlstimme oder auch nur mein Flensburger Punktekonto auf Ebay anzubieten steigt mir der Gesetzgeber und die Gesellschaft auf’s Dach.

Dieser Konsenz ist für Daten/Datenpunkte noch herzustellen.

kleiner Tipo im Artikel? Ditialtechnologie

Vielen Dank für diesen tollen Beitrag. Es ist seit langem der beste Beitrag, den ich zu diesem Thema gelesen habe, weil er auch nicht-themenkundigen Lesern anhand konkreter Beispiele anschaulich macht, wie die Konsequenzen verpassten Datenschutzes aussehen können. Auch der ganz konkrete Bezug auf die Schule gefällt mir persönlich sehr gut, denn gerade dort passiert aktuell, zum größten Teil ohne wirkliche Not, vieles Bedenkliche. Und in meinen Augen ist das größte Problem zu diesem Themenkomplex, dass viele Menschen die Folgen nicht verstehen, weil das Thema oft unnötig abstrakt gehalten wird. Das gelingt hier besser. Vielen Dank für diesen Beitrag.

Wir sollten Abgeordnete und Journalisten anschreiben und fordern, dass sie sich für eine Rückkehr zu grundgesetzkonformen Maßnahmen gegen die Coronakrise einsetzen.

Wenn Sie diesen Rat sinnvoll finden, empfehle ich diesen Text (beide Sätze) in vielen Internetforen zu teilen, um ihn schnellstmöglich zu verbreiten.