Große Daten – bitte was? Der Begriff „Big Data“ geistert seit Monaten durch Artikel, TV-Sendungen und Radiobeiträge. Die weitaus meisten von uns haben dennoch, zumindest laut mancher Studie, keinen blassen Schimmer, was damit gemeint sein könnte. Mit einer Artikelreihe wollen wir deshalb ein paar Scheinwerfer in den Datenanalyse-Wald richten. Denn die enthüllte Überwachungs-, ist eigentlich eine „Berechnungsgesellschaft“. Darin sind die Geheimdienste nur einige Akteure unter vielen.

Klick. „Wir reden über Petabytes, Yottabytes, Zettabytes“, erklärt Kerrie Holley, „aber eigentlich haben wir noch zu wenige Daten“. Klick. „Muster lassen sich mit Hilfe von Mathematik begreifen“, sagt Jurij Paraszczak. „Und mit diesen Mustern lässt sich nicht nur verstehen, was gerade passiert, sondern auch was passieren wird.“ Klick. „Daten sind das, worin wir leben und was wir atmen“, schwärmt Emile Werr von der New Yorker Börse.

Klick.Big Data ermöglicht „einen tieferen Einblick, indem es Kundeninformationen und –verhalten stärker durchforstet“, erklärt eine Stimme. „Peters“ Bank hat mitbekommen, sagt der Sprecher, dass „Peter“ in der letzten Zeit mehrfach Geld für Haushaltsgegenstände ausgegeben hat. Die Bank kennt sein Ausgabeverhalten, Einkommen, seine Kreditwürdigkeit und durch „Peters“ Social-Media-Verhalten weiß das Geldhaus außerdem, dass er gerne kocht und in Gourmet-Restaurants geht. Er wünscht sich einen neuen Herd. Seine Bank weiß, welchen „Peter“ gerne hätte. Sie erhöht seinen Dispokredit, damit er sich das teure Stück auch leisten kann.

Klick. „Linda“ geht zum Arzt. In einer „Big-Data-Welt“ hat „Dr. Patel“ einen „360 Grad Überblick über ihre Krankheitsgeschichte“. Mit ihrem Tablet-PC meldet sich „Linda“ im Fitnessstudio an. Dort notiert ein Trainer ihre Vitalfunktionen und andere „relevante“ Daten in dem von „Dr. Patel“ empfohlenen „Wellness“-System. Eine App überwacht ihre Trainingserfolge. In diese hat natürlich auch ihr Arzt Einsicht. „Gratuliere Linda!“, schreibt er seiner Patientin zur Motivation. „Jetzt solltest du anfangen, Vitaminpräparate zu nehmen.“ Natürlich macht sich „Linda“ gleich auf den Weg zu einer Apotheke – die ihr der programmierte Gesundheits-Guru in ihrer Tasche praktischerweise empfiehlt.

A wie Alles anders

Das alles sind Szenen aus Imagefilmen des IT-Unternehmens IBM. Im Youtube-Channel des US-Konzerns häufen sich echte und vermeintliche Experten, zufriedene Kunden und sonstige werbewirksam Lächelnde, die den verheißungsvollen Slogan „Let’s build a smarter planet“ an das Ende ihrer Geschichten über ihre „smart“ gelösten Probleme stellen. Mal handeln die Big-Data-Erzählungen von Bankgeschäften und Börsenkursen, mal von Tennis, Logistik oder der sogenannten „Sentiment Analysis“ (wie das funktioniert erklärt Anna). Oft geht es um „Muster“, „Echtzeit“, „Vorhersagen“ und immer um rasant wachsende Datenmassen. Bis 2020 soll sich das weltweite Datenvolumen alle zwei Jahre verdoppeln, schätzen die Marktbeobachter der International Data Cooperation (IDC). Bis 2020 werden die Maschinen, die uns umgeben, mal mehr und mal weniger durch unser Zutun, also Fotos, Klimadaten, Bewegungsprofile, Text, Kontonummern, Programmcode, Informationen über Verkehrsströme und Stromverbrauch mit einem Volumen von 40 Zettabyte erzeugt haben. Laut den Analysten soll das der 57-fachen Sandmenge aller Strände der Erde entsprechen – auch wenn das ein etwas absurder Vergleich ist.

Im Zeitalter der explosionsartigen Byte-Vermehrung eröffnet Big Data einen völlig neuartigen Zugang zu empirischer Erkenntnis. Der Hype-Begriff beschreibt das Phänomen der rasend schnell erzeugten Informationen. Big Data steht aber auch für das Technologienbündel, das einen „sinnvollen“ Zugang zum globalen Kommunikations-Chaos möglich machen soll. Denn der Panorama-Blick in den Full-Take-Datenhaufen befähigt zu Beobachtungen, die in der Welt der „Small Data“, der statistischen Stichproben, nicht nur zu teuer, sondern schlicht unmöglich waren.

Der IT-Branchenverband Bitkom spricht von den „V3“-Kriterien: Volume, Velocity, Variety. Bei Big Data geht es also darum große, unstrukturierte Datenmengen in eine Form zu bringen, die Zusammenhänge offenlegt. „Echtzeit“ und viele verschiedene Formate, wie Tweets, Texte, Fotos, Protokolldaten (wer sich wann, wo eingeloggt etc.) und Ähnliches ermöglichen so das „Erkennen von Bedeutungen, Mustern, Vorhersagen“. Manchmal wird noch ein viertes „V“-Kriterium angefügt: Veracity. „Wahrhaftigkeit“, was hier bedeutet, dass mittlerweile Mechanismen möglich sein sollen, die sehr viele Daten auf ihre „Richtigkeit“ und „Vertrauenswürdigkeit“ hin prüfen können. Andere, wie etwa der Big-Data-Optimist Viktor Mayer-Schönberger sehen eine Kernkompetenz der Massenrechnung gerade darin, dass die schiere Informationsmenge den einen oder anderen Fehler automatisch ausgleicht.

Die Nutzer der Technik sehen „die Welt, wie sie wirklich ist“, behauptet der Rechtsprofessor Mayer-Schönberger. Das heißt im Gegenzug, dass die Nicht-Nutzer mit ihrer technisch bedingten Verblendung leben müssen. Das strukturelle Unwissen mag im Fall von Klimaanalysen, Transportlogistik, Physikexperimenten und sonstigen Expertendomänen vertretbar sein. Oft geht es bei der Datenanalyse aber nicht um Prozesse, sondern um Individuen – und um deren Unterscheidbarkeit. In einer idealen Datenwelt dauern Vorstellungsgespräche genau null Minuten, denn der Algorithmus kennt Fähigkeiten, Charakter und Stellenprofil und kann alle Informationen effizient miteinander in Beziehung setzen. Dadurch entsteht ein Machtgefälle, hier vielleicht abgelehnte Bewerbungen, deren Grund die Betroffenen nicht erfahren und nicht einmal mehr erahnen können. „Von da an kann man auf das Geständnis des Angeklagten völlig verzichten, der über sein Verbrechen weniger wüßte [sic] als der Computer“, schrieb der Geschwindigkeits-Theoretiker Paul Virilio schon 1980 über die Anfänge der Rasterfahndung. Reichlich 30 Jahre später macht „Predictive Policing“ Virilios Statement zur visionären Aussage: „Wer nicht mehr über die „Wahrheit“ verfügt, hat nichts mehr zu gestehen.“

A wie Alte News?

Aber zurück zu IBM. Mit einem jährlichen Umsatz von etwa 100 Milliarden US-Dollar und Nettogewinnen von rund 16 Milliarden, ist der US-Konzern globaler Marktführer im Hard- und Softwarebereich. Auch mit seinen Angeboten zur Auswertung von Verkehrs-, Kriminalitäts- und sonstigen Datenbergen liegt das Unternehmen weit vor Big-Data-Konkurrenten wie Amazon oder Microsoft.

Glaubt man dem Bitkom-Verband, dann ist der Hype um die Ganzheitsanalyse noch lange nicht vorüber. Rund 22 Milliarden US-Dollar, so die Prognose, sollen Unternehmen 2016 weltweit mit den Analyse-Technologien erwirtschaften (das Beratungsunternehmen McKinsey geht für 2017 von 53 Milliarden US-Dollar aus). Das klingt vergleichsweise wenig. Eigenbauer wie etwa Google, das mit der Sofortwerbe-Schalte AdWords (und dem Tracking und der Analyse, die dazu gehören) einen Großteil seines Umsatzes einfährt, sind in diese Zahl allerdings nicht eingerechnet.

Naja, dürften einige einwenden, wer bei Google Trends die zwei kurzen Wörter sucht, also Big Data mit Big Data analysiert, erkennt, dass das Phänomen nicht mehr ganz taufrisch ist. Schon vor knapp zehn Jahren hat Google angefangen, Bücher zu scannen, aus Sätzen Bedeutung abzuleiten und an der Übersetzungssoftware Translate zu basteln. Nimmt man die Suchanfragenstatistik als einen möglichen Indikator für Interesse (zumindest das der Google-Nutzer), dann verrät das Diagramm auch, dass der Begriff erst seit 2011 etwas exzessiver in die PC-Tasten getippt wird. Der (vorläufige) Höhepunkt liegt demnach – passend zu den NSA-Enthüllungen – erst rund zwei Monate zurück. Und es besteht noch großer Erklärungsbedarf. Zumindest meinen laut Bitkom nur 14 Prozent der Deutschen zu wissen, was Big Data ist und wofür es gut oder – je nach Perspektive – auch schlecht sein soll.

Was ich hier für die nächsten Wochen plane, ist eine Artikel-Sammlung, die lose durch alphabetisch geordnete Kapitelüberschriften in Form gehalten wird. Kein Big-Data-Konversationslexikon. Auch deshalb nicht, weil ich diesem Text und auch den folgenden nicht den Anschein von Vollständigkeit oder erschöpfender Systematik geben möchte. Warum dann dieses Format?

- Das Thema ist so umfangreich, dass es nicht schwer war, ziemlich schnell Unterpunkte für alle Buchstaben zu finden – genau diese Vielschichtigkeit möchte ich darstellen.

- Buchstabenlisten verraten sofort, dass ihnen kein echtes, inhaltliches System zugrunde liegt. Das finde ich prima. So kann ich auf Aktuelles und Zufallsfunde eingehen.

„Game-changing“ – revolutionär – diesen Ausdruck verwenden die Daten-Propheten auffallend oft. Im Gesundheits- und Versicherungswesen, im Finanz- und Mediensektor und in anderen Branchen sollen die Karten durch Big Data mehr oder weniger neu verteilt werden, weissagen die vermeintlichen Profiteure in Goldgräberstimmung. „Game-changing“ für den Blick, den wir auf dieses gesellschaftliche Phänomen werfen sollten, war allerdings auch die Geheimdienst-Affäre.

„Wir wollen wissen, was sie denken, bevor sie es selbst wissen“, zitierte Sascha Lobo vor einigen Wochen den Google-Verwaltungsratschef Eric Schmidt in einer Gesprächsrunde im Deutschandradio. Schmidt soll dieses Konzern-Ziel bei der Einführung der Analyse-Schleuder Google Now von sich gegeben haben. „Und das ist ein Satz, den eins zu eins auch General Alexander von der NSA hätte sagen können“, zog Lobo die Verbindung zu den Geheimdiensten. NSA-General Keith Alexander sprach zumindest vom Heuhaufen, den man bräuchte, um die Nadel zu finden. Und genau das ist die Logik von Big Data.

Spätestens seit einige Medien Einsichten in die Snowden-Dokumente hatten, wissen wir, dass wir nicht nur in einer Überwachungs-, sondern auch in einer „Berechnungsgesellschaft“ leben, heißt es bereits im Vorwort von „Big Data. Das neue Versprechen der Allwissenheit“. In dieser ist das oberste Ziel die Vorhersage menschlichen Handelns. Und Menschen können Produkte kaufen – oder aber Anschläge planen.

A wie Algorithmus

„Sie selbst können das eigentlich nicht mehr abschätzen.“ Das war die Antwort auf meine Frage, ob ich noch sinnvollerweise behaupten könnte, „nichts zu verbergen“ zu haben. Die Einschätzung kam von jemandem, der sich auskennt – von einem Informatikexperten, der im Bereich „Informationssysteme“, zu „Data-Profiling“, „Data-Fusion“ und „Maschinelles Lernen“ forscht. Hört sich paradox an? Das könnte man meinen, schließlich sollte ich selbst doch als erstes merken, wann und ob ich militante Ideen entwickle. Weit gefehlt. Fatale Rechenfehler haben manche schon bitter spüren müssen.

Etwa der Kanadier Saad Allami, der durch den Begriff „wegsprengen“ in einer SMS völlig ungerechtfertigt „Opfer der US-amerikanischen Rasterfahndung modernster Ausprägung“ wurde. Der Vertriebsmanager eines kanadischen Telekommunikationsunternehmens wollte durch das französische Wort „exploser“ nur seine Kollegen motivieren, eine möglichst durchschlagende Präsentation zu halten. Zu einem Terror-Anschlag wollte er hingegen niemanden anstiften. Aber die „Echtzeit-Analyse des US-amerikanischen Auslandsgeheimdiensts konstruierte offensichtlich aus der marokkanischen Herkunft, der abgefangenen SMS mit dem Begriff „explodieren“ und einer Truppe Einreisender als Empfänger der Nachricht eine Terrorwarnung“.

Ein Algorithmus hatte also nicht nur ein einzelnes Keyword gefunden, sondern ein Muster aus Herkunft, Adressaten und Sprache gebastelt. Dummerweise ein falsches. Das war 2012 – vor den NSA-Leaks. Damals hätte man zumindest mutmaßen können, dass Programme wie „Dishfire“ und „Prefer“ existieren, die Metadaten aus SMS-Texten herausrechnen („content derived metadata“) und mit anderen Informationen verbinden.

Big Data ist eigentlich die Kunst des computergestützten Lückenfüllens. Wenn bei einer großen Zahl von Personen immer wieder die Fakten A, B, C, D und E zutreffen (und die „Data-Mining“-Software dieses Muster erkennt), rechnet das Programm bei der nächsten Person (oder Kreditkartentransaktion, Verkehrsaufkommen, kollidierende Atomkerne) auf die A bis D zutrifft fest damit, dass auch E stimmt. Egal ob E in der Gegenwart (sexuelle Orientierung, politische Einstellung, psychische Krankheiten) oder in der Zukunft (Kaufabsicht, Krebsrisiko) liegt.

Das Füllen der Erkenntnis-Leerstellen geht mittlerweile ziemlich gut. Gesetzt den Fall, ich käme irgendwann auf die Idee, einen Systemumsturz zu planen. Wie ginge ich dabei vor? Da es mir an fundiertem Wissen über Revolutionen mangelt, würde ich vorher gerne ein Buch zum Thema lesen. Je nachdem wo ich lebe, halte ich es allerdings für keine gute Idee „Widerstand für Anfänger – Theorie und Praxis“ im Internet zu kaufen (bedenklicher Exkurs hierzu). Ich gehe also in eine Buchhandlung. Mit EC-, Kredit- und sonstigen Karten zu bezahlen, schlage ich mir besser gleich aus dem Kopf. Bargeld ist allerdings auch keine gute Wahl, weil, je nachdem wer mir über die virtuelle Schulter schaut, sofort klar wäre, welches Buch ich wann gekauft habe. Sobald ich aus dem Laden trete, könnten Programme mein Smartphone-Bewegungsprofil mit der Datenbank der Buchverkäufe abgleichen.

Deshalb entscheide ich mich, das Buch zu kaufen und danach noch einen Kaffee in dem Laden zu trinken. Als ich nach einer Stunde doch nachhause will, hat mich der Algorithmus schon wieder. Denn in der Zwischenzeit haben andere Kunden genau zwei Bücher gekauft: „Allgemeine Chirurgie“ und ein Koreanischlehrbuch. Die Tools wissen aus anderen Überwachungskontexten, dass ich weder Medizinstudentin noch Chirurgin bin oder mich jemals für Korea interessiert habe. Deshalb geht der programmierte Spitzel davon aus, dass ich wohl eher Politisches plane. Das kann völlig falsch sein. Vielleicht habe ich nichts gekauft oder interessiere mich entgegen der Prognose doch für Knochenbrüche. Die Logik von Big Data besagt allerdings, dass andere Daten – Likes, Posts, Visits, Reisen nach Korea – jede Neigungen bereits verraten hätten. (Das Beispiel stammt nicht von mir, sondern von hier)

„Aber wir leben jetzt in einer Welt […], die immer häufiger von sich selbst replizierendem Code gemanagt wird“, schreibt FAZ-Mitherausgeber Frank Schirrmacher in seinem Anfang 2013 erschienen Buch „Ego. Das Spiel des Lebens“. Schirrmacher zerlegt auf knapp 300 Seiten eigentlich die paranoide Denk-Architektur des Kalten Krieges, die sich nun auch im ökonomischen Handeln widerspiegelt. Aber der Journalist bearbeitet auch jene Systeme, die Tweets von Nachrichtenagenturen „mitlesen“ und daraufhin Börsenverkäufe auslösen. Und was macht dieser Code? Zum Beispiel die Evolutionstheorie nachspielen.

Sogenannte „genetische“ oder „evolutionäre“ Algorithmen werden dadurch erzeugt, dass Ausgangscode anhand einer „Aufgabe“ (zum Beispiel soll ein Roboter etwas aufheben) erst geprüft, dann verworfen oder weiterverwendet wird. Das, was sich durchgesetzt hat, löst die Aufgabe erneut, wird erneut bewertet und wieder aussortiert. Das geschieht über viele „Generationen“. Was zum Schluss in der x-ten Variante herauskommt, fährt – im Fall des Roboters – nicht mehr ständig gegen Wände. Oder es schlägt mir bei Facebook die Personen vor, die ich kennen könnte. Oder es sucht nach zusammen auftretenden Informationensmustern. Weil die Programme durch Auslese erzeugt werden, weiß zum Schluss allerdings „niemand mehr im Ansatz, wie diese Korrelation entsteht“. Die Evolutions-Metapher passt ziemlich gut. Wir laufen auf zwei Beinen. Warum? Weil sich das über Generationen hinweg mehr bewährt hat als andere Ideen.

A wie Apache Hadoop

Kaum ein anderes Bild könnte besser zu Big Data passen: Das Logo von Hadoop ist ein kleiner Elefant. Aus etwas Großem etwas Kleines, Erfassbares machen, so etwa könnte man den MapReduce-Algorithmus beschreiben, auf dem dieses freie Dateisystem der Apache-Foundation basiert. MapReduce ist die Grundlage vieler Big-Data-Systeme und zu den Nutzern von Hadoop-Anwendungen zählen Amazon, AOL, Ebay, Facebook, LinkedIn, Twitter, Yahoo aber auch Unternehmen, die sich etwa auf Gesichtserkennung („Facial recognition“) spezialisiert haben. Durch Hadoop bekommen viele Firmen – große und kleinere – die Chance riesige Web-Indices aufzubauen. MapReduce lässt sich gut darstellen, indem man sich ansieht, wie Google grundsätzlich (das heißt ohne personalisierte Suche und so weiter) Suchanfragen beantwortet. Google ist ein besonders gutes Beispiel, weil Mitarbeiter des US-Konzerns MapReduce vor zehn Jahren entwickelt haben.

Ganz vereinfacht gesagt, füttert man MapReduce mit Internetseiten, die Text enthalten. Jede dieser Seiten bekommt eine Adresse, etwa „83“, und wird in die einzelnen Wörter zerlegt. So werden Paare aus Wort und Adresse erzeugt. Das ermöglicht Google, mir eine „Adressliste“ zum Thema „Sporttauchen“ auszuspucken. Die Idee lässt sich nicht nur für Google-Ergebnisse nutzen. Prinzipiell alles, was sich auf parallele Rechnungen aufteilen lässt, geht mit der MapReduce-Taktik. Wichtig für Big Data ist das Mengen-Management, das Hadoop möglich macht. Die Software verteilt die klein gehackten Sätze mit ihren Herkunfts-Nummern auf viele Server, die „Data-Nodes“. Dort werden sie gleichzeitig bearbeitet, was ziemlich effektiv ist.

Das ist die Architektur, freie Data-Mining-Programme sind von der Apache-Foundation aber auch zu haben. Zum Beispiel eines mit dem putzigen Namen „Pig“, das eigentlich im Auftrag von Yahoo entwickelt wurde. Und so hängt das alles, das Know-How um Big Data, miteinander zusammen. Denn Nutzer der Apache-Produkte sind auch Unternehmen wie Cloudera und Splunk, die explizit Regierungsbehörden beliefern. Der britische Geheimdienst GCHQ nutzt Splunk-Tools, um etwa Youtube, Facebook und Blogs in Echtzeit zu überwachen und „Trends“ und künftige Ereignisse, etwa drohende Proteste in Bahrain, aufzuspüren.

A wie Anonym

„Worin liegt der Freiheitswert der Privatsphäre? Und vor allem: Was passiert, wenn der Schutz der Unsichtbarkeit wegfällt?“, fragte Christian Heller schon vor drei Jahren in seinem Buch „Post-Privacy. Prima leben ohne Privatsphäre“. Sicher ist: Im Big-Dataismus lässt sich Anonymität aus dem angehäuften Datenberg potentiell wieder rausrechnen. Das nennt sich dann „De-Anonymisierung“, ein Konzept, das wir seit 30 Jahren kennen. In das Urteil zur Volkszählung schrieben die Richter des Bundesverfassungsgerichts schon 1983, dass es „unter den Bedingungen der automatischen Datenverarbeitung […] kein belangloses Datum mehr gibt“. Heute erkennen uns Smartphones am Gang, Autositze am Sitzprofil , Stromzähler am Energiekonsum und Videokameras am Faltenwurf unserer Kleidung. Mit allem, was wir tun, produzieren wir nicht nur Finger-, sondern auch errechenbare „Verhaltensabdrücke“. Selbst unser Pulsschlag ist individuell. Und das ist aus Sicht vieler Firmen, Geheimdienste und Forscher ungemein praktisch. Denn Big Data funktioniert nur mit Kontext. Und genau dieser Kontext, der Datenhaufen, ist verräterisch. Klar, man kann der Informationssammlung eine andere Überschrift geben, einen Namen etwa durch ein Pseudonym ersetzen. Und trotzdem bleiben Wege offen, um Menschen zu reidentifizieren. Sogar, wenn nur pseudonymisierte Daten anderer „geknackt“ wurden.

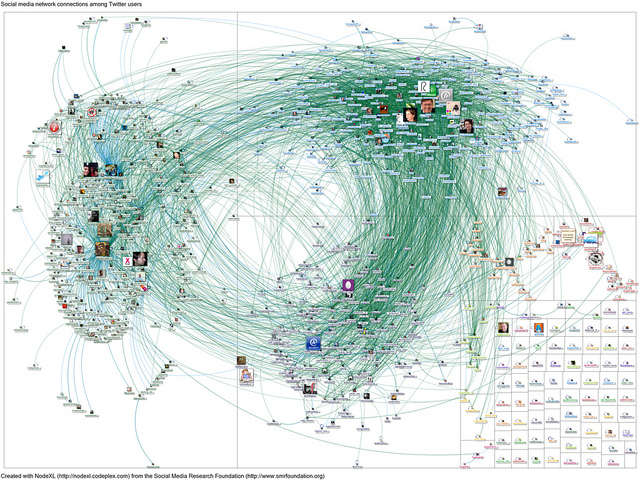

Vor einigen Wochen hat Lance Bennett von der University of Washington an der Freien Universität Berlin einen Gastvortrag gehalten. Es ging um seine Forschungen zu Occupy Wall Street. Der Politikwissenschaftler hat den Protest auch mit Big Data-Technik erforscht, natürlich nur mit pseudonymisierten Daten. Big Data habe seine Forschung völlig verändert, sagte der Politikwissenschaftler damals. Wenn allerdings das FBI irgendwann vor den Universitätstüren stehen würde, müsste man wohl die Server vernichten, gab Bennett zu. Anonymität ist bei Big Data eine Frage der Rechenkapazität. Besonders wenn man wie der Forscher Daten von Twitter auswertet.

(Und bald geht’s weiter mit B, C, D…)

Danke, schöner Text.

Aber die Leute die hier lesen wissen das und für die die es noch wissen müssten ist das alles viel zu abstrakt und lang.

Solange man nicht kurz und prägnant den Leuten sagt: Das und das wird gemacht und es betrifft dich auf diese und jene Weise… wen juckt das?

Das ist genauso eine latente Gefahr wie Terrorismus. Ja, es gibt Terrorgruppen, soll ich mich deswegen an jeder Bushalte Stelle nach Leuten mit Bart umgucken? Und ja, es gibt Überwachung, aber soll ich deshalb nicht mehr meine Katze bei FB posten?

Solange die Menschen nicht einfach und klar verstehen, dass Überwachung und Big Data keine latetente sondern eine konkrete Gefahr ist ändert sich nichts.

Und ein paar Beispiele machen keine konkrete Gefahr aus. Sondern man muss den Leuten irgendwie beibringen, dass sie JETZT nix zu verbergen haben könnten, aber dank der Überwachung/Speicherung das was sie JETZT tun nächste Woche/nächsten Monat/nächstes Jahr dazu führen könnte im Gefängnis zu landen, Haus Hof Familie und Freunde zu verlieren.

Man muss den Leuten verständlich machen, warum das so ist. Aber einfach. Packt die Leute dort wo es weh tut: Geld, Arbeit, Eigentum, Auto, Familie, Nachbarn, sozialer Status, etc.

Z.B. konrekte Anleitungen (aber keine korrekten…), wie man mit Hilfe der Überwachung jmd aus dem Weg schafft. Oder wie man Dank Überwachung sein Haus verliert.

Wie man das im Einzelnen genau macht, keine Ahnung, bin kein Journalist oder Blogger aber ohne Aufreger regt sich auch niemand auf.

Greetz,

GHad

Text und Idee finde ich auch gut, werde es gern lesen.

Was die „anderen Leute“angeht, seh ich es genauso. es müssen starke, platte Narrative her, am besten Filme, was mit Auto, Bier oder Fussball.

… in ein paar Jahren kannst du mit deinem Auto nur noch Richtgeschwindigkeit fahren, weil sonst deine Versicherung unbezahlbar wird. Bevor es losgeht, musst du in dein Smartphone pusten (nein, wenn es dein Kumpel macht wird das an der mitgepusteten DNS erkannt) , und sowieso geht die Krankenkasse hoch, weil du diese Woche schon 4 Bier hattest und schon wieder nicht das Rad genommen hast.

Findest du auf dem Autobahnparkplatz eine Tüte mit Bargeld, kannst du sie einfach stehen lassen (oder auch abgeben), weil es sowieso rauskäme dass du der Finder bist. Du hättest es so gut brauchen können, seitdem dir aus unerfindlichen Gründen dein Job gekündigt wurde und du trotz guter Qualifikation und makellosem Lebenslauf alle Bewerbungen zurückgeschickt bekommst ( daß du bei deinem Urlaub in Ägypten damals dem netten Koch irgendein arabisches Buch bei Amazon bestellt hast, hast du längst vergessen). Die Kartenverkäuferin baggert dich massiv an, weil ihr Smartphone wie wild vibriert, als du vor ihr stehst. Aber vergiss es, deine Frau erfährt es sofort. Schade, daß der Algorithmus bei deiner Hochzeit noch so in den Kinderschuhen steckte. Aber schlimmer geht es ja in der Ehe deiner Tochter zu. Hätte sie nur nicht jahrelang Fakedaten im Internet gestreut!

Seitdem Google bei Hertha eingestiegen ist, haben sie nicht mehr verloren. Du weisst auch nicht, warum du immer noch zu den Spielen gehst.