Das zu Facebook gehörende soziale Netzwerk Instagram hat einen Film des ARD-Politmagazins Monitor entfernt, weil dieser angeblich gegen die Gemeinschaftsrichtlinien verstoßen soll. Der betroffene Film des Magazins rekonstruiert die Ereignisse beim rassistischen Anschlag von Hanau und zeigt unter anderem Versäumnisse der Polizei auf. So waren Notrufapparate nicht durchgehend besetzt, eine Anruf-Weiterleitung an die Leitstelle nicht geschaltet.

Georg Restle von Monitor beschwerte sich über die Löschung des Filmes direkt bei Facebook und Instagram und machte sich über Twitter Luft:

#

Instagram begründete die Löschung bislang mit den folgenden automatisierten Worten:

Wir haben deinen/deine/dein Beitrag entfernt, da er/sie/es gegen unsere Gemeinschaftsrichtlinien verstößt. Wir haben diese Richtlinien aufgestellt, um unsere Community auf Instagram zu unterstützen und zu schützen.

Die Journalistengewerkschaft dju bei ver.di nannte die Entscheidung des sozialen Netzwerkes „völlig absurd“. Niema Movassat, Abgeordneter der Linkspartei im Bundestag, forderte „Vorgaben, die so ein Löschverhalten verhindern“. Stefan Gelbhaar (MdB) von den Grünen forderte auf Twitter die unverzügliche Aufhebung der Sperre.

Eine kurzfristige Presseanfrage zu den Gründen der Sperrung und ob die Entscheidung automatisiert oder von Menschen getroffen wurde, hat Facebook bislang nicht beantwortet. Wir tragen die Antwort nach.

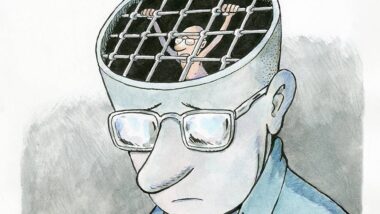

Blackbox Moderation

Unberechtigte Sperrungen und Löschungen von Inhalten kommen in sozialen Netzwerken sehr häufig vor. In den meisten Fällen wissen die Betroffenen nicht, was ihnen vorgeworfen wird und wie sie sich gegen die Sperrung wehren können. Generell haben es prominente Accounts leichter, sich gegen solche Löschungen zu wehren.

Weil die Moderationspraxen der Tech-Konzerne eine Blackbox sind, ist fast nie nachvollziehbar, wie Entscheidungen entstanden sind. Moderationsentscheidungen technischer und menschlicher Art können auch durch massenhaftes Melden eines Beitrages ausgelöst werden. Oftmals kann in der Moderation weder Satire erkannt noch der Kontext von Inhalten richtig eingeordnet werden.

Wie genau die Moderation nach welchen Regeln abläuft, ist bei keinem der Netzwerke bekannt. Einblicke gibt es nur über Whistleblower:innen, die über ihre Arbeit in den Löschzentren bei Facebook oder bei TikTok öffentlich sprechen. Die Presseabteilungen der Unternehmen hingegen verstecken sich bei Presseanfragen meist hinter der Floskel, dass sie über einzelne Fälle nicht sprechen würden und geben quasi nie Einblick in das, was geschehen ist.

Update, 24. Februar 2021: Inzwischen ist der Monitor-Beitrag auf Facebook wieder zu finden. Auf unsere Presseanfrage heißt es heute Vormittag von einem Facebook-Sprecher: „Wir haben den Beitrag wiederhergestellt und entschuldigen uns für den Fehler. Die Monitor-Redaktion ist bereits informiert.“

ˋWir haben deinen/deine/dein Beitrag entfernt, da er/sie/es gegen unsere Gemeinschaftsrichtlinien verstößt.´

Wie bitte facebook? Wir haben !dein! Beitrag entfernt, da !sie! gegen unsere Gemeinschaftsric …

Die Beitrag? Das Beitrag? Ist hier das Gendern gewaltig schief gelaufen, oder übersehe ich etwas?

Instagram ist kein soziales Netzwerk, sondern eine Werbeplatform.

Hallo miteinander,

kleinere Kreativ-Schmieden als Monitor oder Titanic können auf einem Weg doch regelrecht unveröffentlicht werden, so dass sich in der Öffentlichkeit kaum darüber diskutieren lässt, dass es den Beitrag gegeben hat und wie er ungekürzt/verändert ausgesehen hat.

Brauchen wir nicht einen Dienst, der strukturell vielleicht ähnlich organisiert ist, wie die „Common Vulnerabilities and Exposures“? Dort könnten AutorInnen Metadaten zu ihren Werken hinterlegen, die deren Integrität sicher stellen: SHA256-String, PGP-Signatur, Veröffentlichungsplattformen, Torrent-Link als Backup, etc.

Als Maßnahme gegen die Unveröffentlichung ließe sich so eine Struktur auch gegen mögliche Ambitionen staatlicher Stellen etablieren – egal, ob in China, Europa, Russland, Brasilien oder den USA: Erst wenn wir global organisiert belegen können, dass ein Werk existiert hat und wie es im Original aussah, können wir auch einen breiten öffentlichen Diskurs starten, ob diskriminierende, puritanische oder politische Motive beim Overblocking eine Rolle gespielt haben – und ob wir als Souverän so eine Manipulation hinnehmen wollen.

Es würde mich sehr freuen wenn man Twitter etc. Beiträge einfach Zitiert mit Link statt es einfach einzubinden. So bleibt es mir weiterhin verborgen.

Diese ganze Zensurmaschinerie, ist doch erst dadurch entstanden, dass unliebsame, als rechts bezeichnete Meinungen, sogenannte Fakenews und sogenannte Hassbotschaften, gelöscht werden sollen bzw. müssen.

Dumm nur, wenn der eigene Zensurversuch eben nach hinten los geht.

Diese neu geschaffenen Werkzeuge können sowohl gegen Rechts, als auch gegen Links oder eben gegen Unliebsam eingesetzt werden.

Wenn sogenannte alternative Kanäle gesperrt werden, wird dies fürgewöhnlich hoch gelobt.

Nein, dem würde ich eindeutig widersprechen. Moderationsregeln und Löschzentren hatten die großen sozialen Netzwerke schon lange bevor es ein NetzDG in Deutschland gab. Moderation in Internetforen gab es schon, bevor die sozialen Netzwerke erfunden wurden. Dass die sozialen Netzwerke heute strafrechtlich relevante Inhalte wie Morddrohungen, Volksverhetzung und den Aufruf zu Straftaten weglöschen ist eine Folge einer gesellschaftlichen Debatte nach dem Jahr 2015 – und den damit verbundenen sprunghaften Anstieg solcher strafrechtlich relevanter Kommentare und Inhalte – die zu mehr Druck auf die Netzwerke geführt hat.

Für die Netzwerke ist Moderation – also privatisierte Zensur – eine Sache, die vor allem teuer ist. Deswegen ist auch lange so wenig passiert. Und deswegen versuchen die Netzwerke heute auch mit algorithmischen Systemen Moderation zu gestalten, weil das verspricht, billiger zu sein als menschliche Arbeitskraft. Fehlentscheidungen finden also eher statt, weil der Algorithmus falsch lag oder weil der oder die Moderator:in einfach zu wenig Zeit hat, eine Nachricht richtig zu bewerten oder in Kontext zu setzen. Oder die Regel falsch interpretiert.

Richtig ist: Jedes Zensurwerkzeug kann gegen jede:n eingesetzt werden. Das Problem daran ist, dass der Prozess nicht unbedingt nach den geltenden Gesetzen stattfindet, dass er vollkommen intransparent stattfindet und dass Betroffene sich nicht einen Beschwerdeweg wählen können, der diesen Namen verdient.

Insofern halte ich Ihre Sicht für eine in der Rechten weit verbreitete Opfer-Theorie. In solchen Fällen kommt jetzt eben Schadenfreude auf, gerade wenn es um Monitor und Georg Restle geht, die ja ein rotes Tuch in der Szene sind.

Vielen Dank für eure ausführliche Antwort – die ich nur vollumfänglich unterstützen kann!