Auf dem Bildschirm erscheint ein neues Ticket. Mika schaut sich den Fall 20 Sekunden an und drückt auf Delete. Mika hat heute schon 240 solcher Tickets bearbeitet und gerade einmal die Hälfte seines Arbeitstages geschafft. Mika arbeitet im Löschzentrum von Facebook in Essen. Dort moderiert eine Firma namens Competence Call Center (CCC) gemeldete Inhalte für den Weltkonzern. Das nächste Ticket: der Post einer Person, die als Abgeordnete im Bundestag sitzt. Mika überlegt etwas länger. Mika sieht ein „PR-Fire-Risk“ und eskaliert den Fall zur Facebook-Zentrale in Dublin.

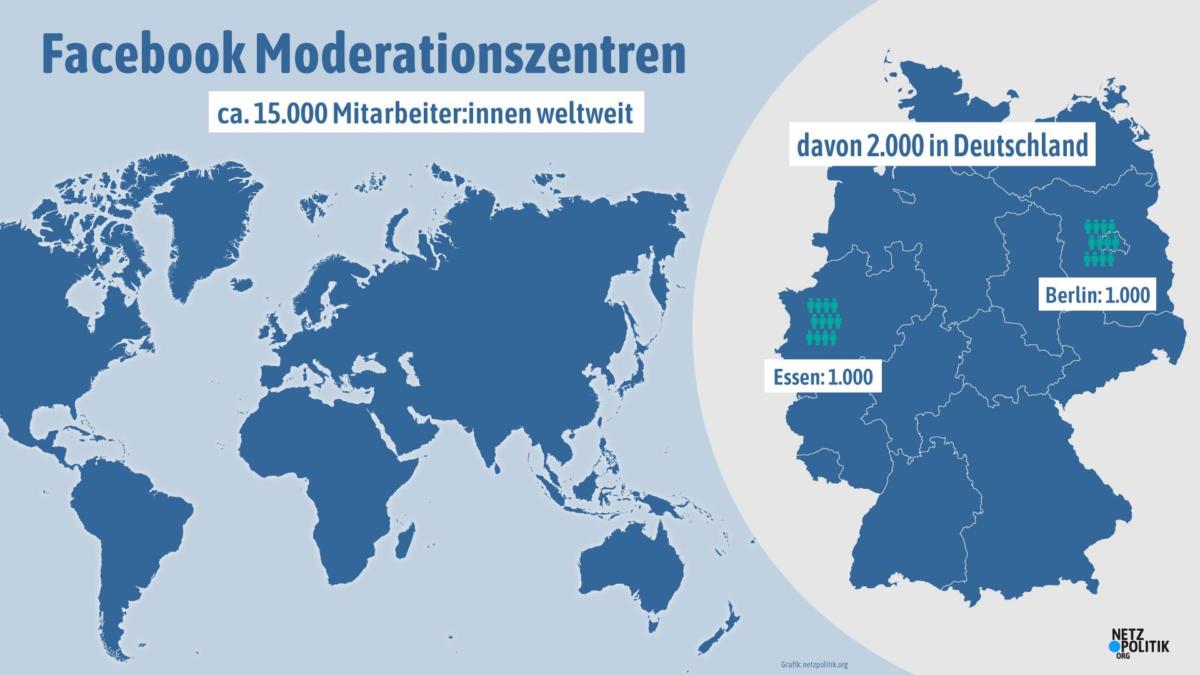

Mehr als 15.000 Menschen sollen laut Facebooks Angaben weltweit damit beschäftigt sein, Inhalte zu überprüfen. Der Datenkonzern und seine Dienstleister ziehen die Content-Moderation wie einen Hochsicherheitsbereich auf. Mika muss auf dem Weg zur Arbeit zwei Mal an Fingerabdrucksensoren vorbei. In einem videoüberwachten Raum schließt Mika alle persönlichen Dinge in einem Spind weg. Vor allem Stifte, technische Geräte, Handy, Papier, Speichermedien – alles, was der Arbeitgeber für gefährlich hält. Wer verbotene Gegenstände in die Arbeits-„Floors“ mitnimmt, kann entlassen werden.

„Durch große Macht kommt große Verantwortung“, erzählt unsere Quelle. Sie will Klarheit darüber schaffen, wie die Moderation bei Facebook abläuft. Viele Dinge würden in der Öffentlichkeit negativer dargestellt als sie sind. Die Intransparenz von Facebook und seinen Dienstleistern trage unnötigerweise zu Missverständnissen bei, sagt die Person, die ihren Job sehr wichtig findet: „Was ich sehe und runternehme, müssen andere nicht mehr sehen.“

Im Dreischichtbetrieb Instagram und Facebook moderieren

Erstmals hat netzpolitik.org einen detaillierten Einblick in die Abläufe im Facebook-Löschzentrum des Dienstleisters CCC in Essen bekommen. Für die Recherche haben wir eine Person getroffen, die wir in unserer Geschichte geschlechtsneutral Mika nennen. Sie arbeitet vor Ort und überprüft Inhalte und Nutzerkonten. Sie erklärt uns die Strukturen, Hierarchien, Abläufe, Arbeitsbedingungen, Systeme und Arbeitskontrolle bei CCC, einem Unternehmen mit weltweit 7.500 Angestellten.

Etwa tausend Menschen arbeiten alleine im Essener Moderationszentrum von CCC. Im Dreischichtbetrieb bearbeiteten sie auf Facebook und Instagram gemeldete Inhalte. Sowohl einzelne Inhalte – auch aus Gruppen und Messenger – als auch ganze Profile, Gruppen und Seiten werden überprüft. Die Moderatoren bearbeiten in Essen derzeit 13 nach Sprachen getrennte Märkte – von Albanisch bis Persisch. Facebook bestätigte uns gegenüber nur, dass in Essen Inhalte auf Deutsch, Niederländisch, Arabisch und Türkisch bearbeitet würden.

Für den deutschen Markt werden nach Angaben von Mika in Essen auch die Livestreams der Nutzer:innen bearbeitet. Einzig Fake-Profile würden in Essen nicht überprüft.

Auch wenn Facebook die Moderationsarbeit ausgelagert hat: Über Abläufe und Regeln der Moderationsarbeit entscheidet der Konzern. Regelmäßig gibt es Policy-Updates von der Europa-Zentrale, für höhere Hierarchieebenen ist der Draht nach Dublin kurz.

Tickets, Queues und SRT

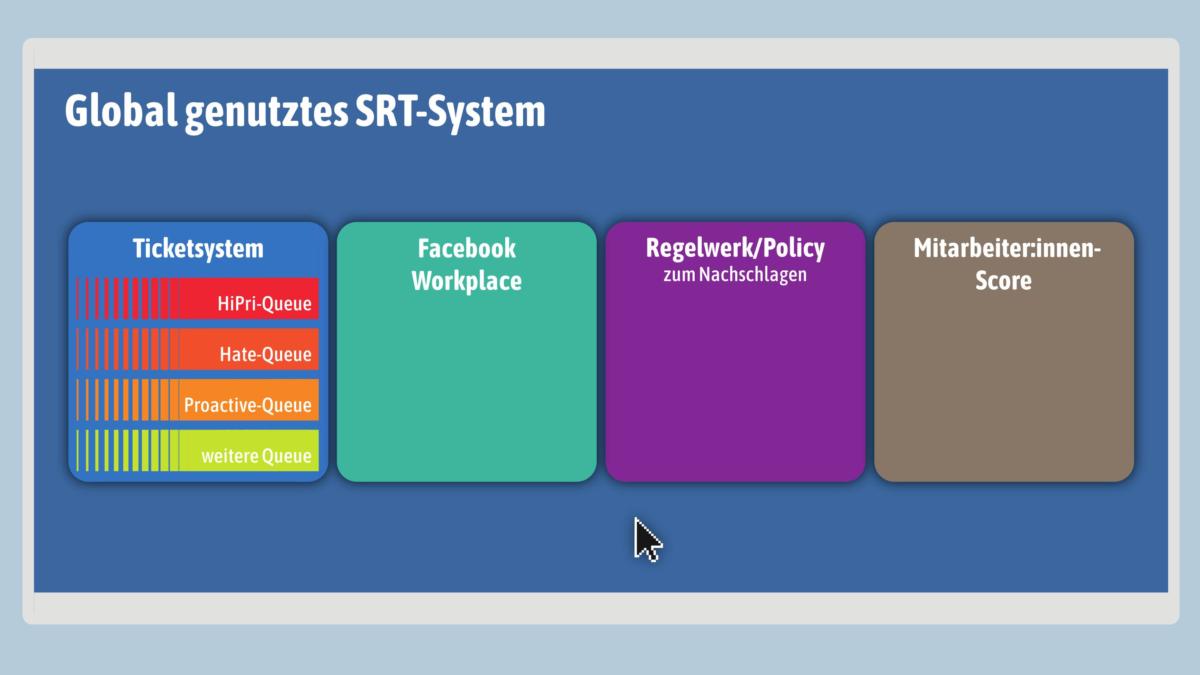

Auch die Software-Lösung für die Moderationsarbeit stammt von Facebook. Das Ticketsystem ist Teil einer browserbasierten Arbeitsoberfläche namens SRT. Dieses weltweit eingesetzte System kombiniert das Ticketsystem für die Moderation mit einem Facebook Workplace sowie der Möglichkeit, digital die umfangreichen Policy-Regeln einzusehen.

Das SRT-System strukturiert die Moderation. Jedes Ticket steht für einen Inhalt, der überprüft werden soll. Gespeist werden die Tickets aus thematischen Queues, die unterschiedliche Prioritäten haben. In der von Mika „Hi Pri Queue“ genannten Warteschlange sind Dinge wie Selbstverletzungen, Suizidankündigungen, Terrordrohungen, Kinderpornografie und ähnliches enthalten. Tickets aus dieser Queue werden sofort bearbeitet und im Zweifelsfall an die europäische Facebook-Zentrale in Dublin weitergeleitet. Dort wird nach Ansicht der Quelle auch entschieden, ob staatliche Behörden eingeschaltet werden oder nicht. In Essen habe man damit nichts zu tun und erfahre generell nicht, wie sich ein Fall weiterentwickelt habe.

Für Tickets aus der „Hate Queue“ hätten die Mitarbeiter 24 Stunden Zeit, sagt unsere Quelle. Treffen Facebooks eigenen Kriterien für Hate Speech zu, wird der Inhalt gelöscht. Das deutsche Netzwerkdurchsetzungsgesetz (NetzDG) schreibt ebenso vor, dass Hassrede innerhalb dieses Zeitraums gelöscht wird. NetzDG-Meldungen würden bei Facebook jedoch nur einen sehr geringen Anteil ausmachen, sie werden an anderer Stelle bearbeitet.

Im SRT können die Queues den Moderatoren individuell zugeschaltet werden: „Als Moderator macht man alle Queues, für die man trainiert wurde“, sagt Mika. Es gibt weitere Queues, beispielsweise für Fotos oder die „Proactive Queue“, mit der Facebook Künstliche Intelligenz für Moderation trainiert. Facebook selbst hat gegenüber netzpolitik.org die Existenz der beschriebenen Queues nicht bestätigt.

Ignorieren, löschen, eskalieren

Liegt ein Inhalt auf dem Tisch eines Content Moderators, kann er verschiedene Optionen auswählen:

Die Hauptkategorien sind:

- Ignore benign („Ignorieren, gutartig“)

- Ignore sexually suggestive („Ignorieren, sexuell suggestiv“)

- Delete („Löschen“) für alle möglichen Kategorien wie Hate Speech, Bullying, Spam, und anderes.

- Checkpoint (bei Suizid, Selbstverletzungen), der User erhält eine Nachricht: „Einem deiner Freunde ist aufgefallen, dir geht es nicht gut.“ Der Inhalt wird gelöscht.

- Escalate („Eskalieren“) bei Terrorismus, Bombendrohungen, Kinderpornografie, Revenge Porn, usw. Das Ticket wird direkt an Facebook weitergeleitet. Dort wird entschieden, ob staatliche Behörden eingeschaltet werden.

- Mark As… („Markieren als…“): Ein Bild wird mit einem Weichzeichner belegt und erhält einen Hinweis auf verstörenden Inhalt.

- Send to… („Senden an…“): Das Ticket wird an eine höhere Hierarchiestufe in der Moderation oder gegebenenfalls an Facebook in Dublin übergeben.

Die einzelnen Kategorien enthalten jeweils weitere Unterpunkte, die bis zu vier Ebenen tief gehen.

Eine Besonderheit bei der Moderation sind Fälle, die als „PR-Fire-Risk“ eingeschätzt werden. Dieser Fall tritt bei Politiker:innen, Prominenten und Accounts großer Reichweite ein – als Richtwert gelten laut Mika mehr als 100.000 Follower. Facebook möchte einen öffentlichen Aufschrei über Moderationsentscheidungen vermeiden, die Moderierenden sollen den Fall direkt zu Facebook nach Dublin eskalieren, wenn das Ticket nicht eindeutig entschieden werden kann. Als Beispiel nannte unsere Quelle rassistische Aussagen der AfD-Politikerinnen Beatrix von Storch oder Alice Weidel.

Entsteht so eine digitale Zwei-Klassen-Gesellschaft? Facebook bestreitet öffentlich, Prominente bei der Moderation zu bevorzugen oder besonders zu behandeln. „Die Regeln sind für alle die gleichen“, weicht der Leiter von Facebooks Brüsseler Lobby-Büro, Thomas Myrup Kristensen, unserer Frage aus. Aber kann man wirklich von Gleichbehandlung sprechen, wenn einflussreiche Nutzer:innen besonders sensibel und aufmerksam geprüft werden?

„Wir machen Facebook-Jura“

Facebook ist stolz auf seine Inhalte-Moderation. Jede Woche entscheidet der Konzern in mutmaßlich Millionen von Fällen über das Löschen oder Nicht-Löschen von Inhalten. „Es gibt nichts, was nicht irgendwo verbreitet wird“, erklärt uns Mika lakonisch. Der Werbekonzern stellt mit Facebook und Instagram die wichtigsten Sozialen Netzwerke der westlichen Welt. Menschen tauschen sich hier aus, prägen ihre Identität und konstruieren ihre Weltsicht. Auch Wahlkampf und politische Debatten finden hier statt. Facebook betreibt eine zentrale Infrastruktur der digitalen Öffentlichkeit – und legt damit die Kommunikationsregeln für Milliarden Menschen fest.

Man schaffe einen Ausgleich zwischen dem Ziel, den Nutzerinnen und Nutzern eine Stimme zu geben und sie zu schützen, sagte Facebook-Managerin Vittoria Federici bei einer Konferenz in Brüssel. Die Lösch-Brigaden handeln dabei hauptsächlich nach Facebooks eigenem Recht, den Gemeinschaftsstandards. Gegenüber der Öffentlichkeit sind diese Regeln schwammig formuliert. Intern legt sie ein geheimes, hunderte Seiten umfassendes Dokument streng und genau fest. Es ist das „Facebook-Gesetz“, wie Mika es nennt.

Wie komplex und bisweilen problematisch das Regelwerk ist, ist inzwischen in vielen Medienberichten beschrieben worden. Weniger bekannt ist seine Anwendung in der Praxis. „Was wir machen, ist Facebook-Jura“, erklärt uns Mika. Die umfangreichen Regeln müssten möglichst genau ausgelegt werden. Es dauere am Anfang eine Weile, bis die Moderator:innen lernten, ihr Bauchgefühl und ihre eigene Meinung zu unterdrücken.

Eine besondere Qualifikation müssen Moderatoren nicht mitbringen. Arbeitet ein Moderator für einen bestimmten Markt, muss er Englisch und die jeweilige Landessprache beherrschen. Am Anfang müssen alle neuen Mitarbeiter ein Training von zwei Wochen durchlaufen, danach begleiten die Neuen einen erfahrenen Mitarbeiter beim so genannten „Shadowing“. Später üben sie an simulierten Moderationsentscheidungen und dann steigt der Mitarbeiter direkt ein.

Dass Mika selbst mit einer Moderationsentscheidung hadert, kommt nach eigener Aussage nur noch im Bereich Bullying und Hate Speech vor: Viele Gemeinheiten, die sich Menschen in dem Netzwerk antun, seien nach den Facebook-Regeln nicht löschbar. Außerdem reizten Rassisten und Rechtsradikale in ihren Formulierungen die Gemeinschaftsstandards oftmals so aus, dass sie immer genau am Rande der Löschung agierten – und so verklausuliert den selben Inhalt rüberbrächten.

Unsere Quelle wirkt sehr abgeklärt. Sie lasse „die Sachen“ an der Türe bei der Arbeit liegen, sonst könne man das nicht aushalten: „Am Anfang war es hart, aber man gewöhnt sich daran. Und Videos von Enthauptungen gehören noch zur netteren Kategorie, wenn die Henker wissen, was sie tun.“ 10,65 Euro pro Stunde verdienen Mitarbeiter in der untersten Stufe brutto, an Wochenende und in der Nacht bis zu 50 Prozent mehr. Psychologische Betreuung gebe es in Essen nur tagsüber und unter der Woche. Laut Facebook seien jedoch alle Dienstleister verpflichtet, rund um die Uhr Psychologen, zur Not via Telefon, bereit zu halten.

Facebooks Regeln werden ständig überarbeitet. In sogenannten Market Calls und Clarifications wird regelmäßig über aktuelle Entwicklungen informiert. Zuletzt wurde etwa weltweit jede Form der sexuellen Anbahnung auf Facebook verboten. Laut der zuständigen Managerin Federici spricht der Konzern vor Regeländerungen mit Vertretern der Zivilgesellschaft, Wissenschaftlern und Behörden. Doch wie Facebook letztlich zu seinen Entscheidungen kommt, ist völlig undurchsichtig.

Moderatoren werden ständig überwacht

Die Leistung der Mitarbeiter wird mit einem Score-System überwacht. In dieses fließen Daten wie richtige Moderationsentscheidungen, Anzahl der bearbeiteten Tickets und Geschwindigkeit ein. Zielwert in diesem Score-System, das nach Auskunft unserer Quelle höheren Wert auf Qualität als Quantität legt, sind 95 Prozent. Die Mitarbeiter können ihren Score jederzeit in ihrer Arbeitsoberfläche, dem SRT, einsehen.

Erreicht ein Mitarbeiter in bestimmten Gebieten den Score nicht, bekommt er eine Nachschulung zu diesem Themengebiet. Quantitativ seien 250 bis 400 Tickets pro Tag normal bei CCC, es gebe aber auch Leute, die mehr als 1.500 Tickets abarbeiten würden. Schafft jemand weniger als 100 Tickets, führe das recht schnell zur Kündigung. Eine Hire-and-Fire-Kultur mit hoher Fluktuation, so beschreibt die Quelle ihre Erfahrungen im Betrieb. Die Chefs machten ständig Druck. Nach der Einstellung würden viele schnell wieder aussortiert, wenn sie nicht die erwartete Leistung brächten.

Einsteiger fangen bei CCC als Content Moderator (CM) an. Die nächste Stufe in der Hierarchie sind die Subject Matter Experts (SME). Sie werden bei kniffligen Fällen kontaktiert. Auf 15 Content Moderatoren kommt einer von ihnen. Darüber stehen die Quality Auditors (QA), welche direkt mit Facebook in Dublin in Kontakt stehen und von Facebook kontrolliert werden. Hier soll die Quote etwa 1:50 sein. Die QAs überprüfen stichprobenartig die Entscheidungen der Moderatoren, teilweise auch für andere Löschzentren. Aus den Entscheidungen der QAs speist sich auch der Score der Moderatoren. Facebook sagt auf Anfrage im Widerspruch zu unserer Quelle, dass alle Hierarchie-Ebenen regelmäßig mit Facebook-Mitarbeitern in Kontakt seien.

Bald endet Mikas Arbeitstag, fast 600 Mal hat unsere Quelle heute entschieden, was auf der Plattform bleiben soll und was nicht. „Irgendwann hat man fast alles gesehen. Es sind nur noch Variationen.“ Unsere Quelle weiß nicht, wie lange sie den Job noch weiter machen will. Irgendwann sei es an der Zeit, mal etwas anderes zu tun.

Über diese Recherche und die Quellen:

Unser Wissen über die Organisation des Löschzentrums in Essen beruht auf einem mehrstündigen Gespräch von drei Redakteuren von netzpolitik.org mit einer Quelle bei Competence Call Center. Wir können und wollen die Quelle, die wir für glaubwürdig halten, aus Gründen des Informantenschutzes nicht näher beschreiben. Wir sind uns der Probleme und des Risikos bewusst, dass wir uns in Teilen dieser Recherche nur auf eine Quelle stützen können. Deswegen haben wir weite Teile des Artikels durch andere Quellen, auch von anderen Facebook-Dienstleistern verifizieren und bestätigen lassen. Durch diese Quellen können wir heute sagen, dass bei allen Dienstleistern sehr ähnliche oder gar gleiche Systeme eingesetzt werden. Weite Teile dieser Recherche hat außerdem Facebook uns gegenüber bestätigt, die Dienstleister selbst gaben kein Statement ab.

Aus meiner Erfahrung kann ich nur sagen, dass die Beschwerde sehr oft zu schnell „bearbeitet“ wird und man bekommt den Eindruck, dass es automatisch mit KI geprüft wird.

Außerdem ist es nicht klar, was Hatespeech ist. In manchen Sprachversionen gehörte ein oder anderes Wort zum erlaubten Wortschatz und dann plötzlich nicht mehr. Dann fängt man an die Benutzer für alte Kommentare zu sperren, die vor Jahren geschrieben wurden. Es gibt keine Verjährungsfrist usw.

Nach der Einführung von NetzDG sperrt zur Sicherheit öfter, es war zu befürchten.

Hast du den Artikel gelesen?

Wer The Cleaners¹ gesehen hat, dürfte keine Zweifel daran haben, dass die Schilderungen zutreffend sind.

¹ https://de.wikipedia.org/wiki/Im_Schatten_der_Netzwelt

Dass der Artikel bzw die wirklich wichtigen Teile nur auf einer Quelle basieren, ist nicht nur schwierig sondern unsauber. Selbst wenn ihr sie für glaubwürdig haltet, was heißt das? Und den Disclaimer man Ende des Textes dürfte nur ein sehr kleiner Teil der Menschen lesen, die Überschrift, Teaser oder sogar die ersten paar Absätze lesen. Natürlich ist es verführerisch, eine (gute) Quelle zu haben, die einem exklusiv etwas erzählt, umso mehr wenn es in das Weltbild oder den Zeitgeist passt, aber das als kritische Plattform dann in dieser Form weiterzutragen, halte ich für falsch.

Nein, es ist nicht unsauber, da wir die Informationen der Quelle durch andere Quellen verifiziert haben und weil uns Facebook in weiten Teilen die Aussagen bestätigt hat. Das ist journalistisch sauber. Dass wir am Ende aus Transparenzgründen zusätzlich offenlegen, dass die Recherche initial nur auf einer Quelle beruhte, wäre angesichts der mehrfachen Bestätigung der Aussagen gar nicht nötig gewesen, ist uns aber wichtig.

Es sei in diesem Zusammenhang auch auf den vor einem knappen Jahr erschienenen Dokumentarfilm „The Cleaners“ verwiesen welcher sich mit dem gleichen Thema beschäftigt, hier mit dem Schwerpunkt auf ein Löschzentrum auf den Philippinen..

Mich würde interessieren, ob und wie weit Facebook seinen Moderatoren verbietet, über die Arbeit und die internen Abläufe zu reden.

Muss eure Quelle mit Vertragsstrafen o.Ä. rechnen?

Die Mitarbeiter:innen der Moderationszentren haben Geheimhaltungsverpflichtungen (NDA / non-disclosure agreements) unterschrieben, welche ihnen unter Androhung einer Vertragsstrafe das Reden über ihre Arbeit verbieten.

Besteht nicht auch die Möglichkeit, dass die Quelle von Facebook instruiert wurde, mit euch zu sprechen?

Es handelt sich um ein deskriptives Stück, wie die Arbeit in einem Moderationszentrum funktioniert. Wir haben die Informationen der Quelle durch andere Quellen verifiziert und bestätigt bekommen. Natürlich haben wir in der Bewertung der Quelle im Vorfeld der Veröffentlichung alle Varianten durchgespielt, halten aber nach der sorgfältigen Prüfung der Informationen solche Spekulationen für wenig zielführend.

Nur aus Neugier: Wurde dieser Artikel auch auf Facebook veröffentlicht / zugänglich gemacht?

Oder Verweise / Hinweise auf den Film Cleaners?

Wenn ja: Wie hat Facebook darauf reagiert? eventuell Mit einer Löschung wegen Verletzung der

Standards oder Richtlinien (wie auch immer die Aktuell aussehen…)?

Wie oben geschrieben: Nur so aus Neugier ;–)

Wir haben den Artikel auch auf Facebook gebracht ( https://www.facebook.com/netzpolitik/posts/10156554462369775 ) und haben nichts Besonderes gemerkt.

Warum wundert es mich nicht, dass ausgerechnet CCC hier der Dienstleister für facebook ist? Habe selbst vor einigen Jahren bei CCC in einem anderen Projekt gearbeitet. Damals gab´s noch keinen Mindestlohn und ein einfacher Mitarbeiter bekam 6,50€/h. Im Projekt haben wir den Kundendienst für eine namhafte deutsche Bank abgewickelt. Interessant ist, dass die Sicherheitsbedingungen (kein Papier, kein Handy, kein… am Arbeitsplatz), Zugang durch 2 Türen mit Fingerprint, absolute Verschwiegenheit etc. sowie die Hierarchien, die Einarbeitung (2 Wochen Kurs, Shadowing, Arbeitseinstieg) und auch die Anforderungen (maximale Kundenzahl pro Arbeitstag, Ziel waren 30 sek pro „Kundengespräch“) die gleichen waren, wir hier im Artikel beschrieben. Und auch der Druck und die damit einhergehende Fluktuation bei den Angestellten kommt mir sehr bekannt vor. Scheint ein Markenzeichen von CCC zu sein. Zu facebook passt dieser Umgang mit Menschen auch.

„Le Monde“ hat genauso „exklusive“ Einblicke erhalten…

https://www.lemonde.fr/pixels/article/2019/04/08/meurtres-pornographie-racisme-dans-la-peau-d-un-moderateur-de-facebook_5447563_4408996.html

Außerdem kann im Falle einer Nichteinhaltung der Geheimhaltungspflicht der Vertrag mit Facebook gekündigt werden, und der derjenige der dies verursacht, der muss für den ganzen Schaden (vorzeitiger Abbruch mit Facebook) aufkommen.

Das heißt die Person , die an Medien oder sonstigen Instutionen des öffentliches Rechts Geheimnisse aussagt, diese rieskiere nicht nur ihren Arbeitsplatz sondern den von allen Mitarbeitern des Löschzentrums (2000).

War is Peace

Freedom is Slavery

Ignorance is Strength

— George Orwell, 1984