Kaum eine Technologie wird von derart grandiosen Versprechen umwabert wie Künstliche Intelligenz, kurz KI. Von Algorithmen gesteuerte Autos sollen uns in Zukunft nach Hause chauffieren, intelligente Maschinen unsere Krankheiten diagnostizieren, ja sogar den Sportteil der Lokalzeitung sollen „Roboterjournalisten“ für uns schreiben. Während wir auf den triumphalen Einzug dieser Zukunft warten, verkauft uns Oral-B angeblich „KI-gesteuerte“ elektrische Zahnbürsten und unser Telefonanbieter lässt uns bei Verbindungsproblemen statt mit einer geschulten Mitarbeiterin erstmal mit einen Chatbot plaudern.

Während die Technologiebranche Hoffnung aufkeimen lässt, dass sich selbst das Jahrhundertproblem Klimawandel mit schlauen Algorithmen in den Griff bekommen lässt, bleiben davon vorerst mutige Hypothesen und steigender Energieverbrauch. Statt große Fragen unserer Zeit in Angriff zu nehmen, geht es bei KI-Anwendungen häufig in Wirklichkeit darum, eine mühselige Arbeit mehr schlecht als recht einem Computer überzuhelfen. Die Vision einer Künstlichen Allgemeinen Intelligenz, die dem Menschen gleich agieren kann, ist nach Ansicht des Informatikers Arvind Narayanan von der Universität Princeton in etwa so plausibel, „wie mit dem Bau einer immer höheren Leiter den Mond zu erreichen“.

Mit der erstaunlich langwierigen Ankunft der verheißenen KI-Zukunft beschäftigt sich der Sammelband „Fake AI“, den die KI-Forscherin Frederike Kaltheuner bei Meatspace Press herausgegeben hat. In seinen Beiträgen nehmen Forscher:innen, Aktivist:innen und Entwickler:innen falsche Versprechen und „KI-Schlangenöl“ auseinander, also betrügerische Wundermittel, die angeblich auf „Künstlicher Intelligenz“ beruhen. Jüngste Ereignisse verleihen mancher Kritik aus dem zu Jahresende 2021 erschienene Band dabei zusätzliches Gewicht: So zählt zu den Autor:innen auch Alex Hanna, die erst vor einigen Tagen ihren Arbeitsplatz als KI-Ethikforscherin bei Google unter lautstarken Protesten verlassen hat.

Von faulen Prognosen und „Bestrafungslogik“

Gescheiterte Versuche, mit sogenannter Künstlicher Intelligenz soziales Verhalten von Menschen vorherzusagen, ziehen sich als roter Faden durch die Beiträge von Hanna und anderen Expert:innen. Oft erstaunt die Naivität, mit der bislang versucht wurde, durch Analyse großer Datenberge vorherzusagen, was nach früherer Erfahrung viel Kontextwissen voraussetzt. Etwa riefen 2017 Forscher:innen der Universität Princeton die „Fragile Families Challenge“ aus, in der aus Studiendaten die Zukunftschancen benachteiligter Kinder vorhergesagt werden sollten.

Doch trotz solider Datenbasis und der damals neuesten Technologie für maschinelles Lernen schaffte keiner der hunderten Teilnehmer:innen Prognosen, die signifikant genauer zutrafen als Zufallsergebnisse, ätzt der Informatiker Narayanan in einem Interview mit Herausgeberin Kaltheuner. An dem Beispiel lasse ich gut ablesen, dass die Vorhersage sozialer Wirkungen sich fundamental von jenen Aufgaben unterscheidet, die KI gut lösen könne.

So manche Anwendung von Künstlicher Intelligenz liege eine „Bestrafungslogik“ zugrunde, schreibt die Kognitionsforscherin Abeba Birhane in ihren Beitrag. Sie spricht von „Cheap AI“, also billiger KI. Damit sind Fälle gemeint, in denen Software „unpassenderweise für Probleme eingesetzt wird, die sie gar nicht lösen kann“. Solche Pseudo-Lösungen sind immer wieder dort zu finden, wo Behörden unliebsame Aufgaben Algorithmen überlassen.

Opfer dieser halbgaren Ansätze sind häufig sozial Schwache und Angehörige ethnischer Minderheiten, die etwa wegen ihrer Hautfarbe durch Gesichtserkennungssoftware häufiger falsch identifiziert werden als andere. Etwa Robert Williams, ein Bewohner der US-Stadt Detroit, der wegen eines Softwarefehlers fälschlicherweise verhaftet wurde.

Die Einteilung von Menschen in Kategorien von Geschlecht, ethnische Zugehörigkeit und sexueller Orientierung sei die „profitabelste und häufigste Anwendung von KI“, schreibt Kaltheuner in ihrem Beitrag. Die KI-Forscherin beschäftigte sich bei der NGO Privacy International mit Datenbrokern, die durch Online-Tracking persönliche Daten sammeln und für Werbezwecke Profile aufbauen.

Sie habe erwartet, sich durch die Sammlung ihrer persönlichen Daten durch Werbebroker in ihrer Privatsphäre verletzt zu fühlen – aber nicht so missverstanden, schreibt Kaltheuner. Das liege daran, dass selbst die ausgereifteste KI auf der falschen Idee aufgebaut sei, die oft komplexen und widersprüchlichen Identitäten von Menschen in einfache Klassifikationen pressen zu können. Das Ergebnisse ließen in ihrem Fall zwar oft schaurig präzise die erhobenen Daten durchscheinen, die daraus abgeleiteten Darstellungen („Bagel-Shop-Besucherin“) blieben aber unvollständig und oberflächlich.

Von Moderation und verpassten Nuancen

An der Komplexität menschlicher Ausdrucksformen scheitern nicht zuletzt jene KI-Systeme, die menschliche Sprache analysieren und regulieren sollen. Technologiekonzerne nutzen automatisierte Inhaltemoderation bereits im großen Stil, um Kosten durch (ohnehin prekarisierte) menschliche Moderation einzusparen.

Facebook-Chef Mark Zuckerberg hatte schon 2018 vor dem US-Kongress angekündigt, die meisten seiner zehntausenden Moderator:innen „in fünf bis zehn Jahren“ durch KI ersetzen zu wollen. Bis dahin werde die Software auch „linguistischen Nuancen von verschiedenen Arten von Inhalten“ gerecht, etwa angeblich terroristischen Inhalten.

Andrew Strait arbeitete früher bei Google an KI-Systemen, die der Konzern zur Erkennung von Urheberrechtsverletzungen, Kindesmissbrauchsinhalten und Hassnachrichten einsetzt. Er hält wenig von den vollmundigen Versprechen automatisierter Moderation. Automatisierte Werkzeuge zur Inhaltemoderation seien „ein weiteres Beispiel verfehlter Hoffnungen“, dass Künstliche Intelligenz komplexe menschliche Probleme lösen könne, schreibt er in seinem Beitrag.

Mehr noch, automatisierte Werkzeuge verschlimmerten die bereits heiklen Abwägungsfragen, die bei der Moderation von Inhalten getroffen werden müssten, betont Strait. Automatisierte Entscheidungen seien „schwierig zu prüfen, zu gewichten, und zu verstehen, sogar für die Entwickler:innen [einer Anwendung], geschweige denn für Regulierungsbehörden oder Forscher:innen von außen, die um Zugang ringen müssen.“

KI als sexy Art, „Statistik“ auszusprechen

Der Sammelband bietet unterschiedliche Blickwinkel auf kaputte und betrügerische Anwendungen, die unter dem vagen Sammelbegriff der „Künstlichen Intelligenz“ vermarktet werden. Wie wenig genau der Begriff ist, wie viel Spielraum er für absichtliche Fehlinterpretation lässt, machen die Forscher:innen Fieke Jansen und Corinne Cath in ihrem Beitrag deutlich. Letztlich liege die Überschneidung aller Anwendungen, die so benannt würden, in der Nutzung mathematischer Methoden, um Muster in Datensätzen zu finden – KI ist in der Sichtweise also praktisch eine sexy Art, das Wort „Statistik“ auszusprechen.

In den vielen Beschreibungen, wie das Versprechen Künstlicher Intelligenz missbraucht wird, betrachtet das vorliegende Werk die echten Versprechen der Technologie nur in Ansätzen. Beiträge aus dem globalen Süden behandeln etwa die fragwürdigen Behauptungen indischer Behörden, mit selbstgestrickter Innovation lokale Probleme ohne Hilfe von außen zu lösen. Dieses als „Jugaad“ bekannt Konzept paare sich mit aus dem Silicon Valley importierten „Techno-Solutionism“, der Idee, Probleme aller Art durch technischen Fortschritt lösen zu können.

Nur am Rande erwähnen Tulsi Parida und Aparna Ashok in ihrem Beitrag die durchaus plausiblen Möglichkeiten, etwa durch KI in der medizinischen Diagnostik längerfristig die Gesundheitsvorsoge in ländlichen Teilen Indiens zu verbessern. Manche mögen einwenden, dass berechtige Kritik an übertriebenen Marketingversprechen zuweilen den Blick darauf verstellt, dass Künstliche Intelligenz in einigen Anwendungsfällen tatsächlich große Verbesserungen von Lebensumständen bedeuten kann. Auch lässt der Sammelband weitgehend offen, wie denn gesellschaftliche, politische, ja journalistische Antworten auf den KI-Hype und die vielen falschen Versprechen aussehen können.

Dem lässt sich entgegenhalten, dass um das tatsächliche Potential der Technologie heben zu können, erst mit faulen Behauptungen und Denkfehlern aller Art aufgeräumt werden muss. Diese Art der Auseinandersetzung ist es, die den Boden für Gegenstrategien zur Quacksalberei mit der Künstlichen Intelligenz bereitet. Dafür leistet der vorliegende Sammelband, der mit liebevoll-futuristischem Layout glänzt, einen hervorragenden Beitrag.

Servicehinweis: „Fake AI“, herausgegeben von Frederike Kaltheuner, ist am 14.12.2021 bei Meatspace Press erschienen. Es steht unter der Lizenz Creative Commons BY-NC-SA frei zum Download zur Verfügung.

Hey,

Im zweiten Absatz des unter Kapitels „Von Moderation und verpassten Nuancen“ fehlt glaube ich ein „dahin“ im Zitat.

Schönes Wochenende

Danke, ist korrigiert!

Wie bei allen neuen und so fundamentalen Dingen, geraten vorallem die Ebenen des Diskurses schnell durcheinander.

Aus wissenschaftlicher Sicht ist KI eher so, meh. Im Allgemeinen nicht formal beschreibbar (als Gesamtsystem). Alle leistungsfähigen Implementationen basieren auf bekannt schlecht analysierbaren Algorithmen (weil selbstreferenziell und mathematisch nicht-linear). Dadurch nicht ernsthaft vorhersagbar. Konsequenz:

– kleinste Veränderungen des Neuronalen Netzes brauchen ein komplettes Re-Training

– keine Vorhersage, was passiert, wenn sich die Eingaben radikal ändern / unsinnig sind

Aus praktischer Sicht haben KI Lösungen überraschendes Potential und „lösen“ viele Fälle bekannt schwerer Probleme scheinbar spielend leicht, holen sie zumindest jedoch auf praktikable Größen herunter. (z.B. Objekterkennung / -verfolgung in Bildern, Restauration von Video- und Audiomaterial)

Die Probleme werden halt aber auch nur „gelöst“ und nicht gelöst. Und so fährt der Tesla unter den weißen Sattelschlepper… und keiner weiß, warum.

Wenn aber einmal richtig Geld im Spiel ist, dann ist Wissenschaft egal.

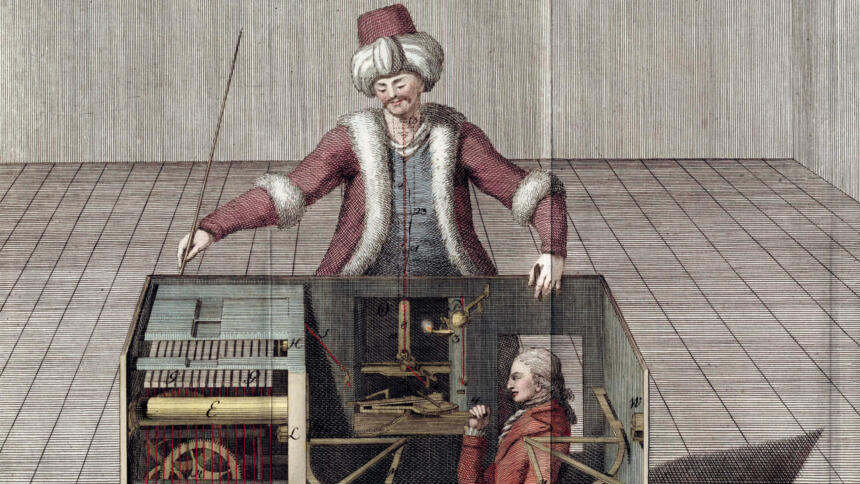

Vielen Dank für diesen Artikel und für das großartige „KI-Symbolbild“.

Während es sich damals noch um „ehrliche Mechanik“ handelte, leisten Zufallsgeneratoren heute unschätzbare Dienste.

Seit Anbeginn der Softwareentwicklung gilt: Fake it until you make it!

In der BU heißt es: „In Wahrheit steuerte ihn ein Menschen …“

Das en muss weg.

Danke, ist korrigiert!