Mit Ablauf der verlängerten Testphase zur Gesichtserkennung startet am Berliner Bahnhof Südkreuz ein weiteres Pilotprojekt zur Überwachung. Zusammen mit dem Bundesministerium des Innern, für Bau und Heimat, dem Bundeskriminalamt und der Bundespolizei testet die Deutsche Bahn den Einsatz von Technik zur Erkennung und Intervention bei auffälligem Verhalten. Hierfür werden „Gefahrensituationen“ definiert, die dann mithilfe „intelligenter Videoanalysesysteme“ automatisiert aufgespürt werden sollen.

Auf eine schriftliche Nachfrage des Bundestagsabgeordneten Alexander Ulrich macht das Ministerium jetzt Angaben zu sechs Szenarien, die von der Technik erkannt werden sollen. Dabei handelt es sich sämtlich um Funktionen in Echtzeit. Als siebte Funktion soll die Überwachung von Personen und Menschenansammlungen auch nachträglich möglich sein. Hierfür wird archiviertes Videomaterial genutzt, indem etwa Personen anhand ihrer Gesichter, Kleidung oder mitgeführten Sachen markiert und in den Videodaten gesucht werden.

Die Szenarien im Einzelnen:

Das Innenministerium listet in seiner Antwort folgende Szenarien auf:

- „Abgestellte Gegenstände“: Durch die Systeme sollen Gegenstände erkannt werden, die im Bahnhof für einen bestimmten Zeitraum allein stehengelassen wurden. Dabei geht es sowohl um verdächtige Gegenstände als auch um nur vergessene Taschen oder Koffer. Die Videobilder der Gegenstände sollen dann den Beobachtern automatisiert angezeigt werden.

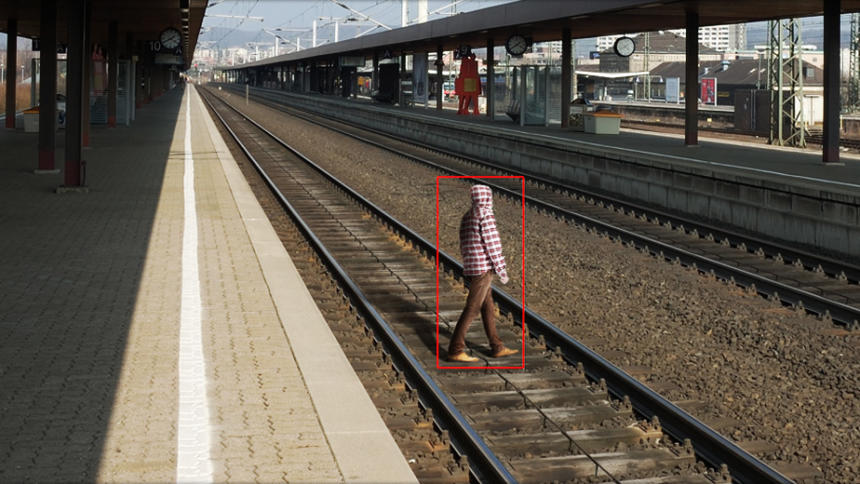

- „Betreten festgelegter Bereiche“: Bestimmte Bahnhofsbereiche, etwa Gleise oder der Eingang zu einem Tunnel, werden vordefiniert. Betritt ein Mensch diesen Gefahrenbereich, soll dies automatisiert erkannt und durch die Systeme gemeldet werden.

- Liegende (hilfsbedürftige) Person: Liegt ein Mensch auf dem Bahnsteig oder einer Treppe, soll dies ebenfalls automatisiert erkannt und durch die Systeme gemeldet und die Videobilder dem Beobachter aufgeschaltet werden. Damit sollen Gefahrensituationen schnell erkannt werden, bei denen eine Person z.B. gestürzt oder zusammengebrochen ist.

- „Personenströme/Ansammlungen“: Läuft eine größere Menschenmasse schnell auseinander oder strömen Menschen schnell zu einer bestimmten Stelle, kann das Anzeichen für eine Gefahrensituation sein. Die Systeme sollen dies erkennen und die Videobilder den Beobachtern automatisiert anzeigen.

- „Nachvollziehen der Position von einzelnen Personen/Gegenständen in Bahnhöfen“: Die Systeme sollen nach Markierung einer bestimmten Person oder eines bestimmten Gegenstandes nachvollziehen können, ob und wo sich diese Person/dieser Gegenstand im Bahnhof befindet bzw. befand. Dies soll dabei helfen, z. B. einen abgestellten Gegenstand einer Person zuordnen zu können und zu erkennen, ob diese Person sich noch und gegebenenfalls wo im Bahnhof aufhält.

- „Personenzählung (insb. Bahnsteigüberfüllung)“: Die ungefähre Anzahl der sich im Bahnhof und insbesondere auch auf einem Bahnsteig befindlichen Personen soll durch die Systeme erkannt werden. So soll z. B. die Gefahr einer Bahnsteigüberfüllung schnell und automatisiert erkannt werden, so dass diesbezügliche Maßnahmen frühzeitig eingeleitet werden können.

- „Retrograde Auswertung von Videodaten“: Es sollen die gleichen, unter 1. bis 6. genannten Funktionalitäten der Liveanalyse anhand der am Bahnhof aufgezeichneten Videodaten retrograd erkannt und ausgewertet werden.

Auswahl aufgrund vorangegangenen Erprobungen an Flughäfen

Seit Beginn des Projekts hatte das Innenministerium nur zögerlich Angaben zu den beteiligten Firmen gemacht. Für die Beschaffung ist grundsätzlich die Deutsche Bahn AG zuständig, die das Projekt als Hausherrin offiziell verantwortet. Eine Ausschreibung erfolgt nicht. Stattdessen werden in einer Marktabfrage verschiedene Hersteller zu den Funktionalitäten ihrer Soft- und Hardware befragt, anschließend wird der Auftrag „freihändig“ vergeben. Aus diesem Grund wurden die Produkte der ersten Projektphase angeblich erst kurz vor Beginn ausgewählt. Getestet wurden demnach ein Gesichtserkennungssystem der Firma Idemia (früher Morpho), außerdem die Software Bio Surveillance Next von Herta Security und EXAV-FRS 2.0 von AnyVision.

Mit der Auswahl der drei Systeme zur Gesichtserkennung sei nach Angaben des Bundesinnenministeriums „ein repräsentativer Ausschnitt der am Markt befindlichen besonders leistungsfähigen Algorithmen“ getroffen worden. Die Entscheidung erfolgte aufgrund internationaler Studien oder vorangegangenen Erprobungen an Flughäfen. Entscheidend sei zudem gewesen, dass die Produkte nicht nur auf die zusätzlich am Südkreuz montierten Kameras zugreifen, sondern auch die Videobilder der bereits bestehenden Anlagen der Deutschen Bahn AG nutzen können. Dies dürfte auch für die zweite Projektphase maßgeblich sein.

Systeme zur Erkennung von abweichendem Verhalten

In der jüngsten Antwort auf die schriftliche Frage nennt das Ministerium erstmals die infrage kommenden Hersteller und Produkte für die Fortsetzung des Pilotprojekts. Aufgelistet werden jene Firmen, bei denen die Deutsche Bahn AG für die Bundespolizei und das BKA eine Marktanfrage gestellt haben:

- Briefcam Insight and Protect (Briefcam)

- GREENAGES Citywide Surveillance (Fujitsu)

- Hitachi Video Analytics (HVA) (Hitachi)

- IBM Intelligent Video Analytics (IVA) (IBM)

- IDOL (MicroFocus)

- IPS Public Transport Protection (Securiton)

- Situational Awareness Builder (Get2Know)

Alle Produkte können abweichendes Verhalten erkennen, in den Funktionalitäten existieren jedoch einige Unterschiede. Während die Software der deutschen Firma IPS lediglich die Bewegung von Personen überwacht, können die anderen Anwendungen auch Gesichter und bestimmte Gegenstände erkennen und verfolgen, Personen zählen, andere Sensoren wie die Nummernschilderkennung einbinden oder Trends ermitteln. Einige Hersteller werben außerdem damit, dass ihre Technik auf künstlicher Intelligenz basiert.

Womöglich kein „Nichterkennungsbereich“ in der zweiten Projektphase

Die Marktanfrage der Deutschen Bahn AG für eine „Software zur Videoanalyse“ endete am 18. Mai. Welche Software schließlich für die Tests ausgewählt wird, ist noch nicht bekannt. Die Firmen sind dann für die Lieferung, Einrichtung sowie die regelmäßige Wartung der Systeme zuständig. Eine weitere Kleine Anfrage soll jetzt die Kosten für die Technik in Erfahrung bringen.

Für den ersten Projektabschnitt hatten die Beteiligten die überwachten Bahnhofsbereiche kenntlich gemacht. Wollten die Reisenden nicht von den eigens aufgehängten Kameras aufgenommen werden, konnten sie andere Zugänge oder Rolltreppen („Nichterkennungsbereich“) nutzen. Weder die Deutsche Bahn AG noch das Bundesinnenministerium haben bislang erklärt, wie dies im zweiten Projektabschnitt gehandhabt werden soll. Wenn auch auf die anderen Kameraanlagen im Bahnhof zugegriffen wird, ist es vermutlich unmöglich, sich der Überwachung zu entziehen.

In Zukunft werden Reisende eingehender überprüft http://m.spiegel.de/netzwelt/netzpolitik/einreisekontrolle-in-israel-grenzbeamte-duerfen-e-mails-lesen-a-896411.html und klar auch die gestellten Fragen zunehmend persönlicher https://www.tagesspiegel.de/weltspiegel/sonntag/urlaub-in-israel-innere-unsicherheit/19313700-all.html

Alles zum Wohle der Inneren Sicherheit?

Nun, diese oben genannten Schritte werden nötig, sobald die Software keine nennenswerte Terrorprävention, sprich Terroristen liefert!

Entweder weil es sie nicht erkennt, siehe Amazon https://netzpolitik.org/2018/gesichtserkennung-von-amazon-verwechselte-us-abgeordnete-mit-verdaechtigen/ oder keine Terroristen da sind oder sie sich wie „normale Menschen“ bewegen oder sie als V-Männer/Frauen überhaupt von jeglicher Überwachung ausgeschlossen sind und somit unbehelligt im Rahmen ihres Tätigkeitsbereiches, den Bahnhof in Gänze in die Luft jagen dürfen!

Klar ist auch im letzteren Fall, das wiederum die Schreie um Ausnahmezustände, neue Gesetze und dem Bundeswehreinsatz im Inneren sehr Laut werden!

Aber hey, mit Angst und Terror kann man die Bürger zum Inneren Frieden zwingen, weil haben wollen diese Bürger den „Toootaaaaalllen Frieden“ nicht, oder doch??

1984 lässt grüßen. Wer sich nicht massenkonform verhält, gilt als gefährlich. Und da soll man nicht paranoid werde? Paranoid dem Staat gegenüber. Das traurige daran ist, in den meisten anderen Ländern der sogenannten Freien Welt geht es schon viel drastischer zur Sache. Frankreich hat den Ausnahmezustand per Gesetz einfach zum Normalzustand erklärt. Und niemand hat sich in der EU groß darüber aufgeregt. England ist vermutlich sogar weltweit das Land mit den meisten Überwachungskameras im öffentlichen Raum. Um nur zwei Beispiele zu nennen. Von den USA, den angeblichen Verteidigern von Freiheit und Demokratie ganz zu schweigen. So gesehen leben wir fast noch auf einer Insel der Seligen.

Frei nach Max Liebermann: Ich könnte nicht so viel fressen, als ich kotzen wollte.

Voll geil! Lass‘ mal da regelmaessig Flashmobs starten! XD

Flashmobs sind keine Lösung.

Das hilft aktuell nur den Initiatoren dieses Überwachungswahns, es liefert ihnen die Daten, die diese Leute gern hätten!

Aktuell ist es ja so, diese Leute haben als Probanden nur friedliche Passanten, was ihnen fehlt sind Menschen, die von diesem Profil abweichen!

Flashmob?

Das würde diesen Leuten nur die Mittel an die Handgeben, die sie wiederum gegen „uns“ anwenden würden.

Proteste hingegen kann man machen, nur sollten diese Koordiniert ablaufen, ferner sollten die Teilnehmer gebrieft werden, um der Software so wenig wie möglich „Futter“ zu geben!

Je Normaler die Verhaltensabläufe während der Proteste sind, desto weniger kann die Software differenzieren!

Als Beispiel möchte ich hier mal die Szene aus dem Film „John Wick 2“ anführen, als auf dem Platz plötzlich alle in der Bewegung verharrten!

Das auf diesem Bahnhof, so in etwa für ein zwei Sekunden, um dann weiter zu gehen, so als ob nichts passiert wäre!

Das wäre ein Idealer Protest auf einem solchen Bahnhof!

Zu Punkt 7) „Retrograde Auswertung von Videodaten“: Es sollen die gleichen, unter 1. bis 6. genannten Funktionalitäten der Liveanalyse anhand der am Bahnhof aufgezeichneten Videodaten retrograd erkannt und ausgewertet werden.

Das heißt dann wohl beliebig viele „false Positives“, so häufig die diversen Softwares halt das Video-Material durchsuchen dürfen.

Die spannende Frage ist doch, ob man nicht rechtlich dagegen vorgehen kann, sollte es wirklich in der zweiten Testphase keinen Nichterkennungsbereich mehr geben. Kennt sich da jmd aus?

Nun, du darfst natürlich Klagen!

Spätestens, wenn du diesen Artikel https://www.vdgn.de/vdgn-journal/2018/vdgn-journal-7-2018/beitrag/rechtsstaat-nur-schall-und-rauch/ durchgelesen hast, wirst du feststellen, wie unser Rrrrechts-System funktioniert!

Recht haben und auch bekommen/durchsetzen, sind in Deutschland anscheinend zwei Paar Schuhe und nicht einmal der Staat hält sich an selbst erstellten Gesetze und Ordnung!

Und wann wird die automatische „Selbst“-Schuss-Anlage montiert?

Das Wort „Selbst“ ist dabei deshalb so wichtig, weil hinterher natürlich jeder selbst daran Schuld ist, wenn er erschossen wird. Schließlich wird niemand dazu gezwungen abweichendes Verhalten zu zeigen.

Interessant wird es dann, sobald auf die detektierten Verhaltensanomalien auch ein automatisierter „Geschäftsprozess“ folgt ohne einen – sagen wir – parasitären Menschlichkeitsparameter.

Roboter raus

Rechte vorlesen

In Schutzhaft nehmen

(Natürlich alles ganz sicher, transparent und demokratisch archiviert in einer Blockchain)

Klingt doch gut – denn das bedeutet ja nichts anderes als, daß sich Verfassungsschutz, BND und Polizei als erste durch was effektives wie Roboter und Computer austauschen lassen.

Das sollte nur mal ordentlich forciert werden. ;)

Man man man… ich denke ich muss mir mal wieder einen SciFi-Film ansehen und Vergleiche ziehen. Ich denke da an Minority Report von Steven Spielberg.

PS: Da fällt mir grad noch ein, wie wird sowas mit der DSGVO geregelt? Sind Videoaufnahmen persönliche Daten und wenn ja, wie holen die meine Zustimmung ein?

Also wenn ich mir die Kurzbeschreibung des Autors angucke mag er scheinbar keine abweichenden Meinungen.

Aber Hauptsache man ist online bei der guten Sache mit dabei ;)

Die Behörden sind voll mit Menschen wie uns. Alle sozialisiert in der Ablehnung von Überwachung, das sollte man sich mal bewußt machen. Ein Polizist hat nicht den Anspruch Polizist zu werden, weil er „überwachen“ möchte. Das ist bullshit.

Ich bin dankbar dafür, dass sich die Behörden in Deutschland mit Augenmaß auf die neuen Bedrohungen (hier scheinen manche ja die Deutsche Bahn als Bedrohung zu sehen) durch Terror vorbereiten. Am Ende lieber in der Kamera gewesen als tot.

Weil bitte ehrlich sein und die ganze Konsequenz einer totalen Datenschutzpolitik benennen: es gibt halt mehr Tote je weniger man überwacht, ganz einfach. Manche kommen damit klar, ich nicht :-)

„Am Ende lieber in der Kamera gewesen als tot.“

Achso, die Kamera greift dann ein, wenn du Opfer einer Gewalttat wirst?

So mit künstliche Intelligenz und so?

Kannst du mir Fallzahlen nennen, wo Terrorangriffe durch Videoüberwachung im öffentlichen Raum verhindert wurde?

Zum Thema Augenmaß: Wie groß ist das Risiko, in Deutschland Opfer eines Terroranschlags zu werden? Hälst du es für Verhältnismäßig auf Grund der aktuellen Gefährdungslage den öffentlichen Raum flächendeckend zu überwachen?

Warum dann nicht Kameras in Privatwohnungen? Statistisch gesehen ist das Risiko dort Opfer von Gewalt zu werden deutlich höher, als auf der Straße.

„Weil bitte ehrlich sein und die ganze Konsequenz einer totalen Datenschutzpolitik benennen: es gibt halt mehr Tote je weniger man überwacht, ganz einfach. Manche kommen damit klar, ich nicht :-)“

Ich habe gehört in China ist es sehr sicher ;-)

Etwas spät zum Fest, trotzdem würde ich gern etwas differenzieren und fragen. Also, erstmal sind nachvollziehbare Funktionen dabei, die im Grunde selbsterklärend sind. Bei liegenden Personen den Wachmann alarmieren ist erstmal gut. Unbewachte Gegenstände aufsspüren, naja, so viele Kofferbomben gab es bisher nicht, ob wir das echt brauchen…und Gefahrenbereiche überwachen, ginge auch mit Lichtschranken, oder? Aber gut lassen wir mal durchgehen.

Bei Nummer 5, erkennen von Individuen und bestimmten Einzelgegenständen, würde ich Einspruch einlegen weil das Missbrauchspotenzial zu groß ist. Da müsste midestens eine Schranke, wie richterlicher Beschluss oder Ähnliches sein. Dann natürlich nur noch nachträglich möglich.

Lässt sich das so machen, dass die anderen Funktionen funktionieren und Anonymität garantieren? Zum Beispiel durch eine Begrenzung der Zahl Charakteristika in der Gegenstands-/Personenerkennung in der Software? Brauchen wir ein Gesetz das die Sammlung solcher Daten durch Software regelt? Macht es Sinn eine Petition zu machen?

@Jan:

Did I understand you right, that the image recognition software should use their full potential by law, which implies that it can track back any person even the innocent?`That is from a technical perspective a bit complicated, because usually artificial intelligence is only able to detect malicious behavior but not a normal one for example waiting for a train, buying a ticket or stand still and doing nothing.

Ein schleichender Prozess, der da droht. Beobachtete ändern ihr Verhalten (Hawthorne-Effekt). Ständig dem Druck ausgesetzt zu sein, sich systemkonform (weil sonst auffällig) verhalten zu müssen, wird uns verändern. Ist das ein freies Land?