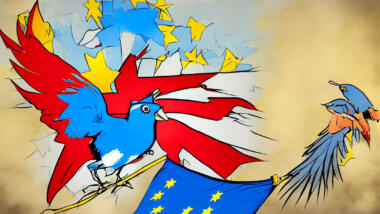

Die Studie macht weltweit Schlagzeilen: Twitter, das eine zentrale Plattform für die politische Debatte ist, verstärkt rechte Politiker:innen in einigen Ländern mehr als linke. In Deutschland ist das zwar nicht der Fall, aber laut der 2021 erschienenen Studie hat Twitter in Ländern wie den USA, Frankreich und Spanien bei der Frage, wessen Tweets der Algorithmus von Twitter User:innen öfter zeigt, eine klare rechte Schlagseite.

Datenbasis dafür ist ein Experiment mit mehreren Millionen Twitter-Nutzer:innen, die unterschiedliche Feeds zu Gesicht bekamen. Möglich ist eine solche aufwändige Untersuchung wohl nur deshalb, weil mehrere der Ko-Autor:innen zum Erhebungszeitpunkt bei Twitter arbeiteten. Denn die Technologiekonzerne geben unabhängigen Forscher:innen höchstens widerwillig Datenzugang. Freiwillige Initiativen der Plattformen seien oft sehr eng gefasst und die Zugangsbedingungen unvorhersehbar, klagt die EU-Kommission und die US-Regierung.

Im Gegenteil, die Plattformriesen behindern Wissenschaftler:innen, die Themen wie politische Polarisierung, Desinformation oder Hassrede auf ihren Plattformen beleuchten. Facebook hat sein Analysetool Crowdtangle immer weiter beschränkt, Twitter unter Konzernchef Elon Musk den Datenzugang über Schnittstellen sehr teuer gemacht. Deshalb wäre ein großangelegte Untersuchung, laut der rechte Stimmen im deutschsprachigen Twitter seit 2021 immer lauter werden, künftig nicht mehr möglich, klagen die Autor:innen Luca Hamma und Martina Schories. Und während Google Faktenprüfungen mit Millionenbeträgen unterstützt, kritisieren Faktchecker:innen fehlende Transparenz im Umgang der Konzerntochter YouTube mit Desinformation.

„Wie wenn Ölkonzerne Zugang zu Messwerten kontrollieren“

Daran etwas ändern soll der Digital Services Act der EU. Durch die neue Verordnung müssen 19 große Internet-Plattformen deutlich strengeren Regeln gehorchen als kleinere Internetdienste. Ein Kernpunkt ist die Verpflichtung für die Großen, gegen „systemische Risiken“ vorzugehen. Dazu zählt die Verbreitung illegaler Inhalte wie Kindesmissbrauchsdarstellungen. Ebenso als Gefahr zählt die systematische Verletzung von Grundrechten so wie jene auf Privatsphäre und freie Meinungsäußerung. Auch die großangelegte Manipulation von Nutzer:innen ist ein Risiko, gegen das Plattformen vorgehen müssen.

Tun sie es nicht, drohen Strafen in Milliardenhöhe. Das könnte etwa Twitter treffen, wenn die Plattform systematisch seine Pflicht verletzt, gegen zielgerichtete Desinformation vorzugehen. Das hat Twitter unter Führung von Konzernchef Elon Musk zumindest angedeutet, als es seine freiwillige Teilnahme am EU-Verhaltenskodex gegen Desinformation beendete.

Damit systemische Risiken überhaupt entdeckt werden können, räumt das EU-Gesetz Forscher:innen umfassenden Zugang zu den Daten der großen Plattformen ein. Artikel 40 schreibt fest, dass jedes Land Koordinierungsstellen einrichten muss, die Anträge aus der Forschung prüfen müssen. Sie können dann anordnen, dass Plattformen Zugang zu bestimmten Datensätzen gewähren müssen. Unabhängige Forschung soll zielgerichtete Prüfungen („Audits“) im Auftrag der Kommission ergänzen, die regelmäßig das Risikopotential der Plattformen checken.

Allerdings lässt das Gesetz vieles ungeklärt. Im nächsten Jahr will die EU-Kommission delegierte Rechtsakten vorlegen, die festlegen, welche Daten Forscher:innen beantragen können. Sie sollen auch klären, in welcher Form sie geliefert werden müssen.

Wissenschaftler:innen, die Plattformdaten für ihre Forschung brauchen, fordern einen robusten Datenzugang, der den Spielraum der Plattformen bei der Datenauswahl einschränkt. „Sonst wäre das wie Klimaforschung, bei der die Ölkonzerne den Zugang zu den Messewerten kontrolliert“, sagt Philipp Lorenz-Spreen. Der Wissenschaftler am Max-Planck-Institut für Bildungsforschung in Berlin untersucht Mechanismen, die das Verhalten auf Online-Plattformen bestimmen; es geht um Einstellungen zu Vertrauen, Partizipation und Gruppendynamik. Dafür braucht er Daten der Plattformen, an die er bislang nur schwer herankommt.

Forscher:innen wie Lorenz-Spreen wollen politisch heikle Fragen über die Rolle der Internetkonzerne in den großen politische Ereignissen des vergangenen Jahrzehnts klären. Haben Facebooks Algorithmen und WhatsApp den Massenmord an den Rohingya in Myanmar befeuert? Hat Donald Trump die US-Wahl 2016 mit russischer Hilfe auf Social Media gewonnen? Treiben YouTubes Empfehlungsalgorithmen die Leute in die Arme von Impfskepsis und Verschörungsmythen? Diese Fragen ließen sich mit Daten der Plattformen vermutlich beantworten.

Welche Daten sollen fließen?

Plattformen müssen bald nicht nur Zugang zu historischen Daten, sondern auch zu Daten in Echtzeit einräumen, „soweit dies technisch möglich ist“. So will es der Gesetzestext des Digital Services Act.

Vorher muss die EU-Kommission jedoch klären, wie das passieren kann, ohne Geschäftsgeheimnisse der Plattformen oder den Datenschutz zu verletzen. Keinesfalls soll es ein zweites Cambridge Analytica geben. In der Affäre gaben Forscher:innen private Daten von Millionen Menschen an die dubiose Datenfirma weiter, die diese für zielgerichtete Werbung für Donald Trump und die Pro-Brexit-Kampagne nutzte.

Solchen Bedenken zum Trotz sprechen sich Forscher:innen und NGOs für einen breiten Datenzugang aus. Die Plattformen müssten Forschung dort zulassen, wo sie bislang nur durch Methoden wie Scraping möglich ist. Dabei handelt es sich um eine Form der automatisierten Datensammlung, die gegen die Nutzungsbedingungen vieler Plattformen verstößt. Daten, die Forscher:innen heute mühsam auf eigene Faust sammeln, müssten von den Plattformen verfügbar gemacht werden, fordert die Stiftung Neue Verantwortung. Ähnlich äußern sich auch andere Stellungnahmen in einem Konsultationsverfahren der EU-Kommission.

Schutzmaßnahmen sollen einen hohen Datenschutzstandard auch dann sicherstellen, wenn millionenfach persönliche Daten im Spiel sind. In Hochrisikofällen könnten die Plattformen „virtuelle Reinräume“ einrichten, die Forscher:innen unter strengen Auflagen Zugang zu nicht-öffentlichen Daten geben sollen. Diesen Vorschlag erarbeiteten Expert:innen aus Wissenschaft, Zivilgesellschaft und Plattformen im Rahmen des European Digital Media Observatory. Ihr Bericht behandelt im Detail die Frage, wie der Zugang zu Plattformdaten mit den EU-Datenschutzgesetzen vereinbar gemacht werden kann.

Klären muss die EU-Kommission auch, wer Zugang zu der Datenfülle erhält. Das Gesetz spricht davon, dass Forscher:innen „unabhängig von kommerziellen Interessen“ sein sollen. Sie müssen die Finanzierung ihrer Forschung offenlegen und ihren Antrag auf Datenzugang begründen. Darüber entscheiden soll die Koordinierungsstelle in dem EU-Land, in dem die Forschung stattfindet.

Die Schranke für den Zugang dürfe jedoch nicht auf Wissenschaftler:innen beschränkt werden, fordern Stimmen aus der Zivilgesellschaft. Auch fachkundige NGOs und die Presse sollen gemeinsam mit Forscher:innen mit Plattformdaten arbeiten dürfen. Das fordern Organisationen wie AlgorithmWatch und die Mozilla-Stiftung in einem offenen Brief an die Kommission.

Journalist:innen wären dann in der Lage, Echtzeit-Daten für Berichterstattung über laufende Ereignisse zu nutzen, sagt die philippinische Friedensnobelpreisträgerin Maria Ressa. Datenanalyse könne helfen, Gewalt in der realen Welt vorherzusagen und zu verhindern.

Knappe Ressourcen als Schwachpunkt

Über den Zugang zu den Plattformdaten entscheiden sollen die Koordinierungsstellen der EU-Staaten, unter Beteiligung der Kommission. Expert:innen melden allerdings Bedenken an. Nationale Stellen bräuchten ausreichende Ressourcen, um komplexe Forschungsvorhaben beurteilen und den Plattformen Paroli bieten zu können, wenn diese die Herausgabe von Daten verweigern. Zumindest einige EU-Staaten sollten dafür eigene Forschungseinheiten in ihren Koordinierungsstellen aufbauen, argumentiert Julian Jaursch von der Stiftung Neue Verantwortung.

Um für die Überprüfung der großen Plattformen Kompetenzen aufzubauen, hat die EU-Kommission das Europäische Zentrum für Algorithmentransparenz in Sevilla eingerichtet. Es soll mit Wissenschaftler:innen und der Zivilgesellschaft zusammenarbeiten, um Risiken beim massenhaften Einsatz automatisierter Entscheidungssysteme zu entdecken. Aber reicht das?

Die Plattformen selbst äußern sich zu dem Vorhaben, ihre Datenschätze zugänglich zu machen, eher skeptisch. Wegen Datenschutzbedenken dürfe das Scraping von Daten keinesfalls erlaubt oder begünstigt werden, erklärt TikTok in einer Stellungnahme an die EU-Kommission. Google betont, es müsse in der Frage, in welcher Form es Zugang zu seinen Daten ermögliche, „Flexibilität“ haben. Auch brauche der Konzern ausreichend Zeit, um Anträge aus der Forschung zu prüfen.

Wird die Kommission die Datenhoffnung von Forscher:innen erfüllen oder die Regeln doch eher an den von den Plattformen vorgezeichneten Grenzen orientieren? Viel hänge an dieser heiklen Aufgabe, sagt der Forscher Lorenz-Spreen. Scheitere die Kommission daran, dass „Paradigma der Datenhoheit der Plattformen zu durchbrechen“, dann berge dies die Gefahr, über die gesellschaftlichen Auswirkungen ihrer Macht weiterhin im Dunkeln zu bleiben.

0 Ergänzungen

Dieser Artikel ist älter als ein Jahr, daher sind die Ergänzungen geschlossen.