Es ist ein wissenschaftliches Großprojekt: In insgesamt 16 Studien untersuchen Wissenschaftler:innen, welchen Einfluss Algorithmen auf die Verbreitung von Falschinformationen und Polarisierung haben. Zwei der weltweit größten sozialen Netzwerke stehen dabei im Fokus: Facebook und Instagram. Beide Plattformen gehören dem Tech-Konzern Meta an.

Die ersten vier Studien wurden nun in den wissenschaftlichen Zeitschriften Science und Nature veröffentlicht. Die Ergebnisse zeichnen – zumindest für den Zeitraum der zweiten Jahreshälfte 2020 in den Vereinigten Staaten – ein differenziertes Bild davon, wie US-Amerikaner:innen soziale Netzwerke nutzen, und welche Auswirkungen dies auf ihre politischen Überzeugen und den gesellschaftlichen Diskurs hat.

Demnach spielen die beiden Plattformen eine entscheidende Rolle dabei, die Nutzer:innen zu Inhalten zu leiten, denen sie wahrscheinlich zustimmen. Die Studien bezweifeln jedoch, dass Meta die politischen Überzeugungen der Nutzer:innen signifikant beeinflussen kann.

Aus Sicht von Meta bestätigen die Studien damit frühere Aussagen des Unternehmens, wonach es für die Nutzer:innen von Vorteil sei, wenn Algorithmen deren Feeds sortierten. Kritiker:innen entgegnen, dass die Studien vor allem zeigten, dass das Problem mannigfaltiger sei als bislang zumeist angenommen und der Konzern nicht aus der Verantwortung entlassen sei.

Verschärfen Algorithmen die gesellschaftliche Polarisierung?

Die Forschungen starteten offiziell Ende August 2020, also noch vor der US-Präsidentschaftswahl im November des gleichen Jahres. Ein Team aus rund zwei Dutzend Facebook-Forscher:innen und externen Wissenschaftler:innen untersuchte über mehrere Monate konkret, welche Auswirkungen Facebook und Instagram unter anderem auf die politische Beteiligung, die politische Polarisierung und die Verbreitung von Falschwahrnehmungen hat.

An drei der vier Studien nahmen für einen Zeitraum von knapp drei Monaten mehrere zehntausend US-amerikanische Facebook- und Instagram-Nutzer:innen teil. Ihre Identifikationsdaten wurden dabei unkenntlich gemacht. Für die vierte Studie stellte Meta den Forschenden anonymisierte Daten von rund 208 Millionen Facebook-Nutzer:innen zur Verfügung.

In der ersten Studie mit dem Titel „Wie beeinflussen Algorithmen von Social-Media-Feeds die Einstellungen und Verhalten in Wahlkampagnen?“ sahen die teilnehmenden Facebook- und Instagram-Nutzer:innen drei Monate lang einen chronologisch statt algorithmisch sortierten Nachrichten-Feed. Die Beiträge waren also nach ihrer zeitlichen Aktualität sortiert und nicht vorrangig nach den persönlichen Interessen der einzelnen Nutzer:innen.

Die Forschenden fanden heraus, dass die chronologische Anzeige – eine Option, die Facebook erst wieder seit Kurzem seinen Nutzer:innen anbietet – „den Anteil von Inhalten aus als nicht vertrauenswürdig eingestuften Quellen um mehr als zwei Drittel im Vergleich zum algorithmischen Feed erhöhte, während er die Anzeige von unhöflichen Inhalten um fast die Hälfte reduzierte“. Zugleich aber habe die chronologische Anzeige keinen nennenswerten Einfluss auf die „Polarisierung“ oder das politische Wissen der Menschen gehabt.

Algorithmen übten zweifelsohne einen großen Einfluss darauf aus, wie Menschen Inhalte auf den Plattformen wahrnehmen, so Talia Jomini Stroud, eine der Studienleiter:innen und Direktorin des Center for Media Engagement an der University of Texas gegenüber dem britischen Guardian, „wir haben aber auch festgestellt, dass […] eine Änderung der Algorithmen in den sozialen Medien die politischen Einstellungen nicht beeinflusst haben.“

Und noch etwas habe sich gezeigt: Ohne algorithmisch vorsortiertem Feed verringert sich die Zeit, die Nutzer:innen auf Facebook oder Instagram verbringen, deutlich. Zugleich verbrachten sie mehr Zeit auf TikTok, YouTube und anderen Plattformen. Aus Sicht der Forschenden zeige dies, wie wichtig die algorithmischen Sortierung für Meta aus wirtschaftlichen Gründen ist.

Facebook und Instagram sind mächtige Kuratiermaschinen

Die zweite Studie nahm das Nutzungsverhalten von etwa 208 Millionen US-amerikanischen Facebook-Nutzer:innen rund um die US-Präsidentschaftswahl im Jahr 2020 – konkret von September 2020 bis Februar 2021 – in den Blick.

Die Forschenden kommen zu dem Schluss, dass Facebook „ideologisch stark gespalten ist – weit mehr als frühere Forschungen zum Nachrichtenkonsum im Internet auf der Grundlage des Surfverhaltens ergeben haben.“ Die Spaltung werde aber weniger durch die Inhalte geprägt, die Freund:innen posten, sondern erheblich mehr durch Facebook-Seiten und -Gruppen. Aus Sicht der Forschenden veranschaulicht dies, dass Facebook-Seiten und -Gruppen eine „sehr mächtige Kurations- und Verbreitungsmaschine“ seien.

Außerdem stellt die Studie fest, dass weit mehr Konservative Falschinformationen sehen und teilen würden als Liberale. Demnach waren 97 Prozent der als Falschinformation deklarierten Meldungen bei Konservativen beliebter als bei Liberalen. Konservative neigten zudem dazu, vergleichsweise mehr politische Nachrichten zu lesen, die auch von anderen Konservativen gelesen würden, so die Studie.

Wenig Auswirkungen auf die Überzeugungen

Allerdings habe das Verhalten der Nutzer:innen nicht unmittelbar Einfluss auf deren Überzeugungen, so das Ergebnis der dritten Studie. Für diese Studie reduzierten die Forschenden die Menge jener Inhalte, die von „gleichgesinnten“ Verbindungen in die Feeds von mehr als 23.000 Facebook-Nutzer:innen gepostet wurden, um rund ein Drittel.

Dies führte zwar dazu, dass die Nutzer:innen deutlich mehr Inhalte aus Quellen jenseits des eigenen politischen Spektrums sahen. Allerdings interagierten sie weniger mit diesen Inhalten als mit jenen, die ihren eigenen Überzeugungen entsprachen. Vor allem aber hatten die anderen Inhalte keine messbaren Auswirkungen auf die Überzeugungen der Studienteilnehmer:innen, ihre Einschätzung von politischen Kandidat:innen oder die politische Polarisierung im Allgemeinen.

Zu einem ähnlichen Schluss kommt die vierte Studie, die das Verhalten von 27.000 Facebook- und Instagram-Nutzer:innen untersuchte. Hier nahmen die die Forschenden den Teilnehmer:innen die Möglichkeit, Beiträge erneut zu teilen. Diese sogenannten Reshares sorgen maßgeblich dafür, das Inhalte bei Facebook „viral gehen“.

Fehlt die Möglichkeit, hat dies vor allem Auswirkungen darauf, wie sich politische Nachrichten sowie Meldungen aus nicht-vertrauenswürdigen Quellen verbreiten. Infolgedessen nimmt zwar unter anderem das Wissen der Studienteilnehmer:innen über politische Nachrichten ab. Allerdings habe auch dies keine signifikanten Folgen auf die Überzeugungen der Nutzer:innen, so die Studie.

Ergebnisse sind nur eingeschränkt verallgemeinbar

Meta sieht sich durch die bisherigen Forschungsergebnisse bestätigt. Laut Nick Clegg, Leiter von Metas Unternehmenskommunikation, zeigen die Forschungen, „dass es wenig Beweise dafür gibt, dass zentrale Funktionen von Metas Plattformen allein eine schädliche ‚affektive‘ Polarisierung verursachen oder irgendeinen bedeutenden Einfluss auf wichtige politische Einstellungen, Überzeugungen oder Verhaltensweisen haben.“

Indes sagen selbst die Forschenden, die die erste Studie erstellt haben, dass die Ergebnisse der Studien nur mit Einschränkungen verallgemeinbar seien. Demnach sei der Studienzeitraum von drei Monaten zwar länger als der vieler anderer Untersuchungen zur politischen Kommunikation. Allerdings wären die Ergebnisse „möglicherweise anders ausgefallen, wenn diese Studie nicht während eines polarisierten Wahlkampfes […] und in einem spezifischen politischen Kontext (den Vereinigten Staaten) durchgeführt worden wäre.“

Die Whistleblowerin Frances Haugen kritisiert ebenfalls den Zeitpunkt der Untersuchungen. Die ehemalige Facebook-Produktmanagerin, die 2021 Tausende von internen Facebook-Dokumenten an die Börsenaufsichtsbehörde weitergab, weist unter anderem darauf hin, dass Meta bereits in den Monaten vor der damaligen US-Präsidentschaftswahl einige „seiner aggressivsten Wahlschutzmaßnahmen“ eingeführt habe, um gegen extreme Beiträge vorzugehen. Viele der Maßnahmen habe der Konzern nach der Wahl wieder zurückgenommen, so Haugen.

Meta darf sich nicht der Verantwortung entziehen

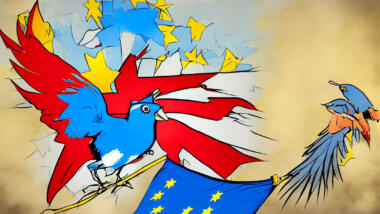

Ohnehin sollte sich Meta nicht allzu kräftig auf die Schulter dafür klopfen, dass es Forschenden seine Daten zur Verfügung stellt. Denn die laut Clegg „beispiellose Forschungspartnerschaft zwischen Meta und externen Akademikern“ wird wohl gezwungenermaßen fortgesetzt: Laut Digital Service Act (DSA), der im November vergangenen Jahres in Kraft trat, müssen Internet-Plattformen künftig deutlich rigider gegen „systemische Risiken“ vorgehen als in der Vergangenheit. Zu diesen Risiken zählen unter anderem die systematische Verletzung der Privatsphäre oder des Rechts auf freie Meinungsäußerung. Damit diese Risiken aber überhaupt entdeckt werden können, räumt das EU-Gesetz Forscher:innen umfassenden Zugang zu den Daten der großen Plattformen ein – ob diese wollen oder nicht.

Bürgerrechtsorganisationen weisen zudem darauf hin, dass die Studienergebnisse Meta und andere Technologieunternehmen keineswegs aus jener Verantwortung entlassen würden, die sie für gesellschaftliche Spaltungen, politische Umwälzungen und der Verbreitung von Verschwörungsmythen trügen. „Die von Meta unterstützten Studien, die sich mit kleinen Stichprobenzeiträumen befassen, sollten nicht als Entschuldigung dafür dienen, dass Lügen verbreitet werden können“, sagt Nora Benavidez, Senior Counsel bei der Bürgerrechtsgruppe Free Press gegenüber der Washington Post. „Social-Media-Plattformen sollten sich im Vorfeld von Wahlen stärker engagieren und nicht neue Pläne aushecken, um sich der Verantwortung zu entziehen“, so die Juristin.

Ähnlich sieht das der Journalismus-Professor Michael W. Wagner, der an der Universität von Wisconsin lehrt und als unabhängiger Beobachter der Forschungskooperation fungiert. Aus seiner Sicht belegen die Studien keineswegs, dass soziale Plattformen wie Facebook „kein Problem sind“. Vielmehr dienten die Studien aus seiner Sicht als „ein guter wissenschaftlicher Beweis dafür, dass es nicht nur ein Problem gibt, das leicht zu lösen ist.“

Studien über die schädliche Wirkung von Algorithmen sind reine Spiegelfechterei. Den wirklichen Schaden verursacht /Targeted Advertising/, also gezielte Werbung auf der Basis der individuellen Dossiers bei den Anbietern der asozialen Plattformen. Die hat wirklich direkten und manipulativen Einfluss auf Wahlentscheidungen. Beispiele Gefällig?

Aus D: Die Falschen Demagogischen Populisten haben es nur durch manipulierende Wahlwerbung in die Position geschafft, in der sie jetzt stehen: Der Schwanz, der mit dem Hund wedelt. Auf Instagram wurden jungen Leuten jeweils die „passenden“ Werbespots gezeigt. Umwelt- oder Klimabewussten stellte sich die Partei als Klimaschützer vor; den anderen als „freie Fahrt für freie Bürger“ oder so. https://targetleaks.de/

Oder bleiben wir in den USA. Da hat gezielte Wahlwerbung auf F.c.book nachweisbar (und nachgewiesen) den Ausgang der Wahl zu Gunsten des orangenen Horrorclowns manipuliert. So wurden Wählern, die als ‚demokratisch‘ orientiert eingestuft wurden, Werbung und „Nachrichten“ gezeigt, die sie von der Teilnahme an der Wahl abhalten, demotivieren sollten. Zusammen mit Gerrymandering hat sich das als äußerst wirksam erwiesen.

Danke netzpolitik.org für den Hinweis.

Nick Clegg, President, Global Affairs – Meta, äh Sir Nick Clegg, so viel Zeit muß schon sein,

hat da ja mal kräftig in Meta´s Porto Kasse gegriffen, um all die universitären HIWI´s zu bezahlen.

Eine schlechte PR ist auch PR! We run ads Stupid.

Mal sehen, wann denn die Lobbyisten aufbrechen und die Studienergebnisse der politischen Community „zur freien Verfügung“ stellen.

Wessen Brot ich ess, dessen Lied ich sing.

Allerdings kann man hier alles falsch machen. Schon der Ansatz des Rüttelns ist gegebenenfalls Quatsch. Es läuft seit Jahrzehnten eher mittels Nudging, also kleinen stetigen Manipulationsbröckchen. Zudem geht es auch um Mobilisierung und Festigung, wo Bestandteile ausnutzbarer Versatzstücke als Potential vorliegen. Wie schon erwähnt wurde, spielt das Targeting für Werbung eine wichtige Rolle, und die Werbung selbst.

Rütteln ist mehr für Influencer und herausragende Stimmen, die man dann vielleicht mit Shitstorms und Verleiten zu ungeschickten Themen und Äußerungen angreifen würde. Das ist Rütteln.

Meinten Sie Rüsseln?

Isolierte Sicht wäre halt wieder wie ein zentraler vorgeschriebener Zertifikatsstore.

Am Besten noch selbst auswählen: [ ] Ich wurde X, wegen … [ ] Ich wurde Y, wegen …

Oder „Ich war vorher X, jetzt bin ich Y“. Wen haben die denn da ausgewählt? Nichtwähler? Gefestigte Wähler (Volksparteisockenaufsteller)?

„dass Meta bereits in den Monaten vor der damaligen US-Präsidentschaftswahl“ – was ist in den Jahren dazwischen passiert?

„wir haben aber auch festgestellt, dass […] eine Änderung der Algorithmen in den sozialen Medien die politischen Einstellungen nicht beeinflusst haben.“ – lasse ich mal zum Lachen stehen.

„anonymisierte Daten von rund 208 Millionen Facebook-Nutzer:innen“ – Meta kann das, Gesetzgeber nicht. Aussagekraft… moment, blätter… 0?

Funktionierendes personalisiertes Zielen ist einfach ziemlich tödlich, per Definition, fast egal was das Ziel ist. Dafür dann Pseudostudien mit „ich bin geflippt ja/nein“ brauchen wir nicht. Na gut, ich habe keine der Studien gelesen, vermute aber, dass das Machbare ohne Geheimndienst zu klein ist, um hier eine sinnvolle Aussage zu treffen.

>>> „wir haben aber auch festgestellt, dass […] eine Änderung der Algorithmen in den sozialen Medien die politischen Einstellungen nicht beeinflusst haben.“ – lasse ich mal zum Lachen stehen.

Das Targeting hilft ja auch die Menschen auf andere Kanäle zu bekommen wo man sie dann bearbeiten kann, oder IRL eingebunden kriegt. Legal oder unter den Radars ist halt immer nett, daher muss der Nutzer zunächst aktiv werden. Daten helfen natürlich auch dabei, wen man ansprechen soll, doch schon das Leiten auf Plattformen und Kanäle, wo die Nutzer selbst Kontakt aufnehmen (können), ist schon eine „nette Sache“. Den Sprung von etwas wie Youtube auf Email versuchen viele, auch seriöse Influencer. Kontakt ist ja dann schon mal eine Stufe weiter auf der Interaktions- bzw. vielleicht ja auch Interessenskala (im Schnitt).

Den Radikalisierungstrieb gibt es sicherlich. Ob die Wirkung dann so riesig ist, und jeder darauf hereinfällt, sei mal dahingestellt. Nicht wenige Influencer legen es darauf an, mit reißerischen Überschriften, Inszielnehmen der politischen Gegner, und dann doch oft recht dünnem Inhalt. Die Bestärkung bestimmter Sichtweisen erlaubt es eben den Bauernfängern (nicht unbedingt dieselben), ihre Arbeit dann noch effizienter zu machen. Denn: wäre Werbung vollkommen unwirksam, warum wird dann so viel Geld ausgegeben? Selbes Prinzip…

Im Targeting gibt es sicherlich auch Reaktionsdaten, also wie jemand auf welche Sorte Inhalt reagiert, bzw. auf Kamapagnen. Kurz und Lang mögen Unterschiede machen, dennoch.

Am Besten wir verharmlosen alles, kippen etwas Verwirrung drüber, und rollen es dann in der mit KI rückgekoppelten Variante frontal flächig aus.

Ein bischen Sci-Fi muss sein…

Für Sci-Fi-Fans: selbst wenn die Effekte „nur“ ein bischen so statistisch sind, hast du bei Millionen von Menschen natürlich schon gewisse Zahlen erreicht. Ein bischen weitergedacht, ohne wirksame „Leitplanken“, bestimmen solche Tech-Konzerne über Lebenszeit, und mit dem Argument, es sei statistisch doch so viel besser, haben wir ein nicht ganz auf Freiwilligkeit basierendes Euthanasieregime erreicht. Hauptsache man muss nicht mehr auf Basis von Prinzipien entscheiden, kann stattdessen juristische Nichtanfechtbarkeit im Spiegel kontemporären Ermessensspielraums bei der Umsetzung von „Regierung im Dienste des totalen Rechtsstaates / you voted for me, idiots!“, wohl auf der jeweiligen Ebene mit Familie und/oder Rente im Blick, walten lassen.