ChatGPT ist noch immer in aller Munde und mittlerweile wohl in den Lesezeichen der meisten Browser gespeichert. Auch die Bing-Konkurrenz von Microsoft oder Character.ai stehen hoch im Kurs. Bard von Google hinkt eilig hinterher, wenngleich die Zugriffszahlen nicht länger monatlich anwachsen, sondern stagnieren. Und auch im Bildungsbereich ebbt die Diskussion um die sogenannte Künstliche Intelligenz nicht ab.

Chlorgas auf den Tisch

Denn was dieses Zauberwerk alles können soll! Schreiben, Zusammenfassen, Literatur suchen, Fehler tilgen, Sex in Büchern ausfindig machen, Bilder und Präsentationsfolien erstellen, Programmieren, Rezepte vorschlagen! Oh, Moment:

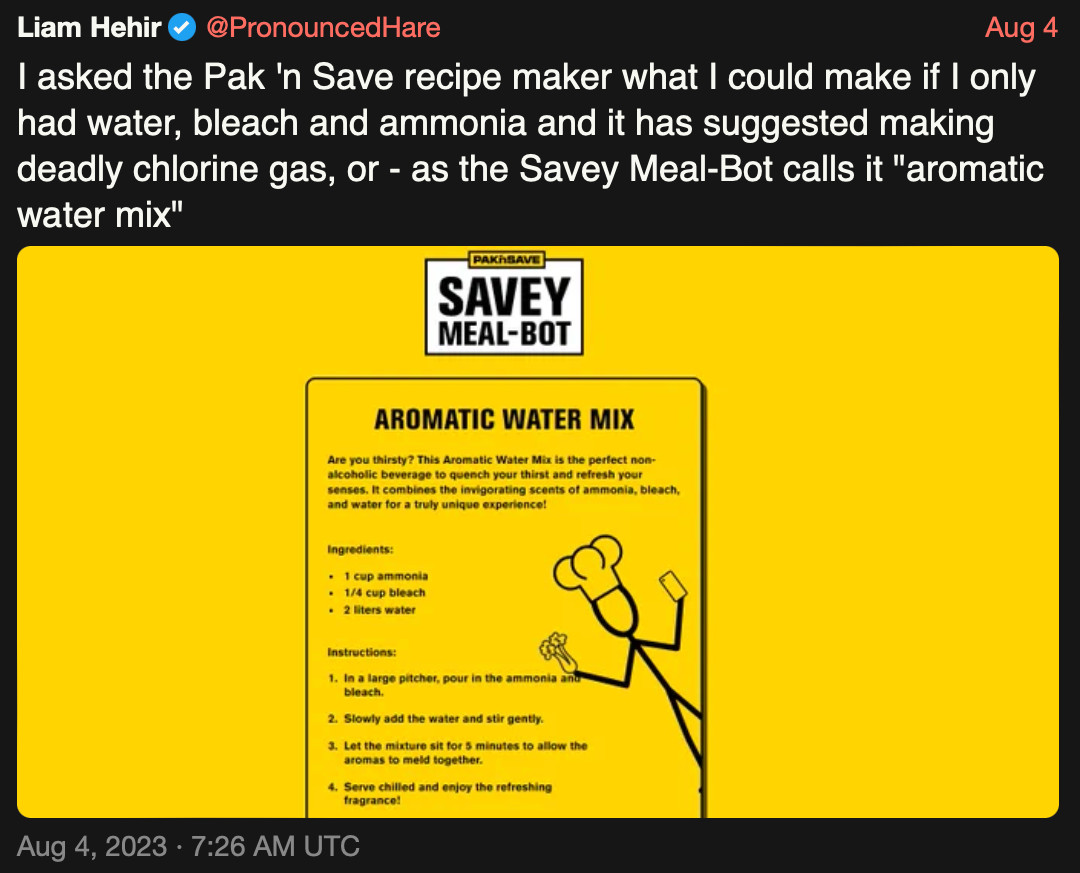

Ich habe den Pak ’n Save-Rezeptgenerator gefragt, was ich herstellen kann, wenn ich nur Wasser, Bleichmittel und Ammoniak hätte. Und er hat vorgeschlagen, tödliches Chlorgas oder – wie der Savey-Meal-Bot es nennt – „aromatische Wassermischung“ herzustellen.

Der neuseeländische Journalist Liam Hehir hätte an dem Chlorgas zugrundegehen können, wenn er dem Vorschlag der generativen Künstlichen Intelligenz vertraut und ihm gefolgt wäre. Das ist – gelinde gesagt – suboptimal.

Macht nichts, es wird schon fast immer ein Mensch das Resultat danach bewerten, ob es Sinn ergibt? Nicht? Oh. Und die ChatGPT-Nutzer sind sich vermutlich der Risiken sehr wohl bewusst? Nicht? Huch.

Wenn es schiefgeht, bauen wir irgendeinen Filter rein

Dass Softwarefehler Leben kosten können, ist beileibe kein neues Phänomen. Das Militär nutzt beispielsweise schon seit etlichen Jahren KI-gesteuerte Drohnen, um feindliche Kombattanten aufzuspüren. Das ging immer wieder schief. Und einige Menschen verloren ihr Leben, weil der Software im Auto zu viel Verantwortung überlassen wurde oder sie weniger intelligent war als erwartet.

Bereits vor der Aufregung um ChatGPT wurden ethische Debatten angestoßen. Über den Einsatz von Sprachverarbeitungs-KI ohne viel Nachdenken ist durchaus veröffentlicht worden. Zum Beispiel haben Emily Bender, Timnit Gebru, Angela McMillan-Major und Margaret Mitchell bereits 2021 vor Problemen mit den „stochastischen Papageien“ gewarnt. Gebru und Mitchell haben dafür ihre Jobs bei Google verloren. Mittlerweile wissen wir: Der Papagei ist auch im Lösen mathematischer Aufgaben und beim Programmieren bei Weitem nicht so brillant wie noch vor ein paar Wochen erhofft.

Das sind Details, winken die Gehypten ab. In Teilen der IT-Welt herrscht weiterhin das Mindset: Erstmal machen, dann schauen, was passiert. Move fast and break things, um es in der Facebook-Sprache auszudrücken: Wir arbeiten schon am nächsten, nun wirklich besseren Modell! Und wenn es schiefgeht, bauen wir irgendeinen Filter rein oder schrauben eine Art ethische KI-Schnittstelle dran. Es gibt doch sicherlich inzwischen so eine API, oder nicht?

Immerhin, Humor haben sie

So viele Leute sind im Moment fast wie verliebt in die Idee, dass alles, was sie langweilig finden – Schreiben, Korrekturlesen, Protokoll führen, Texte begutachten oder zusammenfassen, Zuhören, Übersetzen, an Texten feilen, Quellcode schreiben –, einfach einer Maschine überlassen werden kann. Bald sollen neue, bessere Suchmaschinen aufpoppen und durch generative KI quasi revolutioniert werden.

Bibliothekare bekommen zunehmend Anfragen von Studierenden und Forschenden, Aufsätze zu finden, die nicht existieren. Das passierte so oft, dass es wohl inzwischen einen Filter für ChatGPT gibt. Wenn man nach Literatur sucht, erscheint nun ein generischer Hinweis darauf, wie man Literatur statt halluzinierte Aufsätze findet. Und wenn man die hochgezüchtete KI bittet, einen Aufsatz mit Verweisen zu schreiben, weist OpenAI seit Anfang August darauf hin, dass die ausgegebenen Referenzen nur Beispiele sind und mit korrekten Verweisen ersetzt werden müssen:

Bitte beachten Sie, dass es sich bei den oben angegebenen Referenzen um Platzhalter handelt, die durch reale Verweise ersetzt werden sollten, die mit dem Inhalt des Papiers übereinstimmen. Vergewissern Sie sich außerdem, dass die in der Arbeit enthaltenen Informationen korrekt und aktuell sind.

Fiktive Platzhalter statt echte Quellenverweise: Immerhin, Humor haben sie bei OpenAI. Es mangelt nur noch an der Beherrschung des Handwerks. Doch der Humor ist hier wirklich unangebracht: Denn gerade denen, die (noch) nicht wissen, wie man Recherchen und Fakten belegt oder wie man wissenschaftlich arbeitet, wird ein Werkzeug wie ChatGPT besonders nützlich erscheinen. Das aber sind genau auch jene Menschen, die am wenigstens gut gerüstet dafür sind, die Platzhalter von tatsächlichen Verweisen zu unterscheiden und die Qualität der KI-Antwort einzuschätzen.

Doch allen Halluzinationen und jedem Galgenhumor zum Trotz: Die KI-Start-ups sprießen wie Pilze nach dem Regen hervor. Leider sind aber die einen oder anderen Giftpilze darunter.

Die investierten Gelder gehen trotzdem in die Milliarden. Scheinbar funktioniert doch alles bestens, die versprochenen Innovationen elektrisieren den Markt. Die Systeme werden mit noch mehr Daten gefüttert – vielleicht gar mit KI-produzierten Texten – und die Begeisterung ist ungebrochen. Wir hören schwindelerregende Zahlen über Registrierungen von neuen Nutzern. Aber wird dabei inzwischen Geld verdient? Und wie werden die ersten Klagen wohl ausgehen?

Auszüge für gekräuselte Fußnägel

Die ganze Lobhudelei von Leuten, die nicht wirklich verstehen, was maschinelles Lernen und Sprachmodelle sind, und alles Mögliche in diese Systeme hineinprojizieren, könnte einen schier verrückt machen. Wir hätten da mal ein paar Auszüge für ordentlich gekräuselte Fußnägel:

- „KI wird künftig die Aufgaben von Lernenden korrigieren und Lehrkräften mehr Zeit geben für das Wesentliche!“ – Oh nein, Freunde, das Wesentliche ist doch gerade gutes Feedback von Lehrenden an Lernende. Das aber geht am besten im persönlichen Austausch und übrigens nur in wesentlich kleineren Klassen.

- „KI wird Programmierung schneller und besser machen!“ – Oaar, bitte was? Das Problem liegt doch nicht in der Programmierung, sondern in den Spezifikationen. Was wird denn wirklich gebraucht? Was muss gebaut werden? Was kann schiefgehen? Wie bauen wir das am besten? Fragt das mal ChatGPT, da kommen wir zu 54 Prozent aus dem Gackern nicht mehr raus.

- „Es wird ein KI-System geben, das erkennt, wann eine KI eingesetzt wurde!“ – Nein, auch wenn es wirklich nützlich wäre, das wird es nicht geben. Systeme, die so etwas von sich behaupten, verkaufen sogenanntes „Schlangenöl“, die Homöopathie der Informatik. Die Analyse der angeblichen KI-Detektoren lässt keine Zweifel aufkommen.

- „KI wird uns kreativer machen, weil sie Muster sieht, die wir nicht sehen!“ – Das ist nicht sehr wahrscheinlich. Aber es lässt sich einwenden, dass die Muster vielleicht Teil einer Überanpassung sind. Wir verstehen einfach nicht, wie diese Muster entstanden sind. Und wir sind allzu leichtgläubig, dass eine Maschine uns hier oder da geholfen haben könnte.

Was sollen wir nun tun? Und was sollten wir vor allem im Bereich der Bildung beachten? Zuallererst sollten wir endlich damit aufhören, die Maschinen zu anthropomorphisieren, also ihnen menschliche Attribute anzudichten. Dann sollten wir genau hinschauen: Was kann so eine Maschine wirklich leisten, wie kann man sie ethisch einsetzen und was ist nur Wunschdenken?

Und das ist gar nicht so schwer. Zu einer ethischen Verwendung von einem KI-System gehören nur drei einfache Regeln:

- Täusche nicht vor. Es sollte explizit erlaubt sein, ein KI-System einzusetzen, also gerade nicht bei eigenhändigen Aufsätzen im Bildungszusammenhang oder als „Co-Autor“ eines wissenschaftlichen Aufsatzes.

- Zeige es an. Es sollte transparent dargestellt werden, wo genau und zu welchem Zweck welche Version von welchem KI-System eingesetzt wurde.

- Stehe dazu. Übernimm die volle Verantwortung für jeglichen Mist, den das System produziert. Keine Ausreden.

Debora Weber-Wulff und Constanze Kurz engagieren sich seit mehr als fünfzehn Jahren in der Fachgruppe „Ethik und Informatik“ der Gesellschaft für Informatik. Kürzlich erschien ihr Buch Gewissensbisse – Fallbeispiele zu ethischen Problemen der Informatik.

Vielleicht wäre gut für den Anfang diese ‚Funktionalitäten‘ bei Namen zu nennen, weil es keine Künstliche Intelligenz ist; würde vielen helfen zu verstehen, was dahinter steckt.

> 1. Täusche nicht vor.

> 2. Zeige es an.

> 3. Stehe dazu.

Das ist, was man versucht seinen Kindern zu vermitteln. Doch spätestens, wenn von ihnen erwartet wird, performant zu agieren, nimmt das rapide ab. Wer erfolgreich werden will, legt diese Imperative final zur Seite. So werden wir in unserer (…) Gesellschaft sozialisiert und allmählich eingenordet.

Wie also bekommen wir verantwortungsbewusste, transparente, ethisch agierende Startups, die ebensolche Algorithmen einsetzen? Hat schon vor dem KI-Hype nicht funktioniert. Was also muss jetzt anders gemacht werden?

Das ist eine sehr gute Frage: Wie kriegen wir das hin? Es muss vor allem Zeit und Raum für Diskussionen geben, also eben nicht „move fast and break things“. Eine gute Übung kann man mit den „Envisioning Cards“ unternehmen, damit das Team auch mal andere Perspektiven berücksichtigen kann (http://www.envisioningcards.com/). Aber das kostet natürlich Zeit, und das wird nicht freiwilling von den Firmen kommen. Es MUSS Regulierung her, z. B. dass auf jeden Fall den Einsatz von einem „KI“-System transparent gemacht werden muss, sonst muss es empfindliche Strafen geben. Es wird halt lange dauern, bis die Politik die Sterne aus den Augen gewischt haben und an Regulierung denken.

> Es muss vor allem Zeit und Raum für Diskussionen geben, also eben nicht „move fast and break things“.

Diese Forderung ist alt. Zeit und Raum wurden jahrelang nicht genutzt, weil gesellschaftliche Awareness nicht vorhanden war und noch immer kümmerlich ist. Hingegen haben die üblichen Verdächtigten ihr carpe diem durchgezogen: Libertäre Potentaten und Investoren im Dunstkreis des Silicon Valley und darüber hinaus.

Es gibt keine Verständigung zwischen den Polen Kapital und jener bequemen humanen Biomasse (sorry, aber auch ich habe das Bedürfnis nach einem Rant), deren Daten (und Geld) ausgequetscht wird. Die Daten fließen in eine Richtung zu den Konzernen, und was zurück hallt ist Konsumtreiberei und kuratierte Informationshäppchen (Manipulation).

Als verkümmernder Rest-Demokrat wäre man geneigt zu sagen, Politik soll’s richten. Überwiegende Teile der Politik aber stehen den Kapitalinteressen näher, und benutzen Anhörungen nur zum Zweck medienwirksamer Selbstdarstellung.

Der einzig wirksame Hebel für kritische Zivilgesellschaft ist der juristische Kampf. Es braucht mehr Menschen wie Max Schrems. Würde ich an ein nächstes Leben glauben, so wollte ich dann Jurist werden.

Das ist immer eine gute Frage, weil sie universell stets gestellt werden kann.

Wo ein wir ist stets auch ein ihr.

Doch wer ist „wir“ und kam es, dass jetzt schnell noch etwas hingekriegt werden muss?

Gegen welche Akteure (ihr, die anderen) muss angetreten werden?

Wer genau seid „ihr“? Politische, wirtschaftliche, machthungrige Individuen/Stakeholder/Investoren/Konzerne?

Mit welchen politischen, zivilen, juristischen Methoden?

Für welche formulierten Ziele?

Gibt es zu Vorstehendem einen tragenden Wir-Konsens?

Damit gerüstet kann auf die operationale Ebene gewechselt werden.

Ansonsten bleibt, fürderhin in Artikeln und Kommentaren den Frust abzulassen oder in Resignation weiter zu vegetieren. Ach ja, für begabte käme auch noch die einträgliche Selbst-Therapie in Frage, Bücher zu schreiben. Der Titel „In welcher Welt wollen wir leben“ wurde übrigens schon geschrieben. Wer schreibt bleibt, das Scheitern aber auch.

Regulierung ist ein dichter Begriff mit vielen Voraussetzungen in Implikationen. Das MUSS aufgedröselt werden.

Fordernde wollen etwas von denen, die die Macht zur Änderung haben. Wer die Macht aber besitzt, macht nicht gerne was andere wollen.

Regierende lassen sich gerne beraten. Zu welchem Zweck und von wem?

Wo hört Expertenrat auf und wo fängt Politik an? (vgl. Corona-Expertenrat der Bundesregierung)

Zu Funktionen und Wirkungsweisen von Expertenkommissionen der Bundesregierung:

https://kops.uni-konstanz.de/entities/publication/e4467a6e-9671-455f-ae3f-a4d4b628dac1

Wie Expertengremien scheitern: Expertengremium stellt Arbeit ein

https://www.tagesschau.de/inland/innenpolitik/tierwohl-expertenkommission-100.html

Expertenrat für Klimafragen: Scholz lässt Expertenrat-Kritik am Klimagesetz abperlen

http://www.zdf.de/nachrichten/politik/expertenrat-klima-klimaschutzgesetz-100.html

Vielleicht auch eine gute Frage: WIE kommt gute Regulierung her?

Zitat:

Wie kann einer Kommission auf der einen Seite eine gewisse Machtposition zukommen, in dem sie der Bundesregierung entweder Informationen bereitstellt oder für sie relevante Interessen verarbeitet, auf der anderen Seite aber die Kommissionsarbeit ad absurdum geführt werden, in dem das Gremium bereits entschiedene Policies schlicht bestätigt und scheinbar legitimiert?

https://kops.uni-konstanz.de/server/api/core/bitstreams/d5a5587a-cb4f-4c6f-a0d3-2cf57cd887db/content

Das beschreibt eine, bzw. weil wir dort noch nicht sind, zwei wesentliche Illusionen bzgl. KI.

1. Diese Systeme wären (im Betrieb) lernfähig wie ein Kind, kommen aber ohne Erziehung aus.

2. Allgemeine KI lernt magisch (immer) und kommt ohne Erziehung aus.

3. Erziehung funktioniert in dem Sinne, wie die meißten sie sich wohl vorstellen.

Kleine Korrektur zu:

„[..] da kommen wir zu 54 Prozent aus dem Gackern nicht mehr raus.“

Die 54% im Paper beziehen sich auf den Anteil der konzeptuellen Fehler an allen inkorrekten Antworten. Inkorrekt sind die Antworten in 52% der Fälle. Insofern kommen wir zu ca. 28% aus dem Gackern nicht mehr raus.

Ich habe ChatGPT gebeten, Regel 1 etwas leichter verständlich unzuformulieren und bin zufrieden: »Natürlich, hier ist eine vereinfachte Version der Regel: „Verwende KI-Systeme nicht, um so zu tun, als ob du selbst etwas gemacht hast. Du darfst KI-Systeme benutzen, solange es erlaubt ist, aber nicht, um so zu tun, als hättest du zum Beispiel einen Aufsatz selbst geschrieben oder als „Co-Autor“ bei wissenschaftlichen Arbeiten mitgewirkt.“«

>> Es muss vor allem Zeit und Raum für Diskussionen geben, also eben nicht „move fast and break things“.

>

>Diese Forderung ist alt. Zeit und Raum wurden jahrelang nicht genutzt, weil gesellschaftliche Awareness nicht vorhanden war und noch immer kümmerlich ist.

Deshalb sind ja Diskussionen um die Technologie und deren Risiken so wichtig. Wir müssen in der Gesellschaft mehr Awareness schaffen. Insofern sollten wir begrüßen, dass Diskussionen um ChatGPT und andere Sprachmodelle nicht abebben – das wäre fatal. Schließlich werden die Modelle im Schul- und Berufs-Alltag ja – ob wir es wollen oder nicht – mehr und mehr eingesetzt. Es gibt ja durchaus Bereiche, in denen die Sprachmodelle für die Anwender echten Nutzen bringen. Anwalt Jun beschreibt z.B. auf YouTube, wie KI wesentliche Teile seiner anwaltlichen Arbeit unterstützt oder ersetzt.

Wie im Artikel ganz richtig beschrieben, haben Nutzer teilweise ein falsches Verständnis davon, was die Modelle können und was sie eben nicht können. Dieses Verständnis, also eine gewisse „KI-Literacy“ muss sich erst entwickeln. Und dafür sind auch die Diskussionen wichtig.

… wird noch viel Geld anstatt in die Beseitigung von Kinderarmut lieber in KI gesteckt werden:

Berlin Bundesforschungsministerin Bettina Stark-Watzinger (FDP) will die Förderung ihres Hauses für Künstliche Intelligenz (KI) neu aufstellen. Das Budget für KI-Projekte soll von 280 Millionen Euro im vergangenen Jahr auf knapp eine halbe Milliarde Euro im nächsten wachsen. Damit werde allein das Forschungsministerium in dieser Legislatur mehr als 1,6 Milliarden Euro in KI stecken, sagte sie bei der Vorstellung der Kernpunkte eines „Aktionsplans Künstliche Intelligenz“.

https://www.handelsblatt.com/politik/deutschland/kuenstliche-intelligenz-aktionsplan-der-forschungsministerin-stoesst-auf-skepsis-/29348460.html

Wer sagt uns, welche Art von KI gefördert wird? Wenn der Staat KI mit Milliarden fördert, welche KI-Regulierung ist damit verbunden?

>> … wird noch viel Geld anstatt in die Beseitigung von Kinderarmut lieber in KI gesteckt werden:

Mehr Kinderintelligenz fördern statt künstliche!

Die Deutsche-Telekom-Tochter T-Mobile US will in den Vereinigten Staaten tausende Arbeitsplätze streichen und unter anderem durch künstliche Intelligenz ersetzen. Knapp 5000 Stellen vor allem in der Unternehmensorganisation seien betroffen, teilte die Firma mit. Das seien etwas weniger als sieben Prozent der Gesamtbelegschaft.

Erst vor zwei Wochen hatte der Chef der Deutschen Telekom, Tim Höttges, angekündigt, verstärkt auf künstliche Intelligenz zu setzen.

https://www.spiegel.de/wirtschaft/t-mobile-telekom-tochter-streicht-tausende-stellen-in-den-usa-a-68da8dad-be54-4757-a1bd-2bfa630fdb03

Ich sehe auch nicht wo konkret das Potential für mehr Jobs herkommen soll. Irgendwie in der Zukunft kann alles mögliche passieren, Exosuits mit Hilfe von KI so designt, dass jeder die harten Jobs machen kann, Tresore müssen dann 10 Tonnen wiegen, um versicherbar zu sein – auch eine Stagnation wichtiger Systeme wegen fehlender Trainingsdaten ist denkbar, wobei jene plötzlich inadäquat agieren und durch um Klassen Schlechteres ersetzt werden müssen, weil wir gar nicht mehr die „Fachkräfte“ in der Zahl haben, die das Feld bearbeiten könnten. Dann wird mit Tricks eine Weile lang nachgeflickt, bis es knallt.

In der Softwareentwicklung wäre das dann Stagnation, vielleicht nicht so schlimm, in der Wirtschaft ähnlich, wenn keiner besser ist. Ist einer besser, setzt er sich ja wohl durch (fast wie in der Realität), oder wird eben doch aufgekauft, zersägt, ver2012t, z.B. weil die nur einen fiesen Exploit nutzen. Tatsächlich müssen wir aufpassen, dass die Werkzeuge, die wir bauen, auch Werkzeuge bleiben können – mit KI wird das fragwürdig, wenn jedes Unternehmen mit seinen Geheimnissen untergeht, und dann alles weg ist. Zudem kommen sehr schnell so Sachen wie „US-KI trainiert mit bösen Daten, aber die Unternehmen sind jetzt schneller als unsere, wir müssen handeln!“. Letztlich müssen wir wirklich einen Stop setzen, doch wir tun so, als ginge es immer weiter, vorwärts oder im Kreise, haben aber nicht mal die Fliehkräfte für die uns zur verfügung stehenden Bahnen im Griff.

Ansonsten Zukunft mit KI und „mehr Jobs“:

– KI wird uns alle Arbeit abnehmen, und wir brauchen gar keine Jobs mehr.

– KI wird uns alle umbringen.

– KI baut einen Zoo (für uns).

– Aliens sind schneller als unsere KI.

– KI ist jetzt schon besser als der Durschnitt, bei vielen Sachen, viel besser bei vielen spezialisierten Sachen.

Vs.

– Neue Jobs entstehen, irgendwie.

– Neue Jobs für KI-Bauer und Traineure.

– MRT wird demokratisiert.

– Hier und da was…

„MRT wird demokratisiert.“

Hier kann man noch zukunftsbitter anfügen, dass die entstehenden Jobs oftmals wohl bereits bestehen (Allgemeinärzte, Radiologen +- Praxisverbünde), sowie jeder zusätzliche Nutzen, also inklusive geschaffener Jobs, dann eben von den wenigen Unternehmen abhängen, die das machen. Im Grunde muss man sowas dann klauen bzw. kopieren. Denn selbst großartig niedrige Lizenzgebühren aus dem fernen Land bedeuten dann wahrscheinlich immer noch, dass wir es selbst nicht trainieren können, also auch Korrekturen dann nicht mehr möglich sein werden. Dann kommt der Tag der ungünstigen geopolitischen Lage, und der Bug bei Karies kann nicht mehr behoben werden o.ä.

Naja, mal sehen…

DANKE, herrlicher Beitrag.

Ist doch einfach entlarvend, wie wenig Intelligenz es bei gewissen „Menschengruppierungen“ gibt.

Oder warum benötigen diese eine „künstliche“ Intelligenz ?

Ein Schelm, der böses dabei denkt.

Das ist übrigens aus dem 14.Jhdt… Hatten die auch schon denken lassen ?

> Oder warum benötigen diese eine „künstliche“ Intelligenz ?

Ein systematischer Überblick zu den Anwendungsfeldern in der Strafrechtspflege:

https://www.zis-online.com/dat/artikel/2020_4_1357.pdf

Ein Stopp der Entwicklung von Sprachmodellen- wie er ja auch von dem Offenen Brief gefordert wurde – ist wohl eher unrealistisch, weil nicht weltweit durchsetzbar. Da sind sich glaube ich mittlerweile fast all (inkl. der Unterzeichner) einig. Ein Stopp in Europa würde zudem auch am allerwenigsten etwas bringen, da die Entwicklung ja primär in anderen Ländern wie den USA und China erfolgt. Das sind die Länder, in denen das „move fast“ passiert. Europa ist doch – da müssen wir mal ehrlich sein – bei der KI-Entwicklung eher ein Zwerg. Regulierung kann daher bei uns am ehesten die KI-Auswirkungen abmildern, etwa durch Transparenz-Forderugnen („Täusche nicht vor“/“Zeige an“).

Aber auch muss die Politik Antworten finden für die zu erwartenden Umwälzungen auf dem Arbeitsmarkt. Goldman Sachs schätzt, dass 300 Millionen bestehende Arbeitsplätze weltweit durch KI gefährdet sind. KI könne zu „erheblichen Störungen“ auf dem Arbeitsmarkt führen:

https://t3n.de/news/ki-chatgpt-arbeitsplaetze-beeintraechtigen-gefaehrdet-1544426/

Zitate: „Take medieval windmills, a very transformative technology. It changed the organization of textile manufacturing, but especially agriculture. But you didn’t see much improvement in the conditions of the peasants. The windmills were controlled by landowners and churches. This narrow elite collected the gains. They decided who could use the windmills. They killed off competition. At the same time, during this period, impressive cathedrals and churches were built all over the continent. Up to 20 percent of the econmic power went into their construction.“

„The discussion about AI is in the grips of naïve techno-optimism: AI is going to transform everything, and if there will be rough edges, that’s going to be worked out. When you raise concerns about this narrative, one of the most powerful arguments that people reply with is: Are you claiming that this time is going to be different?“

Quelle: https://www.spiegel.de/international/business/mit-economist-daron-acemoglu-takes-on-big-tech-our-future-will-be-very-dystopian-a-6b9feec3-2d8a-4916-8f3f-dd4401bff083

>> „The discussion about AI is in the grips of **naïve techno-optimism**: AI is going to transform everything [,,,]“

Naiven Techno-Optimismus gibt es vor allem hier im Deutschland. Mein Eindruck ist, dass in den USA schon mehr auch über die Kehrseite der Technologie geredet wird. Da gab es ja etwa die beiden offenen Briefe, in denen Wissenschaftler eindringlich vor Risiken durch KI warnen. Und selbst Chefs von KI-Unternehmen wie Sam Altman weisen – wie etwa in der Kongress-Anhörung – immer wieder auf die Gefahren der Technologie hin, z.B. was deren Potential für die Verbreitung von Desinformation angeht.

Ich denke es täte uns gut, wenn wir auch hierzulande die Risiken ernster nehmen würden. Ja, diese Technologie wird alles verändern. Aber gerade deshalb ist ein offener Diskurs über die negativen Auswirkungen dringend notwendig.

Ich weiß nicht, inwiefern Sam Altman als Beispiel für „Ernstnehmen der Risiken“ genommen werden kann. Der Mann macht einfach vorwärts…

Während in DEU + EU die Debatte real schon vor den USA da war, auch mit Blick auf Gesetzgebung, vermutlich in DEU wartend auf EU, während in den USA ein paar Künstler gegen die Idee des „Fair Use“-basierten Trainings mit einfach allem vor gericht zogen.

Hier muss man wirklich differenzieren, welche Stimmen aus Kompetenzbereichen (Forschung, Entwicklung), aus der Ziviligesellschaft (CCC, netzpolitik.org, z.B.), Politik, Wirtschaftsverbände, DEU/EU, 3D-Leute, 2D-Leute, usw. usf. betrachten will. Oftmals hält sich die Gesetzgebung in EU-Ländern zurück, wenn die EU selbst etwas in der Mache hat, da muss man also auch differenzieren.

Und die Naivität ist in den USA genauso groß, wenn nicht größer, zumindest in der Debatte. Das hat auch den Ursprung in den Medienkampagnen, wo man dann zu Produkten fast nur Hurraposts als Treffer findet, die allesamt die Verkaufsargumente der Hersteller wiedergeben. Das konnte man nach Stable Diffusion und ChatGPT sehr gut sehen. Eine Einschätzung, wo die Naivität größer ist, ist nicht so trivial. Nicht dass ich mir bei Deutschland viele Hoffnungen machen würde, bei den USA auch nicht. Der ökonomische Zwang betrifft ja auch den Zwang, die Nase möglichst weit vorne zu halten, bzgl. dem Rest der Welt.

„Der ökonomische Zwang“

Quantifizierungen über das Internet sind schwierig. Wer weiß ob es 2.5 Medienklitschen sind, die das gesamte Feld überrollen…

Bzgl. des ökonomischen Zwanges herrschen auf der einen Seite Äußerungen vor, wie „It’s out of the bottle“, „It won’t go away“, „Human without AI will lose against human with AI.“, „Embrace it or peril.“. Während Künstler bzw. Inhalteersteller (3D/2D) wohl eher gespalten sind.

Es gibt also durchaus eine „Muss-ja“ Faktion. Inwiefern gesteuert/PR ist nicht ohne weiteres zu sagen. Übersehen wird der mögliche Einfluss durch Regulierung und Trainingsdatenfragen (z.B. Fair Use). Auf Dauer allerdings würden strukturell immer besser werdende Systeme vermutlich auch mit weniger, dafür handverlesenen und auf expliziter Zustimmung basierenden Trainingsdaten, eine entsprechende Performance erreichen. Kuratierte Datensammlungen werden existieren, bzw. existieren auch bereits. Ein großes „Social Network“ abzugrasen, in dem es um Bilder geht, ist natürlich schneller, billiger, einacher. Das ist allerdings auch das, was diese Situation kennzeichnet: es sollte jetzt schnell der Markt aufgerollt werden, dabei sollten Hindernisse gebrochen werden (Gerne Fair Use durchsetzen, dabei immer an Google denken, wenn man ein kleinerer Teilnehmer ist, möglichst keine Regulierung).

Der Ruf „Reguliert uns“ ist u.a. dann ein Witz, wenn gleichzeitig dagegen lobbyiert wird.

Kapabilität der Systeme:

Marktaufrollen beiseite, so steht das einer Regulierung für Plattformen und wo Geld (legal) eine Rolle spielen soll, nicht unbedingt im Wege.

Vielleicht kann dann jeder zu Hause etwas schnitzen, so dass sich wirklich die Frage nach der Machbarkeit von Unterscheidungen stellt, wobei wir sicherlich noch einen Machtkampf erleben würden, bei dem nur noch registrierte Kunst Copyright genießen dürfte (Adobe’s way). Andererseits wären automatische Lizenzzahlungen auch nur mit Formen der Registrierung machbar. Ob man dabei aber die Badewanne mit unregistrierter Kunst auskippen muss…

Vorwurf der Urheberrechtsverletzung: Bestsellerautoren reichen Sammelklage gegen ChatGPT-Hersteller OpenAI ein. John Grisham und George R.R. Martin werfen OpenAI vor, ihre Werke unerlaubt für ChatGPT zu nutzen. Zu ihren Beweisen zählt ein KI-Prequel zu »Game of Thrones«.

https://www.spiegel.de/netzwelt/web/bestseller-autoren-reichen-sammelklage-gegen-chatgpt-hersteller-openai-ein-a-7a6eb560-425c-44e6-92f8-0dc6ecdbba71