Die Polizei in London erprobt seit drei Jahren immer wieder automatische Gesichtserkennungstechnologien. Zwei Forscher, die die Polizisten für ein halbes Jahr bei den Einsätzen begleiten konnten, berichten nun Vernichtendes über das Experiment: Die nachweisbare Erkennungsrate liegt bei lediglich 19& Prozent. 81 Prozent der angehaltenen Personen wurden also falsch erkannt. Auch hätten die Tests bei einer Klage vor Gericht wohl kein Bestand, so die Forscher von der Universität Essex.

In Großbritannien gibt es, wie auch in vielen anderen Ländern, bisher keine gesonderte Rechtsgrundlage für automatische Gesichtserkennung. Weil es sich aber um eine Technologie handelt, die besonders invasiv ist, setzen sich immer mehr Organisationen weltweit dafür ein, ihren Einsatz zu verhindern. In Cardiff läuft seit Mai ein Gerichtsprozess. Und in San Francisco hat der Stadtrat automatische Gesichtserkennung gerade erst verboten.

Tausendfache biometrische Erfassung für acht Verhaftungen

Die Erkennungsraten in London sind noch nicht sehr hoch: Bei den sechs Testläufen zwischen Juni 2018 und Februar 2019, die die Forscher beobachten konnten, lieferte das System 42 Treffer. Nur bei acht davon handelte es sich auch um polizeilich gesuchte Personen. Doch für diese magere Ausbeute wurden Tausende Passanten automatisch erfasst und ihre biometrischen Merkmale in Echtzeit mit jenen von gesuchten Personen auf verschiedenen polizeilichen Listen abgeglichen.

Nach Einblick in die polizeilichen Unterlagen fanden die Forscher zudem heraus, dass weder technische Alternativen, noch die Vereinbarkeit mit Menschenrechten geprüft wurden. Gesichtserkennung im öffentlichen Raum greift nicht nur in die Privatsphäre, sondern auch in andere Menschenrechte wie die Versammlungs- oder Bewegungsfreiheit ein.

Kein Test, sondern Realbetrieb

Hinzu kommt: Anders als bei einem ähnlichen Projekt am Berliner Bahnhof Südkreuz, nutzte die Londoner Polizei die Technik im Realbetrieb. Während Bundespolizei und Innenministerium hierzulande noch eine Gruppe von freiwilligen Testpersonen anwarben, fütterte die Londoner Polizei die Systeme gleich mit echten Listen von gesuchten Personen.

Das erschwerte im Vergleich auch die Überprüfung der Trefferquote. Die Polizei sprach von einer Fehlerquote von 0,1 Prozent, allerdings bezogen auf alle gescannten Gesichter und nicht darauf, ob eine Person auch zu Recht von den Beamt:innen festgehalten und kontrolliert wurde.

Interessanter dürfte hier die Perspektive von Bürger:innen sein: Wenn für eine gesuchte Person fünf andere fälschlich als Kriminelle identifiziert und kontrolliert werden, führt das auch zu sinnlosen Eskalationen. Eine Person wurde etwa überprüft, weil sie im Vorbeigehen ihr Gesicht verdecken wollte. Das führte zu Streit, einer Festnahme und schließlich einem Bußgeld von 90 Pfund. Automatische Gesichtserkennung produziert damit auch neue Arten des „Fehlverhaltens“, die wiederum als Rechtfertigung für härteres Vorgehen von Seiten der Polizei dienen können.

Keine informierte Einwilligung

Unbeteiligte Passanten wurden nur über Flyer und einige Pappaufsteller vor den mit Kameras ausgestatteten Vans über das Experiment informiert. Das erfüllt das Gebot einer informierten Einwilligung nicht, so die Forscher. Einer von ihnen, Dr. Murray, sagt: „Der Bericht wirft erhebliche Zweifel an der Einhaltung der Menschenrechte während dieser Tests auf.“ Auch deshalb rufen die Wissenschaftler die Polizei auf, die Experimente zu beenden.

Dabei erhielten die Forscher:innen weitreichenden Zugang und konnten auch mit Polizist:innen sprechen. Entsprechend detailliert und interessant zu lesen ist auch der 128-seitige Bericht. Auf ihn wird sich wohl auch die Bürgerrechtsorganisation Big Brother Watch berufen. Sie kündigte an, klagen zu wollen, wenn die Polizei die Tests nicht beendet.

Auch am sogenannten Sicherheitsbahnhof Südkreuz konnten keine guten Trefferquoten generiert werden. Dennoch forderte der damalige Innenminister de Maizière einen „flächendeckenden“ Ausbau. Es ist allerdings nur eine Frage der Zeit, bis die Systeme besser werden. Dann wird das bislang gewichtige Argument der Fehlerquoten und der damit verbundenen Diskriminierung Unschuldiger obsolet werden.

Technik ohne Rechtsgrundlage

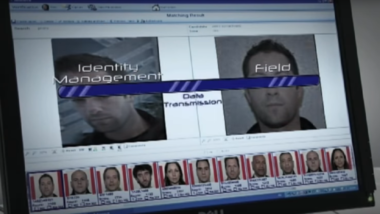

Die Software, die in London im Einsatz ist, heißt „NeoFace“ und wird vom japanischen Elektronikhersteller NEC entwickelt. Der wirbt damit, dass auch Bildmaterial von bereits installierten Überwachungskameras zusammengeführt und in Echtzeit ausgewertet werden kann.

Schätzungen zufolge gibt es in London 500.000 Überwachungskameras in privater und öffentlicher Hand. Wer auf der Straße unterwegs ist, wird im Durchschnitt 300 Mal pro Tag aufgezeichnet. Um zu verhindern, dass sie in den nächsten Jahren mit Gesichtserkennungssoftware ausgestattet werden, braucht es jetzt auch in Europa gesetzliche Verbote für automatische biometrische Erkennungsverfahren im öffentlichen Raum.

0 Ergänzungen

Dieser Artikel ist älter als ein Jahr, daher sind die Ergänzungen geschlossen.