Gestern kamen in der Berliner Heinrich-Böll-Stiftung Politiker und Experten zusammen, um über eine fatale Entwicklung zu diskutieren, die bisher selten im Fokus der Öffentlichkeit steht. Es ging um die Frage Tödliche Algorithmen – Dürfen Waffen autonom über Leben und Tod entscheiden? Im Militärjargon werden solche Systeme „Lethal Autonomous Weapon Systems“ (LAWS, tödliche autonome Waffensysteme) genannt. Die Bezeichnung „Killer Robots“ für solche Waffen ist ebenfalls gebräuchlich und griffiger, aber weniger präzise.

Seit mehreren Jahren wird von der internationalen Kampagne Stop Killer Robots ein Verbot von autonomen Waffensystemen gefordert, das im Rahmen einer UN-Waffenkonvention geltend gemacht werden soll: Ziel ist die völkerrechtliche Ächtung von Militärsystemen, die autonom über den tödlichen Waffeneinsatz entscheiden. Dafür haben sich bisher 19 Staaten bei den Vereinten Nationen ausgesprochen, im August beginnt die nächste Verhandlungsrunde.

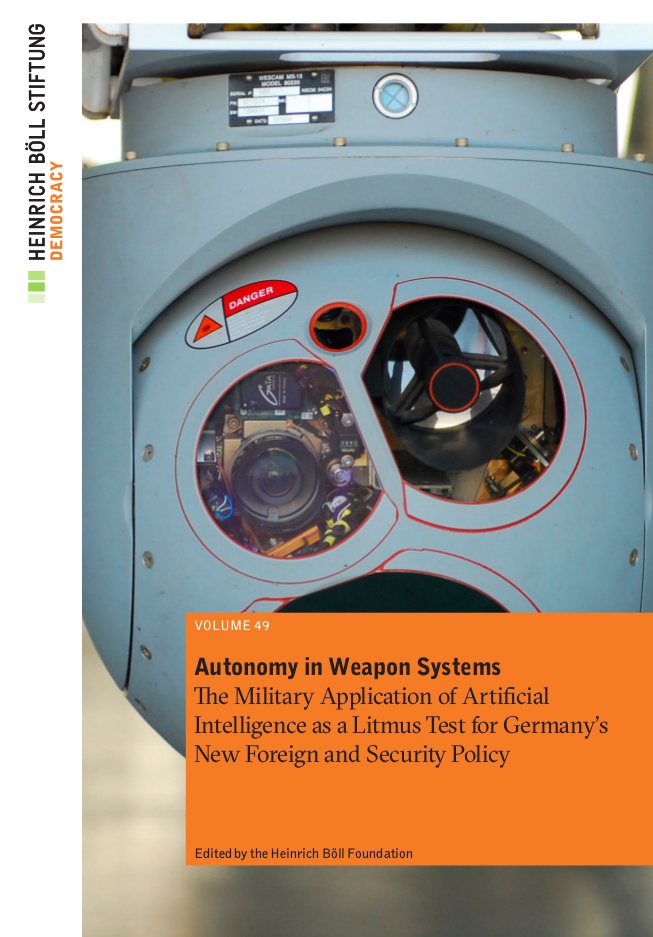

Das Ziel der gestrigen Diskussion war eine Nummer kleiner: Eine öffentliche Diskussion über die gefährlichen militärischen Entwicklungen soll stimuliert werden, wie Ellen Ueberschär von der Heinrich-Böll-Stiftung in ihren einleitenden Bemerkungen betonte. Dazu hatte die Stiftung eine eigene „Task Force“ ins Leben gerufen, die nicht nur dem Namen nach eine gewisse Militärnähe aufweist. Denn zeitgleich mit der gestrigen Veranstaltung erschien bei der Heinrich-Böll-Stiftung das Heft Autonomy in Weapon Systems (pdf) unter der Federführung von Frank Sauer von der Bundeswehr-Universität München.

Sauer war auch einer der Podiumsteilnehmer, gemeinsam mit Konstantin von Notz, dem stellvertretenden Fraktionsvorsitzenden der Grünen im Bundestag, Lorena Jaume-Palasí von „Algorithm Watch“ und John Reyels als Vertreter des Auswärtigen Amts.

Welche autonomen Waffensysteme gibt es?

Die Entwicklung von mörderischen Kampfmaschinen, die selbständig Entscheidungen über Leben und Tod fällen, ist keine ferne Zukunft mehr. So hat etwa der größte russische Militärzulieferer Kalaschnikow im Juli 2017 ein Waffensystem mit der Bezeichnung нахлебник (russ. etwa Schnorrer) vorgeführt, das mit Hilfe von Künstlicher Intelligenz und sogenannten Neuronalen Netzen autonom entscheidet, ob es schießt oder nicht. Es handelt sich um ein vollautomatisches Kampfsystem inklusive Bewaffnung, das älteren Entwicklungen der Firma Samsung in Südkorea ähnelt, aber mit leistungsfähigerer Künstlicher Intelligenz (KI) beworben wird.

Solche bereits angebotenen Waffensysteme sind aber nur ein Ausschnitt der technischen Entwicklungen für Militärs. An Frank Sauer von der Bundeswehr-Uni richtete sich die Frage, was für autonome Waffensysteme es derzeit gibt und welche bereits in naher Zukunft absehbar sind. Statt einer überblicksartigen Antwort widmet sich Sauer einigen Beispielen und verweist auf die Broschüre der Böll-Stiftung, die jedoch diese Frage auch nicht umfassend beantwortet. Allerdings beinhaltet das Heft die relevanten Definitionen und Begriffe, die versuchen, tödliche autonome Waffensysteme und ihre Eigenschaften zu erfassen und rechtlich einzuordnen.

Die sich entwickelnden Möglichkeiten der KI sind zusammen mit der Sensorik, den verfügbaren Daten und der Rechenleistung für die autonomen Entscheidungen solcher Waffensysteme zweifelsohne von hoher Bedeutung. Aktuell wird die Frage, in welche Dienste sich KI-Forscher und -Entwickler stellen, heftig diskutiert. Es ist in den letzten Tagen zu einem öffentlich ausgetragenen Konflikt zwischen dem US-amerikanischen Pentagon einerseits und Ingenieuren und Wissenschaftlern andererseits gekommen. Am 16. Mai wurde bekannt, dass ein Dutzend Google-Mitarbeiter ihren Job hinwarfen, um sich gegen die Partnerschaft in Sachen KI zwischen Google und dem Pentagon zu wehren. Zuvor hatten mehr als dreitausend Google-Leute eine Forderung unterzeichnet, diese Partnerschaft zu beenden und den Vertrag mit dem US-Verteidigungsministerium aufzulösen.

In der Podiumsdiskussion wurde der Streit in den Vereinigten Staaten aber nur am Rande diskutiert, es ging stärker um die deutsche Perspektive auf die sogenannten „Killer Robots“: Welche Haltung nimmt die deutsche Regierung ein? Wie ist die rechtliche Situation? Was sind drängende ethische Fragen im KI-Zusammenhang?

Sauer nennt als Beispiel für autonome Entscheidungen mit Hilfe von KI die militärischen Minidrohnen „Perdix“: Kampfjets können Dutzende solcher kleinen Flugkörper bei hohen Geschwindigkeiten abwerfen. Die preiswerten Drohnen bilden dann einen Schwarm und bewegen sich autonom zu vorbestimmten Wegpunkten. Das Pentagon hatte „Perdix“ im Jahr 2017 demonstriert, allerdings dabei betont, man wolle in einem „zukünftigen Kampf-Netzwerk“ stets Menschen die Entscheidungen über einen Waffeneinsatz überlassen.

Das Beispiel zeigt: Bei völkerrechtlich umstrittenen Waffensystemen mit eigener „Intelligenz“ ist eben nicht mehr nur an große Kampfroboter oder militärische Drohnen mit Hellfire-Raketen zu denken, sondern längst auch an kleinere bewaffnete Drohnen der Militärs, die in naher Zukunft ebenfalls in der Lage sein könnten, autonome Entscheidungen über den Waffeneinsatz zu fällen. Ob auch Software ohne Hardware-Komponente als tödliches autonomes Waffensystem gelten kann, wäre zu diskutieren.

Ebenso wie bei größeren militärischen Waffensystemen sind jedenfalls rechtliche Verantwortlichkeiten bei Kriegsverbrechen sowie Fragen von Menschenrechtsverletzungen zu klären. Der Unterschied zu bereits seit Jahrzehnten verwendeten autonomen Waffensystemen, die etwa herannahende Flugkörper selbständig abschießen, ist vor allem die Frage, ob auf „belebte Ziele“ geschossen wird. Damit meinen Militärs Fahrzeuge oder Gebäude, in denen sich Menschen befinden könnten, oder aber das direkte Zielen von autonomen Kampfsystemen auf Menschen.

Lorena Jaume-Palasí verweist darauf, dass man solche Waffensysteme wegen des Begriffs autonom nicht als menschenunabhängig missverstehen sollte. Schließlich seien es konkrete Menschen, die sie entwickeln, programmieren und zum Einsatz bringen. Ohne menschliches Zutun gäbe es solche Waffen nicht. Sie schlägt vor, besser von automatisierten als von autonomen Systemen zu sprechen.

Auch sollte die Diskussion nicht auf die „Trefferquoten“, Wahrscheinlichkeiten und Effizienz verengt werden, betont Jaume-Palasí. Wer sich dazu drängen lasse, blende Fragen der Verantwortung für solche Tötungsmaschinen aus.

Auswärtiges Amt: „Optimum wäre ein Verbot, das ist aber nicht erreichbar“

Eine Zusammenfassung der politischen Positionen in der Diskussion über autonome Waffensysteme lieferte John Reyels vom Auswärtigen Amt. Bei den Vereinten Nationen hat diese Diskussion den formalen Charakter von Konsultationen von Regierungsexperten. Er fasst den Stand der UN-Debatte zur Ächtung solcher Waffen mit einem knappen Satz zusammen: „Es sieht nicht gut aus.“

Grund sei vor allem eine gewisse Lagerbildung: Es gäbe eine zahlenmäßig größere Gruppe sogenannter blockfreier Staaten, die sich für ein Verbot einsetzt. Dem gegenüber stünden vor allem die Vereinigten Staaten, die eine UN-Regelung gar nicht erst verhandeln wollen. Man stelle stattdessen ausschließlich die Vorteile solcher Waffensysteme heraus.

Auch andere militärisch bedeutsame Staaten wie Russland oder China bezögen einen Standpunkt, der ein schnelles Verbot ablehne. Begründung dafür sei ein Wissens- und Erfahrungsdefizit, man müsse zunächst mehr lernen über die Möglichkeiten solcher Waffensysteme.

Die deutsche Position beschreibt Reyels als „vermittelnde Lösung“, die zusammen mit Frankreich vertreten werde. Er verweist dabei auf den aktuellen Koalitionsvertrag: Man strebe wie darin festgehalten zwar eine Ächtung an und „bekenne sich zum Völkerrecht“, aber realpolitisch könne man derzeit nur die Gründung eines Expertenkreises anstreben. „Optimum wäre ein Verbot, das ist aber nicht erreichbar“, fügte Reyels an. Der Moderator der Diskussion findet für diese Haltung der Regierung den passenden Begriff „deklaratorische Politik“. Der Grüne Konstantin von Notz merkt an, ihm werde bei dieser Positionierung des Auswärtigen Amtes „mulmig“.

Aus dem Publikum wird an Reyels die Frage gerichtet, warum man die Ächtung tödlicher autonomer Waffen nicht auch ohne die Zustimmung der Vereinigten Staaten oder China bei den Vereinten Nationen offen unterstütze, wenn man das Verbot wirklich anstrebe. Der Diplomat verweist daraufhin auf den „geringen praktischen Wert“, den ein solches Vorgehen haben würde. Es bestehe zudem hoher Zeitdruck, so dass sein Ministerium die „vermittelnde Lösung“ mit Gründung einer Expertengruppe vorziehe. Ziel sei vor allem ein Ergebnis in absehbarer Zeit. Welchen praktischen Wert das allerdings hat, blieb offen.

Rüstungsindustrie als Randnotiz

Einen „Schritt in den Wahnsinn“ nennt von Notz die absehbaren militärischen Entwicklungen bei autonomen Waffensystemen. Krieg als eine Art Wahrscheinlichkeitsrechnung, bei der „mathematische Kriterien für Leben oder Tod“ programmiert werden, lehnt er klar ab. Der Krieg an sich sei ohnehin „ein grauenvolles Business“. Diese Bemerkung des Politikers bleibt in anderthalb Stunden Diskussion das einzige Mal, dass ein Bezug zur Rüstungsindustrie fällt. Kein Wort wird ansonsten über die diejenigen gesprochen, die tödliche autonome Waffensysteme herstellen und anbieten.

Der Grüne von Notz verweist auf den Drohnenkrieg der Vereinigten Staaten im letzten Jahrzehnt, der im Rückblick mehr Terroristen hervorgebracht als umgebracht habe. Der praktische Einsatz von bewaffneten Drohnen wird während der Diskussion oft erwähnt und am Ende durch eine Zuhörerfrage zugespitzt. Denn dass Kampfdrohnen technisch als tödliche autonome Waffensysteme fungieren könnten, ist naheliegend. Der Mensch, der in weiter Ferne die Rakete der Drohne auslöst, ist keine technische Notwendigkeit mehr.

Eine Zuhörerin verweist darauf, dass de facto beim Drohneneinsatz der Vereinigten Staaten auch nicht der Soldat am fernen Abzug die Entscheidung über Leben und Tod der Menschen unter der Drohne fälle, sondern die dafür verantwortlichen CIA-Leute. Denn sie seien es, die den Soldaten im Drohnenkrieg die Befehle erteilten. Die Zuhörerin fragt auch nach einem Widerspruch in der Haltung der Bundesregierung: Warum denn einerseits für Deutschland der Beschluss zum Kauf bewaffneter Drohnen unmittelbar bevorstünde, wenn doch andererseits ein Verbot tödlicher autonomer Waffensysteme angestrebt und zudem ein von Reyels extra betontes Bekenntnis zum Völkerrecht abgegeben werde? Das Völkerrecht gelte schließlich auch im deutschen Ramstein, von wo US-amerikanische Drohnen operiert werden.

Reyels räumt in seiner Antwort ein, dass Drohnen wahrscheinlich eines der ersten praktisch benutzten Waffensysteme mit tödlicher Wirkung sein werden, die zu Entscheidungen ohne direktes menschliches Zutun fähig sind. Warum Deutschland nun zu der Liga der Staaten gehören soll, die Kampfdrohnen besitzen, begründet er nicht. Reyels versichert stattdessen zum Einsatz dieser bewaffneten Drohnen: „Wir werden nichts Vergleichbares tun wie die USA.“

Man kann nur hoffen, dass nicht noch die Realpolitik dazwischenkommt.

Nicht zu vergessen all die Söldner-Heere – von miteinander konkurrierenden Freelancer-Vereinen über lokale Milizen bis zu (entstehende) Privat-Armeen der KI-gestützten Großkonzerne. *Die nationalen Militärs dieser Welt, die machens schon längst nicht mehr wies ihnen gefällt. *sing*

*Oder vertreten nur noch wirtschaftliche Interessen

Ob es das Opfer interessiert, ob es von künstlicher oder mangelnder Intelligenz gemeuchelt wurde?

Nachdem ich die Studie genauer gelesen habe, bin ich etwas enttäuscht, dass in der Diskussion so wenig auf sie eingegangen wurde. Auf die Publikumsfrage, wie denn die positive Haltung Drohnen gegenüber mit der ablehnenden Haltung der militärischen Nutzung von sogenannten »Autonomen Waffensystemen« (AWS) einhergehen kann, antwortet die Studie ziemlich deutlich: Drohnen können sehr leicht in AWS umgerüstet werden. Die Argumente gegen AWS gelten daher auch in Bezug auf Drohnen. Schade, dass dies auf dem Podium nicht so deutlich wurde, das war eine sehr scharfsinnige Frage, wie ich finde.

Wenn das Thema der Veranstaltung LAWS sind, ist die Frage, ob Drohnen sich einfach in LAWS umwandeln lassen und ob man deswegen was gegen Drohnen haben sollte, schlicht nicht das Thema.

Doch, das war Thema, weil es sowohl die Leute auf dem Podium als auch aus dem Publikum zu einem gemacht haben. Drohnen dürften die ersten LAWs in breiterem Einsatz werden, deswegen lag es auch nahe.

Entweder ist eine Drohne kein LAWS, dann war sie nicht Thema. Oder eine Drohne ist LAWS, dann ist sie eben LAWS wie jedes anderes LAWS auch. Die Frage, ob man nicht-LAWS-Drohnen ablehnt, ist mE nicht wirklich relevant in dem Kontext. Die Frage, ob nicht-LAWS-Drohnen mit relativ wenig Aufwand in LAWS umgewandelt werden koennen ist trivialerweise zu bejaen, da ist nicht viel zu diskutieren.

Wieso denn? Anders als andere autonome Waffenarten oder bisherige Prototypen stehen sie in großer Zahl bereits zur Verfügung und sind denkbar einfach umzurüsten. Da ist ne ganze Menge zu diskutieren, denn an den bewaffneten Drohnen wurde ja eindrucksvoll exerziert, dass dem Völkerrecht mit Ignoranz begegnet wird. Nicht, dass ich nicht finde, dass die neuen autonomen Waffenideen nicht auch ein gutes Thema zum Diskutieren sind, aber Drohnen als Paradebeispiel haben den Vorteil, dass man sich schlecht mit dem heimlichen Gedanken wegducken kann, dass es ja noch weit in der Zukunft erscheint.

Die Information, dass Frank Sauer an der Bundeswehruniversität München lehrt, ist richtig. Wesentlich (und weniger irreführend) wäre in diesem Zusammenhang jedoch ein anderer Hinweis gewesen, nämlich, dass Frank Sauer seit 2010 dem International Committee for Robotic Arms Control (ICRAC) angehört, das sich für ein internationales Verbot autonomer Waffensysteme einsetzt. In Deutschland ist Frank Sauer vermutlich der führende, und medial sicher bekannteste, Fürsprecher eines Verbots.

Die von Ihnen genannte Task Force der Heinrich-Böll-Stiftung weist keine Militärnähe auf.

Im Übrigen: Für Forscherinnen im Bereich der Internationalen Beziehungen und der Friedens- und Konfliktforschung sind die Bundeswehruniversitäten tatsächlich wegen ihrer Militärnähe interessant – aber nicht etwa, weil die Forscherinnen militärnahe Einstellungen vertreten, sondern ganz im Gegenteil, weil man dort den Friedensgedanken wie auch Erkenntnisse über den Frieden denjenigen vermitteln kann, bei denen das als Korrektiv zu ihrer sonstigen Ausbildung wirken kann.

Herr Sauers Mitwirkung beim ICRAC wurde auf der Veranstaltung nur kurz erwähnt, aber in der Broschüre wird das deutlich. Ich habe es deswegen im Artikel nicht angegeben, weil ich nicht davon ausgehen kann, dass jedem Leser das ICRAC und seine Arbeit bekannt ist und es auch auf der Veranstaltung keine große Rolle gespielt hat. Dass er sich für ein Verbot einsetzt, hat er auf dem Podium zwar nicht explizit gesagt, geht aber aus der Broschüre durchaus hervor.

Wie man das Wort „Militärnähe“ konnotiert, bleibt dem Leser überlassen. Es ist jedoch nicht irreführend, sondern schlicht die Wahrheit, wenn man Forschen und Lehren an einer Bundeswehr-Universität als militärnah charakterisiert. Dass die Task Force der Heinrich-Böll-Stiftung keine Militärnähe aufweist, wäre hingegen unrichtig.

Selbstverständlich können Friedensforscher an Bundeswehr-Universitäten versuchen, „Friedensgedanken“ und akademische Forschung als „Korrektiv“ zu vermitteln, in dem Artikel steht auch nichts Gegenteiliges.