In Genf kamen im November internationale Experten in einer Arbeitsgruppe der Vereinten Nationen (Group of Governmental Experts) zusammen, um über tödliche autonome Waffensysteme und eine mögliche Erweiterung der UN-Waffenkonvention (Convention on Conventional Weapons (CCW)) zu sprechen. Es geht dabei um solche Waffen, die von Kritikern Killer Robots genannt werden. Sie können autonom Entscheidungen über Leben und Tod treffen.

Roboter werden in naher Zukunft technisch enorme Fortschritt machen und in vielen Formen verfügbar sein: mit mehr Sensoren, mehr Rechenleistung, mit stetig sinkenden Kosten und integriert in viele unserer Lebensbereiche. Autonome und halbautonome Systeme, die verschiedene Arten von künstlicher Intelligenz beinhalten und uns vielleicht heute eher wie aus Science-Fiction-Filmen erscheinen, werden im Alltag bald sichtbarer werden. Diese Entwicklungen im zivilen Bereich beeinflussen auch die Diskussionen mit den Militärs: Um die Verbreitung von Tötungsrobotern zu verhindern, müssten jedoch völkerrechtliche Regeln entworfen werden, die ein internationales Verbot möglich machen könnten.

Wir haben mit Marcel Dickow über die Ergebnisse des UN-Expertentreffens gesprochen und darüber, wie man solche Waffensysteme definieren und abgrenzen könnte.

Die Musik im Podcast ist aus dem Titel „Fragments of a lost system“ von Granlab, Creative Commons BY-NC-ND 2.0.

Die UN-Waffenkonvention und die „Killer-Roboter“

netzpolitik.org: Wir haben heute im netzpolitik.org-Podcast Marcel Dickow zu Gast, der sich kurz vorstellen wird. Wir haben ein Thema, über das wir reden wollen, und darin ist er ein Experte.

Marcel Dickow: Ich arbeite für die Stiftung Wissenschaft und Politik und leite hier die Forschungsgruppe Sicherheitspolitik. Ich bin Physiker und deswegen hier in der Stiftung zuständig für alle Themen, die irgendwie mit Technologie und Sicherheit zu tun haben.

netzpolitik.org: Wie lange sind Sie schon bei der Stiftung?

Marcel Dickow: Seit 2009, also seit gut acht Jahren.

netzpolitik.org: Wir sind hier zu einem besonderen Anlass zusammengekommen, nämlich weil vor ein paar Tagen in Genf ein Treffen einer Arbeitsgruppe war, die bei der UNO angesiedelt ist und die sich mit speziellen Waffensystemen beschäftigt hat. Und darüber wollen wir reden, denn Sie sind Teil dieser Arbeitsgruppe und waren auch in Genf …

Marcel Dickow: … ja, genau, wir reden über die UN-Waffenkonvention, die CCW, die einen speziellen Prozess hat, der sich um „Killer-Roboter“ kümmert, wie man im „Volkssprech“ sagt. Wir sagen letale autonome Waffensysteme und kürzen sie mit LAWS für „Lethal Autonomous Weapon Systems“ ab. Und nun hat sich zum ersten Mal eine Gruppe von Regierungsexperten getroffen, die diskutiert hat, ob man diese Systeme zukünftig regulieren soll oder nicht.

netzpolitik.org: Damit haben wir erstmal die Arbeitsgruppe umrissen und was sie tun soll. Vielleicht können Sie uns ein bisschen was dazu sagen, wie der Prozess entstanden ist, dass diese Arbeitsgruppe überhaupt ins Leben gerufen wurde. Sie haben selber eben den Begriff Killer Robots benutzt und erklärt, dass das natürlich nicht der rechtliche Terminus ist. Es gibt ja in der Zivilgesellschaft eine Bewegung, die sich schon vor Jahren gegründet hat. Hat auch dieser Protest und dieses Campaigning in der Zivilgesellschaft diesen Prozess ausgelöst?

Der große Schritt im Jahr 2016

netzpolitik.org: Sie hatten eben schon gesagt, ein Punkt war der Drohnenbericht und auch die öffentliche Diskussion über die Drohnen. Wie ist aber der Übersprung zu anderen autonomen Waffensystemen?

Marcel Dickow: Im Grunde genommen zufällig. Es gab dann die Kampagne von diversen Menschenrechtsorganisationen, zum Beispiel Human Rights Watch und Amnesty, die sich zusammengeschlossen haben und diese „Campaign to Stop Killer Robots“ gegründet haben. Und dann sind zwei Dinge passiert: Erstens hat man danach gesucht, wo ein geeignetes Forum sein könnte; und zweitens hat sich in einem dieser geeigneten Foren, nämlich der UN-Waffen-Konvention, der französische Botschafter in Genf dazu bereiterklärt, ein erstes informelles Expertentreffen zu organisieren.

Aufgrund dieses persönlichen Engagements und weil das Thema in der Öffentlichkeit war und weil es offensichtlich ist, dass es eine neue Qualität und auf jeden Fall ein neuer Typ von Waffensystem ist, über das man sich unterhalten sollte, ist das ganze Thema bei der CCW gelandet.

netzpolitik.org: Fünf Tage lang, nicht wahr?

Marcel Dickow: Fünf Tage lang. Und soviel kann man schon sagen: mit nicht besonders großem Ergebnis.

netzpolitik.org: Das heißt, Sie würden nach diesen ersten Beratungen sagen, so richtig einen Schritt weiter ist man da noch nicht gekommen?

Marcel Dickow: Genau. Es waren auch nicht wirklich Beratungen im Sinne eines wirklichen Austauschs zwischen den Staaten, um einen Kompromiss zu finden. Es war wieder einmal, wie in den vergangenen Jahren auch schon, mehr eine Art Expertenanhörung. Die würde dann am Ende einen Bericht schreiben – das ist auch erfolgt –, aber dieser Bericht ist nicht besonders ambitioniert.

Er sagt im Wesentlichen, dass die Debatten im nächsten Jahr fortgesetzt werden sollen, gibt aber keinerlei inhaltliche Leitlinie, wie die Debatten aussehen könnten oder wohin sie gehen sollten.

Umstrittene Definitionen

netzpolitik.org: Es ist ein gänzlich offenes Ergebnis, wenn man so will …

Marcel Dickow: … genau, wir hatten uns natürlich alle erhofft, dass ein bisschen mehr herauskommt. Dort sitzen ja Diplomaten zusammen und Militärs. Die UN-Waffenkonvention ist eine Konvention, die den Krieg nicht verbieten will oder Gewalteinsatz verdammt, sondern den Krieg „verregelt“. Es werden Regeln gefunden, wie sich Militärs zu verhalten haben, welche Waffentypen sie wie einsetzen dürfen. Es ist also kein Abrüstungsforum im klassischen Sinn. Das muss man einfach wissen. Die Idee dabei ist es, Regeln zu finden, wie dieser Typ Waffensystem …

netzpolitik.org: Wir kommen vielleicht mal zu einer konkreten Definition. Sie haben angesprochen, dass die Abkürzung LAWS für Lethal Autonomous Weapon System steht, also tödliche autonome Waffensysteme. An welcher Definition orientiert man sich und warum?

Marcel Dickow: Das genau ist der erste und wichtigste Streitpunkt. Es gibt keine Definition, nur ganz wenige Staaten haben überhaupt nationale Definitionen. Genau gesagt drei: die USA, die Niederlande und

Großbritannien. Worum es genau geht, der Verhandlungsgegenstand ist also unklar …

netzpolitik.org: … und auch umstritten?

Marcel Dickow: Und hochumstritten. Die Bruchlinie geht im Prinzip in der Richtung, dass die einen sagen, wir wollen auf jeden Fall alle existierenden Systeme nicht verbieten oder regulieren, und viele würden sagen: auch nicht die, die sozusagen vor unserer Haustüre stehen, sondern nur die sehr entfernten Systeme. Andere sagen wiederum: Es geht schon um die aktuellen Waffensysteme, zumindest die, die gerade entwickelt werden.

Die Amerikaner haben, finde ich, eine sehr eingängige und verständliche Definition. Sie sagen, es handelt sich um Waffensysteme, die, wenn sie einmal eingeschaltet sind, die Ziele automatisch, also autonom und ohne Einwirkung des Menschen, auswählen und dann auch bekämpfen. Die große Frage ist, wie die Einwirkung des Menschen ist und wie genau man die beiden Komponenten Zielauswahl und -bekämpfung beschreibt. In der Sprache der CCW nennt man das die „kritischen Funktionen“, weil ein Waffensystem natürlich noch ganz andere Funktionen haben kann. Es kann vielleicht autonom navigieren, es hat sozusagen ein Lagebewusstsein, es kann kommunizieren. Das kann natürlich auch autonom geschehen, aber die kritischen Funktionen sind die, bei denen es um die Zielauswahl und den Waffeneinsatz geht. Das ist wichtig, weil es in der CCW um humanitäres Völkerrecht geht.

Die neue Qualität dieser Waffensysteme

netzpolitik.org: Es geht also letztlich um den Menschen und wie man ihn behandelt …

Marcel Dickow: Genau, und vor allem, wie man ihn schützt. Natürlich ist der Mensch im Krieg unter bestimmten Voraussetzungen ein legitimes Ziel, wenn er ein Kämpfer, also ein „Kombattant“ ist. Diese Voraussetzungen muss natürlich ein Mensch, also ein Kommandeur einer Einheit oder eines Waffensystems, einschätzen können. Die neue Qualität dieser Systeme ist, dass diese Einschätzung möglicherweise durch die Maschine gemacht werden kann und nicht allein durch den Menschen. Das ist natürlich ein sehr schwieriges Konzept, weil die Maschinen wahrscheinlich – würde ich sagen – gar nicht in der Lage sind, solche menschlichen Einschätzungen und Konzepte irgendwie umzusetzen, weil sie nicht verstehen, um was es geht.

netzpolitik.org: Es ist natürlich ein anderes Weltbild, was man einem Computer mitgeben würde und was ein menschlicher Soldat hätte. Ich versuche noch einmal eine Abgrenzung: Bei einem Drohnensystem hat man einen Menschen, der irgendwo den Befehl gibt. Technisch könnte man eigentlich auf diesen Menschen verzichten, das wird aber derzeit nicht getan, zumindest nicht, dass wir davon wüssten. So grenzt man diese von vollständig autonomen Systemen ab. Dennoch gibt es ja solche, also etwa Waffenabwehrsysteme, die schon lange montiert sind, die etwa heranrasende Raketen abwehren könnten, wofür der Mensch zu langsam wäre. Wie ist Abgrenzung, beziehungsweise wo liegt der Streitpunkt?

Marcel Dickow: Viele Staaten beziehen sich darauf, die einen Systeme, zum Beispiel die Defensivsysteme, automatisiert oder hochautomatisiert zu nennen, und meinen damit wahrscheinlich, dass diese Systeme sehr einfachen Logiken folgen. Wenn ein Projektil heranfliegt, schaut man sich Richtung und Geschwindigkeit an und hat vielleicht noch eine automatisierte Freund-Feind-Kennung. Und dann gibt es einen Angriff auf dieses Projektil oder nicht.

netzpolitik.org: Ohne, dass ein Mensch darin eingreift, nicht wahr?

Marcel Dickow: Genau, ohne, dass ein Mensch dabei eingreift. Aber die Parameter des Ganzen, also des Systems und auch der Umwelt, in der das System agiert, sind sehr einfach gestrickt. Im Luftraum gibt es beispielsweise keine Hindernisse, es ist vielleicht ein militärisches Sperrgebiet oder eine Konfliktzone, es gibt keine Zivilisten und so weiter. So ist dieses System zwar komplex, folgt aber einfachen Regeln. Das würden viele als automatisiert oder hochautomatisiert bezeichnen, während autonom eben ein System ist, das sehr viel kompliziertere Entscheidungen trifft …

netzpolitik.org: … muss es sich auch selbst bewegen können?

Marcel Dickow: Nicht notwendigerweise. Es muss natürlich irgendwie mit seiner Umwelt interagieren können, aber der Waffeneinsatz ist ja auch eine Art der Interaktion. Es muss sich nicht bewegen können, aber natürlich ist Autonomie ein Enabler, um sich in einer komplexen Umgebung bewegen zu können. Vieles kann man aus unterschiedlichsten Gründen, auch technischen, nicht per Fernsteuerung machen. Und da ist es gut, wenn das System bestimmte Dinge von sich aus kann, wie zum Beispiel navigieren und sich bewegen, Hindernissen ausweichen und so weiter.

Tödliche Schwarmintelligenz?

netzpolitik.org: Jetzt haben wir als Vergleich die Drohnen genommen, klar militärische Produkte, oder man kann sich auch Kettenfahrzeuge vorstellen, die Waffensysteme montiert haben. Bevor das Treffen in Genf losging, gab es ja nun diesen viralen Videoclip, in dem man sehr viel kleinere Systeme sieht, die man gar nicht mit militärischen Systemen assoziieren würde, die sich vor allem durch sehr billige Produktionsweise und sehr große Beweglichkeit auszeichnen, die im Film aber auch teilweise mit einer gewissen Schwarmintelligenz gezeigt werden. Wir wissen natürlich, dass militärische Systeme existieren, die schwarmintelligent sind, die auch schon vorgeführt wurden. Wie ändert sich aber die Diskussion dadurch, dass die Systeme, über die man heute spricht, billiger und kleiner und damit auch nicht mehr auf militärische Akteure beschränkt sind?

Marcel Dickow: Für die Militärs dieser Welt ist das natürlich eine große Chance. Da entstehen Möglichkeiten, die man vorher nicht hatte. Für die Regulierer macht es das nicht einfach, weil es keine klare Trennung mehr zwischen klassischer militärischer Technologie und ziviler Technologie gibt – etwas, das wir aus dem Cyberbereich ohnehin kennen. Das ist nicht ganz neu, aber tatsächlich ist das eine große Herausforderung. Es steht vielen anderen zur Verfügung. Wir können diese Quadrokopter natürlich im Laden kaufen oder im Internet bestellen.

Die Technologie unterscheidet sich nicht großartig von der, die eine Streitkraft einsetzen würde. Das ist definitorisch nicht so einfach. Wir sehen da eine neue Entwicklung, die wir aus der Militärtechnologie so noch nicht kennen. Wir beobachten bei dieser Technologie, dass nicht mehr die klassischen Rüstungsfirmen die Treiber sind, sondern die zivilen Unternehmen. Wenn wir dann in den Bereich der Software schauen, die für diese Waffensysteme natürlich eine große Rolle spielt, auf Künstliche Intelligenz, datengetriebene Methoden überhaupt, Big-Data-Analyse, maschinelles Lernen und so weiter, dann sehen wir, dass die ganzen Entwicklungen im zivilen Bereich stattfinden.

Das heißt: Wir haben es mit einer Technologie zu tun, die sich sehr schnell verbreitet, die von vielen Experten in vielen Ländern beherrscht wird, die die Militärs sich jetzt zu Nutze machen wollen und bei der wir im zivilen Bereich schon Schwierigkeiten haben, sie irgendwie einzugrenzen: wo gerade die Diskussionen laufen, was wir eigentlich Algorithmen überlassen wollen und was nicht. Und das spiegelt sich im militärischen Bereich wider.

Ziehen die großen Staaten mit?

netzpolitik.org: Sie haben am Anfang schon erklärt, wie der Prozess überhaupt entstanden ist und dass es einen gewissen Sprung zwischen 2016 und 2017 gab, weil die Arbeitsgruppe eingesetzt wurde. Aber Sie haben eben auch gesagt, dass das Ergebnis noch nicht so richtig zufriedenstellend sei, weil man inhaltlich keinen wirklich großen Schritt gemacht hätte. Von anderen Waffengattungen, vor allem von Cluster-Waffen oder Landminen wissen wir, dass es einen anderen Weg gibt, außerhalb dieser UN-Konventionen. Man nennt es „Sidelining“, wenn man quasi einen anderen Weg geht. Glauben Sie, dass es bei dieser Art Waffen wahrscheinlich ist, dass man über diese Arbeitsgruppe nicht zu einem Weg kommt, sondern sich vielleicht nur austauscht und am Ende doch wieder dieses Sidelining probiert?

Marcel Dickow: Also das ist nicht ausgeschlossen. In der Kampagne gibt es eine große Frustration darüber, wie langsam der Prozess ist, dass von Treffen zu Treffen, von Jahr zu Jahr, immer wieder dieselben Dinge diskutiert werden und es politisch nicht vorangeht. Viele Staaten teilen diese Frustration, vor allem die, die für eine Regulierung sind. Die anderen, die sich dafür nicht erwärmen können, sind natürlich ganz froh, dass die Diskussionen in diesem Gremium relativ langsam verlaufen und keinen Fortschritt haben.

Es ist also nicht ausgeschlossen. Normalerweise braucht man einen Staat oder eine Staatengruppe, die dieses Sidelining betreibt, die sagt: „Okay, wir gehen jetzt aus diesem UN-Diskussionsformat und machen ein eigenes Diskussionsformat auf.“

Die große Frage ist: Ziehen die großen Staaten, also die, die Interesse an dieser Technologie haben, mit? Und da sehen wir unterschiedliche Beispiele. Beim Ächtungsvertrag für Nuklearwaffen sind die Nuklearwaffenstaaten eben nicht mitgezogen. Bei den Landminen gab es Staaten – wie die Bundesrepublik zum Beispiel, die Landminen hat –, die haben aber mitgemacht, und andere, wie die USA, haben nicht mitgemacht. Und dann gab es aber auch Verträge innerhalb der UN-Waffenkonvention, wo tatsächlich alle mitgemacht haben. Als es in den siebziger Jahren darum ging, Blendlaser zu verbieten, da haben tatsächlich alle mitgemacht.

netzpolitik.org: … aber Blendwaffen kann man heute als geächtet betrachten …

Foto: Dainomite, Creative Commons BY 3.0.

Marcel Dickow: … genau, also nicht Laser an sich, sondern Laser, die dazu eingesetzt werden, Menschen zu blenden, sind da verboten. Und das beschreibt sehr gut die Funktionsweise dieser UN-Waffenkonvention. Es geht also nicht um ein Verbot von Technologie, sondern um das Verbot oder die Regulierung des Einsatzes einer bestimmten Technologie.

netzpolitik.org: Sie haben es eben schon angesprochen: Wenn man diesen „Sidelining“-Pfad nehmen würde, hat man in der Regel die großen Länder wie China, Russland, die USA nicht mit drin. So ist es bei Landminen, so ist es bei Cluster-Munition ja leider auch. In den letzten Jahren ging es auch darum, dass diese Staaten selber sagen, sie haben keine LAWS, also sie nutzen diese autonomen Waffensysteme noch nicht. Hat sich das geändert?

Marcel Dickow: Also die Technik schreitet voran. Die Frage ist eben, wie definiert man es.

„Nach der britischen Definition gibt es keine LAWS“

netzpolitik.org: Nach ihren eigenen Definitionen, die Sie erwähnt haben – die „Pentagon-Definition“ –, sagen die großen Militärnationen, dass sie selbst diese Waffenarten schon haben oder kaufen wollen?

Marcel Dickow: Nein, es gibt keinen Staat, der sich so öffentlich dazu bekannt hat, diese Waffen anzustreben. Die Amerikaner sind mit ihrer eigenen Definition ein bisschen vorsichtig. Sie haben sie witzigerweise dieses Jahr überhaupt gar nicht benutzt. Sie stellen auch fest, dass diese eigentlich gute Definition sie selbst inzwischen an den Rand der Definition treibt, also dass sie selbst an Waffensystemen arbeiten, die diese Definition möglicherweise erfüllen könnten. Andere, wie zum Beispiel die Briten, setzen eine so hohe Definition an, also ein System, das quasi menschliche Intuition hat und den Menschen in seinen Fähigkeiten mehr oder weniger vollständig abbildet, dass wir das in den nächsten Jahren, Jahrzehnten vielleicht auch nie erreichen können.

Nach der britischen Definition gibt es tatsächlich keine LAWS, und es wird sie auch nicht geben. Und deswegen braucht man sie auch nicht zu regulieren. Das ist der Trick hinter dieser sehr weitgehenden britischen Definition.

Die Chinesen haben sich dem ein Stück weit angeschlossen. Das löst aber natürlich nicht das Problem. Denn das Problem ist ja: Haben wir Waffensysteme, wo der Mensch nur noch eingeschränkt oder gar keine Kontrolle mehr hat? Wenn man sich mal von dieser definitorischen Frage löst und sagt, da haben wir Probleme, dann wäre ja der andere Ansatz – sozusagen die beiden Seiten derselben Medaille – auf der einen Seite die Autonomie, auf der anderen Seite die menschliche Kontrolle. Wenn wir also die Autonomie nicht geschickt definieren können, dann könnten wir aber definieren, wie groß oder in welcher Form die menschliche Kontrolle noch vorhanden sein muss. Dieses Konzept haben die NGOs eingebracht und gesagt, wir wollen einfach sicherstellen, dass immer bedeutende menschliche Kontrolle vorhanden sein muss. „Meaningful human control“ ist der Begriff, den sie da benutzt haben. Er besagt: Die Systeme dürfen nicht so schnell und nicht so autonom sein, dass der Mensch nicht mehr versteht und auch nicht mehr eingreifen kann. Da hat sich dann natürlich ein Streit entwickelt: Was heißt eigentlich „meaningful“? Also wie bedeutend muss „bedeutend“ sein? Und was heißt menschliche Kontrolle? Denn es gibt viele Staaten, die sagen, wenn man im Vorfeld alle Unwägbarkeiten abgeprüft hat, dann ist das genug an menschlicher Kontrolle, dann kann das System von dort aus von allein loslaufen. Das verkennt im Grunde genommen eine typische Konfliktsituation, in der der Gegner es zum Beispiel darauf anlegt, die Parameter so zu verändern, dass man selbst überrascht ist.

Die Frage der menschlichen Kontrolle ist im Mittelpunkt, und es gibt die Idee, das zum Teil des humanitären Völkerrechts zu machen. Es einfach als Norm zu setzen: Es braucht immer menschliche Kontrolle. Das war bisher klar, weil es diese Systeme noch nicht gab. Aber jetzt stellt sich diese Frage.

netzpolitik.org: Sie haben jetzt immer angesetzt bei dieser Kontrolle, das liegt ja auch an der Definition. Aber nun könnte man ja auch sagen: Es wird ganz sicher Formen von Waffensystemen geben, wo der Mensch einfach zu langsam wäre, die vor allem gegeneinander kämpfen. Wie kommt es, dass man nicht auch ansetzt beim Ziel? Also dass man unterscheidet nach der Art, worauf geschossen wird? Ziele ich darauf ab, ein Maschine zu eliminieren, die mein Gegner hat, oder ziele ich auf Menschen? Dabei wäre zu unterscheiden zwischen Kombattanten und Zivilisten. Warum setzt man da an, wo die Kontrolle ist, und nicht vielleicht auf die Zielparameter?

Marcel Dickow: Also das kann man natürlich machen, es hat aber ein paar Nachteile. Dass es dieses L in Lethal Autonomous Weapon Systems gibt, kommt natürlich daher, weil wir über humanitäres Völkerrecht reden. Es geht hier um den Schutz des Menschen, deswegen geht es um letale Systeme. Das ist der eine Punkt. Man könnte natürlich sagen, solange diese Systeme nur auf Objekte zielen, ist das auch alles kein Problem. Die Schwierigkeit hierbei ist – bis auf ein paar Waffensysteme, die tatsächlich nur auf Objekte gerichtet werden können –, dass es ja nicht klar ist, ob in diesen Objekten zum Beispiel Menschen drin sind oder nicht. Natürlich kann man mit einer Bombe ein Haus oder ein Gebäude zerstören. Aber ob da jemand drin ist oder nicht, ist eben genau die Frage, die ein Kommandeur einschätzen muss, bevor er diese Waffe einsetzt.

Man kann den Menschen nicht aus der Gleichung eliminieren. Deswegen reden wir hier über humanitäres Völkerrecht. Auf der anderen Seite ist das humanitäre Völkerrecht nur ein Teil der Problematik. Die andere Problematik ist natürlich: Was machen diese Waffensysteme eigentlich mit dem Krieg? Mit der Hemmschwelle zum Gewalteinsatz? Es geht um die taktische Hemmschwelle, aber auch um die Hemmschwelle, überhaupt in den Krieg zu ziehen, also die politische Hemmschwelle. Da gibt es ganz viele sicherheitspolitische Argumente: Könnte das zu mehr Instabilität führen? Können Krisen dadurch eskalieren, dass sich Maschinen gegenüberstehen und nicht Menschen? Wie verändert es die Natur des Krieges und ob es zum Krieg kommt? Das sind nicht Fragen des humanitären Völkerrechts, sondern es sind sicherheitspolitische Fragen. Und die finden in der Debatte in der CCW so nicht statt, weil sie eben diese Ausrichtung auf das humanitäre Völkerrecht hat.

netzpolitik.org: Obwohl die Mitglieder ja nicht alle Juristen sind, sondern divers, sie sind ja teilweise aus dem Militär?

Marcel Dickow: Ein überwiegender Teil davon sind Juristen. Da schicken ja durchaus die Hauptstädte die Vertreter aus den Verteidigungsministerien hin, die dann wiederum auch meistens Juristen sind. Denn auch die haben natürlich eine Rechtsabteilung. Aber tatsächlich: Es sind nicht alles Juristen. Es sind auch aktive Militärs dabei. Es sind natürlich Experten dabei und es ist die Zivilgesellschaft dabei. Das unterscheidet diesen Prozess sehr stark von anderen im Bereich der Vereinten Nationen, dass die Zivilgesellschaft hier nicht nur als Beobachter, sondern auch als Teilnehmer dabei ist. Das ist auch der Grund, warum ich in Genf dabei sein und das beobachten konnte. Das gibt der ganzen Sache natürlich auch eine gewisse Glaubwürdigkeit. Und die Staaten werden durch die Zivilgesellschaft auch immer wieder daran erinnert, dass sie eine Verpflichtung haben, sich diesen Problemen zu stellen.

„Wie autonom ist ein System?“

netzpolitik.org: Nun beschäftigen Sie sich ja schon länger mit dem Problem, und Sie haben dazu auch veröffentlicht. Wir haben die rechtliche Seite, wir haben die politische Seite, wir haben natürlich auch den Kostenfaktor, worüber in letzter Zeit relativ viel gesprochen wird, einfach durch diese Quadrokopter und die billige Technik. Und dann haben wir sicherlich auch noch militärstrategische Aspekte. Sie haben den Ansatz, dass Sie sagen: Wir müssen die Empirie reinholen und uns tatsächlich überlegen, wie wir die Effizienz von solchen Waffensystemen messen. Und Sie haben verschiedene Systeme verglichen und versucht, dafür eine Art Schema zu entwickeln. Das sind sehr große Waffensysteme, die Sie da teilweise betrachten, also etwa den Eurofighter („Jäger 90“). Warum haben Sie sich dafür entschieden, empirische Daten reinzuholen, und was würden Sie sich davon versprechen für eine mögliche Regelung in der Zukunft?

Marcel Dickow: Wir haben festgestellt, dass es extrem schwierig ist, Autonomie zu definieren. Wie autonom ist ein System? Und gleichzeitig haben wir gemerkt, dass das Risiko von einem solchen System – oder wenn man es von einer anderen Seite betrachtet, der Gewinn eines solchen Systems – nicht nur vom Grad der Autonomie abhängt, sondern auch davon, wie militärisch fähig das System ist. Wie schnell kann es sich bewegen, fliegen? Welche Reichweiten hat es? Wie lange kann es im Einsatzgebiet bleiben? Wir haben dann versucht, so eine Art Matrix zu entwickeln, wo all diese Parameter eingehen, und haben dann versucht, die einzelnen Parameter gegeneinander zu gewichten. Nicht um zur Einschätzung zu gelangen, wie gefährlich oder wenig gefährlich ein System ist, sondern einfach, um Politikern ein Instrument an die Hand zu geben: Wie verhalten sich unterschiedliche Parameter in so einer Gleichung. Einfach damit man ein bisschen spielen kann, deswegen haben wir es auch ein Einschätzungstool genannt. Es liefert keine Zahl, mit der man am Ende einen Beweis antreten kann, aber es gibt unter den gegebenen Parametern den Politikern zum Beispiel die Möglichkeit, relativ leicht auszurechnen, wie viele Gedanken sie sich vielleicht machen sollten oder ab welcher Schwelle sie sich Gedanken machen sollten. Ob ein System autonom genug ist, um unter diese Kategorie letale autonome Waffensysteme zu fallen.

Das ist kein perfektes Tool, es löst auch keine Probleme, aber es soll den Politikern vor allen Dingen ein Instrument an die Hand geben, so eine Einschätzung zu treffen. Wir haben da ganz unterschiedliche Sachen miteinander verglichen, und wir haben auch ganz bewusst den Eurofighter als ein bemanntes System reingenommen, weil wir gesagt haben: Oft spielt für ein Waffensystem gar nicht so groß die Rolle, ob der Mensch noch im Cockpit sitzt oder nicht, weil die ganzen Assistenzsysteme, die den Menschen unterstützen, schon so fortgeschritten sind, dass die Maschine eigentlich ganz viel allein machen kann.

netzpolitik.org: Der Graubereich wäre: Hier entscheidet zwar der Mensch noch, man bekommt aber so viel Input, den man sowieso nicht mehr selber verarbeiten könnte. Der Graubereich wird uns wahrscheinlich in der Zukunft begleiten.

Marcel Dickow: Ja, genau. Den sieht man natürlich im zivilen Leben genauso, also die Autos werden auch immer autonomer in dem Sinn, dass sie immer mehr Assistenzsysteme haben.

netzpolitik.org: Aber sie schießen nicht!

Marcel Dickow: Aber sie schießen nicht.

netzpolitik.org: Aber Sie können natürlich auch jemanden umbringen mit einem Auto, wenn Sie einen Fehler machen als Programmierer oder als Hersteller.

Marcel Dickow: Genau. Da gelten natürlich andere rechtliche Rahmenbedingungen. Aber tatsächlich unterscheiden sich da die zivilen und die militärischen Systeme in den Fragen, die sie für uns aufwerfen, gar nicht so sehr. Es geht immer darum: Welche Beziehung hat Mensch und Maschine? Wie ist der Mensch in der Lage, die Maschine zu kontrollieren? Wie viel von seiner Entscheidungsfähigkeit will er abgeben? Wie weit verlässt man sich auf die Maschine? Diese Fragen tauchen im Zivilen wie im Militärischen natürlich auf.

netzpolitik.org: Jetzt haben Sie in dem einen Papier, was Sie darüber geschrieben haben, die Positionen der Kritiker und Befürworter beschrieben. Es gibt da auch Graubereiche, man kann die sicherlich nicht schwarz-weiß abgrenzen. Aber die eine Seite sagt: Die Kritiker ignorieren zu stark die Vorteile, die solche Waffensysteme bringen können, im Sinne von Leben retten. Dass eine Maschine eben keine Emotionen hat, keine Angst und Stress-Situationen. Sie seien Ludditen, so haben Sie es genannt. Die andere Seite wirft insbesondere dem Militär und den Herstellern vor, dass sie zu kurzfristig denken, dass man aber darüber nachdenken müsse, welche ethischen Dilemmata eigentlich langfristig entstehen und wie das Verhältnis zwischen Mensch und Maschinen ist. Wo würden Sie sich da selber positionieren in diesem Feld?

Marcel Dickow: Ich sehe die militärischen Vorteile, also größere Geschwindigkeit, vielleicht auch größere Präzision an der einen oder anderen Stelle, man kann in derselben Zeit mehr Daten verarbeiten und vielleicht dadurch auch besseres Wissen erzeugen, also genaueres Wissen. Diese Vorteile sehe ich durchaus. Aber die Gefahr, die mir da zu sein scheint, ist doch, dass der Mensch die Kontrolle verliert über die Systeme, die er einsetzt, und dass er zuviel aus der Hand gibt und eben möglicherweise gar nicht an die super-intelligenten Systeme der ferneren Zukunft, sondern dass er das jetzt schon macht bei Systemen, die eben nicht in der Lage sind, eine Situationen einschätzen zu können und so zu agieren, wie der Mensch agieren würde.

Von daher bin ich ein Skeptiker, wenn es darum geht, Entscheidungen – vor allen Dingen über Leben und Tod – von Menschen an Maschinen zu delegieren. Ich glaube, der Mensch ist eben das einzige Wesen, das das Konzept Leben und Tod verstehen kann.

Maschinen können das nicht. Und deswegen sollten sie auch nicht – das ist die ethische Form des Arguments – solche Entscheidungen treffen können, weil die Maschinen eben gar nicht die Konsequenzen ihrer Entscheidung verstehen können. Das ist das, was den Mensch und die Maschine noch unterscheidet, und da sollten wir uns sehr bewusst sein, dass wir diese Entscheidungen auch beim Menschen belassen.

„Lieber zu den Googles und Facebooks dieser Welt als zu den Lockheed Martins und Boeings“

netzpolitik.org: Ich denke, wir werden eine ähnliche Diskussion auch im Zivilen haben. Eine Maschine kann keine Verantwortung übernehmen, das kann eben nur der Mensch. Kennen Sie das Buch „Kill Decision“ von Daniel Suarez? Darin gibt ein fiktives Szenario, wo autonome Waffensysteme fliegen können und sich in Drohnenschwärmen bewegen. Ich war daran erinnert, als ich kurz vor dem Genfer Meeting den Film der Kampagne gegen Killer-Roboter sah. Sie forschen ja schon eine Weile dazu: Haben Sie schon mal vor einem „Killer-Roboter“ gestanden? Haben Sie diese technischen Systeme, die es gibt, gesehen? Haben Sie Kontakte mit den Herstellern, trifft man da auch mal diejenigen, die solche Systeme produzieren?

Marcel Dickow: Nein, ich habe noch nicht vor einem solchen System gestanden. Es gibt sie ja auch noch nicht, zumindest sind sie noch nicht eingesetzt. Ich habe mal aus der Entfernung ein Patriot-Abwehrraketensystem gesehen, das diesen automatischen Modus hat. Aber das ist ein defensives System, was sehr einfachen Mechanismen folgt, da würden wir wahrscheinlich eher von hochautomatisiert sprechen, aber nicht von autonom. Natürlich trifft man auf solchen Konferenzen Wissenschaftler, die zum Beispiel an Künstlicher Intelligenz forschen, die man auch dafür benutzen kann. Ich rede zum Beispiel mit deutschen Herstellern darüber, die sich gerade Gedanken machen, wo Autonomie in ihren zukünftigen Waffensystemen eine Rolle spielen könnte. Ich habe das Gefühl, dass da die deutschen Hersteller noch nicht so weit sind wie vielleicht manche in den Vereinigten Staaten.

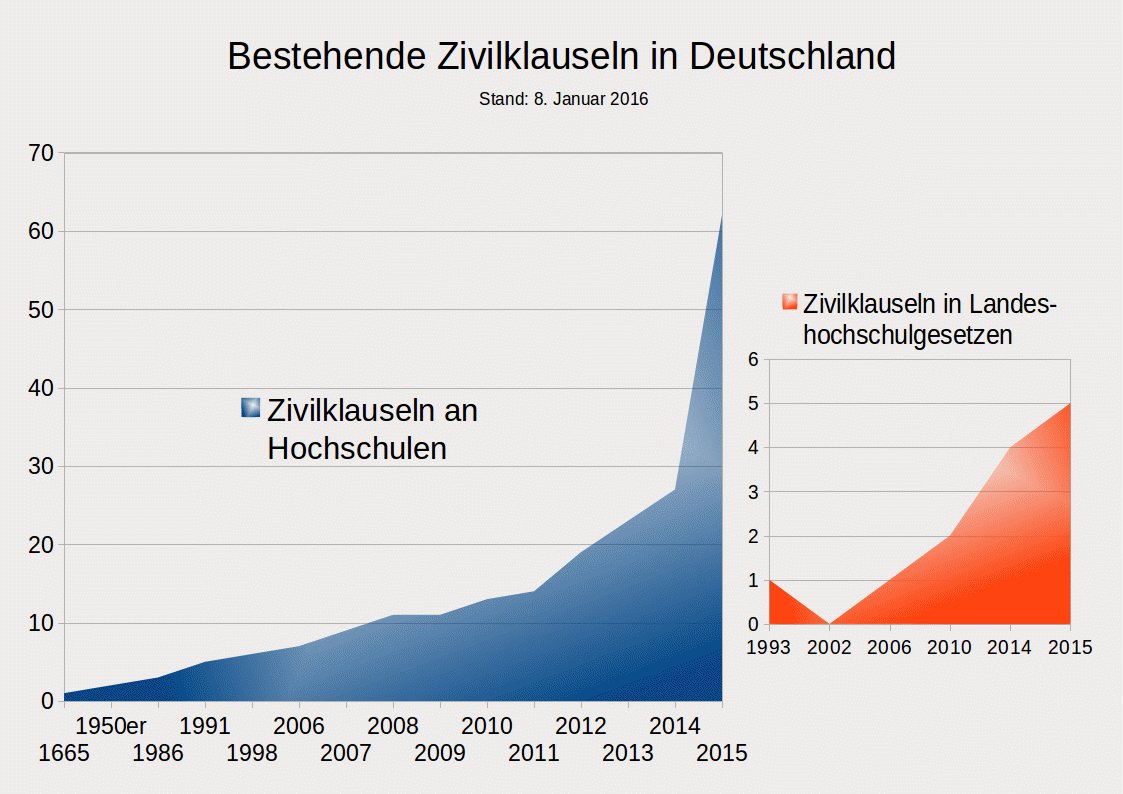

Das Spannende an diesen technologischen Entwicklungen ist, dass die Militärs, genauer gesagt die Rüstungshersteller, mittlerweile eindeutig hinter der zivilen Technologie hinterherhinken. Sie haben sogar Schwierigkeiten, die entsprechenden Experten zu bekommen, denn die meisten von denen gehen aus unterschiedlichen Gründen lieber zu den Googles und Facebooks dieser Welt als zu den Lockheed Martins und Boeings. Insofern ist das tatsächlich für die Hersteller eine Herausforderung, und das merkt man auch. Viele dieser Entwicklungen passieren deswegen nicht in den Laboren der Hersteller, sondern in den Laboren der Universitäten und Instituten. In den USA sind diese eben deutlich dichter dran am Pentagon und werden deutlich stärker mit Mitteln aus dem Pentagon oder aus der DARPA, der Forschungsorganisation des Pentagons, bezahlt, als das in Europa der Fall ist. Nichtsdestotrotz gibt es in Deutschland die Fraunhofer-Institute, die an einigen Stellen auch an solchen Themen forschen. Diese wird dann natürlich auch aus staatlichen Mitteln bezahlt.

(Quelle: zivilklausel.de.)

Marcel Dickow: Ich glaube, das wird passieren. Ob das ein großes Problem ist, werden wir noch sehen. Die Meinungen gehen ja auch weit auseinander, ob Terror ein Riesenproblem ist oder nicht. Wenn man die nackten Zahlen anschaut wahrscheinlich nicht, politisch gesehen aber schon sehr. Die Technologie ist da und es ist überhaupt kein Problem, sich bei Amazon oder bei irgendeinem anderen Onlinehändler einen Quadrokopter zu kaufen und ihn mit einer Sprengladung zu bewaffnen.

netzpolitik.org: Na gut, die Sprengladung ist schon schwieriger zu bekommen als der Quadrokopter.

Marcel Dickow: Das wollen wir hoffen. In den Vereinigten Staaten zum Beispiel ist es aber überhaupt kein Problem, eine Pistole oder ein Gewehr zu bekommen, und es gibt Quadrokopter, die groß genug sind, eine Pistole zu tragen. Und den Rest kann man sich denken. Das gibt es und das werden wir wahrscheinlich auch irgendwann sehen.

Der IS hat solche kommerziellen Drohnen eingesetzt und mit Sprengladungen ausgerüstet. Das fällt natürlich unter keine Regel, weil diese Akteure eben keine regulären Kriegsteilnehmer sind und sich deswegen natürlich nicht an das humanitäre Völkerrecht gebunden fühlen. Dann ist es die Verpflichtung der Staaten, dafür zu sorgen, dass diese Akteure das nicht einsetzen. Aber wie wir alle wissen, ist das quasi unmöglich. Die große Idee, die dahintersteht, ist es, eine Norm zu schaffen. Diese Norm ist auch dann stark, wenn sie von manchen gebrochen wird, solange genug andere sie aufrechterhalten und sie vor allem auch verteidigen im Sinne von: „Wir finden es richtig, dass wir solche Systeme ächten und sie regulieren.“

netzpolitik.org: … und Übertretungen auch versuchen zu ahnden …

Marcel Dickow: … und Übertretungen auch versuchen zu sanktionieren, soweit das geht. Im Anti-Terror-Kampf sind das dann polizeiliche Maßnahmen oder die Staaten finden sich zusammen und versuchen, gemeinsam dagegen vorzugehen. Beim IS hat man das ja gesehen, wo es eine Koalition gab und wo es vorher schon eine Resolution des Sicherheitsrats gab, die die Staaten auffordert, auf entsprechende Art und Weise mit Terrorismus umzugehen.

Das alles gibt es und man kann eine Norm schaffen, die im Grunde genommen sagt: „Behaltet die Kontrolle über eure Waffensysteme, übergebt den Systemen nicht die Kontrolle und die Entscheidungsfindung über Leben und Tod.“ Das werden natürlich trotzdem einige missbrauchen, völlig klar. Aber es wäre trotzdem sinnvoll, diese Norm zu schaffen, weil dann die Staaten auch selbst den Anreiz haben, das bei substaatlichen Akteuren zu unterbinden.

netzpolitik.org: Um zuletzt noch einmal auf den Anfang zurückzukommen: Sie hatten erwähnt, dass der ganze Prozess durch starke Initiativen von NGOs und vor allem durch Noel Sharkey, der sehr aktiv war, in die Wege geleitet wurde. Sie haben sich auch selber positioniert, also wie ihre eigene Haltung ist. Sie sind damit quasi argumentativ ähnlich wie die Mehrzahl der Bevölkerung. Die Deutschen gelten ja ohnehin als nicht besonders militärfreundlich, sondern stehen Friedensinitiativen und Waffenbeschränkungen sehr positiv gegenüber. Was würden Sie sich wünschen? Was könnte eine aktive Öffentlichkeit tun, um möglicherweise diesen Prozess zu beschleunigen? Ein Grund, warum wir darüber reden, ist auch, dass relativ wenig darüber berichtet wurde, dass es diese Gruppe und dass es überhaupt Verhandlungen gibt, anders als zum Beispiel bei der Ächtung von Landminen, wo es aus meiner Sicht eine große Öffentlichkeit gab. Was würden Sie sich wünschen, was eine aktivere Öffentlichkeit tun könnte?

Marcel Dickow: Ich glaube gar nicht so sehr in Bezug auf die militärischen Systeme, aber die zivilen Systeme: Sie werfen ja ähnliche Fragen auf, also die Frage des Kontrollverlusts, der Haftbarkeit, der Verantwortlichkeit, die werden uns ja in den nächsten Jahren sehr stark begegnen. Spätestens, wenn die ersten Autos autonom fahren, werden Unfälle passieren, an denen plötzlich die Maschinen beteiligt sind und nicht nur der Mensch. Wir werden uns mit diesen Fragen auseinandersetzen müssen, so oder so. Ich würde mir wünschen, dass wir das jetzt schon tun. Gern auch einfach im zivilen Bereich, so dass wir uns im Klaren sind, was diese Technologie mit uns und unserem Alltagsleben macht und wo wir unsere Grenzen setzen. Wo wir zum Beispiel nicht wollen, dass die Maschine, sondern dass der Mensch eine Entscheidung trifft.

Das klassische Beispiel sind Systeme, die einen Arzt bei einer Operation oder bei einer Diagnose unterstützen. Was wir nicht wollen: dass die Maschine die Diagnose trifft, sondern dass der Mensch das macht und am Ende noch einmal drüberschaut und seine eigene Einschätzung macht und das letzte Wort hat. Solche Prozesse, solche „Verregelungen“, wie wir mit der zivilen Technologie umgehen, die sollten wir uns bewusst machen. Sie würden dann wahrscheinlich auch – so oder in ähnlicher Form – auf die militärischen Systeme übertragen.

Das scheint für mich die rote Linie zu sein, die ich nicht überschreiten würde. Und sich darüber Gedanken zu machen, würde mir sehr sinnvoll erscheinen. Dann würde der ganze Prozess um die Lethal Autonomous Weapon Systems, also die militärischen Anwendungen, auch sehr viel schneller gehen, wenn wir uns im Zivilen schon mit dieser Technologie auseinandergesetzt haben.

netzpolitik.org: Dann sind wir mit diesem netzpolitik.org-Podcast auch Teil davon, denn man kann sich ja informieren und auch eine eigene Meinung bilden. Ich bedanke mich sehr herzlich für Ihre Auskünfte. Ich bedanke mich auch bei den Hörern und Lesern.

Oh, ist das grotesk!

Dass man über sowas so ernsthaft reden kann, ohne dass dabei ständig ein Gelächter eingespielt wird.

Willkommen in Dystopia!

Erklaer‘ mal, was Du meinst.