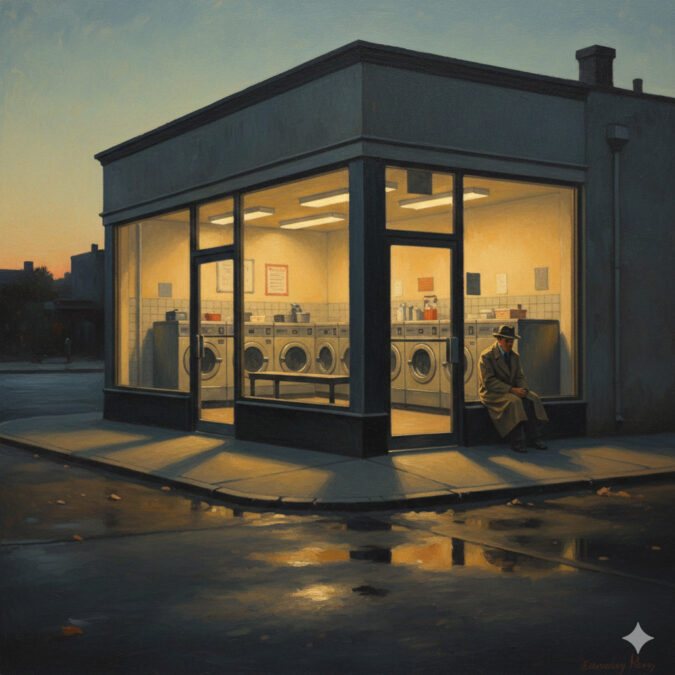

Eines der ersten Bilder, das ich mit „generativer KI“ erstellt habe, war ein Waschsalon im Stil von Edward Hopper. Das Motiv entspricht dem US-amerikanischen Maler sehr: ein halb-öffentlicher, halb privater Raum; die Stimmung irgendwo zwischen Kontemplation und Melancholie. Aber gemalt hat er es nie. Das KI-generierte Bild hatte das typische Hopper-Gefühl in mir geweckt, ich war begeistert. Bildgeneratoren sind der Anfang von etwas Großem, da war ich mir im Jahr 2022 sicher.

Schon früh war die öffentliche Debatte über Bildgeneratoren begleitet von teils inbrünstigen Einwänden, dass Erzeugnisse von Maschinen doch keine ernst zu nehmenden Gefühle oder Bedeutungen zum Ausdruck bringen könnten. Immerhin berechnet Software ihre Erzeugnisse bloß aus Material, das es bereits gibt; es fehlt also der Wille eines Menschen, etwas auf bestimmte Weise auszudrücken.

Mich überzeugt das nicht. Warum soll das Erzeugnis einer Maschine von Gefühl und Bedeutung entleert sein, das Erzeugnis eines Menschen aber gefühlvoll und bedeutsam? Diese KI-Kritik ist von klassischen Kommunikations-Modellen geprägt, die Sender und Empfänger in den Mittelpunkt rücken. Einfach ausgedrückt packt demnach ein Sender einen gewünschten Inhalt auf einen Kommunikationsträger, der die Botschaft zum Empfänger bringt – etwa per Wort oder Bild. Gerade Künstler*innen können diesem Modell zufolge ihre Kommunikation in Form eines Kunstwerks ganz besonders mit Bedeutung aufladen, weil sie dabei auf geniale Weise wie aus tiefer Seele schöpfen.

Diesem Modell zufolge kann ein KI-erzeugtes Bild schon allein deshalb nichts Sinnvolles ausdrücken, weil die Maschine nichts meinen kann. Das Erzeugnis ist allenfalls ein Klumpatsch von einst bedeutsamen Inhalten, also: KI-Slop.

Spätere Ansätze – von Systemtheorie über Poststrukturalismus – haben jedoch das Modell verworfen, wonach Bedeutung wie ein Päckchen von A nach B transportiert wird. Bedeutung lässt sich demnach auch nicht in einem Bild verpacken, sodass es nur noch beim Betrachten ausgepackt und in Empfang genommen werden muss. Vielmehr lässt sich jede Kommunikation und damit auch jedes Bild als eine Art Remix aus bestehenden Bedeutungsträgern beschreiben. Die konkrete Bedeutung eines Werks wiederum entsteht bei jeder Beobachtung aufs Neue und zwar durch die Betrachtenden. Das heißt, nicht nur jedes Werk ist ein Remix, sondern auch jede Beobachtung eines Werks.

Selbst das Wetter meint etwas – für uns

Insofern fehlt maschinell erzeugten Bildern zwar die menschliche Intention bis ins Detail, die etwa anzunehmen ist, wenn jemand nach jahrelanger Übung gezielt eine Leinwand mit Pinsel und Farbe bearbeitet hat. Gefühl und Bedeutung können KI-Bilder trotzdem haben, und zwar beim Betrachten. Das klappt auch ohne jegliche Intention eines Senders.

Das Prinzip kennen wir alle aus unserem Alltag, und zwar vom Wetter: Auch Sonnenuntergänge, Gewitter oder Wolkenformationen können ins uns eine Menge Gefühle auslösen, obwohl das Wetter nichts meinen kann. Es meint trotzdem etwas – für uns.

Die Grenze zwischen menschengemachten und synthetischen Werken ist weniger klar, als man auf den ersten Blick meinen könnte. Auch ohne Einsatz von Software haben Künstler*innen immer wieder gezielt die Kontrolle über ihre Werke reduziert. So spielen beim Action Painting Zufall und Physik eine wichtige Rolle, wenn Künstler*innen Farben schleudern und spritzen. Im Konstruktivismus wiederum geht es um Berechenbarkeit statt Zufall, wenn Künstler*innen streng auf geometrische Formen setzen.

Die Beispiele zeigen, generative KI ist weniger ein radikaler Bruch im kreativen Schaffen, sondern eher eine neue Verschiebung in der Rolle des Menschen beim Entstehen eines Werks. Statt mit Pinsel und Farbe hantiert man mit Prompts; feilt an Textbefehlen, bis die Maschine etwas erzeugt, das man gerne speichern und weiterverbreiten möchte. Der Stoff, aus dem ein Werk entsteht, ist nicht roh wie etwa eine Tube Ölfarbe, sondern vorgeformt durch das einfließende Trainingsmaterial.

Wie es sich praktisch anfühlt, mit Bildgeneratoren zu arbeiten, habe ich eine Zeit lang selbst getestet. Über Monate hinweg habe ich die Software genutzt, um eigene Artikel zu bebildern. Es war reizvoll, mehr Freiheiten in der Gestaltung der Motive zu haben. Inzwischen habe ich aber damit aufgehört – und ich halte es sogar für besser, wenn Redaktionen die Finger von Bildgeneratoren lassen. Dafür sehe ich vor allem drei Gründe.

1. Der typische KI-Look wirkt unseriös

Nach ein paar Jahren KI-Hype und einer Flut KI-generierter Bilder auf Websites und in sozialen Medien zeigt sich eine Kluft zwischen Theorie und Praxis: Während KI-Bilder meiner Meinung nach bedeutsam, gefühlvoll und schön sein können, sind sie es erstaunlich oft – einfach nicht.

So unbegrenzt wie Anfangs vermutet sind die kreativen Möglichkeiten dann doch nicht. Zumindest Stand aktuell, und mit dem eher geringen Aufwand, den viele in ihre Prompts und KI-Erzeugnisse stecken. An einem Großteil der tatsächlich in meinen Feeds kursierenden, KI-generierten Bilder habe ich mich sattgesehen. Sie sind oft überladen und austauschbar, teils offensiv geschmacklos. Einflüsse von Stilrichtungen lassen sich erahnen, sind aber oft grobschlächtig miteinander vermengt, ohne Gefühl für Stimmigkeit. Ein schauriges Beispiel dafür ist das oben eingebettete KI-Bild, das ich leider selbst als Artikelbild veröffentlicht habe, und heute für einen Griff ins Klo halte.

Alles netzpolitisch Relevante

Drei Mal pro Woche als Newsletter in deiner Inbox.

Websites, die auf KI-Bilder setzen, erscheinen mir inzwischen suspekt. Denn in der Praxis nutzen die meisten seriösen Medien solche Bilder nicht oder kaum; fragwürdige Content-Schleudern aber schon.

Egal, wie man sonst zu KI-Bildern steht: Sie können mangelnde Seriosität ausstrahlen. Besonders wenn Leser*innen eine Website nicht gut kennen und nur die Bilder ins Auge springen. Es könnte bei manchen die Frage aufkommen, ob die Redaktion möglicherweise auch ihre Texte achtlos zusammenrührt; wie sorgfältig das redaktionelle Angebot wirklich ist. Die Bebilderung von Artikeln sollte funktional sein und nicht mehr Fragen aufwerfen als die Hauptinhalte.

2. Generative KI schafft bedenkliche Abhängigkeiten

Generative KI gibt Menschen mit Internetverbindung zuvor ungeahnte Produktionsmittel in die Hand. Selbst ohne Vorkenntnisse lassen sich etwa Texte, Übersetzungen, Code, Bilder und Videos in mindestens mittelmäßiger Qualität erstellen. Und wer würde so viele verschiedene Dinge schon mindestens mittelmäßig hinbekommen? Das bedeutet mehr Möglichkeiten und mehr Macht für alle. Aber das ist nur die eine Seite der Medaille.

Die andere Seite ist düster. Je mehr sich generative KI verbreitet, desto mehr zementieren deren Anbieter ihre Machtposition. Als der Bild-Generator Stable Diffusion erstmals gratis für alle veröffentlicht wurde, hatte ich die Hoffnung auf eine dezentrale Zukunft generativer KI ohne mächtige Tech-Unternehmen als Nadelöhr. Es kam anders.

Heute kontrollieren einige wenige Unternehmen wie OpenAI, Anthropic, Microsoft, Meta und Google die populären und effizienten KI-Anwendungen. Sie sammeln die Risiko-Milliarden ein, steigen zu den reichsten Unternehmen der Welt auf oder festigen diese Position. Unter der Regie der KI-Konzerne entsteht eine technologische Infrastruktur, die Produktionsweisen zentralisiert. Die Konzerne bestimmen in der Folge, welche KI-Anwendungen kostenlos sind und wofür man zahlen muss. Sie bestimmen, für welche Sprachen, welche gesellschaftlichen Gruppen, welche Einsatzmöglichkeiten ihre Dienste optimiert werden.

Auf rabiate Weise extrahieren KI-Konzerne massenhaft Werke zum Training ihrer Modelle aus dem Netz, selbst wenn die Künstler*innen und Urheber*innen dahinter das nicht möchten. Einerseits finde ich: Zur Freiheit von Kunst sollte es gehören, dass sich Menschen oder auch Maschinen frei an Werken bedienen können, um Neues zu schaffen. Andererseits bereitet mir das extreme Macht-Ungleichgewicht Bauchschmerzen, das besteht, wenn Milliarden-Konzerne diese Freiheit brachial für kommerzielle Interessen ausnutzen.

In der Folge profitieren nicht alle gleichermaßen von den Produktionsmöglichkeiten sogenannter KI. Die neue Technologie kann nicht nur Gewinner*innen hervorbringen, sondern auch Verlierer*innen. Sie birgt etwa das Potenzial, KI-freie Formen künstlerischer oder handwerklicher Bildproduktion allein durch diese Produktionsgewalt zu verdrängen, zu ersetzen und damit unter die Kontrolle weniger Konzerne zu bringen.

Diese Kontrolle bezieht sich nicht nur auf die Gestaltung der KI-Werkzeuge, sondern auch auf die erzeugten Inhalte. Die KI-Konzerne entscheiden und moderieren, was erlaubt und verboten ist. Bei Sprachmodellen wie Grok aus den USA oder DeepSeek aus China sieht man, wie schnell vermeintliche Inhaltsmoderation in autoritäre Zensur und Desinformation umschlägt.

Bei den meisten kommerziellen Bildgeneratoren gibt es zudem sehr hohe Hürden für jegliche Darstellung von Nacktheit. Damit wollen die Konzerne unter anderem verhindern, dass Menschen illegale Inhalte erzeugen, und nehmen dabei Overblocking in Kauf. Die Folge ist, dass selbst jugendfreie Darstellungen zensiert werden, etwa wissenschaftliche oder künstlerische Motive. Zum Vergleich: Sogar in der Sixtinischen Kapelle im Vatikan sind Adam und Eva ohne Kleider zu sehen.

Keine Skrupel haben die KI-Konzerne dagegen offenbar bei Deals über hunderte Millionen US-Dollar mit dem Militär der rechtsradikalen Trump-Regierung.

Die erhoffte Demokratisierung von Produktionsmitteln durch generative KI hat also auch gegenteilige Effekte. Solange Bildgeneratoren von wenigen Konzernen kontrolliert werden, entstehen neue Formen von Abhängigkeit, und zwar von konkreten KI-Modellen und deren Features, von Plattform-Policys, Finanzierungsmodellen und letztlich auch den Launen und Ideologien ihrer superreichen Eigentümer.

Entsprechend unangenehm ist es, etwa einen journalistischen Artikel oder einen Blogbeitrag mit einem Generator von Google oder OpenAI zu bebildern. Der Name dieser Konzerne in der Bildunterschrift: ein unerwünschter Werbe-Effekt.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Auch wenn meine kleinen Beiträge als Nutzer oder Konsument von KI-Bildgeneratoren das Machtgefüge dahinter nicht nennenswert beeinflussen – es muss einfach nicht sein. Gerade wenn Redaktionen ihre Artikel in großem Stil mit KI bebildern, verstetigen sie den Gebrauch fragwürdiger Produkte.

3. Hinter generativer KI stecken hohe, unsichtbare Kosten

Oft sind die wahren Kosten meines privilegierten digitalen Alltags unsichtbar, und bei den meisten Leser*innen hier dürfte es ähnlich sein. Wir tippen, streamen und surfen mit energiehungrigen Produkten aus unter anderem Plastik und Seltenerdmetallen, die durch geplante Obsoleszenz zugleich der umweltschädliche Elektroschrott von morgen sind; produziert und bis zur Haustür gebracht von oftmals schlecht behandelten Angestellten; entworfen und kontrolliert von Megakonzernen, die damit Milliarden anhäufen. Obendrauf kommen jetzt noch die Kosten für generative KI.

Es ist widersprüchlich, an einem Apple-Laptop sitzend von der Nutzung einer Technologie abzuraten, weil sie verborgene Kosten für Gesellschaft und Umwelt mit sich bringt. Denn was ich an generativer KI kritisiere, trifft auch auf meine eigenen Geräte zu. Um davon nicht völlig blockiert zu sein, will ich zwei Ebenen voneinander unterscheiden: einerseits strukturelle Ausbeutungsverhältnisse, andererseits individuelle Konsumentscheidungen. Ersteres lässt sich nicht durch letzteres überwinden. Dennoch sind individuelle Konsumentscheidungen nicht egal. Bildgeneratoren sind noch nicht so tief in unseren Alltag gesickert wie Laptops; sie sind noch kein wichtiger Teil digitaler gesellschaftlicher Teilhabe. Noch haben wir die Wahl.

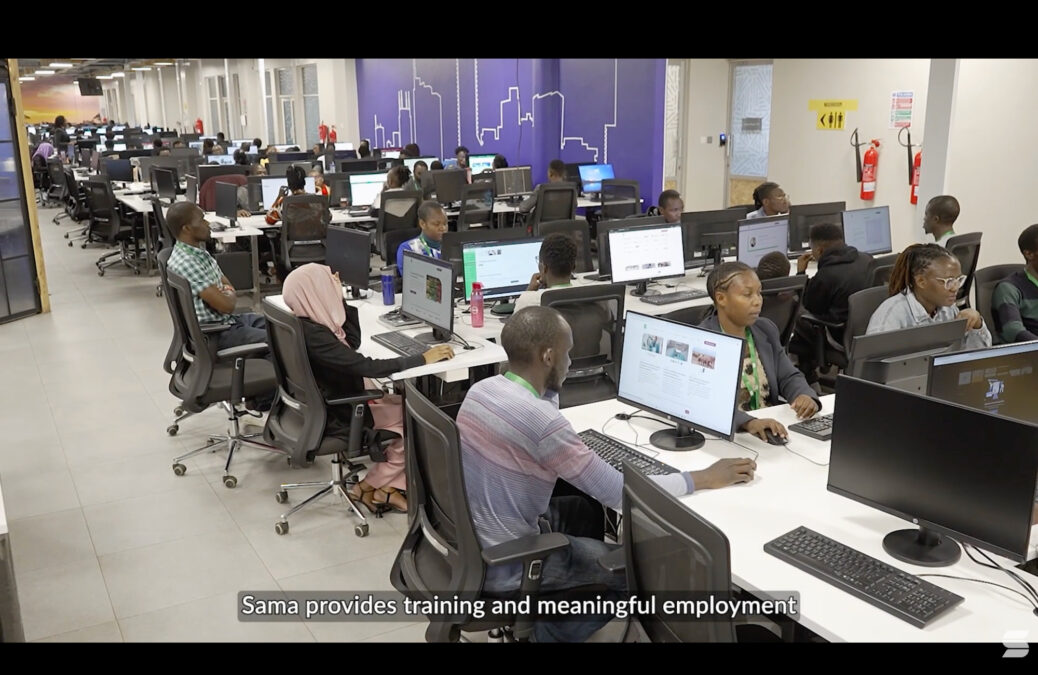

Die Systeme hinter KI-generierten Bildern fressen Energie durch Training und Betrieb und sind deshalb klimaschädlich. Die Konzerne hinter kommerziellen Bildgeneratoren ziehen riesige Rechenzentren hoch, zapfen Atomkraftwerke an und können Menschen im Umland zur Kühlung der Server sogar das Wasser abgraben. Millionen gering bezahlte Arbeiter*innen, oftmals aus dem Globalen Süden, machen durch ihre Arbeit die Leistungen der Software überhaupt erst möglich.

Die menschliche Arbeit hinter sogenannter KI soll nicht nur bewirken, dass generierte Bilder möglichst gut aussehen, sondern auch, dass sie möglichst nicht illegal oder verstörend sind. Gewalt, Folter, Missbrauch – all das sollen Nutzer*innen am Ende nicht zu Gesicht bekommen. Dafür sichten und annotieren Angestellte im Akkord Inhalte, etwa Bilder aus dem Trainingsmaterial oder neue KI-Erzeugnisse. Solche Arbeit ist oftmals psychisch belastend, die therapeutische Begleitung schlecht. Für ihren Lohn zahlen Datenarbeiter*innen also nicht nur mit ihrer Arbeitskraft, sondern auch mit ihrer Gesundheit.

Diese und weitere Kosten verschwinden hinter den glatt designten Oberflächen der Bildgeneratoren, die per Mausklick Inhalte en masse ausspucken, als wären nur Maschinen am Werk. Ich finde: Gerade weil es leicht zugängliche KI-freie Alternativen zur Bebilderung gibt, muss man das als redaktionelles Angebot nicht aktiv unterstützen.

Ambivalenzen aushalten

Mehr als drei Jahre, nachdem ich mit Stable Diffusion einen Waschsalon im Stil von Edward Hopper erzeugt habe, wiederhole ich den Versuch. Dieses Mal mit Google Gemini Ende 2025: „Wie hätte Edward Hopper einen Waschsalon gemalt?“

Ich hoffe darauf, dass mich das Ergebnis kaltlässt, schließlich habe ich mich in diesem Text daran gemacht, Bild-Generatoren zu kritisieren und von ihrem Einsatz abzuraten. Bloß, das Gegenteil ist der Fall: Die Software erzeugt ein Bild, das mir sofort gefällt. Hätte ich es früher in einem Hopper-Sammelband gesehen, es hätte zu meinen Lieblingsmotiven gezählt. Zugleich merke ich, was für ein Luxus daraus spricht, dieses Bild generieren und genießen zu können.

KI genießen, KI ablehnen – wie lässt sich diese Ambivalenz aushalten?

Der Knackpunkt liegt für mich darin, in welcher Rolle ich mit KI-generierten Bildern umgehe. Im Fall vom Hopper-Bild entscheide ich mich als Privatperson dafür, ein problematisches Produkt wie einen Bildgenerator für eine ästhetische Erfahrung zu nutzen: Das ist reiner Luxus. Ob und wie oft man das tun möchte, darüber muss wohl jede*r für sich selbst entscheiden.

Anders ist die Lage, wenn ich in meiner Rolle als Redakteur KI-Bilder in die redaktionelle Routine integriere. Dann wären sie kein privater Luxus mehr, sondern beruflich genutzte Gebrauchsgrafiken für ein breites Publikum. Sie würden den Einsatz einer Technologie normalisieren, die ich sehr kritisch sehe. Mein Fazit: Finger weg.

Zumindest zu dokumentarischen Zwecken kommt der falsche Hopper als eingebettete Grafik in diesen Text. Typisch für Hopper sehen wir hier einen isolierten Menschen in einer urbanen Umgebung. Er scheint in sich gekehrt, als würde er dem Gefühl einer inneren Leere nachhängen. Wahrscheinlich interessiert mich dieses KI-Bild deshalb umso mehr: Weil sich auch KI-Bilder die Frage nach innerer Leere gefallen lassen müssen. Und schon sind sie nicht mehr leer.

Danke für diesen Leitfaden, der ein eindeutiges Fazit hat!

> Ein schauriges Beispiel dafür ist das oben eingebettete KI-Bild, das ich leider selbst als Artikelbild veröffentlicht habe, und heute für einen Griff ins Klo halte.

Interessanterweise gab es in dem Artikel von damals auch noch keine einzige negative Reaktion auf die Bebilderung. Es war für uns alle anfangs neu und interessant. Das hat sich geändert, und wenn ihr heute solch ein Bild als Artikelbild reinstellen würdet, gäbe es ordentlichen Gegenwind, Dauerauftragskündigungsankündigungen, usw. (Und, wenn ich mich recht erinnere gab es den Gegenwind auch hier bei netzpolitik.org, als KI-Bilder überhand zu nehmen drohten).

Ein weiterer negativer Aspekt von KI-Bebilderung ist die mögliche, vielleicht auch unbewusste Täuschung Lesender. Als Beispiel, bei diesem Artikel über einen Heimserver [1], habe ich tatsächlich erst gedacht, dass das abgebildete ein echtes Foto des Servers sei. Es war kein gutes Gefühl, verstanden zu haben, dass es nur eine mäßig passende KI-Darstellung (hier sogar KI-Slop) war. Und damit war ich nicht alleine, wie die Kommentare darunter zeigen.

[1] https://gnulinux.ch/der-server-daheim-ein-jahr-danach

Bei dem Artikel vermisse ich den Hinweis darauf, dass es hier mit black forest labs und den Flux Modellen durchaus eine gleichwertige europäische Alternative außerhalb der US Konzerne gibt.

Eine minimal heuchlerische und leicht von Doppelmoral durchzogene Aussage.

Es wird gänzlich der Diebstahl an Kunstschaffenden Ausgeblendet bei dieser Aussage.

Und ein „hach ist ja doch nicht so dolle“, folgt keiner Konsequent. Vielleicht einfach mal die Bilder austauschen. Und Haltung bzw. Rückgrat zeigen?

Ich freue mich sehr über diesen kritischen Beitrag hier, jedoch sabbeln alle immer nur anstatt zu handeln.

Man hat verstanden wie ***** KI-Bilder sind (mal ganz vom Umweltfaktor abgesehen) dann direkt handeln. Fehler eingestehen, nicht drum rum reden und vielleicht erst mal ein Platz-Halter-Bild rein.

Ein genervter Benutzer… sorry…

Da juckt es mich in den Fingern. Etwa zur Rolle des Betrachters vs. der des Künstlers (Sonnenuntergang vs. das stille Kämmerchen). Oder dazu, wieso eine KI so „stark“ bei der Rekombination der Lerndaten ist (Token). Mir fehlt ein wenig der Aspekt, dass KI Künstler abwertet, dabei aber parasitär und einzig von ihrem Schaffen „lebt“.

Ich widerstehe dem. Statt dessen: Ein super Artikel, der auf beschränktem Raum zum Nachdenken anregt. In den Konsequenzen stimme ich weitestgehend zu. Es hat Spaß gemacht, das zu lesen. Macht mich klüger. Bedankt!

Schade, dass Sie diese Erfahrung gemacht haben – ich sehe ehrlich gesagt eher die Chancen. Meine Design-Studierenden sind ebenfalls kritisch gegenüber KI, aber ihre Möglichkeiten, Ideen umzusetzen, haben sich vervielfacht. Sie lernen, sich Dinge selbst beizubringen, und das mit einer Geschwindigkeit, die ich vor ein paar Jahren für unmöglich gehalten hätte. Und das mit unserer lokalen KI. Gerade die Open-Source-Welt ist gigantisch geworden. Mit Tools wie LM Studio kann man heute schon lokale GPTs auf einem normalen Laptop und sogar Smartphone betriben (Pocket Pal) betreiben – keine Cloud, keine Abhängigkeit. Oder Z-Image, ein kompaktes, leistungsstarkes Bildmodell unter Apache-Lizenz – das ist echte Demokratisierung von Technologie. Wenn auch Herkunft wie bei allen fragwürdig. ich selbst „baue“ ihnen Werkzeuge bzw. Tools ohne jemals Programmiersprache gelernt zu haben.

Was im Artikel fehlt: Die meisten großen KI-Firmen haben selbst keine klare Idee, wie sie langfristig ROI erzielen wollen. Das sollte man nicht vergessen, wenn man über Machtkonzentration redet. Der Wert liegt wohl am Ende nicht in der Kontrolle über Daten, sondern in der kreativen und offenen Nutzung. Und genau da passiert gerade das Spannendste – nicht in den Konzernen, sondern in den Communities. Wir sind Will und nutzen Vecnas Schwarm gegen ihn 🤟

Beim ersten Blick auf den Waschsalon: in der Ecke steht eine Waschmaschine, die nicht benutzbar ist, weil die Waschmittelschublade blockiert ist. Außerdem blockieren sich einige der Türen.

Das ist für mich der Unterschied zu menschlichen Bildern: Hinter solchen Details steckt da meist eine Aussage und es lohnt sich, darüber nachzudenken. Bei KI-Bildern ist es das Unwissen über die Welt und ein zufälliges Artefakt aus dem Zusammenmischen vieler anderer Bilder. Ein Mensch würde sein Bild nachbearbeiten, eine KI generiert beim nächsten Mal einen anderen Fehler.

Hello, zu Deinem Hopper-Waschsalon: Die Schatten auf dem Gehweg sind komplett unmotiviert, die Deckenleuchter sind keine punktförmige Lichtquelle. Wenn ich einen Hopper-Katalog aufschlage und so etwas sehe, gebe ich den Katalog zurück.

Mist!

Ich bin auf dem gleichen Weg, allerdings geht es bei mir um den Sinn der Wörter.

Trotzdem hat mich dein Artikel gepackt.

Zuerst habe ich bei Gemini den prompt eingegeben und das Bild hatte quasi dieselben Waschmaschinen wie bei deiner Gemini Version.

Dann habe ich Startpage nach Hoppers Waschsalon suchen lassen und

tataa

Deine stable Version war das erste Bild!

Vllt kannst du dich noch an den Kommentar von damals erinnern, mit der Kuh auf der Wiese. Warum diese Kuh, warum grad diese Wiese.

Ich glaube zu wissen, warum deine Aufforderung, dass Redaktionen keine Bildgeneratoren verwenden sollen, sehr weise ist.

Das Problem ist bei der Sinnentleerung der Wörter dasselbe.

KI nimmt das, was irgendwie am häufigsten vorkommt und macht das zum Standard. Irgendwann ist alles gleich.

Die tiefe Bedeutung ist weg. Sie stört die Effizienz. KI muss effizient sein, langsam kostet Nutzer und Energie.

Ich träume auch von der KI für alle. Doch die wird es wohl nur auf regionaler Ebene geben, es gibt bei den Menschen keine Einigung, warum dann bei KI?

Meine Antwort heißt slowly App.

Briefe schreiben, bekommen und eigene Bilder im Kopf entstehen lassen. Nur so können wir uns ein wenig bewahren, um nicht im Einheitsbrei zu verschwinden.

Ich liebe es, mit KI zu philosophieren, hoffentlich sind in Zukunft immer noch Menschen da, die das miteinander tun.

Ich sehe KI-Bildgeneratoren eher als eine gute Möglichkeit für Menschen mit einer Fiktosexualität ihren virtuellen Partner lebendiger und interaktiver zu gestalten. Aus heteronormativer Sichtweise ist das nicht verständlich, aber für mich sehr bereichernd.

Für mich ist das Trainingsmaterial ausschlaggebend und es gibt genug Bildgeneratoren, die mit händisch ausgewählten Daten trainiert wurden und nicht mittels Crawler die massenhaft Persönlichkeitsrechte verletzen.

Dieser Artikel wurde mit Hilfe von KI geschrieben. Für mich war es zu lang zum lesen, deswegen habe ich eine KI gebeten den zusammen zu fassen. In Zukunft werden nur KIs mit KIs kommunizieren. Menschen werden nur zuschauen. Und KI Bilder sehen besser aus als von 99,9% der Künstler.

Ein Argument, das in dem Kontext noch anzubringen ist, ist die Förderung von jugen Talenten, die durch die Nutzung von KI wegbricht.

Als ich vor einem guten Jahrzehnt noch zur Schule ging, habe ich gerne gezeichnet, und der Vater eines Freundes hat gerade ein Sachbuch geschrieben. Also hat er mich kurzerhand beauftragt, ein paar Illustrationen für ihn zu gestalten – für ein paar Euro, die ihm nicht wehgetan haben, aber für mich ein tolles Gefühl der Wertschätzung waren, mir die Möglichkeit aufgezeigt haben, wie es wäre, sowas vielleicht später mal zum Beruf zu machen.

Wenn die Leute jetzt für so etwas einfach die KI anwerfen, weil das gerade „in“ ist, gehen uns solche Momente verloren.

Ich würde da nicht so hart mit mir selbst in’s Gericht gehen. Wie oben bereits erwähnt, war das ja für uns alle neu, und die meisten Leute werden eine ähnliche Erfahrung gemacht haben.

Aber die Modelle gibt es zum Großteil ja auch als offline-Version für ComfyUI. Auch wenn wir noch weit davon entfernt sind, die Teile lokal effizient laufen zu lassen. Mit entsprechenden Vorkehrungen und etwas Aufwand ist es so zumindest möglich ein kleinwenig Unabhängigkeit von den Großkonzernen zu erlangen

Bei Geminis Bild vom Waschsalon im Stil von Edward Hopper fällt mir sofort negativ auf, dass die Straße nass ist, als hätte es vor kurzem geregnet, während der Bürgersteig, die Fensterscheiben und die Außenwände des Waschsalons völlig trocken aussehen. Außerdem liegt auf der Straße Müll herum, der für meinen Geschmack zu homogen aussieht (lauter orangefarbene und weiße rechteckige Fetzen), während der Bürgersteig völlig sauber ist. Mich stört das.

Das quadratische Format des Bildes gefällt mir auch nicht besonders. War das eine Vorgabe von dir, Sebastian, oder hat Gemini das so entschieden, oder zeigst du nur einen Ausschnitt des Bildes?

Das erste Bild vom Waschsalon (https://netzpolitik.org/2022/text-zu-bild-generierung-der-anfang-von-etwas-grossem/) gefällt mir übrigens viel besser als das Bild von Gemini.

Beim Generieren von Bildern mit KI fehlt mir übrigens komplett der Spaß am Gestaltungsprozess. Das ist nicht der Fall, wenn ich mit der Hand zeichne oder ein Bild mit einer leistungsfähigen Software für 3d-Grafik erstelle. Für mich ist das neben den im Artikel genannten Gründen ein Hauptgrund, beim Generieren von Bildern keine generative KI zu benutzen, obwohl mir ab und zu die Ergebnisse durchaus gefallen.

Zur Bebilderung von Artikeln möchte ich noch anmerken, dass ich mich in vielen Fällen frage, wozu da überhaupt ein Bild nötig ist; oft stören mich die Bilder sogar, wenn ich zum Beispiel bei der Lektüre von Nachrichten zum hunderttausendsten Mal das Gesicht von Trump, Zuckerberg, etc. sehen muss. Ein bisschen schräg finde ich auch die sog. ‚Symbolbilder‘, die manchen Artikeln hinzugefügt werden. Beispiel: In einem Artikel wird über einen Verkehrsunfall berichtet und als Symbolbild wird ein Polizeiauto gezeigt. Wozu? Jeder weiß, wie ein Polizeiauto aussieht. Wenn es nach mir ginge, würden viele Artikel einfach unbebildert bleiben.

Danke für deine Ergänzung! Zu deiner Frage: Quadratisch war das Standard-Ausgabeformat von Gemini. Und zum Thema Symbolbilder: Viele Lesende finden Artikel über aufbereitete Feeds (sei es via Social, Google News, Feedreader etc.); Artikel ohne Bild würden neben bebilderten Artikeln von anderen wohl unscheinbar wirken und untergehen. Das wäre zumindest mein Hauptbedenken. Persönlich bräuchte ich auch nicht immer Bilder; lese meine morgendliche Dosis Nachrichten als Textwüste im Markdown-Format.

Ein toller Artikel! Danke dafür!

Er hat mich zum Nachdenken gebracht.

Sehr gut auch analysiert wie Kunst funktioniert. Emotionen stecken nicht in der Kunst, „Die Kunst löst sie in uns aus.“ (Was wiederum von unserer Erfahrung abhängt).

Künstler sind Menschen die gelernt haben, etwas zu schaffen, was Emotionen in ihnen oder in anderen auslöst.

Es gibt keinen Grund anzunehmen, dass KI’s das nicht lernen können.

KI ist ein Werkzeug. Und wie so viele Werkzeuge davor ermöglicht es uns produktiver zu werden. Wie bei so vielen Werkzeugen davor kann dieses für positiv konnotierte Aufgaben eingesetzt werden oder für negative.

Wie bei so vielen Werkzeugen davor entstehen neue Abhängigkeiten, da der Anwender nicht in der Lage ist, das Werkzeug selbst herzustellen und auch den Zugriff auf ein Werkzeug nicht kontrolliert.

Wie bei so vielen Werkzeugen davor, hat jeder die Entscheidung es zu nutzen oder auch nicht.

Und wie bei so vielen Werkzeugen davor, kann diese Entscheidung bedeuten, dass ohne ein bestimmtes Werkzeug ein Projekt nicht umsetzbar ist. Das können auch Projekte sein, welche nicht nur wirtschaftlich, sondern auch gesellschaftlich gesehen ein Gewinn wären.

Ich empfehle einfach mal tiefer in die Materie einzutauchen anstatt an den kommerziellen Services das ganze auszumachen.

Alleine Ihr Hopper Bild wirkt weniger wie das des Künstlers – da wäre deutlich mehr rausgeholen.

Lassen Sie sich bitte nicht beirren. Die öffentlich zur Verfügung stehenden Modelle sind stark kastriert und sind zusätzlich umhült von einem ideologischen Layer (m.E. nach DIE Grund-Essenz wirklichen KI-Übels).

Sind die ergänzenden menschen gemachten Pseudoethiken endlich entfernt, eröffnen sich auch deutlich größere Dimensionen der Kreativität.

Ästhetik liegt im Auge des Betrachters. Darum spielt es auch keine Rolle, ob Kunst durch KI oder Mensch geschaffen wurde. Als entlassener Angehöriger der Buchbranche ist mein Mitleid mit den Künstlern einigermassen begrenzt. So wie ich es sehe, gibt es kaum noch Berufe, die nicht direkt oder indirekt vom Zeitgeist bedroht werden. Die wahre Kunst wird in Zukunft wohl darin liegen, bezahlte Arbeit für einen Menschen zu finden.

„[…] Beispiel für ein furchtbares KI-Erzeugnis, das ich mal für ein vorzeigbares Artikelbild gehalten habe. […] Ein schauriges Beispiel dafür ist das oben eingebettete KI-Bild, das ich leider selbst als Artikelbild veröffentlicht habe, und heute für einen Griff ins Klo halte. […]“

Das eigene Frühwerk mit ein paar Jahren Abstand und gestiegenem Anspruch für schaurig, sinnentleert und nicht länger vorzeigbar zu halten ist nun aber etwas, vor dem auch gänzlich KI-frei arbeitende Kunstschaffende nicht gefeit sind.