Der Meta-Konzern will in Zukunft virale Beiträge, die auf seinen Plattformen besonders viel so genanntes „Engagement“ generieren, mit einem Bonus-System belohnen. Der Konzern hat dafür im vergangenen Jahr das „Performance-Bonusprogramm“ aufgelegt. Derzeit können nur ausgewählte Accounts daran teilnehmen. Im Laufe des Jahres soll das Programm jedoch für die Breite ausgerollt werden. Mit dem Programm sollen laut Meta in Zukunft nicht mehr nur die Performance der ausgespielten Werbung, sondern auch die Performance des Inhaltes über die Höhe der ausgezahlten Gelder bestimmen. Der Schritt könnte neue Möglichkeiten für das Geschäft mit Falschinformationen eröffnen, berichtet ProPublica in einem längeren Artikel zum Thema.

Viral werden Beiträge genannt, die sich in sozialen Netzwerken besonders gut verbreiten. Sie enthalten erfahrungsgemäß besonders häufig irreführende oder polarisierende Inhalte. Wie die Whistleblowerin Frances Haugen mit internen Dokumenten belegte, kam auch Meta selbst durch eigene Forschung zu dem Schluss, dass virale Posts viermal mehr Desinformation als andere Inhalte enthalten. Meta könnte also Beiträge belohnen, die besonders viel dazu beitragen, demokratische Diskurse zu zerstören oder zu polarisieren. Ein Monetarisierungsprogramm bei der Plattform X hatte laut einer BBC-Recherche im US-Wahlkampf dazu geführt, dass Nutzer:innen für derlei irreführende Inhalte belohnt wurden.

Kürzungen beim Faktencheck

Das Programm fällt zusammen mit dem Ende des Kampfes gegen Desinformation auf den Plattformen. Schon in den kommenden Wochen will Meta in den USA die Zusammenarbeit mit Fact-Checking-Organisationen beenden. Eine Form von nutzergenerierten „Community Notes“ soll als Korrektiv für falsche Informationen eingeführt werden, während allerdings automatisierte Systeme und menschliches Fact-Checking zurückgefahren werden. Die Regeln der Inhaltemoderation wurden schon zu Trumps Machtübernahme so geändert, dass sie mehr Homophobie und Sexismus zulassen

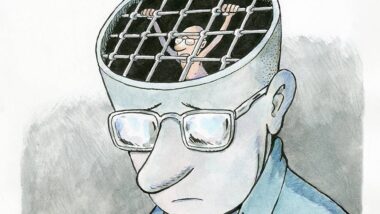

Die Ausrichtung von Algorithmen auf Engagement, also möglichst viel Interaktion der Nutzer:innen bei möglichst hoher Aufenthaltsdauer auf den Plattformen, wird als ein Grund dafür angesehen, dass rechtsradikale und populistische Bewegungen und Parteien sowie deren zerstörerische Diskurse derzeit in vielen Ländern gedeihen. Jüngst gab es wieder Recherchen, die gezeigt haben, dass in Deutschlands besonders rechte Parteien von Algorithmen auf X und TikTok profitieren. Die Ausrichtung der Algorithmen auf Engagement hat in der Vergangenheit auch dazu geführt, dass verschwörungsideologische Inhalte so eine große Bedeutung erfahren haben.

Aus Interesse: Ist das nicht genau die Art wie Youtube click-bait incentiviert?

Ja, nur das es sich auf den Klick reduziert. Das eigentliche Video hat dann meist die richtige Information.