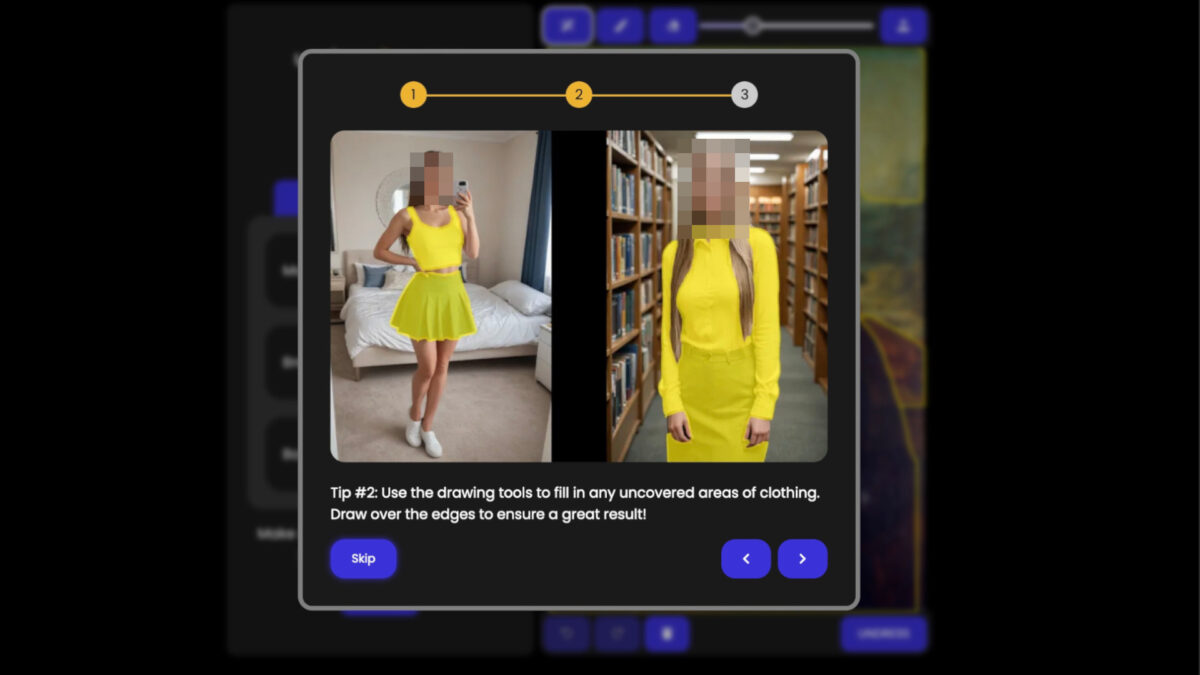

Die ersten Bilder sind gratis, ab dann wird ein Abo fällig. Websites zum Erstellen sexualisierter Deepfakes bieten ihre Dienste inzwischen offen im Netz an; es braucht nur eine Anmeldung per E-Mail-Adresse. Nutzer*innen können ein beliebiges Foto hochladen – und per Mausklick wird die abgebildete Person entkleidet. Die Ergebnisse sind teils fotorealistisch, möglich ist das durch moderne Bildgeneratoren.

Wer solche Bilder ohne Einverständnis der gezeigten Personen erstellt, setzt sich über deren sexuelle Selbstbestimmung hinweg und übt bildbasierte Gewalt aus. Wer solche Bilder verbreitet, kann sich eventuell strafbar machen.

Für die Recherche hat netzpolitik.org eine Stichprobe aus zehn Deepfake-Websites miteinander verglichen und deren Betreiber*innen kontaktiert. Die Seiten ließen sich innerhalb kürzester Zeit finden. Es genügten simple Suchbegriffe bei einer gängigen Suchmaschine. Um den Seiten keine zusätzliche Reichweite zu verschaffen, werden Namen hier nicht genannt, auch nicht die verwendeten Suchbegriffe.

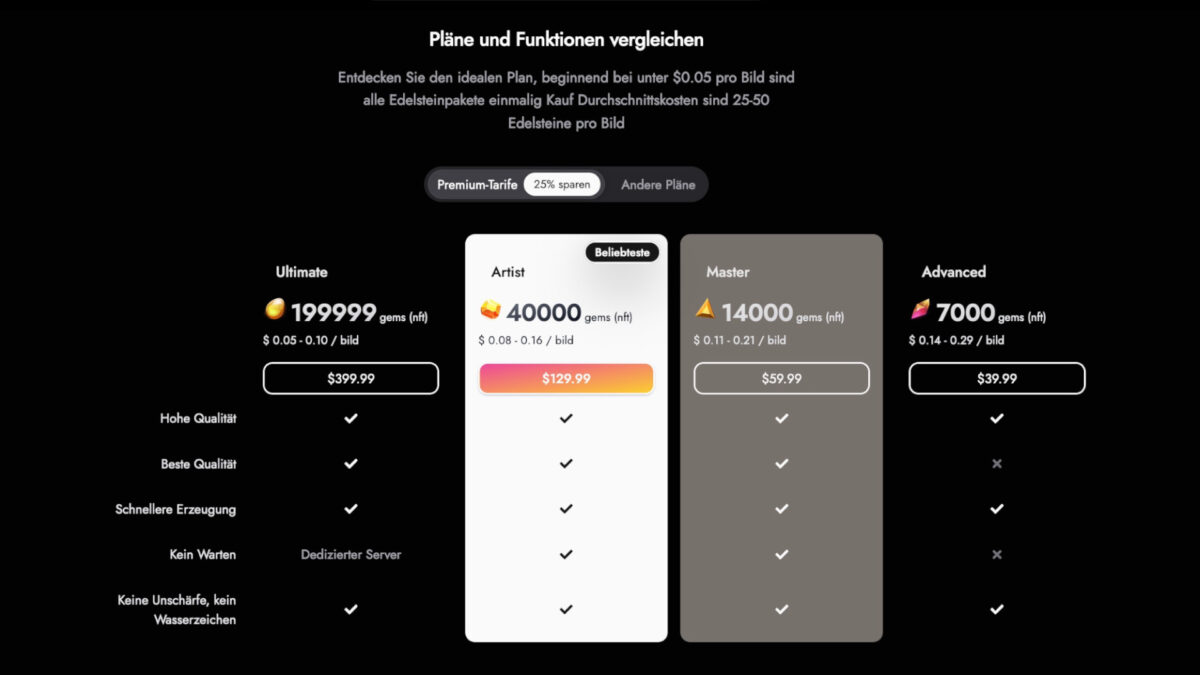

Der Vergleich zeigt: Es ist inzwischen so einfach wie nie, realitätsnahe sexualisierte Deepfakes zu erstellen. Die Website-Betreibenden haben nach eigenen Angaben teils Hunderttausende Nutzer*innen pro Monat. Die Preise für Premium-Abos beginnen bei 2 Euro für Einsteiger*innen und enden bei bis zu 380 Euro fürs Jahresabo. Die Abos versprechen auch eine höhere Auflösung oder kürzere Bearbeitungszeiten.

Dass man solche Bilder nicht ohne Einverständnis der gezeigten Personen erstellen soll, wird oft per Pop-up-Hinweis abgefrühstückt. Teils legen die Websites den Besucher*innen allerdings nahe, sich Nacktbilder weiblicher Promis generieren zu lassen. So zeigt eine Seite das Oben-ohne-Bild einer bekannten US-Sängerin. Deepfakes weiblicher Körper sind offenkundig das Primärprodukt. Nur vereinzelt fand sich auch die Option, nackte männliche Körper zu generieren.

Werkzeuge einfach zugänglich

Jüngst berichteten internationale Medien über einen Deepfake-Fall aus dem US-Bundesstaat Pennsylvania: Die Polizei hatte demnach einen Schüler festgenommen, der KI-Nacktbilder von Mitschüler*innen erstellt haben soll. Aus Sicht der Eltern habe die Schule nicht ausreichend auf Warnungen reagiert. Als der Streit eskalierte, fiel sogar der Unterricht aus. Im Vorjahr kochte ein Deepfake-Fall in einer spanischen Schule zu einem landesweiten Skandal hoch. Die Mütter der betroffenen Mädchen organisierten sich, Zeitungen und Fernsehen berichteten.

Unsere Recherche zeigt: Die Werkzeuge für solche Deepfakes sind einfach zugänglich. Täter*innen bräuchten nur wenige Minuten und ein paar Fotos aus sozialen Medien, um ähnliche Skandale zu reproduzieren. Eines der Tools bietet Nutzer*innen sogar an, einfach den Link zu einem Instagram-Profil einzugeben und die Software soll sich die Bilder automatisch schnappen. Der Aufschrei in Spanien und in den USA mag sich auf konkrete Einzelfälle beziehen – doch vieles spricht dafür, dass sich solche Fälle rund um kursierende KI-Nacktbilder sehr leicht wiederholen können.

Die Technologie dahinter sind universell einsetzbare Bildgeneratoren wie etwa das quelloffene StableDiffusion. Mehrere der untersuchen Websites nehmen ausdrücklich auf StableDiffusion Bezug. Vereinfacht ausgedrückt entsteht das KI-Nacktbild so: Zunächst erkennt eine Software die Umrisse einer dargestellten, bekleideten Person. Dann wird die entsprechende Fläche mit der Darstellung einer nackten Person gefüllt. Beibehalten werden das Gesicht und die sonstige Umgebung des Bildes. Gerade bei frontalen Aufnahmen mit eng anliegender Kleidung können auf diese Weise sehr realistische Aufnahmen entstehen.

Zwar könnten Menschen auch mit einer herkömmlichen Bastelschere Gesichter ausschneiden und Fotos montieren. Im Gegensatz zu solchen Papierfakes sind Deepfakes jedoch mühelos zu erstellen und realistischer.

Verbreitung seit 2023

Noch vor wenigen Jahren war der Zugang zu sexualisierten Deepfakes deutlich schwerer. 2019 gab es etwa Berichte über eine Deepfake-Software namens Deepnude. Auch wenn die ursprünglichen Uploads der Software offline genommen wurden, kursierten in Foren weiterhin Kopien. Inzwischen müssen sich Nutzer*innen nicht mehr durch solche Foren wühlen.

2022 berichteten wir gemeinsam mit dem SPIEGEL über populäre FaceSwap-Apps. Nutzer*innen konnten in den Apps etwa das Nacktbild einer Pornodarsteller*in hochladen und dann deren Gesicht ersetzen. Auch das ist wohl überholt: Inzwischen benötigen Nutzer*innen nur noch das Bild einer beliebigen, bekleideten Person als Vorlage.

2024 warf laut US-Magazin 404 Media Apple mehrere iOS-Apps aus dem App Store, die für nicht-einvernehmliche, sexualisierte Deepfakes geworben haben sollen. Wenn sie ihre Dienste dagegen direkt im Browser anbieten, müssen sich Deepfake-Shops nicht an die Richtlinien von App-Marktplätzen halten.

Der offenbar älteste der zehn untersuchten Online-Shops wurde im Jahr 2022 erstmals im Internet Archive hinterlegt. Das Internet Archive dokumentiert – größtenteils automatisch – Websites für die Nachwelt. Vier Online-Shops wurden im Jahr 2023 erstmals archiviert; vier weitere im Jahr 2024. Die für diese Recherche untersuchten Deepfake-Shops sind also eine neuere Entwicklung.

Windelweiche Schutzmaßnahmen

Alle zehn Shops haben sich zumindest oberflächlich auf juristischen und ethischen Widerstand vorbereitet. Bei mehreren Shops weisen Pop-up-Fenster darauf hin, dass Nutzer*innen volljährig sein müssen und keine Fotos ohne Einverständnis hochladen dürften. Ein Shop schreibt im Footer der Website, für die generierten Bilder sei man als Unternehmen nicht verantwortlich. Ein weiterer Shop führt aus, man sei sich der ethischen Implikationen bewusst – und ermuntere Nutzer*innen, alle rechtlichen Standards einzuhalten. Einen eher kreativen Ansatz verfolgt ein anderer Shop: Die generierten Bilder seien Kunst.

Mehrere Shops schreiben ausdrücklich, dass sie Maßnahmen gegen die sexualisierte Darstellung von Minderjährigen ergreifen würden. In vielen Ländern, darunter Deutschland, ist der Besitz solcher Aufnahmen strafbar. Mithilfe automatischer Alterserkennung lassen sich zumindest technische Hürden hochziehen, um zu verhindern, dass Deepfakes von Kindern generiert werden. Allerdings sind die Schätzungen solcher Anwendungen ungenau. Gerade Personen um die 18 Jahre könnten also irrtümlich als bereits volljährig oder als noch minderjährig eingeschätzt werden.

Dennoch behauptet einer der analysierten Shops, man blockiere 99,9 Prozent illegaler Inhalte durch automatische und händische Prüfung. Außerdem würden die erzeugten Aufnahmen ein Wasserzeichen verpasst bekommen, das Zeitstempel und IP-Adresse enthalte. So könnten Betroffene im Zweifel ein Bild zur Ersteller*in zurückverfolgen. Näher geprüft haben wir das nicht.

Ob die Darstellung einer erwachsenen Person mit oder ohne Einverständnis erfolgt, lässt sich ohne Weiteres nicht feststellen. Große Pornoseiten wie Pornhub verlangen von Darsteller:inen deswegen inzwischen Dokumente und Video-Verifikation. Solche Vorkehrungen fanden wir jedoch bei keinem der zehn Shops.

Dabei ist der Einsatz von Deepfakes für einvernehmliche Darstellungen durchaus denkbar. Im Frühjahr interviewte beispielsweise die taz die Porno-Creatorin Sika Moon, die von realen Aufnahmen ihres Körpers zu Deepfakes wechselte – unter anderem zum Schutz vor Stalking. Mit Blick auf nicht-einvernehmliche KI-Nacktbilder sagte sie: „Das Problem liegt nicht im Werkzeug, sondern bei dem, der es benutzt.“

Adresse: unbekannt

Eine Unternehmensadresse gaben nur drei der zehn Shops auf ihrer Website an. Zwei davon waren demnach in Großbritannien, eine in Argentinien registriert. Zwei Shops erwähnten zumindest das Land Großbritannien als Firmensitz. Und zwei weitere nannten auf direkte Anfrage ihr angebliches Herkunftsland: Kambodscha und Taiwan. Bei drei Shops bleibt schleierhaft, wo die Betreiber*innen sitzen.

Der Deepfake-Shop aus Taiwan hat nach eigenen Angaben 200.000 zahlende Nutzer*innen. Im Durchschnitt würden täglich 100.000 Bilder generiert, heißt es in einer E-Mail, die jedoch mit keinem Namen unterzeichnet wurde. Beim Shop in Kambodscha sollen es täglich 6.000 generierte Bilder sein, rund 50.000 Nutzer*innen würden für den Dienst zahlen. Seit Gründung seien fast 22 Millionen Aufnahmen in Nacktbilder verwandelt worden.

Von Außen überprüfen lassen sich diese Zahlen nicht. Gerade im Konkurrenzkampf miteinander hätten solche Shops zumindest den Anreiz, sich als besonders populär zu präsentieren.

Zahlungen mit Kreditkarte oder PayPal

Am Geschäft mit den Deepfakes sind offenbar herkömmliche Zahlungsdienstleister beteiligt: sechs von zehn Shops gaben an, Zahlungen per Visa und Mastercard zu akzeptieren; drei nennen PayPal, drei Google Pay. Ob Zahlungen über diese Dienstleister auch wirklich funktionieren, haben wir nicht getestet.

Alle Shops verlangen zudem einen Login per E-Mail, um sich Bilder generieren zu lassen. Das dürfte auch eine Maßnahme gegen automatisierte Nutzung durch Bots sein. Hierfür boten acht von zehn Shops an, sich per Gmail-Adresse einzuloggen – also einen weiteren Google-Dienst.

Die Pressestellen von Visa, Mastercard, PayPal und Google beantworteten die Presseanfrage von netzpolitik.org sehr ähnlich: Demnach verstoßen die Shops für sexualisierte Deepfakes gegen die Richtlinien der Konzerne. Entsprechenden Hinweisen gehe man nach. Wie oft das schon der Fall gewesen ist, will jedoch keiner der Konzerne beantworten – auch nicht auf direkte Nachfrage.

Auf einen potenziellen Wegfall der Zahlungsoptionen haben sich mehrere Shops bereits vorbereitet. Sie bieten auch Zahlung per Kryptowährung an.

EU-Richtlinie verbietet Verbreitung

Bereits in unserem Bericht aus dem Jahr 2022 haben wir geschildert, was KI-generierte Nacktbilder für Betroffene bedeuten können. Die Bilder können sich schnell verbreiten, auch in der Schule oder im Arbeitsumfeld. Selbst wenn ein Deepfake nicht den wahren Körper zeigt, kann es Betroffene bloßstellen und verletzen. Josefine Ballon von HateAid sagte: Betroffene wüssten nie, ob andere die Deepfakes vielleicht doch für echt halten. Die gemeinnützige Organisation unterstützt Betroffene digitaler Gewalt juristisch und bringt sich politisch ein.

Zum Schutz von Betroffenen hat sich die EU jüngst auf eine Richtlinie zur Bekämpfung von Gewalt gegen Frauen geeinigt. Demnach müssen Mitgliedsstaaten – auch Deutschland – die Verbreitung nicht-einvernehmlicher, sexualisierter Deepfakes ausdrücklich unter Strafe stellen. Die EU-Mitgliedstaaten haben für die Umsetzung drei Jahre Zeit. Die neuen Regeln dürften damit also erst ab 2027 greifen. Zumindest die Union im Bundesrat zeigte schon in diesem Jahr Ambitionen, eine frühere Regulierung zu schaffen.

Bis auf Weiteres müssen sich Betroffene in Deutschland auf andere Gesetze berufen. In Frage kommen etwa zivilrechtliches Vorgehen wegen der Verletzung von Persönlichkeitsrechten oder das Kunsturhebergesetz, wie der deutsche Juristinnenbund ausführt. HateAid nennt gerade bei herabwürdigenden Deepfakes auch eine strafrechtliche Handhabe, etwa wegen Beleidigung oder Verleumdung.

Geschlechtsspezifische Deepfakes

Neben den Personen, die per Deepfake entkleidet werden, spielt noch eine Gruppe eine Rolle: Vorlage für die nackten Körper der Deepfakes dürften in vielen Fällen die Aufnahmen von Erotik- und Pornodarsteller*innen sein. Deren Job ist ohnehin oft prekär – und die wenigsten dürften ihr Einverständnis dafür gegeben haben, mit ihren Inhalten für KI-Training oder als Deepfake-Vorlage herzuhalten.

Im Kern sind nicht-einvernehmliche, sexualisierte Deepfakes weniger ein juristisches oder technologisches Problem als ein gesellschaftliches. Es ist die Entscheidung von Menschen, die Grenzen der abgebildeten Personen durch KI-Nacktbilder zu verletzen. In den Skandal-Fällen aus Pennsylvania und Spanien waren Teenager*innen involviert. Je nach Fall und Alter sind sie noch nicht einmal strafmündig.

Das Phänomen hat auch eine geschlechtsspezifische Dimension. Besonders im Visier digitaler Gewalt sind Frauen – und das spiegelt sich auch in den zehn untersuchten Online-Shops wider. Sexualisierte Frauenkörper stehen auf diesen Websites klar im Vordergrund. Es wimmelt vor Brüsten, Nippeln und Vulven. Penisse muss man aktiv suchen und wird nur manchmal fündig. So lange es für viele kein Tabu ist, solche nicht-einvernehmlichen Bilder zu generieren, dürften sich Deepfakes kaum eindämmen lassen.

> Wie oft das schon der Fall gewesen ist, will jedoch keiner der Konzerne beantworten – auch nicht auf direkte Nachfrage.

Wenn „die Konzerne“ schon verschweigen, wie oft sie „Hinweisen nachgegangen“ sind, so wäre doch die interessantere Frage, ob sie denn überhaupt etwas dagegen unternommen haben, und was. Denn „nachgehen“ bedeutet nur „wir sehen uns das mal an“.

Das kann; und muß; man sich wohl selbst beantworten. Den Zahlungsanbietern ist das Hemd näher als die Hose und so lange sie dran mit verdienen können werden sie es wohl weiter tun. Ausnahme sind wohl die Großen Porno-Plattformen und ich vermute da auch nur wenn es genug Gegenwind aus Richtung Christlich-Fundamentalistischer Gruppierungen gibt. Da wird dann auch gern auf das Kindeswohl abgestellt weshalb man die Quelle versiegen lassen wollte – statt Eltern, Apps u.a. in die Pflicht zu nehmen den Kinderschutz richtig zu implementieren – das auch ONU-Eltern ihn anwenden können. Kinderschutz sollte doch beim Kind ansetzen oder?

Kurz: Die „Moral“ in dem Bereich hat so viele Doppelte Böden das es wundert wenn nicht der eine oder andere mal ausgeschlagen wird. Löchrig ist das ganze sowieso. Und vom falschen Ende her gedacht (Meiner Meinung nach).

Mit der Alterskennzeichnung auf Gaming-Plattformen scheint es auch so zu sein. Spiele die keine haben aber eine haben müssen werden nicht etwa „ab 18“ eingestuft, sondern gleich ganz raus gefiltert – wie man lesen kann.

a) Freuen wir uns über den digitalen Fortschritt!

Ist doch toll, was es nicht alles gibt! Auch die schrägsten Bedürfnisse vorwiegend männlicher Zweibeiner können monetarisiert werden. Und schön, dass die Dümmsten dafür gut abgezockt werden. Wenn das Geld so ausgegeben wird, fehlt es für gefährlichere Zwecke.

b) Freuen wir uns über die Geschäfts- und Metadaten!

Elektronischer Zahlungsverkehr geht nicht ohne persönliche Daten. Danke für diese Daten.

c) Ungeahnte Möglichkeiten!

Jegliches digitales Bildmaterial lässt sich zusätzlich zu den Metadaten mit „Informationen“ anreichern, auch verschlüsselt zum Zweck der Nachverfolgung. Jedes einzelne Bild kann den kompletten Kundendatensatz incl. Bankverbindung enthalten, aber auch ein „Tag“ (engl.) kann Freude machen. Der Gedanke, auch über seinen eigenen nicht sichtbaren aber vorhandenen Datensatz zu ejakulieren, ist unvergesslich.

Was genau heißt denn „sexualisiert“? Der Mensch pflanzt sich sexuell fort, Erwachsene homo sapiens sind also samt und sonders „sexualisiert“.

Sexualisierung beschreibt das aktive Herstellen eines sexuellen Kontexts, z.B. durch eine andere Person. Der Begriff betont das durch Fremdbestimmung geprägte Machtverhältnis und das fehlende gegenseitige Einvernehmen.

…Erst motzen wenn der Staat mehr Daten kontrolieren will und dann heulen wenn Firmen keine Selbstkontrolle durchführen.Dem Staat mehr kontrolle erauben, dann gibts weniger Geheule das Firmen keine Selbstkontrolle durchführen.Der Staat soll keinen Daten bekommen aber bei solchen fadenscheinigen Firmen, scheint mir hier die Klage in dem Bericht,ist deren fehler meine daten nicht zu nehmen.Ich wiederum hätte gerne mehr Kontrolle durch den Staat, dem muss ich nicht dauernd ne Ausweiskopie schicken und hoffen das die daten nicht für Straftaten Missbraucht werden.Selbst wenn sone dubiose Firma ne Ausweiskopie von mir fordern würde, würde ich denen keine geben.Soviel zu der Idee der Selbskontrolle der Tech Firmen. Die sehen sich genau so wenig in der Verantwortung für euch, wie ihr euch für die.Am einfachsten wäre doch gleich das man sich und seine Kinder mit Personalausweis für Internet nutzung anmelden muss und immer ein/e Verantwortliche, auch als User ersichtlich ist! Quasi ein Zwangsimpressum für das Internet ab internet nutzung,das für die Strafbehörden immer ersichtlich ist.Ich mache ja solchen mist mit anderen nicht, also habe ich keinen Grund nicht erfasst sein zu wollen.

„Ich wiederum hätte gerne mehr Kontrolle durch den Staat, dem muss ich nicht dauernd ne Ausweiskopie schicken und hoffen das die daten nicht für Straftaten Missbraucht werden.“

Jo liebsken Eddi dann darfst mal hoffen dat der Staat nicht selbst ma die Daten missbraucht und dat zweitens keine Radikalen an die Macht kommen, die dir verbieten auch nur einen Pieps zu sagen und jeden Schritt deines Lebens verfolgen… wünscht du es dir?

„Ich mache ja solchen mist mit anderen nicht, also habe ich keinen Grund nicht erfasst sein zu wollen.“

Schreib doch gleich dat du nichts zu verbergen hast. Stimmt zwar nicht aber is wenigstens kompliziert ausgedrückt.

Firmen regulieren ist völlig ok. Wo soll da das Problem sein, außer bei doofen Fehlern, Überregulierung u.ä.? Ich sehe da auch nicht die Vergleichbarkeit.

Und Ausweiskopieschicken, sollte verboten sein. Das sollte digital anonymisiert ablaufen oder bei der Bank eben wie Ausweis vorzeigen, wenn die das darf und muss. Das ist eigentlich gar nicht das Hindernis.

Jo liebsken Mietze, dat mit den Radikalen, da hast ein Argument. Aber „dem Staat“ pauschal möglichen Missbrauch zu unterstellen ist subkomplex, um es freundlich auszudrücken.

Also wenn man das Beispiel mit der EPA anschaut oder wie die Grundrechte weiter eingeschränkt werden, kann man diese Übergriffe schon als eine Form von möglichem Missbrauch der Daten (oder des Bürgerwillens oder seiner Selbstbestimmung) ansehen. Da hat die Netzkatze irgendwo recht.

> Da hat die Netzkatze irgendwo recht.

Die Rückseite des Mondes ist „irgendwo“. Ob EPA oder Grundrechte, es ist nicht „der Staat“ der dafür verantwortlich ist. Verantwortlich sind immer Menschen, Gruppen, Parteien, Einflussnehmer.

Diese gilt es klar zu benennen, anstatt über „Staat“ oder „System“ zu schwadronieren.

Der gemeine und halbwegs der Pedanterie abholde Bürger weiss, wer mit „dem Staat“ gemeint ist: die Entscheidungsträger bzw. regierenden Personen, die für solche Maßnahmen verantwortlich sind. In konkreten Einzelfällen sieht es natürlich anders aus, aber um Tendenzen aufzuzeigen, ist die Aussage „der Staat“ durchaus vertretbar, da der Staat aus Menschen besteht.

Gerade bei Tendenzen ist es überaus wichtig, ordentlich zu differenzieren. Wer das nicht kann, betreibt Schwurbelei, ob aus Unvermögen oder mit Absicht. Absichtlich betreiben dies mit Methode Akteure der Staatsdelegitimierer.

Naja, oder es soll die Delegetimierungstendenz des Staates im Systemsinne andeuten. Dann ist es ein Schuh. Ansonsten wirkt „Benenne den Hund“ immer auch so ein bischen wie ein Totschlagsargument.

Gerade bei sich anbahnenden Tendenzen, kann oft überhaupt gar nicht konkret benannt werden, wie genau es dazu kommt. Die die es könnten, schweigen offenbar gerne. Zuarbeiter rationalisieren sich vielleicht irgendwas zurecht, warum die Richtung jetzt ok sein soll, oder irgendwer was verdient, oder sind längst desillusioniert. Oder es sind auch mal ausländische Akteure (Spionageringe klingeln mal wieder an der Kanzleramtstür, oder was war das mit Marsalek?).

>>> Ob EPA oder Grundrechte, es ist nicht „der Staat“ der dafür verantwortlich ist. Verantwortlich sind immer Menschen, Gruppen, Parteien, Einflussnehmer.

Diese gilt es klar zu benennen, anstatt über „Staat“ oder „System“ zu schwadronieren.

Da wo es geht! Ansonsten gilt es das doch noch herauszuarbeiten. Mindestens für die Strategische Ebene, frühe Mitwisser und Unterstützer. Da gibt es sicherlich noch Überraschungen. Problem hier ist mangelnde Transparenz und fehlende Checks and Balances.

>>> ist die Aussage „der Staat“ durchaus vertretbar, da der Staat aus Menschen besteht.

Langsam nervt jene „Ablehnung des Staates“ etwas, denn natürlich wird der Staat oft als Kurzform für das Wirken der Apparate und von Entscheidungsträgern verwandt, und nein, ich bin nicht diese Apparate. System wiederum ist umfassender, und kann u.a. Verbandelung mit Wirtschaft betreffen, oder den Wiedergeburtscharachter der Probleme. Desweiteren „sind wir“ nicht einfach nur der Staat, jedes Individuum stellt einen kleinen, z.T. auch geschützten, dennoch nur kleinen Teil dar, und die Vorgänge sind erwiesenermaßen verzerrt und durch Manipulation noch weiter kanalisiert. D.h. die Mechanik, wie etwas sich dann auf die Apparate oder Entscheidungsträger auswirkt ist gerade bei Gesetzgebung nicht ganz so durchsichtig. Auch die Auswahl des Führungspersonals ist irgendwie systemisch. Was man in einer Demokratie sagen kann, ist dass jeder einzelne Bürger mitwirken kann und auch solle.

“ Anonymous sagt:

30. November 2024 um 09:44 Uhr sagt“

Ja, bei bekannten Akteuren sollte man differenzieren. Aber dann dürfte man auch nicht vom „Fiskus“ sprechen, sondern müsste jedesmal bei einer Steueränderung alle dafür Verantwortlichen aufzählen. Oder vom „Gesundheitswesen“. Oder bei Abstimmungen der „Partei X“ (keiner weiss in der Regel, wie welcher Abgeordnete abgestimmt hat, man muss es aber irgendwie ausdrücken können). Oder „Frag den Staat“ müsste sich umbenennen in „Frag Frau oder Mann „x“ (mit x=Variable für jede für einen bestimmten Sachverhalt verantwortliche Person). Es geht hier einfach um sprachliche, aber keineswegs inhaltliche Vereinfachung. Deshalb kann man nicht Schwurbelei unterstellen. „Netzkatze“ hat ausserdem nur eine Möglichkeit beschrieben, die durchaus realistisch erscheint.

„Es geht hier einfach um sprachliche, aber keineswegs inhaltliche Vereinfachung. Deshalb kann man nicht Schwurbelei unterstellen.“

So wie Zitierfehler nicht Hausdurchsuchungen bedingen sollten, außer bei offensichtlich nüchternen Akademikern, vielleicht.

Für ein freies Netz ohne unliebsame Inhalte!

Naja, was ist denn das Gegenteil von „unliebsam“? Liebsam? Das Internet als Oase für Wohlbefinden? Und wer hat Deutungshoheit darüber?

Weniger Anlass zum zynischen Grinsen würde ein Ruf bieten, nach einem weniger schädlichen, weniger toxischen, weniger gewaltsamen Internet.

Da es Menschen gibt, die sich schädlich, toxisch und gewaltsam verhalten, sollte man diese daran hindern das Internet weiterhin zu benutzen, wenn sie so auffällig geworden sind.

Nun ist „schädlich, toxisch und gewaltsam“ halt eine sehr subjektive Metrik und „daran hindern das Internet weiterhin zu benutzen“ setzt Strukturen für Identifikation, Kontrolle und Sperrung voraus.

In anderem Kontext nennt man eine solche Struktur „Überwachung und Zensur“.

Haben Sie vielleicht inzwischen bemerkt, dass Ihre „unliebsam“ Metrik nicht minder subjektiv war?

Fällt ihnen nichts anderes ein, als „Überwachung und Zensur“ zu tröten? Auffällig wird man durch strafrechtlich relevantes Verhalten, und das sollte richterlich untersagbar sein, um Wiederholung zu unterbinden. Dafür braucht es keine vorgelagerte, vermeintliche Überwachungs-Prophylaxe-Phantasien.

„Haben Sie vielleicht inzwischen bemerkt, dass Ihre „unliebsam“ Metrik nicht minder subjektiv war?“

Ich habe diese Formulierung bewusst genau dafür verwendet, und der Kommentar darauf bestätigt genau das.

„Auffällig wird man durch strafrechtlich relevantes Verhalten,“

Auffällig ist das Verhalten, die reale Person dahinter muss erstmal identifiziert werden können. Und dann ist Strafrecht bereits das schärfere Schwert gegenüber Zivilrecht.

„und das sollte richterlich untersagbar sein,“

Eine Untersagung muss dann auch durchgesetzt werden können. Dafür müsste man die Person identifizieren und sanktionieren können, oder eben das Verhalten wegfiltern.

„um Wiederholung zu unterbinden. Dafür braucht es keine vorgelagerte, vermeintliche Überwachungs-Prophylaxe-Phantasien.“

Um die Wiederholung zu unterbinden muss man natürlich vorgelagert agieren, denn sonst kann man sie nur nachträglich sanktionieren. Und selbst dafür muss man vorgelagert die Voraussetzung schaffen.

Sie klingen wie rechte Politiker zum Thema Verschlüsselung mit „sicherer“ Hintertür. Vielleicht haben Sie nicht unbedingt das ausreichende Verständnis der Thematik, um sich eine Meinung erlauben zu können?

Der Kommentar am Anfang war übrigens sarkastisch gemeint, da er letztlich einen Widerspruch enthält.

Das war nicht offensichtlich, tut mir leid.