Dass Empfehlungsalgorithmen großer Plattformen wie Facebook und YouTube politische extremeren Perspektiven zu mehr Aufmerksamkeit verhelfen, ist keine neue These. Techniksoziologin Zeynep Tufekci bezeichnete bereits vor über einem Jahr YouTube als „den großen Radikalisierer“, sie stützte sich dabei aber vor allem auf Einzelbeispiele.

Ein Team um den brasilianischen Informatiker Manoel Ribeiro hat sich jetzt noch einmal des Themas auf Basis eines großen Datensatzes von über 300.000 Videos, zwei Millionen Empfehlungen und 79 Millionen Kommentaren angenommen. In ihrem am Portal arXiv.org frei verfügbaren – allerdings noch nicht begutachteten – Beitrag „Auditing Radicalization Pathways on YouTube“ versuchen sie Radikalisierungspfade auf YouTube nachzuzeichnen. Ihr Fazit (S. 2; meine Übersetzung):

Wir liefern starke Belege für Radikalisierung unter YouTube-Nutzern sowie dafür, dass YouTubes Empfehlungssystem das Entdecken von rechtsextremen Kanälen unterstützt, und das sogar in einem Szenario ohne Personalisierung.

Zu diesem Ergebnis gelangen die Autoren auf Basis einer Analyse von kommentierenden Nutzer:innen. Diese sortieren sie zunächst in drei Kategorien unterschiedlicher Radikalität:

- Mit Eric Ross Weinsteins Begriff des „Intellectual Dark Web“ (I.D.W.) werden rechte Anti-Mainstream-Kanäle bezeichnet, die sich durch Kritik an politischer Korrektheit, Feminismus sowie politischem Islam profilieren.

- Als „Alt-Lite“ wiederum werden Videos und Kanäle bezeichnet, die offen nationalistische und latent rassistische Positionen einnehmen.

- In der dritten und extremsten Gruppe der „Alt-Right“ werden offen Thesen rassistischer Überlegenheit („White Supremacy“) vertreten. Grenz- und Zweifelsfälle bei der Zuordnung von Kanälen zu den drei Clustern seien, so die Autoren, in die jeweils weniger radikale Kategorie einsortiert worden.

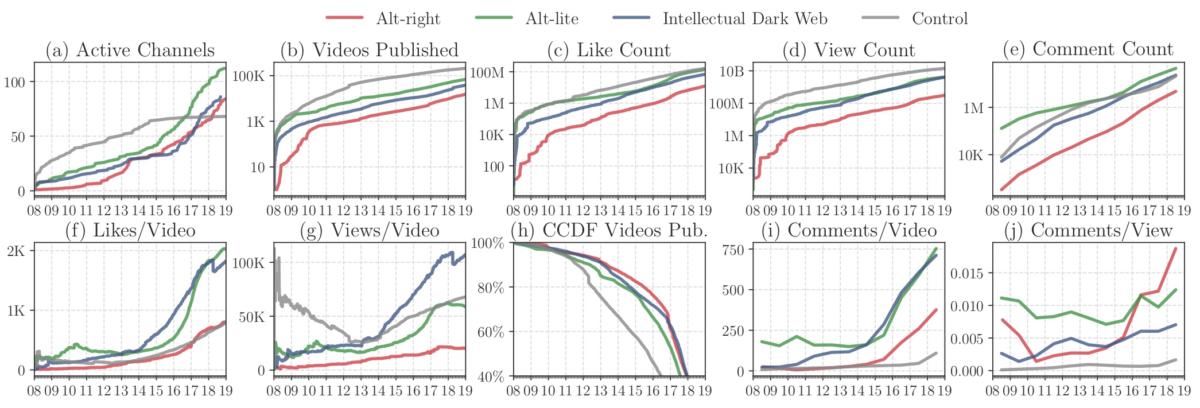

Diese drei Gruppen werden mit einer Kontrollgruppe von traditionellen Medienkanälen auf Youtube verglichen. Eine historische Analyse von Videos, Views und Kommentare der letzten zehn Jahre zeigt dabei ein starkes Wachstum in allen drei rechten Kategorien im Vergleich zur Kontrollgruppe (siehe Abbildung 1). Dabei nehmen vor allem auch Interaktionsraten zu, je radikaler ein Kanal ist.

Pfade der Radikalisierung

Zur Untersuchung der Frage nach „Radikalisierungspfaden“, also ob YouTubes Empfehlungsalgorithmen einen wesentlichen Beitrag zum Wachstum extremerer Kanäle leisten, fokussieren die Autoren in den weiteren Analyseschritten auf Kommentare. Auf Basis verschiedener statistischer Ähnlichkeits- und Überlappungsmaße zeigt sich hierbei im Zeitverlauf eine Angleichung zwischen den drei Kategorien I.D.W., Alt-Lite und Alt-Right.

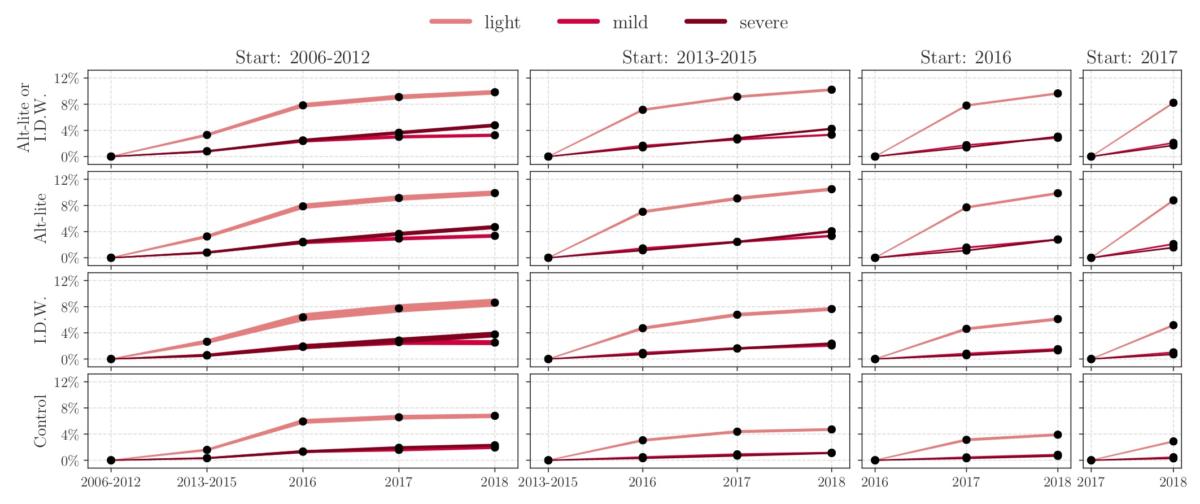

Um zu zeigen, wie genau diese Angleichung passiert ist, verfolgen die Autoren schließlich Kommentaraktivitäten von Nutzer:innen, die zunächst nicht unter Alt-Right-Videos kommentieren. Verglichen mit der Kontrollgruppe steigt der Anteil unter I.D.W.- und Alt-Lite-Nutzer:innen, die in der Folge verstärkt auch unter Alt-Right-Videos kommentieren, stärker an. Darauf, dass es sich bei den Kommentaren nicht um Kritik sondern tendenziell eher um zustimmende Kommentare handeln dürfte, deutet wiederum die quasi „händische“ Untersuchung von 900 zufällig ausgewählten Kommentaren hin.

Nutzervideos und YouTubes Beitrag

Im letzten Teil der Untersuchung widmen sich Ribeiro und Kollegen schließlich YouTubes Empfehlungsalgorithmus und legen nahe, dass auch 2019 noch ein relevanter Teil der Nutzer:innen über YouTubes Empfehlungsalgorithmen zu rechtsextremen Inhalten gelangt. Hier kämpfen die Forscher jedoch damit, dass Empfehlungseffekte besonders stark von Personalisierungsalgorithmen beeinflusst sind, die sich mit der gewählten Methode nicht erfassen lassen (so auch bei einer ähnlichen Analyse des Guardians bzw. das Projekt algotransparency.org). Auch der Untersuchungszeitraum ist kürzer, weil eine historische Erhebung von Empfehlungen schwierig bis unmöglich ist. Zu den interessantesten Ergebnissen der vorhandenen Daten zählt dabei, dass mehr Kanalempfehlungen aus der Kontrollgruppe zu Alt-Lite und I.D.W.-Kanälen führten als umgekehrt.

Zusammengefasst befeuern die Ergebnisse der Studie von Ribeiro und Kollegen Diskussionen über unbeabsichtigte Effekte von Empfehlungsalgorithmen auf großen Online-Plattformen. Hinzu kommt, dass die Effekte bei Berücksichtigung von Empfehlungspersonalisierung eher noch stärker ausfallen dürften. Umso wichtiger ist deshalb die Frage, wie alternative Empfehlungsmechanismen gestaltet werden könnten, egal ob man diese dann als „demokratische Algorithmen“ bezeichnen möchte oder nicht.

Im Umkehrschluss könnte man jedoch auch sagen das Youtube und andere „Soziale“ Netzwerke somit durch die Gewichtung der Inhalte wenn Sie denn wollten durchaus auch Einfluss auf die politische Kultur eines Landes nehmen könnten. z.B. wenn bei eingabe von politischen Suchbegriffen bestimmte Inhalte mit eingestreut werden. Wer nach Rechtsextremen Suchbegriffen sucht könnte als z.B. ein paar Videos zum Thema Menschenrechte usw mit unter gestreut bekommen.

Ich denke das das für Youtube keine so große Sache wäre und dabei helfen könnte der Radikalisierung entgegen zu wirken.

Solche Überlegungen waren auch Grund für dieses Interview zum Thema „Demokratische Algorithmen“: https://netzpolitik.org/2019/neues-aus-dem-fernsehrat-44-charlotte-echterhoff-ueber-demokratische-algorithmen

Viel Spaß beim Lesen und VG

Ich bin mir nicht sicher, ob die Definition von „Alt-Lite“ richtig ist. Wikipedia zum Beispiel (https://en.wikipedia.org/wiki/Alt-lite, Stand 26.08.) besagt ausdrücklich, dass Angehörige *nicht* (weiß-)Nationalistisch oder Rassistisch sind. Ausserdem sagt Wikipedia, dass die Grenze zwischen „Alt-Lite“ und „Alt-Right“ nicht klar gegeben ist, die Daten zur tatsächlichen Radikalisierung sind mir fragwürdig. Die Kategorie „IDW oder Alt-Lite“ ist mir auch nicht schlüssig, es könnten auch die Einzelteile zusammengetragen sein.

Eine der ersten Auffälligkeiten beim ersten Betrachten der oberen Tabellen ist, dass unabhängige, moderate Journalisten und Kommentatoren à Tim Pool oder Carl Benjamin beliebter sind als konventionelle Medien (NBC, The Guardian, CNN etc) sowie Ribeiros Definition von Alt-Right. Meiner Ansicht nach ein Schritt in Richtung politische Mitte.

Ich möchte Ribeiro und seinen Kollegen keine politischen Absichten vorwerfen, aber entweder ist die Zusammenfassung falsch gezogen oder es wurde die falsche Zusammenfassung gezogen.

Aber nicht vergessen, dass MEnschen sich noch konkret radikalisieren müssen.

Von der Weise wie Statistiken oftmals zustandekommen, wissen wir, dass Menschen auch mal „joh könnte ich mir vorstellen“ und nach kurzfristiger Indoktrination auch „die sind doof“ antworten oder schreiben.

Für eine tatsächliche Untersuchung der Umstände einer Radikalisierung braucht es eigentlich auch sinnfällige Kriterien der Feststellung. Dazu könnten wiederholtes und langfristigeres verweilen [nicht Youtubeaccountleichen die etwas abbonnierrtt haben] in den Sphären solchen Kommentierens oder handelns zählen.

Vermutlich ist die Idee, „Radikalisierung“ so verstanden wissen zu wollen, das bereits radikalisierte durch weitere Berieselung im Radikalisiertsein bestärkt werden.

Im Grunde ist das alles etwas fehlgerichtet. Es ist grundsätzlich falsch, einen Empfehlungsalgorithmus für eine einheitliche Darstellung zu verlangen – sie können die Menschen nur durch Formen der Symmetrie und der Ermächtigung zur geltung bringen. D.h. die Empfehlungsalgorithmen machen Annahmen… sortiert die Ergebnisse nach diesen Annahmen und macht sie transparent sichtbar (Videos politisch ähnlich / statistisch häufige clickfolge / etc). Alles andere dient weiterhin der Verdummung, und werden letztlich als lustiges Appeasement in die Geschichte eingehen.

In der Wissenschaft ist das falszifieren eine verbreitete Methode.

Die Zunahme solcher Kanäle geht nach meinen Beobachtungen auf die einseitige Sicht der Dinge auf anderen Kanälen einher. D.h. diese Ergebnisse müsste mit einer Zunahme von linken Inhalte anderswo korrelieren. Gibt es dazu Untersuchungen?

Mich verwundert auch immer wie die politische Einordnung erfolgt. Für mich wäre es dazu wichtig zu wissen wie jemand zu Krieg, Entwicklungspolitik, Umwelt, EU, Sicherheit, Armutsbekämpfung usw steht, um ihn einzuordnen.

Islamkritik und feminismus sind reine soziale Themen, wo es um den Umgang miteinander geht, aber das sind keine Themen die für Politik eine grosse Rolle spielen sollten. Es sei denn man betrachtet den Staat als Gebilde, das uns alle steuert. Was ich nicht hoffe.