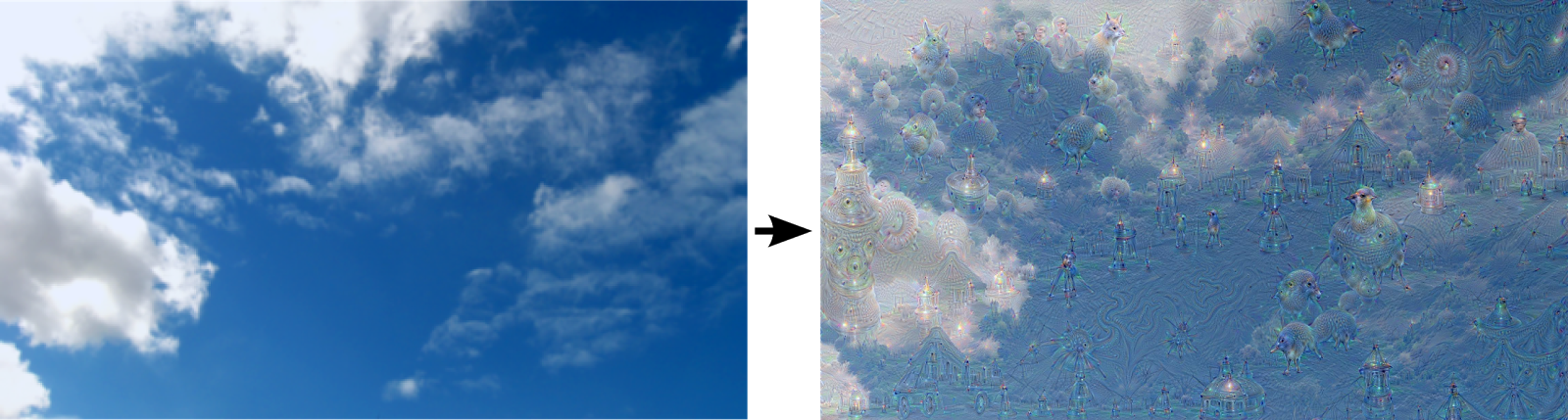

Vor drei Jahren berichtete Google über ein Experiment: Um genauer zu verstehen, wie ein neuronales Netz zur Bilderkennung funktioniert, wurde dieses so konfiguriert, dass es Objekte graphisch verstärkt, die es in einem Bild „erkennt“. Stößt das neuronale Netz auf ein zuvor erlerntes Muster in einem Teil des Bildes, passt es das Bild so an, dass es dem vermeintlich erkannten Objekt immer ähnlicher sieht. Die Effekte sind verblüffend: So wie Menschen manchmal Figuren in Wolken sehen, „erkannte“ das Bilderkennungsnetz in einem bewölkten Himmel plötzlich Fantasievögel.

Das Beispiel stellte die verbreitete Ansicht, dass Maschinen neutraler als Menschen seien, infrage. Und dennoch bewirkte es keinen öffentlichen Aufschrei, obwohl ähnliche Mustererkennungsverfahren auch in weitaus sensibleren Bereichen wie biometrischer Gesichtserkennung zum Einsatz kommen. (Dort werden sie mitunter zu Unrecht als Allheilmittel gepriesen.) Im Gegenteil: Dem großen kalifornischen Unternehmen gelang es, aus dem Bug kurzerhand ein Feature zu machen, indem es die Bilder auch als „maschinelles Träumen“ und kreative Leistung präsentierte. Das faszinierte und stieß auf breites öffentliches Interesse, sodass die generierten Bilder als Kunst verkauft werden konnten – für den guten Zweck.

Musterbasierte Diskriminierung: technisch und sozial

Stellt sich die Frage: Ende gut, alles gut? Ganz und gar nicht, glaubt man den Beiträgen von vier Medienwissenschaftler*innen in einem kürzlich bei Meson Press und University of Minnesota Press erschienen Open-Access-Sammelband. Der Titel „Pattern Discrimination“ (deutsch: Musterunterscheidung, Musterdiskriminierung) spielt auf die Doppeldeutigkeit von „Diskriminierung“ als technisches und als gesellschaftliches Phänomen an. Die Autor*innen stellen Fragen danach, inwiefern die Diskriminierung auf der Grundlage von Geschlecht, Klasse und race, implizit in algorithmischen Systemen zur Mustererkennung enthalten ist. Denn Mustererkennung sei nicht nur ein aufregendes, digitales Tool, sondern auch als ein Resultat von politischen, wirtschaftlichen und kulturellen Entwicklungen zu verstehen. Einige Verfahren werden seit Jahren eingesetzt und sind Alltagspraxis, in den Vereinigten Staaten auch in Gerichtsverfahren. Anhand vieler Beispiele bekommt man einen Eindruck davon, wie vielfältig und komplex das gesellschaftliche Terrain rund um Mustererkennungsverfahren ist.

Das Buch hat eine originelle Form. Es besteht aus vier essayistischen Texten, die aufeinander aufbauen und Thesen aus den anderen Beiträgen weiterentwickeln. Die Autor*innen spielen damit, dass am Thema Mustererkennung auch in anderen Disziplinen als der Informatik geforscht wird. Sie stellen Bezüge zur Psychoanalyse, den Geisteswissenschaften und der Hermeneutik her. Dadurch verschwindet der rote Faden stellenweise. Andererseits führt die Breite der Beispiele und Disziplinen dazu, dass immer wieder neue Verbindungen und Ideen aufblitzen, die man so noch nirgends gelesen hat.

Die Erzählung von sauberen Daten

Hito Steyerl, Medienkünstlerin und Professorin an der Berliner Universität der Künste, setzt an der untersten Ebene an – dort wo Informationen gesammelt und zu Daten aggregiert werden. Mustererkennung sei kein reibungsloses Unterfangen, sondern habe mit Unmengen an verschmutzten Daten zu kämpfen: „Daten sind ein überwältigender Ozean, mehr Landschaft als Bibliothek, mehr Rohmaterial als gebündelte Nachricht, mehr Ableitungen als Gegebenheiten.“

Wie sie richtig erkennt, liegt ein großes Problem darin, dass diese Realität verkannt wird: Wenn große Datenanalyseunternehmen verschmutzte Daten als lösbares Problem darstellen, steht dahinter die Grundannahme, dass saubere Daten, die unsere gesellschaftlichen Verhältnisse vermeintlich objektiv abbilden, ein erreichbares Ziel sind. Mustererkennung soll als riesiger Datenfilter fungieren, der das „Meer an Daten“ so lange filtert, bis es sauber und klar ist. Auch Florian Cramer, Wissenschaftler an der Willem de Kooning Akademie in den Niederlanden, betont, dass Daten vielfach als rein quantitativ, selbsterklärend, wertneutral und beobachterunabhängig missverstanden werden.

Die Singularität ist schon da

Hito Steyerl schlägt einen Blickwechsel vor: Getrübt und verklärt ist nicht „das Datenmeer“, sondern der Blick auf dieses. Das, was aus „Kontaktmetadaten, Beziehungsnetzen (…) oder nur einem Haufen Fake News“ destilliert wird, stelle nicht unsere gesellschaftlichen Verhältnisse dar. Daten müssen als „Chaos menschlichen Lebens“ anerkannt werden, hinter dem sich erst einmal nichts weiter versteckt. In ihrem Essay wird deutlich, wie ein verklärter Blick auf Daten als einfache selbstverständliche Ressource, wie sie etwa die beliebte Metapher von Daten als neuem Öl propagiert, dazu führen kann, Künstliche Intelligenz als nahende technologische Singularität, und damit entweder als messianischen Heilsbringer oder nahenden Weltuntergang anzusehen. Das zeigt sich zum Beispiel in religiösen KI-Sekten, die sich im Silicon Valley bilden, aber auch bei zahlreichen Regierungen weltweit, die momentan viel Geld und Hoffnung in die Entwicklung von KI stecken.

Die wahre, und auch heute schon wirksame Singularität in unserer Gesellschaft seien die Märkte, hält Hito Steyerl dem entgegen. „Wir leben in mythischen Zeiten, wir wissen es nur nicht“, kommentiert die kanadische Professorin für New Media Wendy Chun an späterer Stelle den Glauben daran, dass datenbasierte Wahrheitsfindungen menschlicher Erkenntnis von vornherein überlegen sind.

Vorannahmen kommen durch die Hintertür

Sieht man Daten auch als chaotischen Ausdruck menschlichen Lebens an, wird deutlich, dass Mustererkennungsverfahren, wie sie heute eingesetzt werden, ihre Grenzen haben. „Rechnergestützte Datenanalyse (…) beschränkt sich darauf, was als quantitativ-syntaktische Operationen ausgedrückt und von Algorithmen verarbeitet werden kann“, betont Florian Cramer. Werden qualitative Daten automatisiert mit quantitativen Methoden verarbeitet, gehe notwendigerweise etwas verloren, das durch kritische Interpretation und semantische Analyse aufgefangen werden kann.

Zudem beruhen Grundoperationen der Mustererkennung, wie Datenfilterung oder -Unterscheidung, bereits auf statistischen und politischen Vorannahmen. Sie geben vor, was letztendlich als Muster erkannt wird und was nicht. Das eingangs beschriebene Experiment von Google veranschaulicht dies: Die Software „erkannte“ Muster, mit denen sie zuvor trainiert wurde, obwohl sie nicht in den Bildausschnitten selbst versteckt waren. Eine offensichtliche Grenze von Mustererkennung liegt darin, dass sie eben nicht erkennen kann: „Algorithmen sehen nicht (…) sie träumen und haben Visionen“, die durch ihren Aufbau und die Datenbasis determiniert sind, schreibt Hito Steyerl.

Wenn die Liebe des Gleichen Modell macht

Die Marktlogik ist, so Wendy Chun, auch tief in wichtigen Mustererkennungsverfahren verankert, mithilfe derer Plattformen wie Facebook Massen an individuellen Daten sortieren und klassifizieren. Eine wichtige Annahme hinter diesen Verfahren ist, so Wendy Chun, das eigentlich soziologische Modell der Homophilie. Es wird als Modell zur Strukturierung von sozialen Netzwerken genutzt und beruht auf der Idee, dass Ähnlichkeiten zu Verbindungen führen („similarity breeds connection“), oder „der Freund meines Freund ist mein Freund“, wie Facebook es einem immer wieder versucht nahezulegen.

Individuen werden auf Grundlage ihrer angeblichen Kaufkraft und anderer Merkmale – beispielsweise bis zu einer Kategorie mit Nutzer*innen, die antisemitische Seiten geliked haben – in Nachbarschaften gruppiert. Zu den dadurch entstehenden Netzwerken von sozial als ähnlich oder unterschiedlich bewerteten Nutzer*innen verkauft Facebook seinen Werbekunden dann Zugang. So wird aus einer nicht unbedingt verbundenen Gruppe von Individuen, die antisemitische Botschaften verbreiten, eine für Werbekunden adressierbare Zielgruppe. Nachrichten verbreiten sich unter denen, deren Signale sich laut Mustererkennungsverfahren ähneln, die als Gleich oder Ähnlich identifiziert werden.

Das Modell der Homophilie, wie es heute benutzt wird, ist reaktionär und für Echo-Kammern mitverantwortlich. Denn es „wertet Konsens, Balance und ‚Komfort‘ auf: Dadurch, dass der Fokus auf individuellen ‚Vorlieben‘ und nicht institutionellen Zwängen und Rassismus liegt, wird Segregation vorausgesetzt und bestätigt“. Das erkläre auch teilweise die strukturell verankerte Gewalt online: Die Kategorie „Freund“, die Facebook so gerne nutzt, verkommt zu einer Verschleierungstaktik, die Gewalt, Hass und Konfliktlinien maskiert: „Netzwerkforschung macht nicht nur die Modellierung von Konflikten scheinbar unmöglich, sie tut es auch dadurch, dass sie Konflikte als Freundschaft versteckt“, so Wendy Chun.

Mustererkennung ist keine Einbahnstraße

Die Beiträge des Bandes, so Clemens Apprich, zeigen auf unterschiedliche Weise, inwiefern sich Voreingenommenheit und Technikglaube durch drei wichtige Ebenen in der Informationsgesellschaft ziehen: Von der Transformation von Information in Daten, über die Verfahren der Mustererkennung selbst bis hin zum Umgang mit den oft als „objektiv“ missverstandenen Ergebnissen. Sie machen deutlich, wie wichtig und zeitkritisch eine Auseinandersetzungen mit den Technologien ist, wenn sie nicht nur die Wirtschaft, sondern auch Schutz vor Diskriminierung, Bürgerrechte und Demokratie stärken sollen.

Clemens Apprich schreibt, dass die Herausforderung des Buchs war, „weder den weitverbreiteten Glauben zu wiederholen, dass Algorithmen schlicht zu komplex seien um verstanden zu werden, noch auf den Köder hereinzufallen, das Probleme dadurch gelöst werden können, dass jeder Kommunikationsschritt transparent gemacht wird.“ Diesen Spagat schafft das Buch. Es produziert neue Einsichten, die zeigen, dass interdisziplinäre Ansätze mit einem Blick für menschliche Werte und Schicksale bei der weiteren Erforschung von Mustererkennungsverfahren eine Rolle zu spielen haben.

So etwa die schlichte und hilfreiche Erkenntnis, dass Mustererkennung und die heute damit verbundenen identitätspolitischen, teils vorurteilsgetriebenen Voraussagen über menschliches Handeln keine Einbahnstraße sind. Die „Ausbreitung von Echo-Kammern und die Ausradierung von Politik ist nicht unabwendbar – wir können sie zu sich selbst widerrufenden Prophezeiungen machen.“, erklärt Wendy Chun. Das passiere schon teilweise im gesellschaftlichen Umgang mit den Ergebnissen von Klimamodellen. Sie sind für viele politisch Aktive ein Anreiz dazu, diese Version der Zukunft zu verhindern, oder andersherum: „Die Kluft zwischen Vorhersage und Realität ist der Ort für politisches Handeln.“

Sehr schön erkannt!

Jetzt wird die ganze Welt nochmal neu entdeckt. Diesmal aber elektrisch.

Hefter Raus! Textaufgabe:

Was ist nun wirklich neu und gabs nicht schon analog?

Joa, da war was!

https://de.wikipedia.org/wiki/Neolithische_Revolution

https://de.wikipedia.org/wiki/Industrielle_Revolution

Aber du weist ja, Geschichte ist etwas für die ewig gestrigen!

Warum aus der Geschichte lernen, wenn es doch einfacher ist, die Fehler zu wiederholen?

Hallo,

bei der Übersetzung von „Pattern Discrimination“ hat sich sicher ein Fehler eingeschlichen, oder?

Mustererkennung heißt auf Englisch doch „pattern detection“, womit „Pattern Discrimination“ eher sowas wie Musterdiskriminuerung heißen müsste, oder?

Viele Grüße

Danke für die Rückmeldung! Wir sehen das auch so, Mustererkennung ist an der Stelle nicht präzise, Musterdiskriminierung oder Musterunterscheidung passt besser. Mustererkennung würde aber eher mit „Pattern Recognition“ übersetzt werden. Im Buch selbst schreibt Clemens Apprich übrigens zur Terminologie Folgendes:

“While the word discrimination originates from the Latin verb discriminare, where it simply means ‚to separate, to distinguish, or to make a distinction,‘ it was in the late nineteenth century that it became overtly political. In parallel to the development of racist ideology, discrimination since then has referred to a prejudicial treatment of individuals based on a social category (e.g., race, gender, sexuality, age, class). However, in different terminologies the original meaning of the term has been preserved. This is why in computer science “pattern discrimination” is still used as a technical term to describe the imposition of identity on input data, in order to filter (i.e., to discriminate) information from it. But far from being a neutral process, the delineation and application of patterns is in itself a highly political issue, even if hidden behind a technical terminology. The point of this book is to trace and uncover the implicit ties between the ideological and technical uses of discrimination, as we can experience it in algorithmically enhanced systems of pattern recognition.” (S. x)