Zu schreiben, es sei ein dramatisches Jahr in Sachen Künstliche Intelligenz gewesen, ist vermutlich noch untertrieben. 2018 war das Jahr, in dem öffentlich wurde, dass Cambridge Analytica Millionen Menschen auf Basis ihrer Facebook-Daten algorithmisch analysierte. Ein selbstfahrendes Uber-Fahrzeug tötete eine Fußgängerin, Google wollte Künstliche Intelligenz für das Drohnenprogramm des US-Verteidigungsministeriums liefern und brachte damit seine eigenen Leute auf. In Großbritannien wurden tausenden Studenten durch eine Spracherkennungssoftware die Visa entzogen und in Österreich diskriminiert ein Algorithmus der Jobcenter nun Ausländer*innen, Mütter und Ältere bei der Vergabe von Förderung. Das waren nur einige Schlagzeilen aus den vergangenen zwölf Monaten.

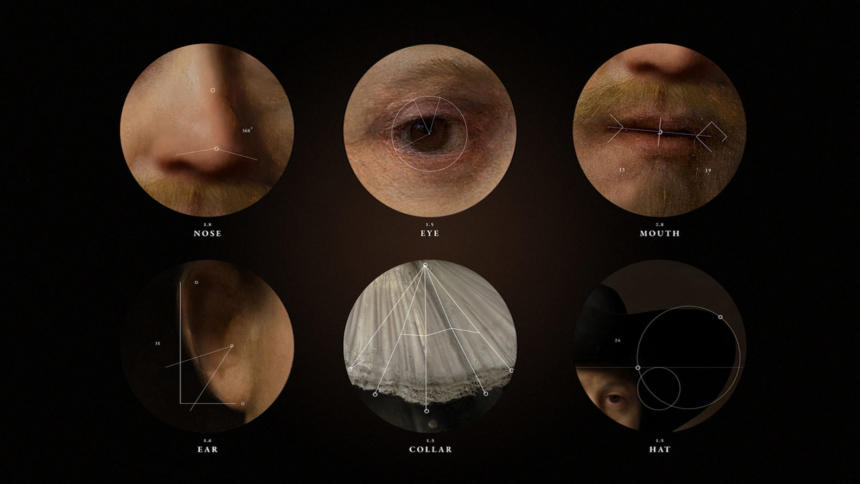

2018 war auch das Jahr, in dem automatisierte Gesichtserkennung mächtig Fahrt aufnahm. Nach Amazon bieten jetzt auch Facebook und Microsoft die Technologie als Dienstleistung an, die sich jeder mit genug Geld einkaufen kann. In den USA arbeiten bereits die Polizeibehörden von Orlando und New York mit einer solchen Software. In Deutschland nutzt neben dem Bundeskriminalamt zum Beispiel auch Hamburg Software zur automatisierten Gesichtserkennung. Am Berliner Bahnhof Südkreuz läuft die zweite Phase eines Pilotprojektes zur „intelligenten Videoüberwachung“.

Gesichtserkennung: Wer schützt die Öffentlichkeit?

Das New Yorker Forschungsinstitut AI Now warnt jetzt in seinem Jahresbericht (hier als PDF) vor den Folgen für die Öffentlichkeit, wenn diese Technologie nicht streng reguliert wird. Staaten seien in der Pflicht, enge Grenzen für den Einsatz zu ziehen. Es reiche nicht aus, auf die Verwendung von Gesichtserkennung im öffentlichen Raum hinzuweisen. Mit Blick auf die Massenüberwachung, die durch die Technologie möglich wird, müsse die Zustimmung aller eingeholt werden, die davon betroffen sein könnten. Communities sollten das Recht haben, sich der Gesichtserkennung nicht auszusetzen, egal ob in privaten oder in öffentlichen Zusammenhängen.

Besondere Sorgen machen sich die Forscher*innen auch um die so genannte „Affekterkennung“, eine Unterkategorie der Gesichtserkennung, die behauptet, mit Hilfe von Fotos oder Videos Aussagen über die Persönlichkeit, die Gefühlslage oder die Motivation einer Person treffen zu können. Es existierten keinerlei verlässliche Studien, die diese Behauptungen stützen, warnt der Report. Trotzdem werde diese Technologie bereits in Bewerbungsgesprächen, bei der Vergabe von Versicherungen oder in der Polizeiarbeit eingesetzt.

Die Frage nach der Verantwortung

Am Ende läuft jede neue Schlagzeile, jeder öffentliche Skandal auf die gleiche Frage hinaus, schreiben die Autor*innen des Reports: Wer trägt eigentlich die Verantwortung? Wer kann also zur Rechenschaft gezogen werden, wenn eine Künstliche Intelligenz Menschen tötet, fälschlicherweise zu Kriminellen erklärt, falsche Diagnosen ausstellt oder ihnen auf andere Arten Schaden zufügt? Sind es die Hersteller, die die Algorithmen bauen und mit Daten trainieren? Sind es die Behörden oder Firmen, die die Technologien einsetzen? Oder etwa der Algorithmus selbst, wie es das Europäische Parlament in einer Resolution vorgeschlagen hat, das Roboter gerne zu „elektronischen Personen“ erklären würde, die selbst für ihr Fehlverhalten haften? Diese Frage sei noch weitgehend ungeklärt, schreiben die Autor*innen des US-Reports, werden sich aber immer drängender stellen, je weiter maschinelles Lernen und Künstliche Intelligenz in unsere Gesellschaft hineinwirken.

Detailwissen statt große KI-Aufsicht

Interessant ist dabei eine Empfehlung, die AI Now in Hinblick auf die Regulierung gibt. Sie empfehlen Regierungen, keine nationale Aufsicht für alle möglichen Einsatzfelder von Künstlicher Intelligenz zu schaffen, sondern die Befugnisse von sektorspezifischen Behörden auszuweiten. In Bereichen wie Gesundheit, Bildung, Sozialhilfe oder Justiz müssten je eigene Strukturen geschaffen werden, um den Einsatz von Künstlicher Intelligenz zu regulieren, zu beaufsichtigen und im Zweifel zu korrigieren. Eine nationale Aufsichtsbehörde könne gar nicht genug Detailwissen in all diesen Bereichen bündeln, um nuanciert regulieren zu können.

Der Bundesregierung schwebt anderes vor. In der Ende November vorgestellten KI-Strategie geht es an sehr vielen Stellen darum, wie die deutsche Forschung und der Einsatz von KI in deutschen Unternehmen gefördert werden soll, um Deutschland im internationalen Wettbewerb hinter China und den USA nicht ganz so schmächtig aussehen zu lassen. Nur an einigen wenigen Stellen dreht sich die Strategie überhaupt um die Frage von Regulierung. Dafür ist unter anderem vorgesehen, ein deutsches „Observatorium für künstliche Intelligenz“ einzurichten, das die Verbreitung und Auswirkungen von KI beaufsichtigen soll, vor allem in Hinblick auf Arbeit. Deutschland plant also genau das, wovon der Report abrät.

Die vielen drängenden Fragen zu Rechenschaft und Verantwortlichkeit aus dem Bericht, die sich stellen, wenn künstliche Intelligenzen Entscheidungen über das Leben von Menschen treffen, beantwortet die Regierung in ihrer Strategie nicht. Diese delegiert sie in die Enquete-Kommission Künstliche Intelligenz der Bundestages, die darüber hinter verschlossenen Türen diskutiert.

Wie soll denn bitte ein Algorithmus Verantwortung für sein Fehlverhalten übernehmen? Und wie soll dieser dann zur Rechenschaft gezogen werden? Versteh ich was nicht oder das EU-Parlament?

Sind wir schon in der Matrix?

Algorithmen, die unsere Verhaltensmuster studieren und speichern.

So sind wir bald alle virtualisiert? Werden wir schon bald im Rechner simuliert?

Algorithmen, die uns anschauen und verstehen…..vielleicht.

Full context of the Motion for a resolution (never mind the fight club, don’t.)

59. Calls on the Commission, when carrying out an impact assessment of its future legislative instrument, to explore, analyse and consider the implications of all possible legal solutions, such as:

a) establishing a compulsory insurance scheme where relevant and necessary for specific categories of robots whereby, similarly to what already happens with cars, producers, or owners of robots would be required to take out insurance cover for the damage potentially caused by their robots;

b) ensuring that a compensation fund would not only serve the purpose of guaranteeing compensation if the damage caused by a robot was not covered by insurance;

c) allowing the manufacturer, the programmer, the owner or the user to benefit from limited liability if they contribute to a compensation fund, as well as if they jointly take out insurance to guarantee compensation where damage is caused by a robot;

d) deciding whether to create a general fund for all smart autonomous robots or to create an individual fund for each and every robot category, and whether a contribution should be paid as a one-off fee when placing the robot on the market or whether periodic contributions should be paid during the lifetime of the robot;

e) ensuring that the link between a robot and its fund would be made visible by an individual registration number appearing in a specific Union register, which would allow anyone interacting with the robot to be informed about the nature of the fund, the limits of its liability in case of damage to property, the names and the functions of the contributors and all other relevant details;

f) creating a specific legal status for robots in the long run, so that at least the most sophisticated autonomous robots could be established as having the status of electronic persons responsible for making good any damage they may cause, and possibly applying electronic personality to cases where robots make autonomous decisions or otherwise interact with third parties independently;

g) introducing a suitable instrument for consumers who wish to collectively claim compensation for damages deriving from the malfunction of intelligent machines from the manufacturing companies responsible;

Affekterkennung und dergleichen sind anmaßende technofaschistische Übergriffe in die inneren Angelegenheiten souveräner Individuen und gehören geächtet … wer sie geil findet und nicht in aktive Fundamentalopposition tritt, wird sich bald in einer Dystopie wiederfinden, bei der selbst gewisse bescheuerte „Die Welt“-Leitartikler nicht mehr behaupten können werden, sie hätte nichts mit 1984 zu tun … gute Miene zum bösen Spiel, sonst ist der Social Credit Score deiner Freunde im A****.

Siehe auch: iBorderCtrl.no

Dieser Beitrag verwendet den Begriff „Künstliche Intelligenz“ irreführend und falsch. Das zeigt sich schon daran, dass er teilweise als Synonym zu „Algorithmus“ verwendet wird. Aber auch daran, dass „Gesichtserkennung“ als KI bezeichnet wird. Dabei hattet ihr doch selbst darauf verwiesen, dass das verschiedene Dinge sind: https://netzpolitik.org/2018/diagramm-ist-das-kuenstliche-intelligenz-oder-bloss-ein-daemlicher-bot/