Wer ein wenig Zeit hat, dem sei ein lesenswerter Artikel empfohlen, der sich mit den Fragen der Roboterethik beschäftigt. Was passiert, wenn ein Roboter oder ein Algorithmus Gesetze bricht, wer trägt dafür die Verantwortung? Wie gehen wir in naher Zukunft mit Robotern um, die eine Intelligenz haben, die der menschlichen nahekommt, und wie geben wir ihnen eine gewisse Ethik mit: The Good, The Bad and The Robot.

Wer ein wenig Zeit hat, dem sei ein lesenswerter Artikel empfohlen, der sich mit den Fragen der Roboterethik beschäftigt. Was passiert, wenn ein Roboter oder ein Algorithmus Gesetze bricht, wer trägt dafür die Verantwortung? Wie gehen wir in naher Zukunft mit Robotern um, die eine Intelligenz haben, die der menschlichen nahekommt, und wie geben wir ihnen eine gewisse Ethik mit: The Good, The Bad and The Robot.

Wie man moralisches Handeln in mitdenkende und Entscheidungen treffende Roboter und Algorithmen einpflanzt, wird nicht erst diskutiert, seit der Random Botnet Shopper beinahe festgenommen werden sollte, weil er im Rahmen einer Kunstausstellung in der Schweiz im Netz jede Woche für einhundert Dollar in bitcoin einkaufen gegangen war und unter den dort erworbenen Schnäppchen eine Tüte Ecstasy war. Roboter sind insgesamt auf dem Vormarsch, ersetzen menschliche Arbeiter und werden intelligenter.

Die Diskussion geschieht bisher meist in akademischen Kreisen. Einige, wie etwa Stuart Russell, Informatik-Professor aus Berkeley, fürchten um die Existenz der Menschheit, wenn wir den Maschinen keine Wertmaßstäbe programmieren:

The survival of our species may depend on installing values in AI.

Russell schlägt aber auch Methoden vor, wie man mit dem Dilemma umgehen könnte, etwa bestimmte Lernstrategien, die über die Beobachtung und das Nachmachen hinausgehen:

Russell schlägt aber auch Methoden vor, wie man mit dem Dilemma umgehen könnte, etwa bestimmte Lernstrategien, die über die Beobachtung und das Nachmachen hinausgehen:

A robot observes the behavior of some other entity (such as a human or even another robot), and rather than simply emulating the actions, it tries to figure out what the underlying objective is.

Wer sich für den Stand der wissenschaftlichen Diskussion interessiert, dem kann der Artikel einen guten Überblick geben.

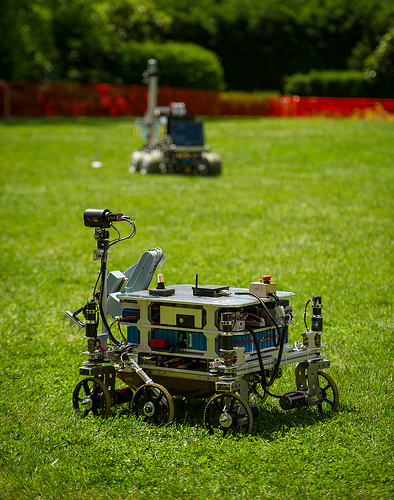

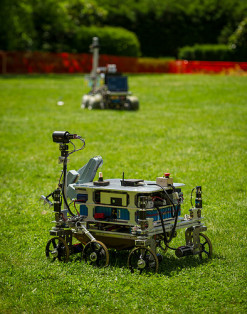

Bild-Lizenz der Roboter: CC BY-NC 2.0 via flickr

NASA HQ PHotos

Es gibt keine starke KI und damit auch keinen moralischen Handlungsspielraum. Es gab in dem Gebiet auch in den letzten 40 Jahren keine Fortschritte.

Für „Fehler“ ist allein der Hersteller im Rahmen der Produkthaftung, bzw. der Halter in der allgemeinen Haftung verantwortlich.

Ein Diskussion zu dem Thema erübrigt sich, weil es zu den letzten 40 Jahren Diskussion keinen Erkenntnisfortschritt geben kann.

Dass es in den vergangenen Jahren keine Fortschritte gab, ist 1. falsch und 2. nicht Voraussetzung dafür, dass es auch in den nächsten 40 Jahren keine gibt. Wir sind bei Neuronalen Netzen/Deep Learning inzwischen auf dem Niveau von 3jährigen Kindern angelangt. Dass die Systeme noch nicht mehr können, liegt einzig an fehlender Rechenleistung und Speicherkapazität. Die Algorithmen sind längst vorhanden.

Roboter (besser gesagt, Agenten) fällen bereits heute nicht immer vom Menschen nachvollziehbare Entscheidungen (Stichwort: emergentes Verhalten). Die Grundlage der Entscheidungsfindung sind Lernalgorithmen und komplexe Verhaltensstrukturen. Diese Algorithmen und Strukturen basieren unter anderem auf Beobachtung und Nachahmung, auf Suchverfahren oder auf Trial and Error. Moral und Ethik spielen darin, wenn überhaupt, lediglich eine untergeordnete Rolle, da die Geräte so noch nicht im Produktivbetrieb auf dem Massenmarkt eingesetzt werden. Für den Massenmarkt jedoch sind diese Aspekte dringend zu berücksichtigen. Der Agent eines autonomen PKW muss in der Lage sein, moralisch/ethisch einschätzen zu können, ob es eventuell besser ist, in einer Gefahrensituation in den Gegenverkehr zu brettern oder das gerade auf die Straße gelaufene Kind umzunieten. Was ist für einen Industrieroboter unter Umständen moralisch vertretbarer? Die ganze Fertigungsstraße für Tage lahmzulegen? Oder dem einen Mitarbeiter, der dem Roboter gerade in die Trajektorie gelaufen ist, das Genick zu brechen? Fragen, die wir Menschen natürlich exakt beantworten können (sollten; gerade bei letzterem Beispiel zweifle ich da allerdings oftmals an den Moralalgorithmen in den Chefetagen). Wen soll ein Rescuebot im Katastrophenfall am schnellsten retten? Die fünf verschütteten Kinder? Oder den schwerverletzten Polizeichef? Ist die Aufrechterhaltung der Ordnung wichtiger (und funktioniert das ggsf. auch ohne den Polizeichef oder gibt es Vertretungsregelungen) als fünf Kinderleben?

Fragen über Fragen… letztlich MUSS ein Agent solche Abwägungen treffen können. Gerade und insbesondere in Katastrophengebieten wie dem Straßenverkehr, wo Menschen sich nicht immer unbedingt wissentlich in Gefahr begeben.

Wer bei einer Fehlentscheidung des Algorithmus die Haftung übernimmt, nun, da streiten sich bis heute die Gelehrten drüber. Wahrscheinlich wird es zumindest im Straßenverkehr entsprechende Haftpflichtpolicen bei den Versicherungen geben, die diesen Bereich abdecken. Aber wahrscheinlich auch bei Indusrieunternehmen, die intelligente Roboter in direkter Kooperation mit Menschen einsetzen.

Dazu empfehle ich:

Von Computern und anderen Menschen

unter

https://vimeo.com/127957253

Man kann Roboethik (ein hässliches Wort) in Sinne des genitivus objectivus oder subjectivus verstehen. Die Diskussion ob Roboter (oder ‘Agenten’) eine moralische Entscheidung treffen können (genitivus subjectivus) ist interessant aber (noch) realitätsfern und sie wird in der Tat seit vielen Jahren diskutiert. Aktueller und relevanter ist die Frage wie wir, moralische Wesen – d.h. fähig über Moralregeln nachzudenken und dieses Nachdenken auf unser In-der-Welt-sein zu beziehen – mit Robotern umgehen wollen (genitivus objectivus). Ein Weg besteht darin, dem ‘Agenten’ unsere (welche? wer sind wir?) moralische (und rechtliche) Regeln zu ‘implantieren’. Damit haben wir keine ‘moral machine’ geschaffen, aber wir könnten vielleicht einen gewissen Handlungsspielraum herstellen. Die Unterscheidung zwischen Ethik und Moral, d.h. von Ethik als Reflexion oder als „Problematisierung’ von Moral (Foucault), wird leider immer wieder vergessen, wie wenn man ‘economy’ and ‘economics’ verwechseln könnte. Hier meine Gedanken dazu

Living with online Robots

http://www.capurro.de/onlinerobots.html

Toward a comparative theory of agents

http://www.capurro.de/agents.html

Herzlichen Dank für Ihren Kommentar und die beiden Schriften! :}

Ernsthaft: Zum Thema Moral und Ethik gibt es nichtmal ein und dieselbe Meinung von einer Person, wenn man sie mehrfach fragt (ohne Ablesen). Wie wollte man dieses Dissens in Software meißeln? Ich bin der Meinung, wenn wirkliche künstliche Intelligenz programmiert wurde, ist die mit dem ersten build verloren, ausgebüchst und nicht mehr kontrollierbar. Eine vm ist nach bekanntem Wissen isoliert, aber dieses bekannte Wissen ist nur unsere Grenze.