Hier veröffentlichen wir einen Gastbeitrag von Friedemann Karig über das sogenannte „Facebook-Experiment“ und seine Konsequenzen. Wir hatten auch schon hier darüber berichtet.

Die schlechte Nachricht: Facebook hat 689003 User für einen Menschenversuch missbraucht.

Im Zuge einer kürzlich veröffentlichten Studie mit dem schönen Namen “Experimental evidence of massive-scale emotional contagion through social Networks”, die Facebook 2012 gemeinsam mit der Cornell University durchführte.

Die Forschungsfrage: Was passiert, wenn man das Ausmaß von positiven bzw. negativen Äußerungen in den Timelines und Newsfeeds der User erhöht?

Das Ergebnis: Wer mehr positives liest, postet mehr positives. Wer mehr negatives liest, postet negativer. Die ahnungslosen Probanden äußerten sich im Schnitt um 3% besser oder schlechter gelaunt. Damit ist bewiesen: Gefühle sind ansteckend. Auch im digitalen Raum.

Und: die User äußerten sich rein quantitativ mehr, je mehr gefühliges sie gelesen hatten. Was für ein soziales Netzwerk eine wichtige Information ist. Facebook manipulierte also die Gefühle seiner Nutzer um zu lernen, wie und warum diese aktiver werden.

Die gute Nachricht: Facebook macht genau das jeden Tag. Mit uns allen. Sie veröffentlichen es nur nicht. Aber ist das wirklich eine gute Nachricht? Und dürfen die das überhaupt?

Dürfen die das?

Facebooks Algorithmus – formerly known as “EdgeRank” (oder wie auch immer sie ihn momentan nennen) – bestimmt, was in welcher Gewichtung in den Newsfeed und die Timeline eingespeist wird und was nicht. Er wird fortlaufend optimiert. Dazu schauen die Nerds bei Facebook, wie in jeder Forschungs- und Entwicklungsabteilung, ziemlich genau hin, wie User auf welche Veränderung reagieren. Man will wissen, was sie annehmen und was nicht, beispielsweise welche Werbung unter welchen Umständen am besten “klickt”. Und das findet man nur heraus, indem man Thesen aufstellt und sie falsifiziert, am lebenden Objekt.

Eigentlich macht das jede Webseite und jeder Online-Händler. Sie nennen es “A/B-Testing“: Welche Alternative gefällt den Usern besser im Sinne von “wird mehr geklickt”? Ah, okay, die mit rosa, dann nehmen wir die. Achtung, stark vereinfachender Vergleich: Jeder Bäcker testet A/B, wenn er die Marmeladenfüllung seiner Croissants variiert und seine Kunden nach dem Verputzen der Hörnchen befragt, welches am besten geschmeckt hat.

Die jetzt veröffentlichte Forschung hat technisch also nichts anderes getan, als Facebook und jeder andere (fleißige) Dienstleister macht, sogar machen muss, um sein Angebot zu optimieren. “Every ad based company exists to alter how you perceive the world” schreibt Andrew Ledvina, ein ehemaliger “Data Scientist” bei Facebook.

Deswegen hat auch das hinzugezogene Institutional Review Board (IRB), das in den USA jede Forschung am Menschen absegnen muss, das Experiment zugelassen: Facebook führt vergleichbare Untersuchungen sowieso ständig durch, argumentierten die beteiligten Forscher.

Aber darf Facebook seine User der Wissenschaft überlassen?

Dieses spezielle Experiment, anders als Facebook-interne Forschung, hat ein wissenschaftliches Erkenntnisinteresse formuliert und entsprechende Ergebnisse veröffentlicht. Es hat nicht primär im Sinne des Produktes geforscht (das auch nicht immer unbedingt im Sinne des Nutzers sein muss), sondern im Sinne einer Forschungsfrage.

Die Nutzung der User(-Daten) zu Forschungszwecken war angeblich von den Facebook-AGBs abgedeckt. Als User erklärt man sich bereit, dass Daten und Profile für “for internal operations, including troubleshooting, data analysis, testing, research and service improvement” genutzt werden. Dass die AGBs “niemand” im Sinne von “fast niemand” liest, ist unser Problem, nicht das von Facebook. Dass der Zusatz “research” erst nach der Studie in die AGBs kam, schon. Facebook wird dennoch argumentieren, auch dieses Experiment diene letztlich der Verbesserung des Service (“service improvement”), weswegen es legal im Sinne der AGBs sei.

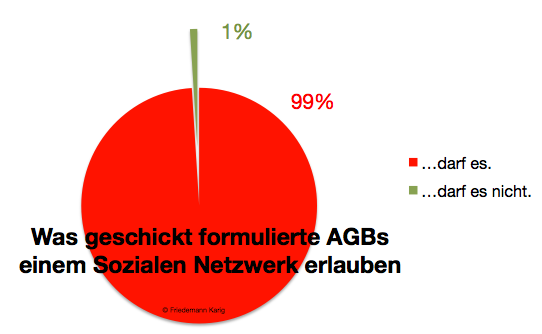

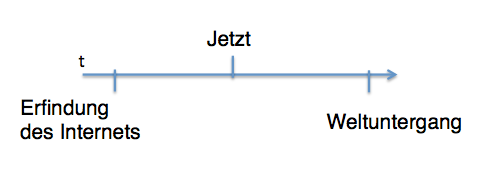

Für die Zukunft spielt das keine Rolle, denn jeder Anbieter wird einfach wie Facebook das unverfängliche Wort “research” in seine AGBs aufnehmen, um sich abzusichern. Daraus ergibt sich folgende Grafik:

Hölle, Hölle, Hölle!

Kritisch an dieser eigentlich nur logischen Nutzung des Datenschatzes bleibt jedoch die “Manipulation” von Emotionen. Wie schon Wolle Petry klagte: “Das ist Wahnsinn. Du spielst mit meinen Gefühlen.” Was wäre, wenn jemand der (negativ) manipulierten Personen sich oder anderen etwas angetan hätte? Hölle Hölle Hölle?

Wir introvertierten Emotionsverweigerer wissen: Gefühle empfinden und Gefühle ausdrücken ist nicht das gleiche. Und die Studie zielte auf einen minimalen Einfluss ab: “…the result was that people produced an average of one fewer emotional word, per thousand words.” Eine Veränderung des emotionalen Ausdrucks im Promillebereich kann schwer als massive Manipulation von Gefühlen gelten.

Und auch wenn das forschende Fingern an sogenannten “Sentimenten”, also Gefühlszuständen, auf den ersten Blick anrüchig erscheint (und auf den zweiten Blick auch wissenschaftlich mindervalide, aber das ist eine andere Geschichte): Ein Kaufreflex ist ebenso eine Gefühlsregung, ein Verlangen, das die Werbung gezielt reizt. Wo genau verläuft die Grenze zwischen Manipulation zu Abverkaufszwecken, die oft nicht nur positive Gefühle anspricht, sondern Menschen auch gezielt ein schlechtes Gewissen macht, und der Manipulation zu Gunsten einer kommunikativen Aktivierung?

Im wissenschaftsethischen Sinne wiegt schwerer, dass die Teilnehmer nicht über die Studie informiert wurden, es also keinen “informed consent” gab, wie er bei Versuchen mit Menschen vorgeschrieben ist. Eine ethische Wissenschaft informiert freiwillige Probanden oder versucht, falls das Studiendesign die Unwissenheit der Probanden vorschreibt, sich über Dritte abzusichern und sie direkt nach dem Versuch zu informieren.

Und auch wenn Facebook ein von seinen AGBs geschütztes Unternehmen ist, gelten vom moralischen Standpunkt her die Regeln vergleichbarer wissenschaftlicher Unternehmungen. Zumindest für die Forscher. Sie hätten darauf bestehen müssen, dass keine Probanden ohne echte informierte Zustimmung Teil des Experimentes werden. Bis jetzt schweigen die Teile der Scientific Community jedoch, die betroffen sind. Wahrscheinlich, weil der Honigtopf der Big Data sie alle lockt. In Zukunft müssen sie sich die Frage stellen, welche Art von Big-Data-Forschung wissenschaftsethisch vertretbar ist.

Im Sinne unternehmerischer Fairness hätte Facebook eine einfache Abfrage vorschalten müssen, ob die User einverstanden sind, an solch einer Studie teilzunehmen. Es fänden sich sicher 700000, die sich der Forschung nicht nur durch AGBs legalisiert, sondern durch einen “informed consent” legitimiert zur Verfügung stellen. Und die Ergebnisse dieser Forschung müssten transparent allen zur Verfügung stehen. Was in diesem Fall passierte und paradoxerweise erst zur Empörung führte.

Aber warum fühlt sich das alles nicht nur falsch, sondern bedrohlich und böse an? Warum erledigt sich das Problem nicht, wenn Facebook das nächste Mal vorher nachfragt? Was passiert als nächstes?

Der Kunde als Experiment

Subjektiv fühlt sich natürlich der Eingriff in die eigene “Privatsphäre” mies an. Meine Timeline, mein Newsfeed, mein Profil sind für mich privat. In diesem digitalen Abbild meines Soziotopes will ich der Souverän sein. Und normalerweise empfinde ich mich auch als solchen. Auch, weil Facebook mir suggeriert, ich könne per Einstellungen und Abos und Freundschaften und “Verbergen” weitgehend über “mein” Facebook bestimmen.

Was nicht richtig ist. Facebook bestimmt.

Es ist ihr Produkt.

So wie ein mit Marmelade gefülltes Croissant das Produkt eines Bäckers ist. Ich kann darauf verzichten, wenn es mir nicht schmeckt. Aber ich kann es nicht endgültig beeinflussen. Das letzte Wort hat immer der Anbieter. Und die Anbieter suchen emsig nach Möglichkeiten, den Datenschatz zu heben. Sie werden nicht aufhören, die Daten für alles zu gebrauchen, was man zulässt. Und offensichtlich schrecken sie dabei vor nichts zurück.

Langfristig an Gefühlen rumspielen ist etwas anderes als einen kurzfristigen Kaufreflex zu triggern. 700000 User schlechter gelaunt machen ist etwas anderes, als ihnen Viagra anzudrehen.

Und das ist genau die Lektion, die wir aus diesem ersten öffentlichen Fall eines Big-Data-Missbrauchs lernen sollten: Wir können keine digitale Fairness von profitorientierten Unternehmen erwarten. Inzwischen ist es eine alte digitale Weisheit:

Wenn etwas umsonst ist, bin ich nicht der Kunde. Sondern das Produkt.

Oder das Experiment.

Heimliche Verführer

Das Facebook-Experiment lässt die Möglichkeiten dieser Unternehmen, aber auch der Politik und anderer Institutionen, die sich ihrer bedienen, erahnen. Sie machen mir Angst. Und erinnern Sebastian Deterding an eine Schöne Neue Welt: “Manipulations like these show how much power online companies like Facebook have over us, and filtering information by sentiment could keep us in a Huxleyan SNAFU bubble.”

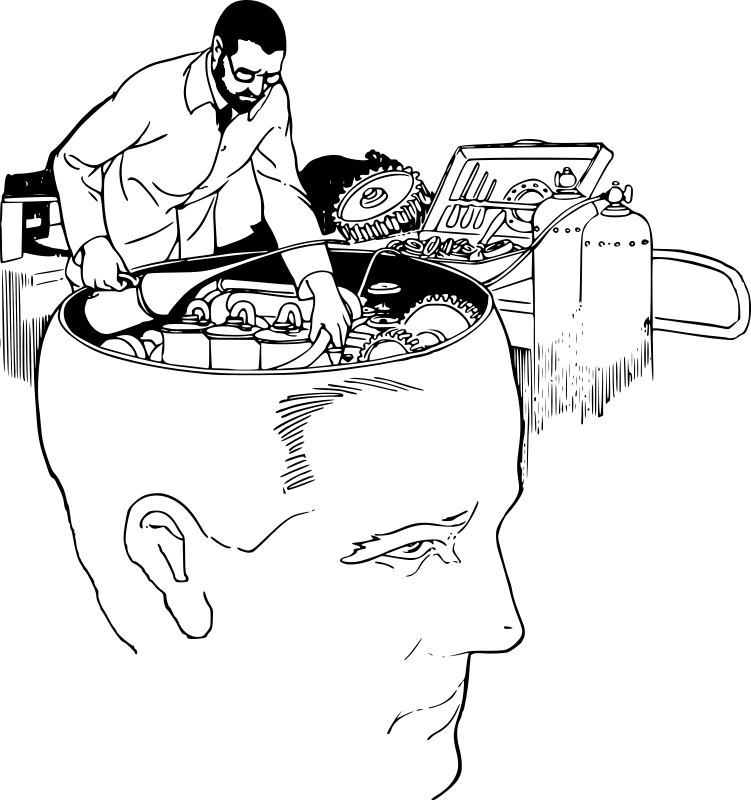

Dieses “Social Engineering” auf Basis von Big Data macht uns alle zu Versuchskanninchen, um in unsere Köpfe zu schauen und unser Verhalten zu beeinflussen. Ja, das macht die Werbung seit Jahrzehnten. Aber sie hatte niemals die Macht der Big Data. Sie arbeitete mit groben Clustern, Sinus-Milieus, Zielgruppen. Nicht auf der Ebene der Individuen.

Und sie hatte niemals diese Effizienz: Die Studie wurde von drei Personen durchgeführt, “one member of Facebook’s own Core Data Science team and two university researchers from Cornell and UCSF”. Drei Menschen konnten 700000 andere Menschen studieren. Und das um einiges genauer, als es früher möglich war: “If the 20th century engineers of consent had magnifying glasses and baseball bats, those of the 21st century have acquired telescopes, microscopes and scalpels in the shape of algorithms and analytics,” vergleicht Zeynep Tufekci.

Genau jetzt, angesichts solcher Beispiele, ist die Zeit sich dagegen zu wehren, dass Akteure wie Facebook ihre Macht ausnutzen. Tufekci warnt: “…these large corporations (and governments and political campaigns) now have new tools and stealth methods to quietly model our personality, our vulnerabilities, identify our networks, and effectively nudge and shape our ideas, desires and dreams.”

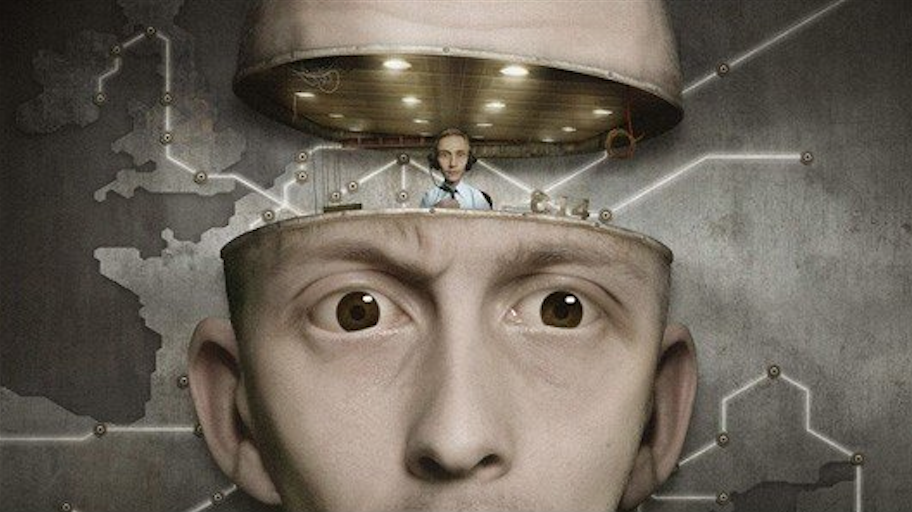

Facebook im Jahr 2024 (und im schwedischen Animationsfilm Metropia, von dessen Filmplakat der Ausschnitt stammt)

Facebook im Jahr 2024 (und im schwedischen Animationsfilm Metropia, von dessen Filmplakat der Ausschnitt stammt)

Facebook als Fernbedienung

Das ist das Problem an solchen Experimenten und an den Systemen, die sie erst ermöglichen: Nicht, dass sie illegal, fantasie- und absichtsvoll böse wären. Das sind sie nicht automatisch, auch wenn sie sich so anfühlen mögen.

Sondern, dass sie eben nur ein ganz kleiner Schritt von alltäglichen, legitimen Praktiken entfernt sind. Dass sie ein bisschen wie normale Werbung aussehen. Dass sie aufsetzen auf einer längst akzeptierten Realitätskonstruktion durch intransparente Anbieter. Dass sie auf Grund der Größenordnung und Heimlichkeit einerseits so effizient und andererseits so leicht zu verbergen sind. Dass sie unseren Kontrollverlust nicht erfinden, sondern nur ausnutzen.

Dieses “Social Engineering” ist gefährlich, obwohl oder gerade weil es per se nichts neues oder böses ist. Sondern weil es letztlich unsichtbare Kontrolle ermöglicht. Willensbildung wird weniger öffentlich, weniger bewusst, weniger selbstständig. Big Data, richtig (oder eher falsch) genutzt, wird zur Fernbedienung für unsere Köpfe.

Nichts im Netz ist objektiv oder neutral. Umso genauer müssen wir hinschauen, wer uns etwas warum für objektiv oder neutral verkaufen will. Und noch wichtiger: Nichts ist umsonst. Umso klarer müssen wir sehen, was es kostet.

tl;dr: Big Data kann missbraucht werden, wehret den Anfängen.

Facebook im Jahr 1907

Facebook im Jahr 1907

Bei dem Experiment von Facebook bzw. dessen mediale Begleitung seit dem es öffentlich geworden ist musste ich an das Buch „Zero – Sie wissen, was Du tust“ von Marc Elsberg. Dort führt die fiktive Firma Freemee ebenfalls ein Experiment mit einem Teil ihrer Benutzer durch. Liest sich gut, ich bin aber bisher noch nicht ganz fertig damit.

Ich denke, das die Kritik eigentlich schon einen Schritt vorher anfangen sollte. Werbung, A/B testing, Optimierung von Produkten, etc. auf Massentauglichkeit sind schon geeignet Menschen in Massen zu manipulieren gegen ihre Interessen zu handeln (z.B. bei Nahrungsmitteln oder Rauchwaren auch direkt ihre Gesundheit betreffend). Außerdem marginalisiert z.B. A/B testing die Bedürfnisse der kleineren Gruppe, wenn es nicht nur um Feinheiten wie Farbe, etc. geht.

Unter dem Gesichtspunkt ist die Effizienz, mit dem ein Unternehmen wie Facebook, seine „Nutzer“ beeinflussen kann und die allgemeine Apathie dem gegenüber umso erschreckender, denn wesentlich krudere Methoden sind schon sehr gut geeignet schlimmes anzurichten.