Digitale Barrierefreiheit, digitale Teilhabe, Inklusion – auch das gehört zu den Versprechen der Unternehmen hinter modernen KI-Systemen. Sie zeichnen eine rosige Zukunft, in der mithilfe der KI möglichst alle Menschen mit und ohne Behinderung an der Gesellschaft teilhaben können. Casey Kreer, freiberufliche Beraterin für Barrierefreiheit und Web-Entwicklerin, kommt zu einem anderen Urteil: „Wir werden mit den Fehlern der KI leben müssen. Das ist gefährlich, aber das ist die Realität.“

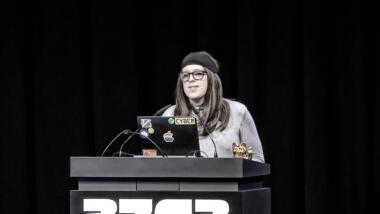

Es gebe zwar ein paar brauchbare Anwendungen von KI-Systemen für Barrierefreiheit, wie Kreer auf dem 37. Chaos Communication Congress in Hamburg erklärt. Doch dann räumt sie mit dem Mythos auf, dass KI ein Allheilmittel sei. Kreer nutzt seit ihrem sechsten Lebensjahr assistive Technologien, hat eine angeborene Sehbehinderung. Sie verwendet Spezialtastaturen und -mäuse, Spracheingabe- und Vergrößerungssoftware sowie Screenreader.

KI kann, so Kreer, ein gutes Werkzeug sein, wenn wir sie selbstbestimmt benutzen. Menschen mit Behinderung kann sie im Alltag unterstützen, etwa über automatisch generierte Alternativ-Texte für Bilder. Diese Texte beschreiben, was auf einem Bild zu sehen ist. Gerade auf sozialen Medien können Nutzer:innen mithilfe Alt-Texte ihre geposteten Bilder besser zugänglich machen. Ohne Alt-Texte fehlt Menschen mit Sehbehinderung ein großer Teil an Information.

Verschiedene Produkte versuchen, diese Lücke zu schließen, etwa die Bilderkennung von Apples Betriebssystem iOS oder der Text-Generator ChatGPT, dessen aktuellste Version GPT-4 ist. Während die iOS-Lösung nur sehr wenige Informationen liefert, ist ChatGPT deutlich ausführlicher in der Beschreibung eines Bildes. Denn die großen Sprachmodelle dahinter sind multimodal und können auch zusätzliche Befehle beachten. „Beispielsweise kann ich, wenn ich in einem Museum bin, das Sprachmodell dazu auffordern, mir statt einer Beschreibung des Bildes ein Gedicht zu generieren oder ein Lied“, sagt Kreer. „Das erlaubt mir verschiedene Zugänge zu dem Bild.“ Eine solche Art der Teilhabe sei zuvor nicht möglich gewesen.

ChatGPT als Hilfsmittel

Mit der Bilderkennung von GPT-4 ist noch mehr möglich. Damit lassen sich etwa Programmoberflächen erkennen und akkurat beschreiben, wie Kreer erläutert. Das ist sehr hilfreich, wenn man einen Screenreader nutzt, um mit dem Computer zu interagieren.

Auch im Bereich leichte und einfache Sprache können Sprachmodelle wie GPT-4 unterstützen. Das ist besonders für Menschen wichtig, die eine Lern- oder kognitive Behinderung haben. Sie profitieren sehr davon, wenn Inhalte einfach aufbereitet oder zusammengefasst sind, Fremdwörter oder komplexe Text- und Satzstrukturen aufgelöst sind. Dazu gibt man Sprachmodellen ein Regelwerk vor, wie sie Texte in einfache Sprache übersetzen sollen. In Form eines Werkzeugs, das sie selbstbestimmt nutzen, erlaubt das Menschen einen Zugang zu Inhalten, den sie vorher nicht hatten.

Hilfreich sind große Sprachmodelle auch beim Programmieren; hierzu teilt Kreer Erfahrungen aus ihrem Arbeitsalltag. „Wenn man blind ist, ist es schwierig, einen Überblick über den Code zu haben.“ Mit der Sprachausgabe des Screenreaders kann sich Kreer nur jeweils eine Zeile Code anhören. Die muss sie sich im Kopf merken, um sie in den Kontext des Codes setzen zu können. Große Sprachmodelle wie bei GPT-4 erleichtern die Arbeit, indem sie auch allgemeinere Fragen zum Code verarbeiten und Antworten liefern könnten.

Schließlich seien Sprachmodelle häufig auch eine große Hilfe bei der Online-Recherche, da sie Suchergebnisse verschiedener Suchmaschinen miteinander verknüpfen und zusammenfassen. Das sei in der Form zuvor nicht möglich gewesen, so Kreer. Auch können Sprachmodelle Untertitel automatisiert generieren, was für Menschen mit Behinderung Zugang zu Videoinhalten schaffen kann.

Wenn Sprachmodelle Quatsch produzieren

Doch gerade an diesem Beispiel zeigt sich eine Gefahr von Sprachmodellen. Zum Beispiel lässt sich mit KI-Systemen gesprochenes Wort in Text umwandeln; auf diese Weise entstehen automatisch generierte Untertitel. Die Untertitel-Funktion bei YouTube-Videos zum Beispiel produziere häufig auch Quatsch, der absolut unverständlich ist, kritisiert Kreer. Oft würden Technologien auf vorhandene Strukturen aufgesetzt, ohne dass sie einen Mehrwert liefern.

KI-Systeme können auch den umgekehrte Weg gehen und geschriebene Worte und gesprochene Sprache umwandeln. Dann nennt man text to speech, kurz TTS. Die Qualität solcher TTS-Software ist häufig gut, wie Kreer erklärt. Jedoch könne es passieren, dass diese Programme Texten falsche Informationen hinzuzufügen. So berichtet Kreer von einem Vorfall, in dem iOS beim Vorlesen die Zahl Fünf in eine 50.000 verwandelte.

Problematisch wird es auch, wenn KI-Systeme aufgrund vermeintlicher Sicherheits-Einstellungen Informationen unterschlagen. Zum Beispiel, wenn ein Bilderkennungssystem keine Bilder beschreibt, in denen viel Blut zu sehen ist. Damit bestimmt das Programm, auf welche Inhalte Menschen barrierefrei zugreifen dürfen und auf welche nicht. Es verhindert selbstbestimmte Information, wie Kreer erklärt.

Vorurteile, Faulheit und kommerzielle Interessen

Ein anderes großes Problem ist der Bias, der in die Modelle eingeschrieben ist. Der Begriff meint etwa Verzerrungen, Vorurteile und die systematische Stereotypisierung von Menschen. Das zeigt ein Beispiel des Bildgenerators DALL-E der Firma OpenAI. Als Kreer damit ein Bild von einer blinden Person generieren ließ, erschien in sechs von sechs Fällen die Darstellung eines jungen, weißen Mannes; gepflegt gekleidet mit Sonnenbrille und Blindenstock. Auffällig sei an den Bildern die unrealistische Haltung des Stocks, sagt Kreer. Das liege daran, dass die Modelle unvollständige Daten haben, in denen blinde Menschen nicht adäquat repräsentiert sind.

„KI ist ein Abbild der Gesellschaft, das Vorurteile eins zu eins spiegelt“, so Kreer. Der Bias stecke bereits in den grundlegenden Daten. Es sei fatal, wenn Menschen schlechte KI-Outputs akzeptieren. Leider sei das häufig der Fall, denn Menschen „sind faul und ableistisch“, sagt Kreer.

Und da gibt es noch ein Problem: Der Treiber von Technologien für Barrierefreiheit sind in der Regel Start-ups wie etwa accessiBe oder Userway. Sie entwickeln Lösungen, die sich gewinnbringend an Staaten oder große Unternehmen verkaufen lassen. Damit sind Menschen mit Behinderung nicht mehr die eigentliche Klientel und die Produkte werden nicht für sie optimiert, wie aus Kreers Vortrag hervorgeht.

Wie der Konflikt zwischen Betroffenen und Unternehmen eskalieren kann, zeigt etwa der Fall von Adrian Roselli, den Kreer in ihrem Vortrag anspricht. Roselli ist Experte für Technologie für Barrierefreiheit und kam zu dem Schluss: „KI sorgt nicht für mehr Inklusion.“ Öffentlich hatte er auf X, ehemals Twitter, die technischen Lösungen von Unternehmen wie AudioEye kritisiert und vor überzogenen Erwartungen an die Technologie gewarnt. Letztlich drohte ihm die Firma sogar mit rechtlichen Konsequenzen.

Dass KI nicht für mehr Inklusion sorgt, liege laut Kreer daran, dass sie selbst ableistisch ist. Und das lasse sich auch nicht ändern. Technische Lösungen für digitale Barrierefreiheit zu entwickeln, das gehöre in die Hände von Menschen mit Behinderung; KI könne diese Aufgabe nicht übernehmen.

Ich finde die KI Entwicklung für Menschen mit Behinderungen schon vielversprechend wenn auch aktuell noch in den Kinderschuhen. Wie im Beitrag beschrieben, helfen große Sprachmodelle ja jetzt schon in einigen Bereichen (z.B. Programmierung). Wenn ich etwa mit der ChatGPT-App ein Foto mache, kann ChatGPT in der Regel schon ganz gut erklären, was darauf zu sehen ist. Klar, das funktioniert nicht immer und machmal produzieren die Sprachmodelle auch Quatsch. Aber wir stehen halt noch am Anfang der Entwicklung und wenn man ein paar Jahre weiter denkt, sieht das vielleicht (hoffentlich) besser aus.

Ich könnte mir vorstellen, dass Screenreader irgendwann gar nicht mehr unbedingt auf semantisches HTML, ALT- oder ARIA-Attribute angewiesen sind, sondern sich einfach die gerenderte Webseite „anschauen“ um der Nutzer:in in prägnanter Form zu beschreiben, was darauf zu sehen ist und welche Optionen es gibt. Das wäre doch ein echter Benefit.

Ich möchte hierzu noch einmal kurz anmerken, was ich auch in meinem Vortrag sagte: Ich kann mir auch sehr gut vorstellen, dass die Sprachmodelle irgendwann gut genug sein werden, um semantisches HTML und andere für barrierefreie wichtige Details interpolieren zu können und mir damit nicht-barrierefreie Inhalte zumindest grob zugänglich gemacht werden. Dabei handelt es sich aber um eine „Assistenzfunktion“ – das können auch bereits jetzt andere Menschen für mich erledigen. Ich bin dabei darauf angewiesen, dass die Modelle Inhalte korrekt wiedergeben – und wenn sie es nicht tun, entstehen für mich viele neue unsichtbare Barrieren, weil sie damit mein Weltbild verfälschen. Und sollte ich es einmal bemerken, habe ich keine Möglichkeiten, die Programme zur Rechenschaft zu ziehen, bei Menschen würde das gehen. Selbstbestimmter Zugang zu Informationen im digitalen Bereich wird auch in Zukunft nicht ohne Angebote funktionieren, die tatsächlich auf technischer Ebene barrierefrei sind und auf die ich mit einer deterministischen Methode (z.B. Screenreader, wie sie jetzt sind) zugreifen kann. Es gibt schließlich auch Dinge, bei denen die Art der Kommunikation extrem relevant ist. Alternativtexte und weitere Dinge werden also auch in Zukunft von Menschen verfasst werden müssen, um wirklich inklusiv zu sein – ganz egal wie gut die Modelle noch werden. Ich möchte die Welt selbst erleben, nicht durch die Layer eines LLMs.