Die Partnerbörse OkCupid experimentiert mit ihren Algorithmen und den Menschen, die damit die Hoffnung auf eine neue Liebe verbinden. Das hat der Mitgründer der Plattform Christian Rudder in einem Blogpost offenbart:

I’m the first to admit it: we might be popular, we might create a lot of great relationships, we might blah blah blah. But OkCupid doesn’t really know what it’s doing. Neither does any other website.

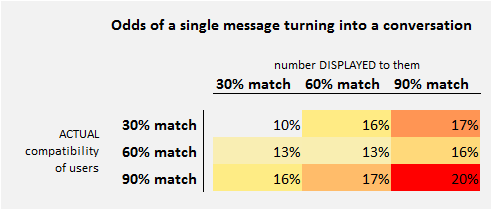

In einer der letzten Folgen von How-To-Analyze Everyone hatten wir noch auf den angeblichen Matching-Algorithmus von OkCupid Bezug genommen, der vorgab anhand der Übereinstimmung bei beantworteten Fragen und gesetzter Präferenzen zu ermitteln, wie gut Teilnehmer zusammenpassen. Doch in manchen Fällen, so stellte sich heraus, war der Übereinstimmungswert reine Fiktion und Menschen mit niedrigen Matching-Punktzahlen wurde stattdessen ein hoher Wert vorgespielt:

[I]n the back of our minds, there’s always been the possibility: maybe it works just because we tell people it does. Maybe people just like each other because they think they’re supposed to?

Das Ergebnis: Suggestion spielt eine große Rolle, aber dennoch ist die Erfolgswahrscheinlichkeit bei zuvor ermitteltem hohem Matching-Wert am höchsten.

Rudder reagiert mit dem Eingeständnis Werte manipuliert zu haben auf den Aufschrei, der im Zuge des Facebook-Experiments erfolgt war. Das Soziale Netzwerk hatte zugegeben, die Newsfeeds von einigen Nutzern manipuliert zu haben, um herauszufinden ob sich die Stimmung eines Nutzers auf andere überträgt. Manchen wurden mehr positiv gestimmte, anderen negative Beiträge angezeigt. Man fand heraus, dass das eigene Postingverhalten tatsächlich in Zusammenhang mit dem anderer stehe.

Mit einem hat Rudder in Bezug auf Auswertungsalgorithmen und Co. recht:

It’s not like people have been building these things for very long, or you can go look up a blueprint or something. Most ideas are bad. Even good ideas could be better. Experiments are how you sort all this out.

Wie weit man bei solchen Experimenten gehen darf, muss jedoch diskutiert werden. Die Medienwissenschaftlerin Danah Boyd hatte bezogen auf das Facebook-Experiment die Möglichkeit in den Raum gestellt, Ethikbeiräte zu besetzen, die ein geplantes Experiment vor seiner Durchführung bewerten sollen.

Es ist durchaus sinnvoll, Menschen und ihre sozialen Interaktionen vor den negativen Auswirkungen von Experimenten zu schützen. Gerade da wo Menschen besonders verwundbar sind, ist dies notwendig.

Aber aus diesen Experimenten in Social Networks einen Aufreger zu machen ist nicht zielführend. Jedes A-B Testing ist genau so invasiv, nur wird die Ethikabschätzung da von einem Codemonkey mit Deadline getroffen. Die Leute werden im Netz nach Strich und Faden manipuliert und ausgetrickst, egal ob die Wissenschaft sich jetzt Knüppel zwischen die Beine wirft oder nicht.

Die einzige Frage, die sich hier stellt ist: Wollen wir da wenigstens noch etwas Erkenntnis herausziehen, oder nicht?

Was für ein Blödsinn. In den OKC-Kommentaren drehen die Amerikaner auch durch, schreien was von Ethik, blablablubb.

Dabei geht es hier lediglich darum, dass ein paar Usern eine andere Match-%-Zahl angezeigt worden ist für einige Personen. Zwei Menschen, die sich sonst nie kennengelernt hätten, haben also einen minimal anderen Start in ihre Beziehung zueinander.

Wieso tun im Zuge dieser „Affäre“ alle so, als sei das was OkCupid „Match“-Wert nennt (oder auch der Facebook „News“Feed) etwas allgemein definiertes? Das sind Services/Markennamen von Unternehmen, was sich dahinter verbirgt kann man daraus nicht schließen, von Ethik reden schon garnicht. Es käme doch auch keiner auf die Idee dass in „fruit“Loops tatsächlich Obst ist, nur weil eine Firma das so nennt?

Meinetwegen. Ich bin froh, dass im OkTrends-Blog dadurch nun nach Jahren der Inaktivität endlich wieder gepostet wird. Die Analysen der OkCupid-Profile und Aktivitäten, die dort von 2009 bis 2011 veröffentlicht wurden, gehören zu den interessantesten Datenauswertungen, die ich kenne. Ich hoffe, die Medien (einschl. netzpolitik.org) veranstalten deshalb jetzt nicht wieder eine Hexenjagd.

Die Aufregung um das ganze Thema kann ich auch absolut nicht nachvollziehen. Ich bin selber Betreiber von kommerziellen Websites und natürlich macht man da ab einem gewissen Traffic-Volumen zumindest mal A/B- oder besser noch Multivariable-Tests. An welchen Schrauben soll man denn ansonsten auch rumdrehen wenn man den Service optimieren will?!

Das gleiche würde ich ebenso andersgearteten Diensteanbietern zugestehen ….