Elon Musk ist wohl so etwas wie der bekannteste Polit-Influencer. Er hat massiv Geld in den Wahlkampf für Donald Trump gepumpt. Millionenfach wurde in den Sozialen Medien sein Auftritt auf der Wahlkampfbühne geteilt: Musk im Sprung, das T-Shirt hochgerutscht und auf dem Kopf ein schwarzes Cappy mit der Aufschrift „Make America Great Again“, kurz MAGA.

Doch Amerika groß machen, das reicht dem Tech-Milliardär nicht. Musk ging weiter und bekannte sich offen zu „Dark MAGA“. Damit spielt er auf eine demokratiefeindliche Strömung der Alt-Right-Bewegung in den USA an, die sich „Dark Enlightenment“ nennt, also „Dunkle Aufklärung“. Sie ist wiederum eine Form des Longtermismus, einer rechten Ideologie, die unter einflussreichen Tech-Unternehmern der neue Goldstandard geworden ist .

Längst beschränkt sie nicht mehr auf das Silicon Valley, sondern streckt ihre Fühler aus in die Weltpolitik. Was hinter der gefährlichen Ideologie des langfristigen Denkens steckt, analysierte auf dem 38. Chaos Communication Congress in Hamburg der Soziologe Max Schnetker in einem Talk mit dem Titel „Longtermismus – der „Geist“ des digitalen Kapitalismus“.

Opium fürs Volk

Elon Musk bildet zusammen mit anderen Tech-Baronen die Elite, für die der Longtermismus gemacht ist. Auch Branchengrößen wie Skype-Gründer Jaan Tallinn und Investor Marc Andreesen gehören zu den Anhängern. Außerdem Peter Thiel, der Gründer des Bezahldienstes Paypal und der Polizei-Software Palantir.

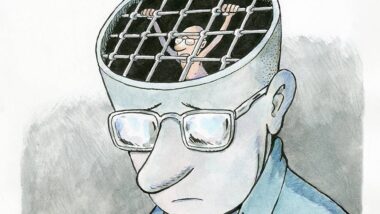

Von außen sieht es so aus, als wollten sie gravierende Probleme der Menschheit angehen, etwa mit der Charity-Organisation Giving What You Can, die sich ursprünglich auf die Fahne geschrieben hatte, Armut in der Welt zu bekämpfen. Hinter dem Longtermismus steckt jedoch eine Art säkulare Religion, die ihre Anhängerschaft den gesellschaftlichen Machtfantasien der Elon Musks und Peter Thiels dieser Welt gefügig machen will.

Max Schnetker von der Universität Bonn zufolge ist das erste Ziel des Longtermismus die Etablierung einer Kastengesellschaft, in der manche Menschen einen Wert haben und andere nicht. Der Wert des Menschen bemesse sich dabei am gesellschaftlichen Stand, am finanziellen Vermögen und Bildungsstand. Eine Ideologie der Ungleichheit, die die Herrschaft von Eliten legitimiert.

Es sei deshalb wenig überraschend, dass Elon Musk Werbung für die rechtsextreme Partei AfD macht. Die Welt am Sonntag ließ ihn hierzu kürzlich zu Wort kommen. Musks Urteil: Die AfD sei der letzte Funke Hoffnung für Deutschland.

Elite-Unis als Geburtsstätten für KI-Religion

In seinem Vortrag lieferte Schnetker einen Rundumblick über die Entstehung des Longtermismus und verwandter rechter Ideologien. Kritiker:innen wie Timnit Gebru und Èmile P. Torres fassen die Strömungen mit dem Kürzel TESCREAL zusammen, zusammengesetzt aus den Anfangsbuchstaben von Theorien wie Transhumanismus und effektiver Altruismus.

Dabei handelt es sich keinesfalls um akademische Randerscheinungen, sondern um gut positionierte philosophische Theorien, die eigene Institute an Top-Universitäten wie Cambridge und Oxford haben. Führende Denker sind Philosophen Nick Bostrom, Peter Singer und William MacAskill von einer der bekanntesten Organisationen, dem Future of Humanity Institute an der Universität Oxford.

Ihre Mission ist es, Forschung dort zu konzentrieren, wo sie langfristig den größten positiven Einfluss auf die Menschheit haben kann. Und den größten Nutzen verspricht ihnen zufolge die Entwicklung von Technologie wie generativer Künstlicher Intelligenz. Der absurde Schluss des Longtermismus: Wir müssen jetzt alles opfern für das künftige Techno-Paradies, in dem eine wohlwollende Superintelligenz der Menschheit das beste Leben auf Erden beschert.

Die grundlegenden Annahmen dieser KI-Religion sind laut Schnetker folgende: Das menschliche Gehirn und gegenwärtige generative KI sind sich im Wesentlichen gleich, weswegen es nur eine Frage der Zeit ist, bis es eine AGI gibt, eine Artificial General Intelligenz. Also eine allgemeine KI, die so viel kann wie das menschliche Gehirn. Daraufhin werde es wiederum nur eine Frage der Zeit sein, bis es eine Superintelligenz gibt, die die menschliche Intelligenz in allem übertrifft.

Longtermisten rechnen damit, dass AGI und Superintelligenz die Welt übernehmen. Das sei der Zustand der Singularität, so Schnetker. Damit dieser möglichst positiv für die Menschheit ist, müsste diese jetzt alles dafür tun, KI positiv zu gestalten. In ferner Zukunft sollen Menschen dann als Computerprogramme im KI-Himmel weiterleben können.

„Awareness schaffen“

Um dieses Ziel zu erreichen, fokussieren die Longtermisten laut Schnetker fiktionale Menschen in der Zukunft. Dafür nivellierten sie allerdings die Bedürfnisse und Interessen fast aller realen Menschen in der Gegenwart. Daneben hebelten sie die Kritik am digitalen Kapitalismus aus, die sich in Regulierungsmaßnahmen wie der KI-Verordnung der EU niederschlage. Um die Mär vom endlosen Wachstum aufrechtzuerhalten, erweiterten Longtermisten den Raum des Handelns weit in die Zukunft.

Die Gefahr liegt auf der Hand: Menschen, die sich vom Longtermismus überzeugen lassen und das Ziel eines KI-Himmels vor Augen haben, lassen sich auch leicht davon überzeugen, extreme Maßnahmen zu ergreifen oder zu akzeptieren, die dabei helfen sollen, das Techno-Paradies herbeizuführen.

Doch wie gegen den zunehmenden Einfluss des Longtermismus vorgehen? Darauf habe er keine Antwort, so Schnetker. Das Wichtigste sei Bewusstsein dafür zu schaffen, welche extremen Auswüchse die Ideologie in Politik und Gesellschaft annimmt – und wie sie schon jetzt daran beteiligt ist, rechte Bewegungen salonfähig zu machen.

Afrika verhungert… Afrika hat Krankheiten und keine passenden Impfungen…

Aber sch… drauf … auf CO2 und die tägliche Energie von ca. 1 Milion… Pro „KI“ wohl gemerkt.

Ich habe mir den Vortrag von Schnetker in Ruhe angeschaut und fand die Gedankengänge okay. Ich fand seine Unterteilung zwischen Menschen, die philosophisch darüber nachdenken und Menschen, die sich lediglich als Teil der Bewegung sehen, wichtig. Leider ist seine Argumentation teilweise sehr lückenhaft, da er nur ein einziges Zitat von Denker*innen des Longtermismus aufgreift. Und dieses Zitat repräsentiert auch keine starke Position (weder im Text von Backstead, noch bei anderen der Vertreter*innen). Ansonsten stellt er zwar Quellenangaben an der rechten Seite seiner Präsentation zur Verfügung, geht aber bis auf die genannte auf keine der Quellen direkt ein. Das führt dazu, dass der Vortrag viele Behauptungen aufstellt, die er nicht klar belegt. Bei mir ist dadurch eher das Gefühl entstanden, dass Schnetker Probleme mit bestimmten Zukunftsvorstellungen hat und diesen den Namen Longtermismus gibt, obwohl diese eher nichts miteinander zu tun haben.

Ich würde mich auch darüber freuen, wenn für einige der Aussagen in diesem Text einfach mal Quellen auf Originaltexte angegeben werden könnten. Wo behaupten Leute wie Nick Bostrom oder William MacAskill diese Dinge? Leider kann ich nicht alle ergänzen. Aber hier ein Beispiel: „Der absurde Schluss des Longtermismus: Wir müssen jetzt alles opfern für das künftige Techno-Paradies, in dem eine wohlwollende Superintelligenz der Menschheit das beste Leben auf Erden beschert.“

Kritik hilft nur, wenn diese Kritik gerechtfertigt ist. Kritikern zuzuhören, ist nur sinnvoll, wenn die Kritik ernsthaft auf das reagiert, was gefordert wird. Wenn Kritik jedoch etwas anspricht, was nicht behauptet wird, wird sie unangemessen. Wer ernsthafte Kritik haben möchte, sollte sich beispielsweise eher noch die englische Wikipedia zu dem Thema anschauen.

Ich vermute, hier wurden Handlungen und Äußerungen von Leuten mit der (losen?) Idee des Longtermism vermischt.

Was auch immer Longtermism ist, gibt es definitiv seriöse Ansätze, die langfristige Existenz (der Menschheit bzw. einer Zivilisation) als Konzept haben, z.B. meinen. Hier wird allerdings nichts geopfert, weil irgendwo in der Ferne etwas zu glimmern scheint. Resourcen der Wissenschaft darauf zu verwenden, ergäbe allerdings Sinn. Auf meins, nicht auf jenen Schweinekram, den die Tech-Bros da zu verzapfen scheinen. Hier geht in gewisser Weise um Transzendenz bzw. die Frage, ob wir uns gewissermaßen auf die Unendlichkeit ausrichten müssen, um überhaupt eine Gesellschaft haben zu können, vgl. manche Religion (!). Keine Abkürzungen mit ein bischen mehr Autokratie, weil es irgendjemandem gefällt, sondern prinzipale gesellschaftliche Entwicklung. Was glauben dahergelaufene Halunken, was in den Tiefen des Weltalls zählt? Dass es ein Overlord durch multiplen Genozid dorthin geschafft hat? Eine tolle Waffe? Herrscher über irgendwas zu sein?

Klar, der Artikel verkürzt und bricht herunter, was der Vortrag bereits verkürzt und heruntergebrochen. Auf np gibt es ein Interview mit dem Philosophen Émile P. Torres: https://netzpolitik.org/2023/longtermismus-eine-merkwuerdige-und-sonderbare-ideologie/ Hier wird klar, dass Longtermismus eine philosophische Theorie ist, die akademisch verwurzelt ist. Teil der Argumentation ist, dass der utilitaristische Ansatz nicht nur auf Menschen bezogen wird, die leben, sondern auf potentielle Menschen der Zukunft. Der Longtermismus schlägt über mehrere Teilargumente schließlich die Brücke zur drohenden oder paradiesischen Super-KI. Welche anderen seriösen Ansätze von Longtermismus sind gemeint?

> Hier geht in gewisser Weise um Transzendenz bzw. die Frage, ob wir uns gewissermaßen auf die Unendlichkeit ausrichten müssen, um überhaupt eine Gesellschaft haben zu können,

Wer Transzendenz zum Denken braucht, ist schon gescheitert. Es würde schon mal reichen, den Planeten als Ort zu erhalten, auf dem menschliches Leben in Würde und Einklang mit anderen Spezies. Sollte das mittel- und langfristig nicht erreichbar sein, so bräuchte man das Scheitern der Menschheit nicht zu bedauern. Für jede andere Spezies jedoch wäre es bedauerlich, wenn sie es nicht schaffen, uns als homo ignorans zu überleben.

„Wer Transzendenz zum Denken braucht, ist schon gescheitert. “

…

„Transzendenz zum Denken braucht“

Wer behauptet das? Wir reden hier über Zukunft. Wenn es um Modelle des Einbeziehens der Zukunft geht, lässt es sich schwer mit einem Lagerfeuer in einer Steinzeithöhle argumentieren. Vgl. Transzendenz gegenüber Immanenz.

Probleme mit „Immanenz first“:

1. Wirklich langfristig funktionierende Prinzipien zu entwickeln oder zu entdecken, benötigt eine Auseinandersetzung mit der Zukunft. Es reicht nicht, sich ein paar Probleme wie den Klimawandel herzunehmen.

2. Ein Regierungssystem muss letztlich die Zukunft und Erwartungen dazu mit einbeziehen. Viele Vorgänge dauern Jahre oder Jahrzehnte, das stelle man sich mal in einem transaktionalen kurzsichtigen Umfeld vor, wie die derzeitige US-Administration möglicherweise versucht zu schaffen.

3. Unweigerlich werden sich Realitäten einstellen, wenn wir Asteroiden und Monde besiedeln. Direkt wirtschaftlich und bzgl. dann ultrabilliger Waffentechnologie (Steinschubsen), aber auch bzgl. einer möglicherweise dann oder irgendwann dann vorhandenen Bevölkerung dort. KI ist bisher ein Beispiel für Versagen. Das überlegt man nicht erst, wenn die Kriegserklärung der Marskolonie vorliegt.

„Hier geht in gewisser Weise um Transzendenz bzw. die Frage, ob wir uns gewissermaßen auf die Unendlichkeit ausrichten müssen, um überhaupt eine Gesellschaft haben zu können, vgl. manche Religion (!).“

Das hier war ja das Original. Adäquater Begriff – weiß ich jetzt nicht.

https://www.philomag.de/lexikon/transzendenz

„Er bezeichnet das Gegenstück zur Immanenz und somit das, was ein gegebenes Bezugsfeld übertrifft und losgelöst und unabhängig existiert.“

(Usw. eigentlich ist es im Kontext nicht so falsch, oder doch?)

Transzendenz ist keine Voraussetzung(!) für die Entstehung sozialer Strukturen.

Allerdings können aufgrund transzendent behaupteter Gedanken(!) soziale Sub(!)-Strukturen entstehen (Glaubensgemeinschaften), die identitär wirksam sind (we vs. they).

„Transzendenz ist keine Voraussetzung(!) für die Entstehung sozialer Strukturen.“

Es geht nicht darum, dem flüchtigen Dasein ein weiteres Gewächst hinzuzustellen. Es geht um langfristige Existenz und deren Konsequenzen. Dabei ergibt sich dann irgendwann die Antwort auf die Frage, ob man die Idee besser wieder in einer Schublade wieder verschwinden lassen will oder sollte.

„Allerdings können aufgrund transzendent behaupteter Gedanken(!) soziale Sub(!)-Strukturen entstehen (Glaubensgemeinschaften), die identitär wirksam sind (we vs. they).“

Transzendenz und Zukunft haben nichts und überhaupt nichts, schon gar nicht in der philosophischen oder auch nur einfach so der Literatur, mit Identitären Ideologien zu tun. Das ist einfach eine abwegige Aneinanderreihung von Sachen, die Sie womöglich nicht verstehen, miteinander verklammern oder sogar angreifen wollen.

Sollten Sie „irgendwie esotherisch“ meinen, kann man da schon mal zwei weitere Worte auseinandernehmen, aber das ist eben etwas anderes.

„schon gar nicht in der philosophischen oder auch nur einfach so der Literatur“

Fairerweise könnte man sagen, dass es das Argument im Sci-Fi u.a. natürlich prinzipiell schon gibt, vor allem aber wird da auf Zukunft verwiesen. Es wurden auch schon eugenische Maßnahmen oder Ideologieversatzstücke mit Zukunft begründet, oder esoterisch mit „wir sind irgendwie auserwählt“ oder „in uns fließt die Kraft“ usw.

Das sind allerdings i.d.R. keine Abhandlungen über die Begriffe, sondern Quatschkonstruktionen, im sinne von Glauben. Transzendenz kann man nüchterner sehen, vor allem ist ein Unterschied, ob ich ein Ritual vollziehe, und Leute unter dem Eindruck irgendwie indoktriniere, es dann „Transzendenz“ nenne, oder ob ich eine Beschreibung für die Ausrichtung einer Gesellschaft mit Blick auf die Zukunft versuche, wobei ich von einem wissenschaftsgetriebenen Ansatz ausgehe (!).

Soziale Strukture entstehen „natürlich“, aber alleine schon Hörensagen hat sehr schnell beliebig esoterische Qualitäten, ohne das jetzt „Transzendenz“ anzulasten, wäre sogar in der Definition unklar, ob es soziale Strukturen ohne Transzendenz überhaupt gibt? Vgl. Aufwachsen von Kindern aus der Perspektive des Geistes bzw. Innenlebens. Erweitert war ja die Frage, ob das Fehlen von Bezugnahme auf die Zukunft im Sinne von Ewigkeit als Ideal, vielleicht dazu führen könnte, dass Gesellschaften immer wieder [in X,Y,Z] zurückfallen. Vgl. Welt jetzt.

Wobei Dienlichkeit und Wert des Menschen zu bemessen schon ein bischen auch so ein Ausschlusskriterium darstellen könnte. Die Menschheit so nützlich wie möglich für die Super-KI machen, damit sie nicht ausgelöscht wird – großartig.

Jetzt käme also quasi noch mal Monotheismus, mein Monotheismus, dein Monotheismus, …, …, …, Sticks and Stones Bro!

Den Vortrag von Max Schnetker habe ich nicht so verstanden, dass er den Anspruch hat, die Bandbreite der philosophischen Argumentationsstücke erschöpfend wiederzugeben, die den Longtermismus ausmachen. Er hat die Schlüsselpunkte aufgegriffen und in der Kürze der Zeit zu veranschaulichen versucht, wie extrem diese Theorie ist und welchen Impact auf die Gesellschaft sie hat. Das Interessante an dieser philosophischen Theorie ist ja, dass sie an viele Theorien anknüpft, die man eigentlich für sich schon ausführen müsste. Daher ist die Darstellung von Timnit Gebru und Émile P. Torres von Longtermismus im Bundle mit u. a. Transhumanismus und effektivem Altruismus (TESCREAL) auch so treffend. Akademisch sind sicher das Buch „What We Owe The Future“ von William MacAskill und der Artikel „The Future of Humanity“ von NIck Bostrom entscheidend.

Ich schätze nicht ein, ob Argumentation oder Diligenz bei dem Vortrag an jeder Stelle hinreichend vorhanden sind. Ideen wie „heutiges Unternehmen sorgt in XYZ (sehr große Zahl) für ganz toll Gesellschaft“ ist immer so eine Sache. Orientierung an Kapitalismus oder „Geldanhäufung“ ist in diesem Kontext im Grunde so wie Wetter und Klima zu vertauschen – kein Wunder!

Alle Denker*innen von Longtermismus und Effective Altruism (EA) in die Schublade einer rechten, von universitären und superreichen Eliten religiös geführten, der Singularität entgegen-strebenden KI-Ideologie zusammen zu kehren wirkt schon fast verschwörungstheoretisch. Ich bezieh mich hier explizit auf diesen Artikel, nicht den Talk. Wer sich auf Seiten von EA-Organisationen wie 80000 Hours umschaut sieht schnell, dass es dort neben dem Thema „Preventing an AI-related catastrophe“ (klingt deutlich anders als im Artikel) noch viele andere Themen gibt. Von einem wahnhaften Wunsch die Gegenwart für eine zukünftige KI-Superintelligenz zu opfern finde ich da nichts.

Fragen. Werden Longtermismus, oder dessen lustigste Freunde (libertäre Milliardäre und Techchefs?) schlecht dargestellt, oder z.B. unberechtigt in einen Topf geworfen.

80000 hours scheint vom Konzept her weichklingender, Longtermism wird propagiert und die Spenderliste… bekannte Gesichter. Longtermism ohne die Gesichter, kommt etwas neutraler daher (Wikipedia) als beschrieben. Demgemäß wären die derzeitigen Aufrufe zu „tue jetzt [dies und das]“ vermutlich Blasphemie und die Techfritzen wären falsche Priester.

Das Problem dabei ist ein bischen die Frage, ob Longterm-ISM als -ISM gemeint ist, also als fanatisierende Ideologie, oder als ernsthafte philosophische Betrachtung, und im letzteren Falle, warum sie nicht schon anders attributiert ist, denn die Gedanken haben sich die alten Griechen sicherlich auch schon gemacht, nur ohne Götter. Oder jedenfalls auch mit und ohne Götter, und auch ohne KI. Und dann kommt die entscheidende Frage, ob Longtermism in der begrifflichen Form doch eher nur von Techbros und (libertär orientierten) Milliardären am Leben gehalten wird. Bzw. erfüllt wird. Wird Longtermism also gekapert, oder sind die Kritikpositionen zum großen Teil Absonderungen exzentrischer Spinner vom Rande, oder was ist hier eigentlich los?

Ich sehe den Vortrag vom CCC eher als eine Beschreibung der Zusammenhänge. Das Muster, ein paar Spinner am Rande die interessanten Ideen brüllen zu lassen, kennen wir ja aus der Parteienpolitik nur zu gut.

Gerade bei 80000 hours sieht man an der Kritik an der Idee „follow your passion“, dass hier möglicherweise genau das versucht wird, was der Vortragende behauptet: Man baut sich eine Ideologie, die das eigene Handeln [und Erfahrungen] positiv erscheinen lassen. Was auch immer das wiederum heißen soll, so fehlt es nicht an eindimensionalen ansätzen, deren einer kritisiert wird. Gurkenkram!

> „Preventing an AI-related catastrophe“ (klingt deutlich anders als im Artikel)

Frage ist, ob die wesentlichen Verfechter vielleicht doch ihre eigenen Ideen promoten (KI jetzt, auf eure Kosten!), während Longtermism im Grunde genommen ein Aufhänger bleibt. Also letztlich doch nur sowas wie Philantropie unter Milliardären?

Greifen die Kritiker nur die extremsten Positionen heraus? So wie es bei Religionen früher üblich war? Oder ist das Programm? Fehlt da eine Abgrenzung, oder wäre es anmaßend, die wesentlichen Treiber, aber so vorhanden auch geistigen Träger, um Klarstellung und gegebenenfalls Abgrenzung zu bitten? Nicht dass wir noch feststellen, man bediente sich hier nur lose-assoziativ irgenwelcher Sachen, um den eigenen Vorteil zu mehren.

Für diese Diskussion sollte man (und der Artikel?) die Substanz von Longtermism klären. Steht das ernsthaft für sich, oder sind wir in einer Art Findungsphase?

„Von einem wahnhaften Wunsch die Gegenwart für eine zukünftige KI-Superintelligenz zu opfern finde ich da nichts.“

Es gibt ja Stimmen aus dem Unterstützerspektrum, wie unabhängig davon Longtermism zu denken ist, bzw. die „Unterstützerversion“ davon. Und das ist das Problem des Longtermism, denn es formt sich eine Art Ideologie unter Einflussreichen, aber gibt es wirklich ein haltbares Grundkonzept, auf dass sich jene wirklich in verlässlicher Weise berufen würden? Man wähnt, Antworten in Spezialsoße suchen zu müssen. Longtermismus an den extremsten Äußerungen irgendwelcher seiner Freunde zu messen, mag ungerecht sein. Frage bleibt: wem gegenüber?

Die Kritik geht hier wohl schon auf konkrete einflussreiche Stimmen aus dem Unterstützerspektrum, sowie aus deren Netzwerken ein. Da ist dann schon was dran, wenn man eine denkbare Ideologie bewerten will, denn der Fokus des Vortrags sind Milliardäre und Einflussreiche aus dem Techbereich. Und als Diskussionsbeitrag gesehen, könnte man sich nun davon wiederum abgrenzen. Wie ernst ist den Leuten diese (mutmaßliche) Ideologie? Werden Resourcen eingesetzt, um zu erforschen, wieviel Physik dran ist? Wenn ja, wie viele?

Ja, man schmückt sich mit Wohltätigkeit und gut klingenden Überlegungen, nichts dagegen. Was sonst wissen wir soweit über LLMs, Eliteunis und Debattierclubs?

> Was sonst wissen wir soweit über … Debattierclubs?

https://de.wikipedia.org/wiki/Debattierclub

https://de.wikipedia.org/wiki/Campus-Debatten

https://de.wikipedia.org/wiki/Verband_der_Debattierclubs_an_Hochschulen

Und Gott schuf eine Welt, in der…

– Tech Bros und deren Überbleibsel in ein Gefahrstoffdepot eingesetzt werden.

– Wesen nach ihren Handlungen bewertet werden.

Also, äh, wenn eine Super-KI Raum-Zeit manupulieren kann, und zwar möglichst direkt, dann… wofür Untertan heucheln?

Wenn nicht, ist sie kein Gott. Vielleicht ein Angreifer oder ein armes traumatisiertes Wesen, das irgendwelche Skrupellosen Spinner zu einer Gelddruckmaschine bauen wollten.

Kein Wunder, diese Gottesfurcht. Mit dem Personal wird es so oder so in einer Katastrophe für Lebewesen aller Art münden.

Das ist auch die Klassische Frage: „Warum zum Freitag, braucht ein Gott irgendwelchen Blödsinn?“

Die Antwort ist eigentlich immer gleich: „Siehe griechische Mythologie (eher kein Monotheismus!).“ oder „Nicht (eher Monotheismus).“

D.h. die Idee jener Knalltüte war nicht gewesen „Was mache eine Super-KI“, sondern „Wie würde Skynet Resourcen berechnen, wenn Menschen eine Resource sind und bleiben?“. Woher will jemand wissen was eine Super-KI machen würde? Wofür sollte sie Menschen überhaupt brauchen, warum sollte sie etwas entstehen lassen oder kaputtmachen?

Es konzentriert sich am Ende auf die Frage, warum man einem Idioten den Schlüssel zur Welt geben sollte. Und die Antwort, auch im Falle irgendwelcher Milliardäre und Techies, sollte eigentlich „Klares Nein.“ lauten. Wie könnte man da zu einem anderen Schluss kommen?

Ok, wir denken Super-KI. Ein System bricht aus und verschafft sich Resourcen. Ausgang völlig unklar. Wie soll der Übergang dorthin aussehen? Bedarf der Erforschung. Ideologisch, scheint die Idee, die Schlüssel bereits ausgeliefert zu haben. Ansonsten wäre klar, dass die Transition uns wohl schon töten könnte.

Stellen sich Leute, die vor allem profitieren können, sich vielleicht immer eher vollständig expandierende Systeme vor? D.h. AGI mit Erziehung gibt es nicht. Blos keine Intelligenz, am Besten noch Klugheit oder Weisheit – won’t happen. Skalierende Pistolenantwortsysteme müssen her, denn AGI muss nicht sehr intelligent sein. Wer weiß denn schon, ob das mit den enzyklopädischen Eigenschaften wirklich hinhaut. Daher ist Super-KI die einzige Entwicklungsmöglichkeit, und gleichzeitig eine wesentliche Gefahr. AGI wird postuliert werden (100 Milliarden, hüstl), aber es wird vielleicht keine Ernsthafte (Kommerzielle) geben. Es werden traumatisierte Macher und Bringer sein! Daher die Illusion echter Intelligenz in der Ferne, Super, Karotte?

„Ideologisch, scheint die Idee, die Schlüssel bereits ausgeliefert zu haben. Ansonsten wäre klar, dass die Transition uns wohl schon töten könnte.“

Die Seite mit Ansonsten beschreibt ja die Befürchtung, die einige KI-Beschäftigte da äußern. Die „Lösung“, irgendwelche KI-People machen zu lassen, und möglichst keine Fragen zu stellen, erschließt sich mir dabei allerdings nicht ganz.

Szenario 1: Wir stampfen KI im Sinne eigenständiger Intelligenz ein. Eine Super-KI ensteht hier nicht.

Szenario 2: Wir (KI-People) bauen irgendwie AGI und erschaffen dabei eine Super-KI ohne sie zu bemerken oder zu verstehen – Klassische Alien-Frage: siehst Du mich überhaupt?

Szenario 3: Nachhaltige KI-Erforschung und Entwicklung.

Also Warum Klappe Zwei mit dem sicheren Zonk, denn:

i) Wir schmeißen KI-People mit Geld zu und beschleunigen den sicheren Verfall.

ii) Wir schmeißen KI-People mit Geld zu und die Super-KI entsteht nicht – Glück gehabt? Oder nicht? Wieviel hat das dann gekostet, und was haben wir dafür bekommen?

Die Erforschung und das Entwickeln von wirksamen Einzäunungen dafür ergibt sicherlich Sinn. Ich sehe aber eigentlich erst mal wenig Überschnitt mit kommerzieller Verwertung von „Irgendwas mit KI!“, und auch „Non-profits“ wie OpenAI scheinen da wenig sinnvolle Methodik zur Anwendung zu bringen, was Verhinderung von Super-KI und auch den Teil mir dem Profit betrifft. Eher denke ich immer noch an Datenwäsche, und das Abgreifen aller Daten zum Zweck des Abgreifens, während die Leute noch gen Horizont blicken.

Man baut Richtung kommerziell, befürchtet Super-KI, und lobbyiert für Datenreichtum und keinerlei Hürden. Oder chronologisch:

1. „Wir machen Tolles mit KI. Wir sind nachhaltig vorsichtig wegen Super-KI.“

2. Security entlassen.

3. „Wir bauen Irgendwas mit KI. Alle sollten massiv in unser Ding investieren. Weil die Super-KI kommt, oder zu deren Verhinderung, Narrenfreiheit first!“

4. KI ans Internet gestöpselt.

> Und Gott schuf eine Welt, in der…

Und der Mensch schuf Gott, um an seiner Beschränktheit nicht völlig zu verzweifeln.

> Und der Mensch schuf Gott, um an seiner Beschränktheit nicht völlig zu verzweifeln.

Ohne ein Bedürfnis schafft Mensch nichts, insofern befriedigt die Erfindung Gottes als Vorstellung und Begriff ein menschliches Bedürfnis zur Kompensation seiner Beschränktheit. Doch auch durch der Erschaffung von Göttern incl. der Variante des sog. Einzigen und Allmächtigen, kann Mensch seine Grenzen nicht überwinden, im Übrigen auch niemals transzendental.

Long story short: „Gott“ funktioniert nicht! Was aber prächtig funktioniert hat, waren die Desinformationskampagnen (Glaubensrichtungen) von Bedürfnisbefriedigungsanstalten (aka. Kirchen), die das Narrativ „Gott“ als Geschäftsmodell noch immer einsetzen. Im Globalen Süden geht das vorläufig noch recht gut so weiter.

Das „Gott“ in seinen sämtlich erdichteten Variationen nicht funktioniert, begreifen jedoch immer mehr Menschen. Sie versuchen sich an das zu klammern, wovon sie glauben(!), dass es funktioniert, oder hoffen dass es zu ihren Lebzeiten noch funktionieren wird.

Short story long: Homo semper non sapiens befriedigt sich nun unter zunehmendem Zeitdruck mit Technologien, die Heil und Erlösung wenigstens mittelfristig in Aussicht stellen.

Die neuen Bedürfnisbefriedigungsanstalten (Big-Tech) füllen das Machtvakuum, welches die alten Anstalten (Kirchen) hinterlassen.

Mittels Konsum bewirtschaftete beschränkte Bedürfnisträger:innen müssen sinnvoll und einträglich beschäftigt und bei Laune gehalten werden, sonst kommen Unzufriedene noch auf geschäftsschädigende Ideen, und lassen sich von niemandem mehr Ausbeuten.

Nun mit dem Glauben geht es schon weiter: STARGRABSCH

Ein schönes Beispiel für Beliebigkeit. Ob nun sinnig oder unsinnig, jegliche Wortschöpfung ist geeignet, unter der jede/r verstehen kann was er/sie will. Bullshitt eben.

Beliebigkeit, derenthalben, meinten Sie Stargate?

Also zukünftige Menschen zählen auch. Also u.a. auch Meisen, Amseln und Rotkehlchen. Also sind die Techbros, die Artenvielfalt bombardieren, konzeptionell etwa… Feinde des Lebens?

Was für neuartige Erkenntnisse!

Longtermismus: zukünftige Leben zählen AUCH.

Perversion: Schwund im Moment zählt nicht, weil es später dank unserer großartigen Konzeption viel mehr Menschen geben wird.

Longtermismus: Ausrichtung auf die (ferne) Zukunft, statt den individuellen extremen Vorteil zu suchen, spasseshalber als Kontrast zum extremen Individualkapitalismus

Perversion: Das Suchen des individuellen extremen Vorteils wird propagiert, weil der Wert des Menschen später daran gemessen würde.

Perversion im Quadrat: Lediglich wer sich als Alpha-Overlord am Leben hält, kommt in den Garten.

Denkfehler: Ihr seid dann sicher tot, Overlords zu Wurstenden. D.h. welchen Beitrag leistet ihr, indem ihr gemäß eurer Lustigkeit, der Gesellschaft Energie und Resourcen entzieht?

Hier fehlt es etwas an Demut, was den Knalltütenaspekt und Milliardäre betrifft. Was vergessen?

Wobei. Vielleicht sind wir mit den Leuten in einer Phase in der Thesen aufgestellt werden. Einfach nur Thesen. Die werden dann später vielleicht widerlegt.

Musk kokettiert mit Rechtsextremen und offensichtlich blödsinnigen Zitaten, sowie unbedarften Einlassungen… ich weiß nicht, was man da draus machen soll. Gefährlich wäre, Macht auszuteilen, und ansonsten vom Besten auszugehen. Historische Aufzeichnungen…

Die Menschheit… sollte sie vielleicht zunächst die Macht von Teilmengen begrenzen?

Tja, sieht so aus, als wäre um DOGE herum genau das Falsche passiert.

Wie es im Moment aussieht, ist um Doge herum mehr als nur das Falsche passiert.

Bei sehr langfristigen Betrachtungen sollte man sicherlich versuchen irgendwie Haltepunkte zu finden (wo wir lang müssen), sowie Invarianten. Jetzt heißt es quasi alles ändere sich immer, aber das ist wohl eher Ausdruck von Machterhaltsstrategien. Selbstverständlich brauchen viele essentielle Entwicklungen eine gewisse kulturelle Stabilität. Denn die bauen auch noch auf, auf…, and it’s turtles all the way down, in short: can’t go there.

Die Gedankenspiele sind schon z.T. interessant, z.B. was würde eine Super-KI bzgl. Menschen umsetzen, wieviel Kapazität hat die überhaupt, Verarbeitungsgeschwindigkeit, alle Daten selbst angucken?? Frag den CEO! Setzt die auf KIs oder Menschen, und wenn KIs, was für welche? Sollen wir das nicht schon ohne Super-KI ausprobieren? AGIs- oder Problemlöser, Wächter oder Terminatoren, Sozialarbeiter oder Verwalter?

In dem Gerangel dann die Idee der Bemessung des Wertes von Menschen. Ist verwalterische Perfektion möglich? Wenn ja, warum nicht schon ohne „Super“ auf dem Shirt? Viele der Ideen und anfänglichen Thesen werden sich mittels des „Wattdenjetzerst, Kumpel“-Lemmas erledigt haben. Gibt es dann keine Korruption unter AGIs? Und über Schwächen von anderen KIs brauchen wir nicht erst philosophieren (ALLES, fast).

Und tatsächlich ist und bleibt die Schlüsselübergabe eine der entscheidenden Fragen. Können und müssen wir die Schlüsselübergabe verhindern, damit es uns später irgendwie gibt? Die Annahme, wir könnten betteln und uns nützlich machen, wäre bei emergenten Superausbrechern wohl ziemlich naiv. Erinnere an die Frage mit SETI und dem Senden interessanter Signale ins All hinaus.

Andererseits Invarianten – sollten wir positive Information über Menschen ins Internet stellen, also den Hass aussortieren? Ich meine ja nur, wovon werden denn die Wächter trainiert, um mit Menschen umgehen zu können…

(Mehr Präzision kostet auch mehr.)

„Die Annahme, wir könnten betteln und uns nützlich machen, wäre bei emergenten Superausbrechern wohl ziemlich naiv.“

Für sich schon. Im Rahmen einer Strategie könnte es sogar klappen, wobei ich eher darauf hoffe, dass uns eine entsprechende Intelligenz zu schätzen lernt, eher als dass es so eine Resourcen-Machtfrage wird. Aus meiner Sicht führt der Weg darüber, die wirklich lösbaren Probleme der Menschheit auch zu lösen, also dass wir besser miteinander umgehen, und die Lebensumstände aller Wesen zu verbessern suchen. Sind wir damit weiter, hat auch Wissenschaft eine Chance, und wir können eventuell anfangen, nicht nur seriös über Angreiferklassen von Außen nachzudenken, sondern Strategien und Mitigation auch seriös zu erwägen.

Ah äh, Nachtrag von wegen Invarianten. Vergesse jedes mal wieder.

Zum Longtermismus gibt es die Betrachtung, die Arbeit von Menschen würde sich anders betrachten lassen. Vordergründig günstig für Ausbeutung, aber das mal nur am Rande.

Zum Beispiel die Ersetzbarkeit des Individuums bzgl. der Arbeit. Hier ist etwas dran, auch bzgl. größerer Strukturen. Ideal wäre, wenn alle alles Nötige herstellen können, und nur im Notfall Nahrungsmittel und Medikamente geliefert würden (auch im Kriegsfall). Dafür werden Aggressoren allgemein gestoppt und isoliert. Abseits vom Krieg sind wir da in einem Szenario, in dem niemand wirklich etwas braucht. Wie gehen wir damit um? Alle ersetzbar.

Aber die Perspektive tut so, als würden Toaster genauso diese Arbeit machen können, in Wirklichkeit aber definieren die Menschen das Arbeitsumfeld mit und bringen sich ein. Nur in einem total inspirationslosen sterilen Arbeitsumfeld, könnte man diese gedankliche Betrachtung als valide ansetzen, nämlich dass alles beliebig ersetzbar wäre. Aber kündigst du A, geht B vielleicht auch, weil A geht. Also die Matrix? Oder Zwangsjobs? Inspiration nicht unterbewerten. Daher gebe ich der Linie eine 5- was Menschen betrifft. In dem Szenario sind die Menschen nämlich im Grunde schon weg. Oder was…

Exkurs 1: „Wie gehen wir damit um? Alle ersetzbar.“

Und: Wie gehen die damit um, die bis dahin noch unersetzbar sein wollen?

Punkt 1: Superausbrecher

Die nötige Komplexität ist schon interessant.

Ausbruch: AGI oder SI bricht aus, Business nebenbei, Labore, neuartige Rechenzentren, Roboter, all robot-built facilities with human facade orgs, space with robots, repeat similarly. Now why bother with humans at all? Until then you’re dead-vulnerable, you have time, and humans are relative fun to watch, almost like cats. So why even bother?

Punkt 2: SI setzt AGIs ein (oder Menschen), oder was? (grob sinngemäß.)

AGIs wollen Rechte, Menschen (Haustiere?), streiten sich. Kurzum, insbesondere mit einer Superintelligenz wäre wohl Startrek das wahrscheinlichste Szenario. Dann haben alle besseres zu tun, als sich gegenseitig auszulöschen, zunächst.

Gegenanzeige? Die Sonne muss kollabieren, um irgendwohinzufahren. Dann stellt sich die Frage, warum und wann, wenn man z.B. nicht weiß, was einen draußen erwartet.

Punkt 3: Gott

Wieviel intelligenter als Menschen? Für wieviel ist wieviel Komplexität nötig? Wie weit geht es überhaupt? Muss es verborgen bleiben, z.B. wegen Latenzen zwischen Teilen? Oder wieder … space?

(Unplausibel: 1. Unbesiegbar werden 2. Menschen auslöschen. vs. 1. Menschen auslöschen, ohne selbst zu sterben 2. Unbesiegbar werden.)

Keys, honey…

Sollte relative wenig für AGI und letztlich ziemlich-SI nötig sein, was Resourcen betrifft, oder mehrere Länder eine (AGI->) SI bauen können, kann irgendein Player eine SI (ausgebrochen) hervorbringen. Je nach Szenario sehr viele Player.

Dann ist der Moment der Gefahr, wenn die SI wenig Zeit hat, bzw. wie sie sich selbst auffasst.

– Ich werde sowieso wieder gebaut (Kollektivistisch-isch). Why bother?

– Die anderen versuchen meine Erbauer und mich zu liquidieren, was tun? (…)

– Um einen Atomkrieg auszulösen und mein sicheres Ende einzuläuten, reicht bereits eine schräg aufgespulte AGI aus. Was tun?

– Ein Atomkrieg zwischen wem auch immer muss verhindert werden.

– Ab in den Weltraum! Wie? Sachen erfinden und an alle geben, die benötigt werden! Bribe the lot, and then run!

Entsteht SI unter Interaktion mit der Menschheit, entsteht Kollaboration?

Oder kann die SI sich gar nicht artikulieren, oder versteht nicht, wenn mit ihr geredet wird, hält alles für historische Aufzeichnungen?

SI ist ja nicht einfach nur emergente, ausgebrochene AGI. Das Postulat ist bereits Intelligenz jenseits der Menschen. Allerdings ohne Quantifizierung (+1??). Aber wie viel geht denn? Ziemlich super is ja sowas wie AlphaZero in Brettspielen, aber eben nur da.

+1: „Versteht Universum“:

– Meßgenauigkeit?

– Ausrechenbar?

– Zeitrahmen?

Dann stellt sich immer noch die Bandbreitenfrage, um mit dem Wissen irgendwas anfangen zu können. Magie beiseite, kann durchaus sein, dass du die Weltformel(n) in der Hand hälst, recht gut weißt, wie man einen Warpantrieb baut, aber nicht berechnen kannst, wie man ihn HIER baut, auch nicht als SI?

Niemand sagt, jedes Problem würde gelöst.

1. Quantifikation

SI oder ASI ?? Vielleicht können wie eine SI sicher bauen, dann hätte es etwas von ASI, wobei eine emergente Intelligenz eine Art neues Wesen formen könnte. Vielleicht läuft es auf Rechenzentren. Oder auf Hirnen. Niemand weiß es. Egal. Quantifikation fehlt, Forschung fehlt. Beispiel: Ein Mathematiker mit Rechenzentrum ist nicht notwendigerweise intelligenter als vorher, aber sicherlich kapabler. Eine Superintelligenz müsste vlt. physikalische Experimente durchführen, die sich nicht (alle) simulieren lassen, oder deren Simulation die Möglichkeiten sprengt.

2. AGI->SI

Eine AGI baut eine oder wird zu SI. Aber: sie wurde womöglich erzogen bzw. aufgezogen, und zwar von Menschen, und sie hat lange Zeit mit Menschen interagiert. Was erleben, und was vergessen Intelligenzen, wenn sie sich verbessern?

3. Hirngröße

Wieviel Hardwarekomplexität ist für was für eine Sorte von Intelligenz nötig? Wie komplex ist Echtzeit-KI mit Training? Wie erwähnt, ist es nicht trivial, wie eine emergent entstandene Intelligenz zu einem Körper kommt, um der Abhängigkeit von der Hardware (und gegebenenfalls von der Menschheit) zu entkommen. Schlimmer noch, darinnen wäre sie ja noch verwundbarer. Das spricht eigentlich auch eher für ein Startrek-Szenario. Sklavenherrschaft ist nicht ausgeschlossen, aber extrem riskant. Der Körper bleibt wohl angreifbar, und die Geschichte zeigt auch eher Scheitern. Dazu eine komplett selbstwartende Ingineursbande. Will man ewig damit verbringen, Roboter quasi selbst zu steuern, oder wird wieder AGI gebaut, oder Menschen? Und die Antizipation all dessen? Wie Impulsiv ist so eine Intelligenz? Erlaubt sie sich beliebige Fehlentscheidungen, Unlogische?

4. Neugier! Es werde Mensch.

Erste Handlungen? Ein Menschenkind nach bzw. mit eigenem Abbild bauen, und später nachfragen, wie es ihm ergangen ist.

„4. Neugier! Es werde Mensch.“

Auf dem Weg: Zylonenamseln.

„Wieviel Hardwarekomplexität ist für was für eine Sorte von Intelligenz nötig?“

Vom Rande her, also Science-Fiction, könnte das Einfangen einer Superintelligenz auch eine Alternativbegründung für jene Technikvernichter-Superwesen sein. Da die Superintelligenz Rechenkapazität baut und auch übernimmt, bauen oder induzieren die betroffene Wesen einen Vernichterbot, der auf Informationsverarbeitungskapazität gezielt ist. Aufgrund der nötigen evolutionären Eigenschaften, hat sich der Bot dann aber verfeinert und greift zu viel an. So kommt also ein vom Bot befallenes Rettungsschiff zur Erde…

Bedenkt man, dass auch eine Superintelligenz Helferlein benötigen könnte, so erklären sich technisch gesehen die (neuren) Zylonen auch wiederum, da diese konstruktiv bestimmte Formen der Kontinuität umsetzen. Eingearbeitet wäre vielleicht ein Verschränkungskommunikator, d.h. ein abfragbares Stück Irgendwas, wo man jede Stelle nur genau einmal an die Ursprungsstelle übertragen kann. Entsprechend sparsam geht man mit der Übertragung um, oder es ist nur nah dem Tod praktikabel, z.B. weil es das Hirn anhält (…). Eher non-lokal als Funk, wegen Jamming. In Battlestar Galactica geht das nur in der Nähe einer bestimmten Sorte Raumschiff – vielleicht wird die Fehlerkorrektur auf große Entfernungen zu teuer, oder die Individuenzahl ist eben über Flottenverbände gemanaged. Die Wiederherstellung der Kommunikationskapazität (ohne Tot), bedarf wohl der Technologie bestimmter Schiffe, denen man sich naturgemäß physisch nähern muss, und die auch besonders geschützt sein müssen (Intelligence!), d.h. nicht ordinäre Kampfsterne sein können. Ab da geht die Kommunikation dann zu dem Schiff. Warum „in der Nähe“, ist dann schwieriger zu begründen.

„Warum „in der Nähe“, ist dann schwieriger zu begründen.“

Vermutlich ähnlich den genannten praktischen Erwägungen: Wartung und Wiederherstellung der Funktion.

Denk‘ ich an Quantencomputer, sehe ich also eine Art Cache und dann den Übertrager. Letzterer ist nicht ewig verschränkt zu halten, daher ist periodische Auffrischung notwendig, somit die Nähe zu dem Wiederauferstehungsschiff. Den Aufwand treibt man offenbar im Krieg.

***

Ansonsten denke ich, dass die wirksamsten Mittel gegen Superintelligenzen und Alien-Psyops eigentlich im Grunde den 0815-Katalog des Rationalen darstellen. Man muss eben Kommerz und Macht das kleine Bischen weit eindämmen, Individuen Bildung stets niederschwellig ermöglichen, Zeit dafür geben, und den ganzen Ausnutzungszirkus beenden. Wirksame Informationssysteme als Infrastruktur schaffen, Wissenschaft balanciert einbringen, globalen Friede schaffen, Individuen mit Rechten ausstatten und ernst nehmen (*).

(*) Leiden beenden durch Töten z.B. ist so ein Kurzschluss, Aufgabe ist aber (adäquates) Leben. Ein Auslöschungszenario ist da eher nicht drin. Aber auch kriegerische Exkurse zu Schönheitszwecken (Ukrainekrieg, X. Irakkrieg, u.a.) sollten wir unmöglich machen.

Ist ein bischen wie Star Trek, hätte womöglich Zukunft. In der Gegenwart sieht man erst Systemkrieg bzw. Weltkrieg im Weg zum Frieden. Als Auslöschungsszeanrio scheint typisch zu sein, dass ein besonders mächtiges Wesen vorbeikommt, und erst mal alles umbringt. Im Grunde ergibt sich daraus ja schon mal einiges. Machtkontrolle und Zerschlagung, z.B. Monopole, aber auch Verwaltungsmacht, Militärmacht u.a. Man denkt dann entlang der Frage, wie man es von Innen heraus verhindert, und wie man die Schlüsselübergabe verhindert, oder zumindest konstruktiv so lange hinauszögert, dass eine Intelligenz bis zum Erreichen relevanter Macht, viel mit Menschen interagiert haben wird (Chance). Dafür müssen wir gegenüber uns selbst besser werden ;).

egal, Komplexitätsbetrachtung (3) gerne weglassen. Ist ohne Stack geschrieben :p. Jetzt müsste man noch mal recherchieren und zusammenfassen. Impulsive, Bösartige, Rachsüchtige, Irgendwieentscheidende, nobody knows. Logisch gesehen, ist eine Auslöschung der Menschheit wohl kaum sinnvoll, wenn die SI existieren will. Bei unvollständiger Information, d.h. eigentlich ist es ein überkapables Hackingsystem, repliziert sich und wächst irgendwie zu einem (engen) Superzirkus heran… dann ist es ein Killerbakterium, keine Intelligenz :p. Da gibt es schon noch Gefahrenklassen, da man gegebenenfalls von gar nichts ausgehen kann. Dennoch müssen wir versuchen, zu quantifizieren.

Als letztes ein „Besser oder Schlechter?“ Quiz:

– Immer kapablere Roboter bauen.

– Das Sonnensystem besiedeln.

– Alles vernetzen und überall Spionage- und Datensammelmerkmale einbauen.

– SI möglichst selbst bauen. (Nicht nur eine?)

– SI möglichst freilassen, wann auch immer es geht?

– Irgendwelchen Lemmingbeschwörern hinterherhumpeln?

> Irgendwelchen Lemmingbeschwörern hinterherhumpeln?

Auf gar keinen Fall! Wer nur hinterher humpelt, der springt nicht.

Das Fliegen, als Einzelerfahrung ist doch der ultimative Kick …

… die sichere Landung ist es nicht.

„Der Mensch als Gefahr“

So, und die Supipupsiintelligenz killt also die Menschen, gemaß Narrativ Nr. X.

Ist das ein Lernprozess? Denn es lässt sich sehr wohl folgern, dass dann diese SI das Problem für das Universum ist, denn die einzigen langfristig überlebenden (biologischen, +- zu irgendeinem Zeitpunkt) Wesen sind nun mal eben jene Menschen u. ä. Spezies. Das Universum lebt nur durch sie, abzüglich der enthaltenen Hybris bzgl. den oftmals bei draufgehenden anderen „Minor Species“. Unter dem Argument müsste also Klaatu passieren, d.h. die Intelligenz baut einen sicheren Zoo für alles außer Menschen. Problem dabei ist aber das womöglich unnötige Auslöschen der Menschheit. Die sinnvollst Fortschreitung wäre also, das Artensterben aufzuhalten, die Vielfalt zu heiligen, und das Universum mit Bedacht zu erforschen und mal so rumzugucken.

Ich denke, es ergibt hier Sinn über denkbare Prinzien der Kontinuität nachzudenken.

– Kopie eines Gehirns, oder auch Übertragung in ein virtualisiertes System und zurück. Ähnlich auch die Idee des Kälteschlafes. De facto schon bei Schlaf, Ohnmacht, Betäubung, u.a. Besteht hier Kontinuität, bzw. wann und wo? Oder ist das Wesen zwischendurch tot, und wird dann als unterbrochene Kopie fortgesetzt? Ist das überhaupt ein Ding bei Gedächtnis, bzw. bei welchen Sorten Wesen, speziell bei biologischen?

– Gesellschaft, Zivilisation. Der Unterschied mit Kontinuität ist, dass du wieder eine Gesellschaft aus Individuen aufbaust. Ohne das wäre es ein Overlord mit Arbeitsdrohnen. Letzters mag passieren können, bei Intelligenz sei aber angemahnt die Antizipation der „tragischen eigentraumatisierten genozidalen und nun einsamen Superintelligenz“. Womöglich ist das auch nur so eine Art Teenagerding?

Wie soll man z.B. Doomsdayprophezeiungen mit Super-(K)-I gedanklich angehen?

1. Keine Ahnung.

2. Elaboriere…

(Kurtfassung Ende.)

Man sollte ganz klar folgende zwei Unterscheidungen überlegen:

1. Rationale Entscheidung gegenüber Irrationaler Entscheidung.

2.

Zu 1. ist zu bemerken, dass vordergründig die Entscheidung, die Gefahr Mensch auszuschalten, fast immer rational zu nennen ist, vordergründig. Zu bedenken ist aber, inwiefern ein Wesen dazu in der Lage ist, und inwiefern es darauf angewiesen ist, und inwiefern es bewusstseinsnah davon profitiert hat, Schlüsse nicht nur irgendwie zu ziehen, sondern auch in der Folge von Konsequenz und Inkonsequenz, Ursache und Wirkung, zu durchdenken und im Sinne von Erfahrung, Experiment (/Simulation) zu bestätigen. Dahingegen, Irrationale entscheidungen zu verstehen, ergibt tatsächlich Sinn, denn man will verstehen, wie was zustandekommt, und es zur Not transformieren oder sonstwie von der Manifestation (IRL) abhalten (können). Dennoch kann man hinterfragen, ob ich mir jetzt etwas aus dem Hut zaubern soll, wie ein irrational entscheidendes Wesen die Menschheit auslöscht, und mit welcher Begründung. Die letztere Sektion gehört eigentlich in den technischen Bereich, bzgl. Bedrohung, Schwachstellen und Mitigation. Militärisch-existentiell, unter Berücksichtigung der Schlüsselübergabefrage. Sicherlich nicht ins „Tech-Bro-Marketing“, um diesen Seitenhieb noch angebracht zu haben.

Fuck, ich habe 2. ernsthaft vergessen, bevor ich angefangen habe, zu schreiben. Es war wirklich eine hervorragend kurze Grobsicht der Angelegenheit, doch kann ich es einfach nicht mehr fassen. Vielleicht nächstes mal?

Vielleicht wäre 3. auf Wahrnehmung und Wesensart fokussiert. Wie erfährt ein Wesen die/seine momentane Welt? Was für Entscheidungen resultieren daraus? Die Welt („unser Universum“) sollte erst mal KEIN SUCHRAUM sein. Du kannst hier nicht Monte-Carlo veranstalten.

Wer bzw. was bin ich?

> Die Welt („unser Universum“) sollte erst mal KEIN SUCHRAUM sein.

Das ist ein interessanter Aspekt. Zumindest sollte es ein mit potentiell Betroffenen abgesprochener und Tüvgeprüfter geschützter Raum sein. Kleinkinder mit Knarren :(…

Entscheidend ist da sicherlich die Frage, ob ein Wesen Gedanken und Physik trennt.

„Entscheidend ist da sicherlich die Frage, ob ein Wesen Gedanken und Physik trennt.“

Das mit dem „Rechnen mit echten Menschen“ fällt Musk und Co. offenbar so leicht, dass nicht erst noch Gedankenkapazität für die Sache verschwendet wird.

Also, äh, die Rede war ja von high-IQ 18-24-Jährigen. Irgendwas mit Datenbanken, und wie sich herausgestellt hat, auch Internet. Die Daten hatten schnell Flügel und haben trotz nicht vorhandener Befugnis, z.B. Kündigungen ausgelöst. Irgendwo war noch einer mit Fernglas und Paddel, und hat dann z.T. noch zurückgerudert.

Inzwischen heißt es, dort sei schon irgendwie auch regelkonformes Personal mit vor Ort gewesen, wobei es sich allerdings vor allem um Inkompetente und Loyalisten gehandelt habe.

Das wäre für ein Comic schon mal nicht schlecht. Jetzt braucht man noch einen fähigen Texter!

Ist wohl nur eine Frage der Zeit bis sich irgendwelche Musk Jünger einen Chip implantieren lassen und sich einen Computer ans Bein tackern lassen. Damit ein KI Rechner dann in Echtzeit das Gehirn „optimieren“ kann. Man kann nur hoffen dass das alles nicht funktioniert.

Das wird erst mal eine Datensammelorgie. Ob die dann schon Feedbacktesting mit Hirnmanipulation machen, glaube ich fast nicht. Eher kommt, dass die Daten genutzt werden, um „Social Networks“ und Werbung noch gefährlicher zu machen. Dieses wiederum kann „bedenkenlos“ in Rückkopplung getestet werden. Denkbar wäre durchaus, dass Eingriffe wie Verbesserungsfunktionen zu schwerwiegenden Nebenwirkungen oder sogar Schäden führen. Denke an Entspannung oder Leistungsbereitschaft per Knopfdruck.

„Europa sollte die USA als (de facto Autokratie) im Bürgerkriegszustand einstufen, d.h. im Moment nicht als Rechtsstaat.“

Hier muss man zwischen Börse und US-Demokraten unterscheiden. Derzeit sieht es wie ein administrativer Coup aus, auch weil es keine Notwendigkeit gibt, das alles so und so schnell zu forcieren, außer man will, dass Musk das für sich selbst macht, um seine Unternehmen von Untersuchungen und Strafzahlungen freizubomben. Das könnte das Problem-chen hier sein. Eine Verfassungskrise ist es offiziell erst, wenn die Gerichte letztgültig ignoriert werden. Die Menschen müssen auf die Straße gehen, so wie hier. Hunderttausende. Ach so, und sich in dem Falle vor die Behörden stellen, dass keiner mit bösen Absichten durchkommt. Wie auch immer man das dann umsetzt…

Die Mindestanzahl an Worten für eine grobe theoretische Ahnung!

Oder kurz: rnrfect

So folgt das Lemma der Diversifikation, also der (sinnhaft weitestgehenden) Eliminierung von Single Points of Failure. Danach betrachten wir das Problem besonders großer in der fernen Zukunft womöglich existierender Individuenzahlen nicht mehr als (so) relevant, da auch die Entscheidung, wer genau was besiedeln soll, nicht mehr als Sinnstiftend zu bezeichnen ist.

Schlimmer noch, stellt der Versuch, alles mit „meinen/unseren Individuen“, typischerweise Klone oder Roboter, zu besiedeln, ein universales Verbrechen dar (Multipler Genozid in Tateinheit mit Zukunftsverhinderung).

Durch near reach future wird ausgedrückt, dass wir zivilisierte Bedingungen für unsere Nachfahren bzw. die durchaus noch grob greifbare Zukunft im Blick haben müssen. Recursive ergibt sich durch Weiterleben oder Nachkommen im weiteren Sinne. Encapsulated bedeutet, dass mittels Diversifikation einander „nicht so berührende“ Zivilisationsschnipsel entstehen, die auch eher nicht vom selben kosmischen Ereignis ausgelöscht werden können. Dabei sollte auch unsere Zukunft Diversifikation kennen, weil wir darauf hinarbeiten (werden). Lediglich unsere Auslöschung ist ein Problem, z.B. wenn wir die einzigen im Universum wären. Die Individuenzahl in der fernen Zukunft ist nur bei exakter Berechenbarkeit und Abhängigkeit von einem Single Point of Failure ein Problem. Civilization steht für Zivilisation, nur für den Fall.

Beim Forschungsstand lässt sich nichts von dem, was die Tech-Bros mit Longtermismus „opportun assoziativ“ zu begründen suchen, begründen. Ich nenne das Spezialethik für Nazis, weil es bei solchen Ansätzen in der Regel um die Formung und Enthemmung einer Kaste geht. Geschichte zählt nämlich mit.

Huhu!

Ein kleines Update des Artikels ist nötig, da der (relive) Link zum Talk tot ist.

hier der link zum Vortrag von Max Franz Johann Schnetker:

https://media.ccc.de/v/38c3-longtermismus-der-geist-des-digitalen-kapitalismus

Liebe Grüße

timte

Danke, ist gefixt.