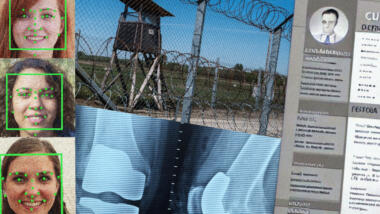

Wenn sogenannte Künstliche Intelligenz Fehler macht, können Unschuldige im Knast landen. Im Jahr 2020 wurde etwa der US-Amerikaner Robert Williams verhaftet, wie die New York Times (NYT) berichtete. Die Polizei war auf der Suche nach einem Ladendieb, und ein KI-System für Gesichtserkennung sagte: Williams sieht aus wie der Verdächtige. „Nein, das bin ich nicht“, sagte Williams, als die Polizei ihm das Foto des Gesuchten zeigte. „Denkt ihr, alle Schwarzen Männer sehen gleich aus?“

Das Beispiel zeigt die typischen Probleme von KI-Systemen: Sie können Leute benachteiligen, die nicht ausreichend in den Trainingsdaten repräsentiert waren, zum Beispiel Schwarze Personen. Und wenn Menschen die Entscheidungen eines KI-Systems unkritisch übernehmen, kann es schnell fatal werden.

Von solchen und anderen Fällen handelt eine neue Resolution des UN-Menschenrechtsrats. In dem Beschluss steht auf Englisch: Künstliche Intelligenz kann diskriminieren, „unter anderem aufgrund von race, Geschlecht, Alter, Behinderung, Nationalität, Religion und Sprache“. Staaten sollen Menschen vor Schäden und Diskriminierung durch KI-Systeme schützen. Sie sollen die Folgen von KI abschätzen und Risiken mindern. Dass solche Dinge wichtig sind, darauf haben sich die Mitgliedstaaten im Menschenrechtsrat am 14. Juli geeinigt. Demnach sollen Trainingsdaten für KI-Systeme „genau, relevant und repräsentativ“ sein. Sie sollen auf Verzerrungen („bias“) geprüft werden.

Wenn der Mensch die Maschine falsch einsetzt

Diskriminierung kann nicht nur passieren, wenn Menschen ein KI-System entwickeln, sondern auch, wenn sie es einsetzen. Auch davor warnt der Menschenrechtsrat. Anschaulich macht das wieder ein Vergleich mit dem Fall von Robert Williams. Es waren letztlich Menschen, die das Ergebnis des KI-Systems nicht ausreichend hinterfragt haben. Die Polizist*innen haben Williams laut NYT erst einmal festgenommen, fotografiert, über Nacht eingesperrt und seine Fingerabdrücke genommen.

Besonders gefährdet sind laut UN-Menschenrechtsrat auch Personen, die „nationalen“, „indigenen“ oder „sprachlichen“ Minderheiten angehören. Der Rat schreibt von Menschen in „ländlichen Gebieten“, von „wirtschaftlich benachteiligten Personen“ und von Menschen in schwierigen Lebenslagen. Sie alle seien einem größeren Risiko ausgesetzt, dass ihre Rechte übermäßig durch KI-Systeme verletzt werden.

Als Gegenmaßnahme sollen Staaten fördern, dass KI-Systeme transparent sind. Das heißt, KI-basierte Entscheidungen sollen erklärbar sein. Außerdem sollen Staaten den Einsatz von KI-Systemen beaufsichtigen.

Redefreiheit in Gefahr

KI ist ein grober Sammelbegriff, Beispiele für konkrete Systeme nennt der UN-Beschluss kaum. Immerhin schreibt der Menschenrechtsrat ausdrücklich von KI-Systemen, die Desinformation und Hassrede eindämmen sollen, etwa in der Content Moderation.

Große Online-Dienste wie Instagram, Facebook, TikTok und YouTube setzen solche Software ein. Sie soll automatisch verdächtige Inhalte erkennen. Anders wäre die Flut an Inhalten kaum zu bewältigen. An dieser Praxis dürfte sich künftig kaum etwas ändern, im Gegenteil. Auch die deutsche Medienaufsicht fahndet inzwischen mit Software nach beispielsweise Volksverhetzung. Laut UN-Beschluss sollten Staaten in dem Bereich Forschung fördern und sich über transparente Lösungswege austauschen. Bei der Moderation von Inhalten sollten Menschenrechte wie Meinungs-, Rede- und Informationsfreiheit geschützt werden.

Die Probleme von KI-Systemen beschreibt der Beschluss zwar ausführlich. Aber konkrete Pflichten für Staaten stehen in dem Beschluss nicht. Die Mitgliedstaaten „heben“ lediglich die Wichtigkeit der Themen „hervor“. Hervorgehoben wird der „Bedarf“, den Themen „besondere Aufmerksamkeit zu schenken“. Das ist der Sound von gemeinsamen Beschlüssen auf internationaler Bühne: weich und unverbindlich.

Immerhin bringt der Beschluss die grundrechtlichen Probleme von KI-Systemen weltweit auf die Agenda. Im UN-Menschenrechtsrat sind 47 Staaten vertreten, darunter autoritäre Regime. Wie die französische Nachrichtenagentur AFP berichtet, haben Österreich, Brasilien, Dänemark, Marokko, Singapur und Südkorea die Resolution vorgeschlagen. Trotz ihrer Zustimmung im Rat hätten China und Indien gesagt, sie seien mit dem Ergebnis nicht ganz einverstanden.

Die EU verhandelt ihr KI-Gesetz genau jetzt

Aktuell verhandeln das Europäische Parlament, der Ministerrat und die EU-Kommission ein KI-Gesetz für die EU. Es soll sogenannte Künstliche Intelligenz umfassend regulieren. Das Gesetz ist das erste seiner Art, es könnte international Maßstäbe setzen.

Während die EU im Trilog hinter verschlossenen Türen am finalen Text arbeitet, drängen Bürgerrechtler*innen auf den Schutz von Grundrechten. Über die größten Probleme im KI-Gesetz haben wir hier berichtet. Unter anderem wollen Staaten selbst gefährliche KI-Systeme für die „nationale Sicherheit“ einsetzen. Solche Ausnahmen können Löcher in das eigentlich ambitionierte Gesetz reißen.

Um diese und weitere Probleme dreht sich auch ein Aufruf von NGOs wie European Digital Rights, Algorithm Watch und Amnesty International. Er wurde am 12. Juli veröffentlicht, insgesamt haben ihn 150 Organisationen unterzeichnet. Sie fordern die EU-Organe auf, „Menschen und ihre Grundrechte im KI-Gesetz an erste Stelle zu setzen“.

Vor allem der Hype um den Chatbot ChatGPT hat KI in den Fokus einer breiteren Öffentlichkeit und vieler Regierungen gerückt. Auch die USA planen neue Regulierungen. Am 17. Juli berichtete die Agentur Reuters, dass die EU in Asien für Regeln nach dem Vorbild des KI-Gesetzes lobbyiert. Demnach soll es Gespräche mit Vertreter*innen aus Indien, Japan, Südkorea, Singapur und den Philippinen gegeben haben. Die Reaktionen seien aber verhalten gewesen; die Regierungen würden demnach lieber erst einmal abwarten.

„Wenn der Mensch die Maschine falsch einsetzt“

Nur nicht aus den Augen verlieren: Nicht alle Maschinen können richtig eingesetzt werden. Ähnlich wie mit personalisiertem Tracking, sogar mit ähnlichen Konsequenzen (Schutz davor begünstigen, auf allen Ebenen, weil sonst kaputt).

Das ist im Grunde auch eine Form von Fäkalhumor, dass der Kommerz eine Maschine hinsetzt, und wir jetzt bitteschön die Maschine richtig nutzen sollen.

Natürlich geht das nur in Abstraktion, dass man sich fragt, wie jetzt „social networks“ allgemein, oder in jew. spezifischerer Form, Nutzen bringen, wo nicht, wo Gefahren sind. Real passiert alles mögliche von verschiedensten Seiten, aber gesellschaftlich sind wir eigentlich immer noch „stuck in using THEIR machines“.

Das ist nicht locker, vor allem in Zeiten von Verteilungskämpfen. Wir wären also gut beraten gewesen, rechtzeitig ein vernünftiges System gebaut zu haben /hätten /Fahrrrradketten. Auf der positiven Seite gibt es durchaus grobschlächtige Ansätze, wie „Kompletto illegal wegen Datenschutz!“, die so traurig das für den mit den großen Anbietern nicht existierenden Markt ist, der einzige Weg im (späten) Umgang mit diesen zu sein scheint (bzgl. Rigorosität, nicht unbeding nur komplettes Verbot). Kosmetisch jedenfalls, könnten wir das mit einer zukünftigen entwickelbaren Gesellschaft einpacken, dann werden Teilhabe und Möglichkeiten zu großem Prozentsatz von KI und ihren Managern bestimmt, während Konzepte nicht ganz auf Freiwilligkeit basierender Euthanasie wieder ein Blatt im eigenen Buche bekommen (Nicht wil alle NAZIs sind, sondern weil es so unglaublich konvenient ist, und z.B. auf Arbeitskraft hin optimiert wird.). Z.T. wird das nicht verhinderbar sein, dass KI indirekt viel bestimmt, u.a. wegen des Marktzwanges, aber wir dürfen auf keinen Fall dorthin, dass sie direkt KI-Systeme zulassen, die diese Sorten Manipulationen und Eingriffe durchführen. Auch nicht indirekt-effektiv.

Bei Cloudbasierten Systemen die ganze Horden von Mitarbeitern ersetzen, sollten im Zusammenhang mit Sanktionen und Verteilungskämpfen gesehen werden. Self-kill-move (societally).

Der normale Durchschnittsbürger wie ich ist überfordert sich gegen unangemessene oder gar einer fortlaufend dauerhaften Überwachung zu dessen TK und darüber hinaus einer Beobachtung seiner Person angemessen zu wehren.

Staatsanwaltschaften haben hierzu (u.a. auch wegen deren ständiger Arbeitsüberlastung) kein Interesse Vorermittlungen geschweige denn ein Verfahren gegen Unbekannt einzuleiten.

Es wäre für Betroffene wünschenswert, wenn es hierzu eine spezielle kompetente Behörde gäbe, an welche man sich vertrauensvoll wenden könnte.

D. Beyer

Es ist komplett unmöglich KI zu regulieren. Es ist notwendig Datennutzung und Geschäftsmodelle, mithin also die Betreiber, zu regulieren. Dabei spielt keine Rolle, ob ihr tun mit Hilfe einer KI oder irgendwie anders ermöglicht wurde.

Die Verantwortung einem Programm zuzuschreiben ist absurd und der feuchte Traum von Behörden, Polizei, Geheimdiensten und einer Industrie. Die naive Sicht auf KI spielt einzig Konzernen in die Hände. „Ein Computerfehler, da kann man nix machen“ würde Fefe spotten wenn sich die Verantwortlichen mit einer rassistischen KI herausreden. Genau diese Möglichkeit bietet aber die Idee, KI regulieren zu wollen.

Liebe Politik: Formuliert, was ihr warum erreichen wollt und nicht primär wie ihr das erreichen wollt. Sonst sind eure Gesetze morgen schon überholt. Die Technik schreitet schell fort und ihr habt doch jetzt schon keinen Schimmer, wie eine KI funktioniert, was sie kann und wo ihre Grenzen liegen. Sorgt erst einmal für Datenschutz und zieht Facebook und Co einmal effektiv zur Verantwortung.

Wieso unmöglich? Verwaltung und kommerzielle Dienste können sehr wohl Vorgaben umsetzen. Betrug geht immer irgendwo, aber das ist eben dann auch die strategische Abhängigkeitsfrage, winkend mit russischem Gas und chinesischem Arbeiter. Zur KI-Regulierung gehören ja jene Trainings- und Datenfragen.

Natürlich gibt es weitere Bereiche im Kommerz, und auch in halbschattigen Datensammel- und Verarbeitungsbereichen, wo das nicht so einfach prüfbar ist. Uns bleibt vielleicht nichts anderes übrig, als die Nachteile zu identifizieren, und zu bekämpfen. Rassistische Systeme sind so ein Nachteil, und wer bei der Mitarbeiteraussiebung ein solches einsetzt, hat vielleicht alsbald ein Problem, und der Hersteller steht dann auch in Frage.

Was den Hype betrifft, muss man sehr aufpassen nicht überall diese generativen Systeme und großen Sprachmodelle zu vermuten – die werden unweigerlich einen starken, vielleicht bis zu fatalen Impakt haben (ohne super zu sein oder zu werden), sind aber nicht überall das (einzige), was zum Einsatz kommt. Wir sind nicht plötzlich auf allen Gebieten der Anwendung von „irgendwas mit KI“ unendlich weit. Am weitesten sind wir dort, wo ein Ergebnis schnell zustandekommt, und sich möglichst auch noch automatisiert (möglichst schnell) prüfen lässt. Halbkonsistente Sprachhalden können Schnittstellen bilden und Lücken füllen, die sonst mit erdachtem Schrott gefüllt worden wären, aber die harten Fakten sind Solarmodule und Batterien die funktionieren, Moleküle die funktionieren, Unternehmen die Funktionieren, usw. usf. Natürlich kann ein Mensch die Sprachhalde prüfen, ist ohne Enzyklopädie und entsprechend Zeit aber gern mal etwas aufgeschmissen dabei.

Wie man herangeht lässt man immer weitläufige Gebiete aus, die von „KI“ wie wir sie derzeit kennenlernen, bestrichen werden werden.

> „Sorgt erst einmal für Datenschutz und zieht Facebook und Co einmal effektiv zur Verantwortung.“

„Aber das geht doch nicht. Dann müssten wir uns aufwendig andere Kofferlieferanten suchen.“

Naja, die Schwierigkeit besteht darin, die schädlichen Aspekte irgendwie einzudämmen ohne die coolen Aspekte wie KI-Cover („Wie klingt „Fly Me To The Moon“ gesungen von Freddie Mercury?“) oder ähnliche KI-Kunst gleichzeitig auch noch abzuwürgen. Zum Abwürgen zähle ich auch diese eklige Diskussion um Wasserzeichen in KI-Bildern.

> Zum Abwürgen zähle ich auch diese eklige Diskussion um Wasserzeichen in KI-Bildern.

Wasserzeichen könnten ein Instrument sein, die unerwünschte Verarbeitung von Bildern/Bilddaten durch KI rechtswirksam zu unterbinden.

„Wasserzeichen könnten ein Instrument sein, die unerwünschte Verarbeitung von Bildern/Bilddaten durch KI rechtswirksam zu unterbinden.“

Ähm ja ok. Aber es verhindert trotzdem nicht die Trainingsdatenapokalypse – abgeleitete und modifizierte Werke werden keine Wasserzeichen enthalten und in die Trainingsdaten einsickern.

Am Ende haben wir des Kaisers neue Kleider, in einer Situation, in der wir uns abhängig von Clouddiensten gemacht haben, die uns dann mit Tricks vorgaukeln, dass alles gut wird, während die Stagnation einen unmöglichen unaushaltbaren Zustand herstellt.

Gut das nur als Huckepackbrötchen, ich meinte natürlich: Es verhindert höchstens den kommerziellen legalen Wisch über das Netz, nicht aber die Nutzung dieser Machwerke ohne Wasserzeichen. So gesehen kann „juristisch wirksam“ nicht das Heilmittel sein.

Lösungen werden bereits geboten, das läuft aber über eine Positivdatenbank von Privatanbietern wie Adobe o.ä. Also wirklich „sicher“ ist nur, wer einen von denen stecken hat, was auch immer man dann dafür wiederum unterschreiben muss…

Eight Months Pregnant and Arrested After False Facial Recognition Match

https://www.nytimes.com/2023/08/06/technology/facial-recognition-false-arrest.html