Die derzeitigen Kriege des Westens sind vom Einsatz neuer Waffentechnologien wie den Drohnen geprägt. Sie bieten sich als Alternative zum personalintensiven und risikoreichen Einsatz von Bodentruppen an und versprechen zugleich präzisere Militärschläge mit weniger zivilen Opfern. Dennoch bleibt ihr Einsatz hoch umstritten – unter anderem auch, weil sie die Hemmschwelle für militärische Interventionen deutlich gesenkt haben. Wann und unter welchen Umständen und mit welchen Einschränkungen Drohnen und autonome Waffensysteme angewendet werden, ist auch mit ethischen Fragen verbunden.

Dies ist ein Gastbeitrag von Bernhard Koch und Niklas Schörnig. Die ungekürzte Fassung ist erschienen in „vorgänge. Zeitschrift für Bürgerrechte und Gesellschaftspolitik“, Nr. 218, Rückkehr zum gerechten Krieg?, S. 43–53.

Dies ist ein Gastbeitrag von Bernhard Koch und Niklas Schörnig. Die ungekürzte Fassung ist erschienen in „vorgänge. Zeitschrift für Bürgerrechte und Gesellschaftspolitik“, Nr. 218, Rückkehr zum gerechten Krieg?, S. 43–53.

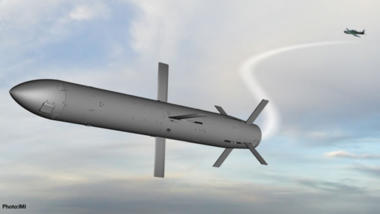

Die militärische Robotik verzeichnet in den letzten zehn Jahren eine besonders dynamische Entwicklung. Immer mehr Militärs weltweit greifen auf Roboter zurück, speziell bei Aufgaben, die für Menschen zu dreckig, zu langweilig oder zu gefährlich wären. Unbemannte Flugsysteme (UAVs, Unmanned Aerial Vehicles), oft auch als „Drohnen“ bezeichnet, sind die bekannteste und am weitest verbreitete Variante militärischer Roboter.

Mehr als neunzig Staaten setzen inzwischen militärische Drohnen (pdf) zur Aufklärung und Überwachung ein, und mehr als dreißig Staaten streben nach bewaffneten Systemen oder haben diese schon in ihren Arsenalen. Inzwischen verfügen sogar nichtstaatliche Akteure, wie zum Beispiel der IS, über kommerzielle Drohnen, die nachträglich bewaffnet wurden. Allerdings hat sich nicht nur die reine Anzahl ferngesteuerter Systeme oder die Zahl der sie nutzenden Akteure erhöht. Auch ihre technologische Leistungsfähigkeit wurde in den vergangenen Jahren deutlich gesteigert. Militärische Roboter sind zumindest aus den Arsenalen fortschrittlicher Armeen praktisch nicht mehr wegzudenken.

Militärische Roboter, besonders aber ihre bewaffneten Varianten, werfen eine Vielzahl von kritischen Fragen auf. Neben der taktischen respektive strategischen und rechtlichen Dimension betrifft dies vor allem auch ethische Fragen. Man erinnere sich nur an die heftige Diskussion, die die Aussage des damaligen Verteidigungsministers Thomas de Maizière auslöste, Kampfdrohnen seien, wie alle Waffen, ethisch neutral zu betrachten. Diese Debatte dauert im Kern noch an und wird durch die zunehmende technologische „Selbstständigkeit“ moderner Waffensysteme noch gesteigert.

Die rasante Entwicklung militärischer Robotik seit der Jahrtausendwende

Eine zentrale Ursache des Booms militärischer Robotik ist der schnelle, sich in einigen Bereichen sogar beschleunigende technologische Fortschritt, der unbemannte Systeme möglich werden lässt, die noch vor wenigen Jahren technisch undenkbar gewesen wären. Zumindest in den technologisch fortgeschrittenen Staaten kommt inzwischen praktisch kein Waffensystem mehr ohne Elektronik aus.

Unter dem Begriff „militärische Robotik“ kann man auf einer ersten Ebene vor allem den Bereich unbemannter, aber ferngesteuerter Systeme verstehen. Auch wenn immer mehr Aufgaben durch Computer übernommen werden oder der Computer den menschlichen Operator unterstützt (zum Beispiel indem vorgegebene Wegpunkte automatisch abgeflogen werden), trifft ein Mensch immer noch alle zentralen Entscheidungen – speziell wenn es um dem Einsatz tödlicher Gewalt wie bei den US-Kampfdrohnen-Missionen geht. Diese Systeme zeichnen sich vor allem durch sehr lange „Stehzeiten“ aus, also das Vermögen, zum Teil ein bis zwei Tage lang in der Luft zu bleiben.

Auch spielt bei diesen Systemen die deutlich gestiegene Bandbreite der Kommunikationsverbindungen eine wichtige Rolle. Sie ermöglicht es, hochaufgelöste Filme in Echtzeit zu übertragen und so weit entfernten Kommandostellen ohne Verzögerung ein Lagebild im Einsatzgebiet zu liefern – und das über die gesamte Missionszeit. Der Einsatz solcher Militärroboter kann die Gefährdung für die eigenen Kräfte signifikant reduzieren und ermöglicht deshalb neue Missionen, die mit bemannten Systemen schlicht als zu gefährlich verworfen würden. Dies ist ein von Befürwortern unbemannter bewaffneter Systeme besonders häufig vorgebrachtes Argument. Kritiker verweisen hingegen auf die stark umstrittene Praxis der Vereinigten Staaten, bewaffnete Drohnen im Rahmen „gezielter Tötungen“ gegen mutmaßliche Terroristen im Graubereich des Völkerrechts einzusetzen. Sie argumentieren, dass die minimierte Gefahr eigener Verluste die Hemmschwelle für den tödlichen Einsatz senkt.

Eine zweite, weitergehende Sichtweise auf militärische Robotik nimmt die zunehmende Fähigkeit vieler militärischer Systeme in den Blick, Einsätze praktisch ohne menschliches Zutun durchzuführen. Experten sprechen in diesem Zusammenhang von „autonomen Waffensystemen“ bzw. „letalen autonomen Waffensystemen“ (LAWS), wenn sie gegen Menschen eingesetzt werden. Was genau unter einem „autonomen Waffensystem“ zu verstehen ist, ist umstritten. Eine erste und sehr hilfreiche Annährung bietet die Direktive 3000.09 (pdf) des amerikanischen Department of Defense vom 21. November 2012, die unter einem „autonomen Waffensystem“ folgendes versteht:

A weapon system that, once activated, can select and engage targets without further intervention by a human operator. This includes human-supervised autonomous weapon systems that are designed to allow human operators to override operation of the weapon system, but can select and engage targets without further human input after activation.

Zwei Aspekte sind an der Definition besonders bemerkenswert: Erstens erfolgen Zielauswahl und Zielbekämpfung durch ein System ohne weiteren menschlichen Input. Den Menschen kommt zweitens bestenfalls die Rolle einer Überwachungsinstanz mit der Möglichkeit zum Abbruch der Operation zu; im schlechtesten Fall werden sie zu Zuschauern degradiert, die sich vollständig auf die Computeralgorithmen des Systems verlassen müssen, ohne eingreifen zu können.

Wer nun glaubt, solche Systeme seien reine Science-Fiction-Fantasien, irrt. Es gibt heute schon Waffensysteme, die die genannten Anforderungen zumindest rudimentär erfüllen könnten – sofern man sie in den (oft vorhandenen) vollautomatischen Modus stellen würde. Hierbei handelt es sich bislang um Selbstverteidigungssysteme zum Schutz von Schiffen oder Lagern, die anfliegende Raketen oder Granaten selbständig detektieren und bekämpfen. Technisch vorstellbar, wenn auch noch nicht zuverlässig umsetzbar, sind zum Beispiel Systeme, die auf einem Schlachtfeld alle Personen angreifen, die nicht durch einen speziellen Sender als „Freund“ gekennzeichnet sind oder die auf Basis einer Gesichtserkennungssoftware bestimmte Zielpersonen in einer Gruppe identifizieren und töten. Gegenüber den aktuell mit Kampfdrohnen praktizierten „gezielten Tötungen“ wäre dies eine neue Stufe. Noch setzt kein Staat vollautonome Waffen gegen Menschen ein. Die Systeme, die autonom eingesetzt werden könnten, sind bewusst immer noch von menschlicher Zustimmung abhängig.

Die aktuell wohl größte Hürde für solche Systeme ist, dass sie – zumindest zum jetzigen Zeitpunkt – nicht in der Lage sind, zentrale Forderungen des Internationalen Humanitären Völkerrechts (IHL) angemessen umzusetzen, wie zum Beispiel die Unterscheidung zwischen Kombattanten und Zivilisten oder der proportionale Einsatz der Mittel zum angestrebten militärischen Ziel. Es ist aber nicht auszuschließen, dass die Technologie voranschreitet und eine adäquate Umsetzung des Völkerrechts in den Bereich des Möglichen rückt. Deshalb gilt es, neben der rechtlichen Seite auch die ethische Seite der militärischen Robotik und die mit ihr verbundenen strategischen Entwicklungen zu betrachten.

Kampfdrohnen und gezielte Tötungen

In den letzten eineinhalb Jahrzehnten (vor allem nach dem Irak-Krieg) ist die Diskussion um die Theorie des gerechten Krieges wieder neu entflammt, hat bedeutende Wendungen genommen und wird nun auch auf die ethischen Probleme des Einsatzes militärischer Robotik angewandt. Nach dem Sozialphilosophen Michael Walzer ist Krieg eine Handlung, die politische Gemeinschaften vornehmen. Die politische Führung begeht ein Verbrechen, wenn sie unberechtigterweise einen illegitimen bewaffneten Konflikt vom Zaun bricht. Für ihre Armeen heißt das: Wenn die Kämpfer gemäß der Regeln töten, ist ihnen das nicht moralisch anzulasten. Warum und für welche Ziele sie kämpfen, ist nach Walzer irrelevant. Diese Sicht drückt sich heute im Wesentlichen im humanitären Völkerrecht aus.

Für die revisionistische Theorie des gerechten Krieg hingegen gibt die individuelle Selbstverteidigungssituation das normative Muster ab, von dem her auch bewaffnete Konflikte gedacht werden müssen. Hier hilft eine Analogie aus dem zivilen Leben: Einem Angreifer steht im Falle eines ungerechten Überfalls, wenn er in gerechter Notwehr oder von dritten Personen in gerechter Nothilfe gewaltsam gestoppt wird, selbst keine Notwehr zu; er kann eigene Gewalt nicht damit entschuldigen. Übertragen bedeutet das: Wer sich an einem ungerechten Krieg beteiligt, ist nach dieser Theorie moralisch haftbar und kann sich nicht beschweren, wenn er oder sie selbst angegriffen wird.

Eine Schwierigkeit dieses Ansatzes liegt darin, dass sie der politischen Natur von bewaffneten Konflikten nicht ganz gerecht wird. Ein Vorteil dieser individualistischen Sichtweise hingegen ist, dass man sie einfacher auf die Beteiligung von nichtstaatlichen Kriegsakteuren und die sich immer weiter individualisierende Militärtechnologie anwenden kann. Die Entwicklung und Nutzung von bewaffneten Drohnen hat die Praxis der sogenannten „gezielten Tötungen“ erheblich ausgedehnt. Gezielte Tötungen sind natürlich nicht nur mit bewaffneten Drohnen – also militärischer Robotik – möglich. Aber dass sie insbesondere am Ende des letzten Jahrzehnts so häufig geworden sind, hat selbstverständlich auch mit der technischen Verfügbarkeit des Instruments und den relativ gefahrlosen Einsatzmöglichkeiten zu tun.

Der Unterschied in den beiden ethischen Herangehensweisen kann an einem Drohneneinsatz gut verdeutlicht werden:

Die sogenannte „traditionelle Theorie des gerechten Krieges“ bei Michael Walzer unterschied gewissermaßen verschiedene normative Wirklichkeiten: die Wirklichkeit des Alltagslebens und die Wirklichkeit des Krieges. Krieg gilt hier als ein normativer Sonderzustand. Entsprechend ist für die ethische Bewertung von Drohneneinsätzen nur zu fragen, ob erstens tatsächlich ein Krieg bzw. bewaffneter Konflikt zwischen zwei oder mehreren politischen Gemeinschaften vorliegt und ob zweitens das Mittel der Kriegsführung dem ius in bello (also dem humanitär-völkerrechtlichen Bestimmungen, z. B. den Genfer Konventionen und seinen Zusatzprotokollen) entspricht. Sind diese beiden Bedingungen erfüllt, ist der Einsatz bewaffneter Drohnen aus theoretischer Sicht legitim und völkerrechtlich legal.

Für den Revisionismus in der Theorie des gerechten Krieges hingegen müssen sich Gewalthandlungen daran messen, ob sie individuelle Rechtsverletzungen verhindern. Krieg wird nach den gleichen normativen Regeln betrachtet, mit denen wir auch Gewalt im Alltag beurteilen würden. Es kommen also die oben diskutierten Bedingungen legitimer Selbstverteidigung (oder eben Fremdverteidigung) ins Spiel. Eine entscheidende Frage in diesem Zusammenhang ist, ob die eingesetzte Gewalt nötig ist, um die widerrechtliche Gewalt des Angreifers abzuwehren. Das ist sie nur dann, wenn der widerrechtliche Angriff schon stattfindet oder zumindest unmittelbar bevorsteht. Die Bedingung des „immediate threat“ ist für legitime Verteidigung ein entscheidendes Kriterium.

Im Endeffekt erfordert dieser Ansatz eine Beurteilung von Gewalteinsätzen auf der Basis dessen, was wir heute Grund- oder Menschenrechtssystematik (pdf) nennen können. So darf beispielsweise keine Person mit tödlicher Gewalt angegriffen werden, wenn zur Abwehr der Bedrohung, die von ihr ausgeht, auch die Festnahme reichen würde. Hierfür eignen sich Drohnen – im Gegensatz beipielsweise zu Spezialkräften – nicht. Drohnen können nur beobachten und töten, sie kennen keine Zwischenstufen.

Andererseits ist im Falle einer legitimen Selbstverteidigung die illegitim angegriffene Person selbst nicht „haftbar“. Sie unterliegt keiner Pflicht, größere Risiken im Verteidigungsakt auf sich zu nehmen. Sie unterliegt aber einer Pflicht, die Risiken für unbeteiligte Dritte so gering wie möglich zu halten, denn auch diese dritten Personen sind nicht haftbar. Diese beiden normativen Momente können dazu führen, dass sich der legitime Verteidiger gewissermaßen moralisch gezwungen sieht, das präzise technologische Instrument aus der Distanz zu nutzen, das den „Kollateralschaden“ und die Bedrohung für ihn selbst möglichst gering hält. Eine eindeutige ethische Ablehnung des Einsatzes bewaffneter Drohnen lässt sich also auch bei den „Revisionisten“ nicht aus der revisionistischen Variante der Theorie des gerechten Friedens herauslesen; vielmehr gilt es, bei jedem individuellen Fall erneut abzuwägen.

Autonome Militärrobotik

Auch die Nutzung von LAWS lässt sich nach den beiden genannten Perspektiven beurteilen: Für die traditionelle Theorie des gerechten Krieges ist militärische Robotik nicht ausgeschlossen, wenn sich deren Gewalt an völkerrechtlichen Kernprinzipien messen lässt, also z. B. nur gegen klar identifizierbare und identifizierte gegnerische Kombattanten richtet. Es mag eine offene Frage sein, ob LAWS diese Unterscheidung technisch gelingt oder ob sie die Verhältnismäßigkeit ziviler Kollateralschäden beurteilen können. Die technischen Unzulänglichkeiten schließen ihre Nutzung aber nicht generell aus.

Aus Sicht der revisionistischen Theorie des gerechten Krieges hingegen müsste auch ein autonomer Militärroboter erst einmal versuchen, eine Zielperson mit nicht-letalen Mitteln lediglich festzunehmen. Ebenso wenig wie ein Polizist einen in flagranti gestellten Mörder einfach erschießen darf, weil dieser über grundlegende Rechte verfügt, dürfte ein autonomer Roboter einen Gegner einfach so töten – selbst wenn dieser plant, einen illegitimen Angriff auf Menschen durchzuführen. Dies gilt umso mehr, als der Roboter natürlich keine Rücksicht auf sein eigenes „Überleben“ nehmen muss.

Jenseits der beiden Ansätze gibt es weitere ethische Fragen mit Blick auf autonome Waffensysteme:

- Die Intuition, dass Maschinen nicht über das Leben von Menschen entscheiden dürfen,

- die Vermutung einer Verantwortungslücke,

- neu auftretende Risiken.

Hier fällt die Bewertung ebenfalls uneinheitlich aus.

1.) Vielfach wird vorgebracht, dass autonome Waffensysteme nicht über Leben und Tod von Menschen „entscheiden“ dürfen. Das ist eine verwirrende Ausdrucksweise, denn eine Maschine entscheidet nicht im selben Sinne wie ein Mensch. Wir deuten mit solchen Redeweisen das Verhalten von Maschinen mit anthropomorphen Ausdrücken, vom Menschen her. Aber vielleicht deuten wir bald das menschliche Verhalten mit Ausdrücken, deren Gehalt wir vor allem aus maschinellen Abläufen entnehmen. Das würde zu einer Selbstreduktion des Menschlichen führen. Wer seine Ethik bloß an Handlungsfolgen ausrichtet, sieht in der maschinellen „Entscheidung“ nicht notgedrungen einen Einwand gegen autonome Waffensysteme.

2.) Einige Autoren heben daher auf eine andere Norm ab: Es darf nicht sein, dass Menschen einen Prozess in Gang setzen, für den sich keine (natürliche) Person mehr verantwortlich machen lässt. In der Tat beunruhigt es die meisten, wenn etwas vor sich geht, für das keine zuständige Person verantwortlich gemacht werden kann, falls etwas schiefläuft. Verfechter autonomer Robotik könnten hier einwenden, es müsse uns doch nicht stören, dass niemand verantwortlich ist, solange die Ergebnisse, die mit der Nutzung der Robotik erzielt werden, deutlich besser sind als ohne deren Nutzung. Oder provokant gefragt: Was hat man davon, wenn man eine Person für ein schlechtes Ereignis verantwortlich machen kann, zu dem es bei Nutzung von „unverantwortlicher“ Robotik vermutlich gar nicht gekommen wäre?

Verantwortlichkeit ist eine soziale Relation: Vielfach ist sie nicht einfach „natürlich“ gegeben, sondern in einer gesellschaftlichen Praxis etabliert oder durch soziale Institutionen (wie dem positiven Recht) erst erzeugt. Die Frage, ob die Programmierer, die Hersteller, Nutzer oder andere die Verantwortung für die ungewünschten und schädlichen Auswirkungen von autonomer Robotik tragen sollen, ist wichtig; vielleicht ließe sich in einem konsensuellen Prozess eine Antwort darauf finden.

3.) Auch wenn sie nicht jeden überzeugen mögen, sind mit den beiden Argumentationslinien Probleme angezeigt, die zu vertiefter Reflexion auffordern: zur Weise, wie wir Verantwortlichkeit verstehen, und zu Analogien bzw. Disanalogien im Sprechen über Mensch und Maschine. Für das praktische Urteil im angewandt-ethischen Sinne ist wahrscheinlich gar keine so vertiefte Reflexion nötig. Möglicherweise liegt der Haupteinwand, der sich gegen tödliche autonome Waffensysteme vorbringen lässt, auf der schlichten Ebene der Risikoabwägung komplexer Systeme. Wir wissen heute einfach nicht, was alles mit solchen Geräten passieren kann. Welche Auswirkungen sind zu erwarten, wenn zwei autonome Waffensysteme miteinander in Kontakt kommen? Verstärken sie sich dann gegenseitig und treten eine Kaskade von Waffenanwendungen los? Natürlich können auch große Risiken wieder abgewogen werden gegenüber großen günstigen Folgen. Dennoch spricht vieles für eine Art „Vorsichtsprinzip“, das bei sehr großen Risiken eine ethische Bremse einzieht. Risiken, die wirklich an die Substanz unserer Lebensgrundlagen gehen, sollten auch bei großen Vorteilen nicht eingegangen werden. Denn große Risiken kollektivieren in unvertretbarem Ausmaß: Den Schaden haben alle zu tragen, auch jene, die von den Vorteilen nicht profitieren oder profitiert hätten. Die Risiken der Nutzung autonomer Waffensysteme gehören aber möglicherweise genau in diese Kategorie derer von unvertretbarem Ausmaß.

Wie weiter?

In der Summe ist festzuhalten, dass der Einsatz von Kampfdrohnen und auch von zukünftigen letalen autonomen Waffensystemen aus Sicht der Theorie(n) des gerechten Krieges ethisch durchaus kontrovers diskutiert werden kann, die Kritik an letalen autonomen Waffensystemen breiter und fundamentaler ausfällt. Dies drückt sich auch in der Debatte um Kampfdrohnen und LAWS aus. Während Kampfdrohnen immer stärker zu einem grundsätzlich akzeptierten militärischen Mittel werden, bei dem von der Mehrheit der am Diskurs Beteiligten nur das „wann“ und nicht das grundsätzlichere „ob“ diskutiert wird, hat sich gegenüber letalen autonomen Systemen eine breite gesellschaftliche Abwehrfront gebildet.

Es ist vor diesem Hintergrund nicht überraschend, dass es keine internationalen Anstrengungen zu einem Verbot bewaffneter ferngesteuerter Drohnen gibt. Gleichwohl ist es bedauerlich, dass gerade die westlichen Vorreiter dieser Technologie auch keine Anstalten machen, sich für internationale Mindeststandards bei den Einsätzen starkzumachen. Die von Präsident Obama in den letzten Wochen seiner Amtszeit veröffentlichten Direktiven zum Einsatz von Kampfdrohnen (pdf) sollten möglicherweise den Nukleus einer, wenn auch sehr breit interpretierten, internationalen Einsatznorm darstellen. Allerdings sind diese (zu) späten Anstrengungen im Zuge der deutlich undifferenzierteren Einsatzpraktiken seines Nachfolgers schnell unter die Räder gekommen. Auch wenn es schmerzt, muss man der Realität hier ins Auge sehen: Die militärische Kampfdrohne wird nicht verschwinden und die Chancen auf eine Regulierung der Einsätze oder die Eindämmung ihrer Verbreitung wurden – vermutlich – verpasst.

Positiver sieht die Entwicklung hingegen bei den letalen autonomen Waffensystemen aus. Hier fasste die fünfte Überprüfungskonferenz der UN-Waffenkonvention (Convention on Certain Conventional Weapons, CCW) im Dezember 2016 nach drei inoffiziellen Treffen 2014, 2015 und 2016 den Beschluss, ab dem Sommer 2017 eine offizielle und zeitlich nicht begrenzte Group of Governmental Experts (GGE) einzusetzen. Ziel ist es, der CCW Vorschläge für den Umgang mit LAWS zu unterbreiten, die bis zu einem Verbot dieser Waffen reichen könnten. Ob die Vorschläge dann die Zustimmung der teilnehmenden Staaten erhalten, ist noch nicht klar. Denn obwohl noch kein Staat letale autonome Waffen besitzt und einsetzt, haben sich selbst kritische Staaten wie Deutschland bisher nicht eindeutig zu einem Verbot bekannt. Bislang wagt sich von den technologisch fortgeschrittenen Staaten keiner aus der Deckung. Entsprechend wäre eine koordinierte Positionierung mehrerer europäischer Staaten wünschenswert und sollte angestrebt werden.

Viel wird allerdings von zwei Faktoren abhängen: Erstens, ob es der Expertengruppe gelingt, eine Definition autonomer Waffensysteme zu entwickeln, der alle zentralen Akteure zustimmen können. Und zweitens, wie mit der Frage der Überprüfung der Einhaltung eines möglichen Verbots umgegangen wird. Das Herzstück eines autonomen Waffensystem ist nicht die Hard-, sondern die Software, die deutlich schwieriger zu inspizieren ist. Angesichts der Tatsache, dass sich bislang aber kein Staat mit Verve gegen ein Verbot engagiert, darf man verhalten optimistisch auf eine rüstungskontrollpolitische Beschränkung – vielleicht sogar ein Verbot – letaler autonomer Waffensysteme hoffen.

Über die Autoren:

Über die Autoren:

Dr. phil. Bernhard Koch ist stellvertretender Leiter am Institut für Theologie und Frieden, Hamburg, und Lehrbeauftragter an der Goethe-Universität Frankfurt am Main. Seine aktuellen Forschungsschwerpunkte sind Ethik und Gewalt, Ethik und der Einsatz autonomer Waffensysteme und rechtsethische Fragestellungen.

Dr. phil. Niklas Schörnig ist wissenschaftlicher Mitarbeiter am Leibniz-Institut Hessische Stiftung Friedens- und Konfliktforschung, Frankfurt. Seine aktuellen Themenschwerpunkte sind die Zukunft des Krieges, militärische Robotik, Rüstungskontrolle und australische Außen- und Sicherheitspolitik.

Dr. phil. Niklas Schörnig ist wissenschaftlicher Mitarbeiter am Leibniz-Institut Hessische Stiftung Friedens- und Konfliktforschung, Frankfurt. Seine aktuellen Themenschwerpunkte sind die Zukunft des Krieges, militärische Robotik, Rüstungskontrolle und australische Außen- und Sicherheitspolitik.

Alle Bilder im Beitrag sind bewaffnete und unbewaffnete unbemannte militärische Flugroboter der US-Navy, Official U.S. Navy Page unter Lizenz der US-Regierung.

Einfach eine Produkthaftung für die Steuerungen von autonomen Drohnen einführen, die ein „Kollateralschaden“ bzw. dessen Angehörige im Fehlerfalle einklagen dürfen.

Und deren Programmierer zu Kombattanten erklären.

Dann löst der Markt das Problem! :)

Ein hochbezahlter Prorammierer bei SAP in Walldorf weiß nicht unbedingt, zu welchem Zweck sein Softwaremodul wo zusammengesetzt wird. Er weiß bestenfalls, daß seine Firma zu 70 % für Überwachung und autonome Systeme arbeitet. Kein Mensch kann also Kombatanten und „Unschuldige“

unterscheiden. Und waum sollte SAP für ein Produkt von Rheinmetall-Diehl in Produkthaftung treten?

Software ist eine flüchtige Substanz.

Jeder Krieg(Kampf)seinsatz in einem fremden Land ohne UN Mandat ist ein Kriegsverbrechen.

So einfach ist das.

Ob man nun per Hand oder autonom tötet ist höchstens eine philosophische Frage. Und eine sehr zynische dazu.

Gratulation zum vollstaendigen Verfehlen des Artikelthemas.

Das, in deiner Wahrnehmung, welches gewesen wäre?

Autonome Waffensysteme, das duerfte nur schwer anders zu verstehen sein.