Sie sind wieder da: Die Hetze, die Gewalt, die Glorifizierung und Legitimierung von Rassismus und Intoleranz. Die massenhafte Radikalisierung spiegelt sich als #hatespeech im Netz, wo kommerzielle Plattformen beliebte Trends bekanntermaßen verstärken.

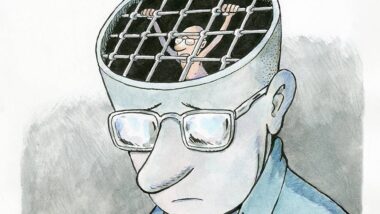

Auf den Kopf gefallen? #takedown #hatespeech #freespeech

Als Reaktion präsentierte Heiko Maas (BMVJ) im Januar diesen Jahres eine Kooperation zwischen den „Internetanbietern“ (!) Google, Facebook und Twitter sowie „zivilgesellschaftlicher“ (!) Organisationen: eco – Verband der Internetwirtschaft e.V., die Freiwillige Selbstkontrolle Multimedia-Diensteanbieter (FSM), jugendschutz.net, klicksafe.de, die Amadeu-Antonio-Stiftung und der Verein Gesicht zeigen! Ziel war es, Mechanismen zum Umgang mit rechtswidrigen Hassbotschaften zu entwickeln: Die Unternehmen sollen #hatespeech als Task Force nach Nutzer_Innenmeldung und Prüfung innerhalb von 24 Stunden löschen. Zusätzlich vereinbarte man einen verstärkten Informationsaustausch, regelmäßige Mitarbeiterschulungen, die gemeinsame Erarbeitung von Informationsmaterialien sowie die Bereitstellug von Anzeigevolumina für die „NGOs“ auf den Plattformen. Seit diesem Monat unterliegt die Umsetzung der Selbstregulierung auch einem Monitoring.

Eine gute Lösung? Nein.

Klingt schön einfach und effektiv, stellt aber nicht nur die weltweite Presse- und Meinungsfreiheit infrage: Wie bereits in der Zensursula-Debatte (2009), erscheint zunächst Skepsis angebracht hinsichtlich der Effektivität der Maßnahme – hier mit Blick auf Filter Bubbles, die #hatespeech oft nur seinen Sympathisant_Innen offenbaren, deren Meldung unwahrscheinlich ist (zu gezielten Attacken weiter unten). Die enorme Menge und Verbreitungsgeschwindigkeit von Inhalten stellen darüber hinaus die Effizienz des Ansatzes in Frage, wie international vergleichbare Projekte zeigen: In Australien beispielsweise kombinierte das Monitoringprojekt fightagainsthate.com des Online Hate Prevention Institutes nach Frustration mit klassischen Analyseinstrumenten ein Crowdsourcing der Meldungen von #hatespeech mit Formen der automatisierten Datenanalyse, kollektiven Intelligenz und menschlichen Expertise – und erhielt im Ergebnis nicht nur interessante Einsichten in die unterschiedlichen Funktionsweisen der Plattformen, sondern ein Realtime-Monitoring, so CEO Dr. Andre Oboler auf dem UN Symposium Tracking Hatred: An International Dialogue on HATE SPEECH in the Media (Dezember 2015). Das Beispiel zeigt in die Zukunft von Content Moderation.

Wiewohl sie auf den ersten Blick vermutlich humaner erscheint als das Outsourcing der Drecksarbeit in die Philippinen, ist auch diese Entwicklung nicht unkritisch: Wie die Verge in The Secret Rules of the Internet jüngst anschaulich illustrierte, muss die #hatespeech-Diskussion einerseits die fundamentalen Abweichungen von elementaren Anforderungen an verantwortungsvolle Content Moderation und Selbstregulierung berücksichtigen – beispielsweise Transparenz, Konsistenz, die Möglichkeit der Revision, andererseits die äußerst geringe Motivation der Plattformanbieter, die Verfahren zu ändern. Verbunden mit Technologien der automatisierten Daten – und Netzwerkanalyse sowie der kollektiven Intelligenz, stellten sich die Moderationspraktiken hierzulande mindestens als höchst undurchsichtig dar. Weltweit birgten sie ein enormes Mißbrauchspotential für weitere Zensurmaßnahmen und engten damit den in autoritären Regimen ohnehin äußerst engen und vor allem durch Social Media geschützten öffentlichen Diskursraum weiter ein.

#hatespeech im globalen Kontext

Was tun? Angesichts der traditionellen Alternativlosigkeit der deutschen Diskussion, die dem Löschen von Inhalten lediglich recht unkonkrete #counterspeech-Ansätze gegenüberstellt, konsultierte ich das Netz, weltweit, und fand ein paar bedenkenswerte Einsichten und Vorschläge, insbesondere im bereits erwähnten UN Symposium Tracking Hatred: An International Dialogue on HATE SPEECH in the Media (Dezember 2015) die ich hier exemplarisch vorstellen, diskutieren und zur Diskussion stellen möchte:

Dimensionen: #incitementspeech, #hatespeech , #offensivespeech/ #strategiclitigation

Zunächst einmal unterscheide man grundlegend #incitementspeech, #hatespeech und #offensivespeech voneinander, so Dr. Agnès Callmard (Columbia University Global Freedom of Expression, UN Symposium). Nicht aus Gründen der analytischen Spitzfindigkeit, sondern mit Blick auf Wirkung und Einschränkung: #incitementspeech als Aufforderung zu Gewalt, Terrorismus und Völkermord sei international beispielsweise auf Basis der UN Genocide Convention, der UN Convention on Racism sowie dem International Covenant on Civil and Political Rights (ICCPR) illegal (Factsheet Europa). #hatespeech, begriffen als Aufforderung zu Diskriminierung oder als Glorifizierung, Förderung oder Legitimierung von Rassismus und Terrorismus sei dagegen nicht international, aber zumeist national illegal (mit Ausnahme der USA, in Deutschland beispielsweise durch die Schranken zu Art. 5 GG sowie den Artikel der Volksverhetzung). #offensivespeech als Verbreitung und Propaganda von Fremdenfeindlichkeit und Stereotypen ist zumeist legal, eine häufige Ausnahme beträfe Blasphemie. Die rechtliche Einordnung eröffnet die Möglichkeit strategischer Gerichtsverfahren.

Varianz: #hatespeech, #netzwerkeffekte, #strategies, #context

Zudem schlug Callamard sinnvolle Differenzierungen von #hatespeech-Akten vor, beispielsweise nach Einfluss der Speaker_In, Zusammensetzung des Publikums, Intention, Inhalt, und Ziele des Sprechaktes, Zielgruppe/-objekt und Medium etc. Diese unterstützen die Analyse von #hatespeech als politische Strategie, beispielsweise zur Rekrutierung von Sympathisant_Innen oder zur Einschüchterung von Aktivist_Innen. Die Unterscheidungen implizieren einerseits die Sinnhaftigkeit von ebenso strategischen Reaktionen, die andererseits variierende Netzwerkeffekte der großen Plattformanbieter berücksichtigen muss: Aufrufe zu Gewalt verbreiteten sich besonders schnell über Twitter, die Holocaust-Leugnung sei besonders bei Facebook virulent, so Oboler über die australischen Einsichten ebenfalls auf dem UN Symposium.

Anhand der Einordnung der Entstehung, Verbreitung und Politisierung der umstrittenen Videos „The Innocence of Muslims“ (2012) pointierte Dr. Moustafa Bayoumi (Brooklyn College, Autor: „How Does It Feel To Be A Problem? Being Young and Arab in America?“, UN Symposium), dass nicht nur die Ursachen von #hatespeech in lokalen und globalen Konflikten liegen. Sondern, dass #hatespeech auch erst im Kontext dieser Konflikte Geltung erlangt, ein Fakt, der reale Verantwortlichkeiten von Führungspersönlichkeiten und Publikum hervorhebt.

#wastun? #targetingtheaudience, #protectingthevictims, #preventingviolence

Der Komplexität des Problems stehen zahlreiche Ansätze und Initiativen gegenüber, ein Versuch einer Ordnung:

#targetingtheaudience: Mit dem Ziel, #hatespeech seinen fruchtbaren Boden beim Publikum zu entziehen bzw. seine Wirkung auf reale Gewaltausbrüche so reduzieren, initiierten Minderheiten in Wien und Südkalifornien beispielsweise Nachbarschaftskontakte, die von enger Kooperation mit lokalen Mainstreammedien, massiver Advocacy/ Sensibilisierung und Preisverleihungen begleitet waren. Den in der UN Diskussion als erfolgreich eingeschätzten Projekten stehen in diesem Kontext umstrittene #shaming-Ansätze aus Brasilien gegenüber: Hier soll #hatespeech auf Plakate ausgedruckt und in der Nähe der Wohnorte der Speaker_Innen verteilt werden. Als kritisch werden dabei Datenschutzbedenken und Wirkung eingeschätzt.

Auf Plattformen übertragen, bietet der #targetingtheaudience-Ansatz beispielsweise die Möglichkeiten, Nutzer wie bei Advertisement auf besonders dubiose Quellen oder Alternativangebote aufmerksam zu machen oder dem Konsum rassistischer Angebote gezielte Alternativinformationen voran zu stellen, wie das Projekt Search Racism. Find Truth eindrücklich belegt.

#protectingthevictims/ #counterspeech: #hatespeech wirkt traumatisch. Um die toxische Wirkung auf Betroffene und Aktivist_Innen zu lindern und einzugrenzen, empfehlen sich #counterspeech, #campaigns, #awareness und #medialiterary, allerdings unter Bedingungen und in Grenzen, so scheint mir: Ihre Effektivität erforderte wohl zunächst ein adäquates Capacity Building für die engagierte Zivilgesellschaft, nicht nur hinsichtlich von Training und Awareness, sondern im Zweifelsfall auch mit Blick auf Sicherheitsvorkehrungen für Aktivist_innen, wie Sicherheitsprobleme bei der Ausrichtung des Online Harassment Summit (SXSW Festival) jüngst zeigten.

Mit Blick auf eine strategische #counterspeech-Ausrichtung, eine zielgerichtete Reaktion auf Anführer_Innen, Angreifer_Innen und Angriffe mittels sozialer Netzwerke, stellt sich die Frage nach einer Nutzung aktueller Daten- und Netzwerkanalysetools: Dürfen die Methoden der kommerziellen Plattformen, der Onlineüberwachung und der Wählermanipulation auch zur zivilgesellschaftlichen De-Radikalisierung eingesetzt werden? Und wenn ja, unter welchen (technologischen) Bedingungen? Hier liefert der Online Harassment Research Guide ebenso wertvolle Diskussionbeiträge wie das Coral Projekt, einer Kooperation zwischen Mozilla, der New York Times und der Washington Post zur Entwicklung und Erprobung besserer Community-Technologien.

Abschließend sei im Kontext von #counterspeech die Frage gestellt, ob es Sinn macht, die Konflikte online über den Schutz von Betroffenen hinaus zu verstärken: Erfahrungen im Kontext des Arabischen Frühlings deuten letztlich nur auf Konflikt-Eskalation und die Zerstörung verbliebener öffentlicher Diskursräume. Mit Blick auf die aktuelle Hartz4-Reform lassen sich womöglich konstruktivere #counterstrategies ausmachen.

#preventingviolence: Monitoringprojekte werden aktuell vielfältig propagiert und ins Leben gerufen, bspw. in Deutschland (Meldung und #takedown) und in Australien (Meldung, Prüfung, #takedown). Außerhalb des Selbstregulierungsmonitoring und auf Basis transparenter Verfahren und offener Technologien könnten solche Projekte einerseits wertvolle Einsichten zu Keyplayern, Inhalten und Adressaten von #hatespeech geben, andererseits vor allem die Wirkungsweise von #hatespeech untersuchen: Es gelte letztlich zu verhindern, dass #hatespeech in Gewalt resultiert, bspw. im Falle von Wahlen! Mit diesem Ziel entwickelte iHuB in Kenia Tools mit Vorbildwirkung.

Countering #hatespeech in Deutschland: #dagehtnochwas

Die Übersicht zeigt: Entgegen der scheinbaren Alternativlosigkeit zu Löschforderungen an kommerzielle Plattformanbieter zeigen sich international vielfältige soziale und technische Ansätze, dem komplexen Problem von #hatespeech zu begegnen. Herausgefordert sind #nerds und #alliens gleichmaßen, zur Debatte stehen mal wieder (und deshalb nicht weniger) Frieden und Freiheit:

„Slavery, the Gulag, the Holocaust (…) Ruanda (…) required a complete monopoly over the media, over expression, a complete monopoly over, in fact, consciousness, at times through the church. So I’m asking you (…) Where are the greatest dangers to our common values? (…) What are the sources of the greatest risks to our common humanity in contexts where governments are using state of emergencies to curtail dissent, are using counter-terrorism to put in prison people who are at the frontline of combatting terrorism and calling for tolerance? (…) I want you (…) to think (…) seriously about the response we are gonna bring to hate speech, and whom are we gonna target, and whom are we gonna try to bring back to the respect for human rights!“ (Dr. Agnes Callamard, UN Symposium Tracking Hatred).

Gute Fragen! Kommerzielle Medienmonopole sind nicht minder gefährlich als staatliche Medienmonopole. Ausgestattet mit Exekutivfunktionen, einer intransparenten und mißbrauchbaren Zensurinfrastruktur und -hoheit, stellen Social Media Plattformen ein globales Risiko dar. Deshalb braucht es auch im Kampf gegen #hatespeech einen Wettbewerb um sozio-technische Alternativen, eine Sicherung pluraler Medien, Presse- und Meinungsfreiheit und (!) Netzneutralität!

Nun, ich bin kein Social-Media-Fachmensch, sondern diesbezüglich wohl eher ein normaler Nutzer. Für mich ist dieser Text daher praktisch unleserlich, weil derart mit mir nicht geläufigen Fachtermini gespickt, dass ich jeden Satz dreimal lesen muss, bevor ich ihn verstehe.

Mein Wunsch: Berherzigt doch bitte eine der Grundregeln des Journalismus und verwendet eine Sprache, die eure Zielgruppe auch versteht. Oder richtet ihr euch neuerdings nur nach an Nerds?

> Berherzigt doch bitte eine der Grundregeln des Journalismus und verwendet eine Sprache, die eure Zielgruppe auch versteht.

Bitte nicht! Wem die eigene Bildung für netzpolitik.org nicht ausreicht, hat unzählige Möglichkeiten sich diese an geeigneten Orten anzueignen. Wer wissenschaftliche Texte lesen will, der darf nicht erwarten, dass er alles beim ersten Lesen begreift.

Zu obigem Text jedoch kann man Kritik anbringen, dass die Lesbarkeit durch eine Unzahl von #-Zeichen erschwert ist, dadurch leidet auch die Text-Verständlichkeit.

Der Autor ist es dem Leser schon schuldig, zu erklären warum der Text nicht ohne Vorangestelltes #-Zeichen auskommen kann, denn man kann die Fachbegriffe durchaus ohne dieses Zeichen verwenden. Wurde etwa nicht korrekt zitiert?

Danke für die Rückmeldungen! Ich empfehle die Konsultation der Originalquelle: http://www.unaoc.org/what-we-do/projects/hate-speech/ bzw. http://www.unaoc.org/2015/12/hate-speech-part-1/ (Aufzeichnung).

In der Tat die Mehrfachverwendung von Rauten im Fließtext ist erstaunlich störend. Ähnlich das Auslassen von Leerzeichen.

Transparenz nicht gewährleisten bei Löschungen,

Meinungsfreiheit beschränken,

Finde ich gut

Wozu braucht man schon Wissen und Aufklärung,

Gegenfrage: Wie erklärt man einem #platzhalter, dass er #platzhalter ist?

#platzhalter=beliebiges Adjektiv, welches nicht selbst reflektierend über sich denken kann

zum Beispiel Rassist,Fundamentalist,Dummen,Abhängigen etc…

Geht nur durch (positive) eigene Erfahrung bzw Mathe/Logik oder habt ihr ne Idee?

Leider ist beides meist bei den meisten Menschen stark beschränkt durch ihr Weltbild