Künstliche Intelligenz kann Gesichter, Objekte und Schriftzeichen trotz Verpixelung und Weichzeichnung erkennen. Schon lange werden Bilddaten nicht mehr nur von menschlichen Augen verarbeitet. Eine Studie der Universität Cornell zeigt, dass künstliche neuronale Netzwerke auf Bildern mehr erkennen können als Menschen.

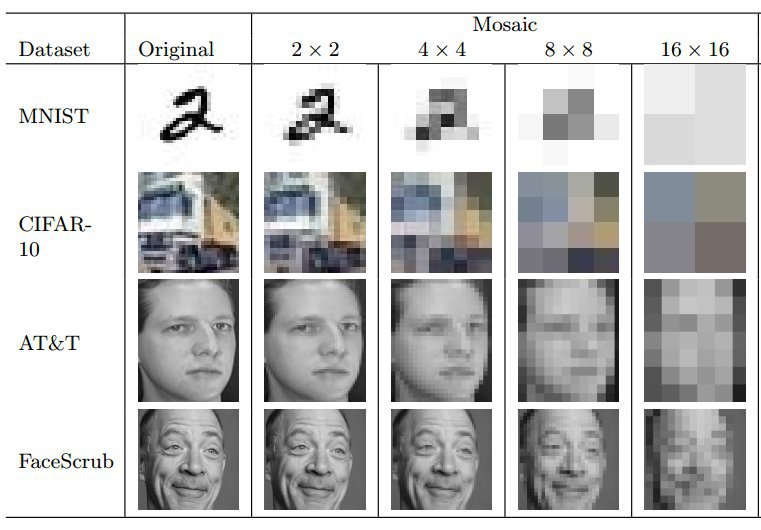

Wissenschaftler untersuchten verschiedene Verpixelungsmethoden – Verpixelung, Weichzeichnung und die P3-Methode – und testeten diese an unterschiedlichen Datenbanken.

Wie funktionieren Weichzeichnen und Verpixelung?

Wird ein Teil eines Bildes verpixelt, wird der Bildausschnitt in kleine Quadrate unterteilt. Die Durchschnittsfarbe der jeweiligen Quadrate wird ermittelt und die Quadrate eingefärbt.

Weichzeichnung wird verwendet, um Teile eines Bildes oder Text mithilfe eines Filters zu trüben und somit unkenntlich zu machen.

Die Privacy Preserving Photo Sharing Methode (P3) teilt jedes Bild in ein öffentliches und ein geheimes Bild. Das öffentliche Bild enthält keine sensiblen Informationen mehr und kann zum Beispiel auf Social-Media-Plattformen hochgeladen werden. Das geheime Bild, welches die sensiblen Informationen enhält, wird verschlüsselt und z. B. auf den Server eines Online-Speicherplatzanbieters hochgeladen. Besitzt man beide Bildteile, kann man diese einfach zum Original zusammensetzen. Über einen Grenzwert kann der Nutzer selbst bestimmen, welche Menge an Informationen aus dem Originalbild entfernt wird.

Auch die automatische Weichzeichnungsmethode von Youtube wurde getestet. Das Unternehmen bietet seit 2012 die Möglichkeit, automatisch alle Gesichter in einem Video unkenntlich zu machen. Damit sollte die Privatsphäre für Videos verbessert werden um beispielsweise Material von Protesten und Demonstrationen veröffentlichen zu können, ohne die Identität der Aktivisten preiszugeben.

Im alltäglichen Gebrauch, zur Unkenntlichmachung von sensiblen Daten auf Bildern und in Videos, erfüllen diese Methoden sicherlich ihren Zweck. Wenn überhaupt sind noch Umrisse eines Nummernschildes oder Gesichtes zu sehen. Das Lesen des Kennzeichens oder die Identifizierung einer Person sind unmöglich, zumindest ohne maschinelle Hilfe.

Für ihre Studie nutzen die Wissenschaftler vier verschiedene Datenbanken:

- MINST eine Sammelung handgeschriebener Zahlen,

- CIFAR-10 eine Sammlung verschiedener Tiere und Fahrzeuge,

- AT&T eine Sammlung von Gesichtern,

- FaceScrub eine Sammelung von Gesichtern von Prominenten

aus: https://arxiv.org/abs/1609.00408

Diese unbearbeiteten Bilder ließen sie künstliche neuronale Netzwerke lernen. Danach wendeten sie die genannten Methoden an, um Informationen aus den Bildern zu entfernen. Dann wurden die bearbeiteten Bilder in die künstlichen neuronalen Nezwerke eingespeist und mit den Originalbildern abgeglichen.

Maschinen sehen, was den Augen verborgen bleibt

Im Fall von Youtubes Weichzeichnungsmethode erkannte das künstliche neuronale Netzwerk die Identität der gezeigten Personen mit 57 Prozent Wahrscheinlichkeit richtig. Auch Verpixelung und P3 schnitten beim Verschleiern von Bildern eher schlecht ab. Bilder, die mit der P3-Methode unkenntlich gemacht worden waren wurden mit bis zu 95 Prozent Wahrscheinlichkeit richtig erkannt und verpixelte Bilder aus der AT&T-Datenbank sogar mit 98 Prozent Wahrscheinlichkeit.

Anhand der Erfolgsquoten bei der richtigen Zuordnung durch die Netzwerke wird deutlich, dass die jetzigen Methoden nicht ausreichen, um sensible Informationen auch für künstliche Intelligenz unsichtbar zu machen. Jedoch muss die künstliche Intelligenz immer noch das Originalbild kennen, ein „Zurückrechnen“ der Verpixelung ist nicht möglich.

Ein simples Google Image Search hat meine vage Ahnung bestätigt, wen das Bild zeigt. Auch ohne den tollen Entpixel-Algorithmus ;)

Was vermutlich daran liegt, dass verpixelte Bilder einfach nur runterskalierte Versionen des Originals sind.

Ein verpixeltes Bild wird beim Vergleich mit dem Originalbild sicher gut erkannt. Auch Menschen sind da nicht schlecht darin. Die Frage ist aber eher, wird die Person auch dann auf dem verpixelten Bild erkannt, wenn das System nicht das unverpixelte Originalfoto sondern nur andere Fotos des Menschen kennt?

Ja, das neuronale Netz lernt entsprechend, es ist da letztlich frei in seiner Entwicklung.

Menschen erkennen Gesichter ueber einen evolutionaer angelegten Algorithmus. Der ist ziemlich gut und robust, aber natuerlich nicht auf die in der Natur nicht vorkommende Verpixelung ausgelegt.

Die Frage ist wohl eher: Wann wird jemand (mit drei Buchstaben) eine Software geschrieben (gehabt haben) die genug Originalbilder einsammeln kann damit das Neuronale Netz nichts weiter tun muss als „Memory spielen“. Sprich: Wenn das neuronale Netz nur genug Bilddaten hat, dann findet es irgendwann auch das passende Originalbild. Voila, Enttarnt per Software.

Was spricht eigentlich gegen den früher benutzten Schwarzen Balken/Kasten?

Ich glaube es ist die allseits geläufige „Weichspüler“ Methodik, das man alle Dinge die den Menschen ungemach bereiten so Soft macht das sie irgendwann keiner mehr bemerkt.

Einfacher gesagt: Es ist wie mit dem Frosch auf der Herdplatte. Nur das es hier um Menschen (als Menge) geht.

Das Grinsen und die Brille … das genügt schon, da weiß man wen man vor sich hat!

eine Misere!

Die AT&T-Datenbank enthält die Gesichter von 40 Personen, facescrub auch nur 530 Personen. Diese jeweils sehr geringe Zahl sollte man im Text erwähnen, wenn man es mit der „gefährlich“ hohen Erkennungsquote tut.

Nur eine Vermutung, aber ich denke es sollte so sein: Automatische Anonymisierungstools sind sehr wahrscheinlich unsicherer als manuelle „Verpixelung“. Während die Automatismen immer dasselbe tun und sich somit auch immer gleich gut „wiederherstellen“ lassen, dürfte eine manuelle Anonymisierung mit handgeführtem „Stift“ individuellere Ergebnisse liefern.

Wenn Du manuell anonymisieren willst, dann ueberschreibe die betreffende Region mit vom Original voellig unabhaengigen Werten. Das kann schwarz, gelb-gruen kariert oder Dein verpixelter Wellensittich sein, Hauptsache die Originaldaten sind weg.

Wer wirkungsvoll automatisiert anonymisieren wollte, sollte natuerlich das gleiche tun.

Und ja, die klassischen schwarzen Balken tun das, wenn sie gross genug sind und alles abdecken. Denn wie gesagt: das neuronale Netz ist nicht auf menschlische Erkennungsansaetze angewiesen. Fuer uns sind Augen und ihre Position sehr wichtig, mit Kinnen oder Kopfformen koennen wir nicht so viel anfangen. Maschinen werten alles aus.

Generell Proportionen und Koerperhaltung waere uebrigens auch so eine Sache, in einem Video natuerlich auch Bewegungsmuster.

Erinnere mich an den Fall eines gesuchten Verbrechers, der schon gut acht Jahre zurückliegt. Dieser hatte sein Gesicht auf Bildern durch einen Wirbeleffekt unkenntlich gemacht. Interpol hat den Filter dann einigermaßen gut rückgängig machen und ihn darüber identifizieren können.

P.S.: Bitte noch den kleinen Tippfehler korrigieren:

„Maschinen sehen, was den Augen _verbrogen_ bleibt „

Der Wirbeleffekt war nichtmal grossartig verlustbehaftet, also netterweise schoen bloed[tm].

Ihr habt -wieso auch immer- die Lösung des Problems vergessen:

Legt einen schwarzen Balken über das Gesicht oder nehmt irgendein völlig fremdes bzw. bekanntes Gesicht wie das des schönen Thomas de M., verpixelt es, vorher evntl. noch verzerren und/oder morphen, und ersetzt damit das Gesicht des unkenntlich zu machenden.

Fertig.

Einfach das Bild aus 2m Abstand betrachten

Den Vogel auf dem Bild erkenne ich auch so. Aber meine Erkenntnis könnte die Bevölkerung verunsichern. ;-)

Man übersieht auch immer den, der die Bilder aufnimmt. der hat die unverpixelten Daten. Die Spione sind meistens staatlich und an die geben alle Firmen alles raus, was die wollen. Wird noch schlimmer mit den Drohnen zukünftig. Das ist eine Mail an Hermes Versand dazu, nachdem sie angekündigt haben, Zustellroboter, mit Kameras natürlich, zu testen.

(Bitte um Weiteleitung an Unternehmensleitung und Zuständige für Zustellrobotertest): Wie ist, natürlich weiß ich, dass garnicht, sichergestellt, dass die Zustellroboter nicht für Spionage verwendet werden? Sie müssen Kameras haben, Adressen und Namen. Gesichtserkennung dazu und es ist ein perfektes Überwachungsgerät. Und wir alle wissen, dass Firmen mit Überwachungsstaaen zusammenarbeiten. Roboter sind bei Menschen beliebt, das wird funktionieren, aber nur solange bis einer merkt, und veröffentlicht, dass sie als weitere Überwachungsgeräte missbraucht werden können (oder sollen? wir können ja nicht shene ob oder ob nicht, also müssen wir in Überwachungsstaaten davon ausgehen).

Solange wir in Überwachungsstaaten leben, würde ich nichts bei einem Kurierdienst verschicken oder bestellen, der mit Robotern zustellt und ihn sofort verklagen, wenn ich einen seinen Robotern sehe, er also auch mich sehen und aufnehmen könnte (Recht auf informationelle Selbstbestimmung lt. Art. 2 Abs. 1 GG in Verb. mit Art. 1 Abs. 1 GG, § 4 BDSG, Art. 8 Abs. 1 EMRK). Man muss beachten, dass sich das auf jeden Passanten und auch sonst alle ausdehnt, die im Erfassungsbereich der Roboter-Kamera sind.