Maschinelles Lernen, Big Data und Zukunftsprognosen auf Basis von Algorithmen beeinflussen zunehmend unser Leben. Die bestehenden Regelungen zu Datenschutz und Privatsphäre können diesen Phänomenen nicht mehr adäquat begegnen. Vergangene re:publica thematisierte Kate Crawford diese Entwicklungen und zeigte auf, warum wir dringend neue Regelungen zur Datenethik brauchen.

Die Australierin ist Expertin in den Bereichen der Datenanalyse, Social Media und digitaler Kommunikation. Als leitende Wissenschaftlerin am Microsoft Research Institute forscht sie zu den Themen gesellschaftlicher Wandel und Medientechnologien. Im Mittelpunkt steht dabei die Schnittstelle zwischen Mensch, mobilen Geräten und sozialen Netzwerken.

Im „Surveillance Capitalism“ produzieren Algorithmen oft Ungleichheit

Ihren Vortrag beginnt sie mit dem Vorwurf, die aktuelle Diskussion um Ethik bezüglich künstlicher Intelligenzen drehe sich vor allem um die befürchtete Singularität. Darunter versteht man den Zeitpunkt, an dem die maschinelle Intelligenz die menschliche übertrifft und sich eigenständig reproduziert. Dabei sind Singularität und Superintelligenz allerdings nur reine Theorie – und viele Experten sind der Meinung, sie würde niemals eintreten. Geblendet von dieser möglichen Bedrohung versage die Menschheit darin, die aktuelle Technologie ausreichend kritisch zu reflektieren, so Crawford.

In den momentanen Systemen zur Datenanalyse herrsche oft Ungleichheit, die zur Ausbeutung und Entmachtung von Menschen führe und oft diskriminierende Züge annehme. Crawford fordert deswegen einen sozialen und ethischen Rahmen, innerhalb dessen Maschinen, künstliche Intelligenzen und Algorithmen programmiert werden sollen.

Die Intelligenz der lernenden Systeme basiert hauptsächlich auf dem massenhaften Sammeln von Daten. Das Datensammeln ist einerseits Basis des Profit-Modells der Analysesysteme und andererseits ein kontinuierliches „Training“, um die Funktionalität der künstlichen Intelligenzen zu verbessern. Die Produktion von Risiken für bestimmte Individuen oder Gruppen findet bei der Programmierung selten Beachtung.

„We are all data subjects, but the effects are uneven“

Viele Arten autonomer Software diskriminieren, was die Frage aufwirft, auf welchen menschlichen Werten und Weltanschauungen sie basieren. Um die Diskriminierung entlang verschiedener Kategorien wie Geschlecht, Herkunft und Rasse zu verdeutlichen, führt Crawford einige Beispiele an.

IBM ist eines der weltweit führenden Unternehmen in der Datenverarbeitung. Um in den globalen Flüchtlingsströme mögliche Dschihadisten zu identifizieren, entwickelte das Unternehmen die Software i2 EIA, welche „echte“ Flüchtlinge von „unechten“ unterscheiden sollte. Auf Grundlage öffentlich verfügbarer Daten wie Twitter-Likes, aber auch registrierter Grenzübergänge und vielem mehr wurde für jeden erfassten Flüchtenden ein „Terrorist Credit Score“ errechnet. Selbstverständlich erfolgte das zweifelhafte Projekt ohne das Wissen der zahlreichen Betroffenen. Schließlich nutzte IBM ausschließlich öffentliche Daten, strukturierte diese und bewegte sich so innerhalb des aktuellen Rechtsrahmens zum Datenschutz.

IBM representatives pointed out that the i2 EIA doesn’t collect intelligence; it just helps ingest and make sense of unstructured data. They aren’t spies or agents or operatives, just engineers.

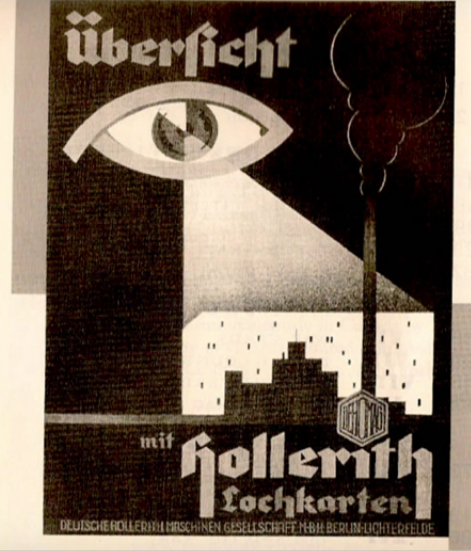

Die Folgen einer solchen Strukturierung von öffentlich verfügbaren Daten könnten durchaus weitreichend sein. Sie können verhindern, dass Menschen eine staatliche Grenze passieren dürfen oder einen bestimmten Job bekommen. IBM hat durchaus Erfahrung mit der Diskriminierung von Minoritäten. Während des dritten Reichs kooperierte das Unternehmen mit der Spitze der NS-Führung und half durch ein Lochkartensystem , Juden und andere Minderheiten zu identifizieren.

Ein weiteres Beispiel für Diskriminierung durch künstliche Intelligenz ist Googles Bilderkennung. Dunkelhäutige Menschen identifizierte es häufig als Gorillas. Grund dafür sind die Trainingsdaten, auf denen das Programm basiert. Anscheinend wurden überproportional viele Bilder mit hellhäutigen Gesichtern in das System eingespeist, sodass Dunkelhäutige oft nicht erkannt wurden.

Ähnlich diskriminierend ist das System von Amazon, welches US-Wohnviertel mit überwiegend schwarzer Bevölkerung schlechter beliefert als weiße Nachbarschaften.

Auch auf Grundlage des Geschlechts können Algorithmen diskriminieren. Ein Projekt untersuchte mit Fake-Accounts die Job-Angebote, die Männern und Frauen von Google präsentiert wurden. Das Ergebnis zeigte, dass Männern auffällig oft Jobs mit Gehältern von 200.000 Dollar jährlich und mehr angezeigt wurden, während Frauen meist schlechtere Jobs angeboten wurden. Ergo gelangen die „guten“ Jobangebote seltener an Frauen und entsprechende Werber fokussieren sich zukünftig eher auf Männer als Zielgruppe. Dadurch entsteht ein Teufelskreis, der dazu beiträgt, die bestehenden Verhältnisse zu reproduzieren.

Regelungen zu Datenschutz und Transparenz müssen durch Datenethik ergänzt werden

Viele Formen der Diskriminierung, die wir in unserer Gesellschaft größtenteils überwunden geglaubt haben, leben in der Infrastruktur der algorithmischen Systeme weiter. Da die momentanen Rechtsrahmen bezüglich Datenschutz und Transparenz diesem Probelm nicht Herr werden können, fordert Crawford eine neue Datenethik. Außerdem will sie eine klare Informationslage über das Funktionieren der Systeme.

Doch selbst die Entwickler von Algorithmen haben oftmals Schwierigkeiten, ihr Funktionieren zu erklären, so die Wissenschaftlerin. Lernende System zu verstehen sei sehr schwer, die Untersuchung meist nur durch Momentaufnahmen möglich. Diese sagten allerdings wenig über die inhärente Dynamik und den ständigen Wandel der Datensysteme aus.

Im Laufe der Geschichte brauchte es immer eine Krise, die die vorherrschende gesellschaftliche Norm erschütterte, um neue ethische Standards zu etablieren. Crawford sieht die Menschheit momentan am Zeitpunkt dieser Krise, da die neuen Möglichkeiten lernender Maschinen die alten Verordnungen und Normen von Datenschutz und Transparenz sprengen. Die gesellschaftliche Reflexion hinkt wie so oft dem technischen Fortschritt hinterher.

Hoffnung macht Crawford die Zivilgesellschaft. Nur durch ein kontinuierliches Fordern nach ethisch korrekten Standards und dem Ablehnen von Systemen, die auf Vorurteilen basieren oder diskriminierende Elemente beinhalten, könne ein entsprechender Wandel herbeigeführt werden.

Weiter Informationen und der Audio-Mitschnitt des Vortrags finden sich hier.

Während des dritten Reichs kooperierte [IBM] mit der Spitze der NS-Führung und half durch ein Lochkartensystem, Juden und andere Minderheiten zu identifizieren.

Und deshalb darf IBM also nie mehr Daten analysieren? Was ist denn das für eine Totschlag-Argumentation? Das gibt nicht nur einen, sondern mindestens 5 Godwin-Punkte.

Es ist erstmal eine geschichtliche Tatsache und keine Totschlag-Argumentation. Die kam eher mit Dir, zu unterstellen, dass IBM deshalb keine Daten mehr analysieren dürfe. Wir empfehlen immer: Erstmal mit dem Video beschäftigen, dann kommentieren. Gerne mit Verstand.