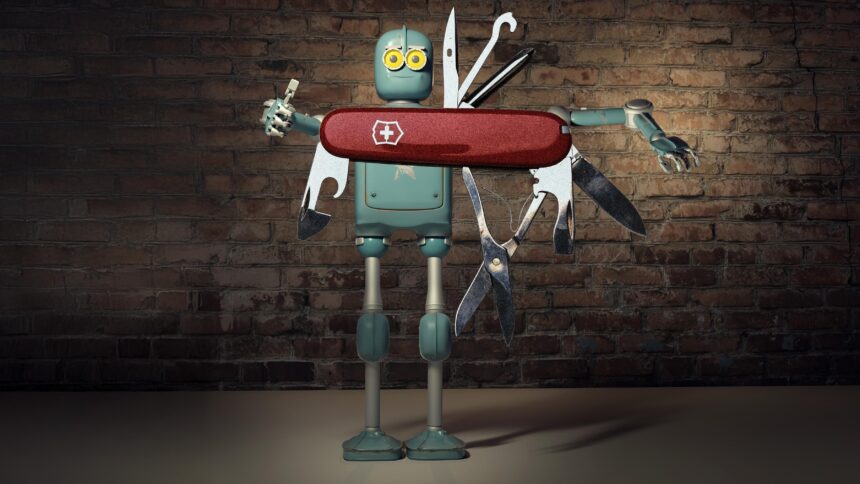

Big-Tech-Hersteller bekannter KI-Produkte vermarkten Werkzeuge wie Gemini, DeepSeek, ChatGPT und Co. als Alltagstechnologie. Private Nutzer*innen sollen sie überall und für alle möglichen Zwecke einsetzen können, als Web-Suchmaschine, als Korrekturleserin, als Autorin oder Lern-Assistenz. Ein solches Marketing definiert Menschen als defizitäre Lebewesen, die sich stets optimieren müssen.

Wir haben uns mit Maren Behrensen darüber unterhalten, wie die Werbestrategie der KI-Giganten versucht, unser Menschenbild zu prägen. Behrensen sagt: Wir müssen dem nicht auf den Leim gehen, sondern können als kritisch denkende Personen einen selbstbestimmten, kreativen Umgang mit der Technologie finden. Behrensen lehrt Philosophie an der niederländischen Universität Twente in Enschede und forscht zur technologischen Vermittlung sozialer Realitäten sowie zu Identitätskategorien, Antigenderismus und Populismus.

KI für alle Zwecke

netzpolitik.org: KI ist überall. Was für einen Nutzen verspricht uns die KI-Industrie?

Maren Behrensen: Sie verspricht, dass KI uns im Alltag hilft, uns produktiver macht und wir effizienter arbeiten – oder sie uns sogar heilen kann.

Ein Beispiel sind Therapie-Bots. Die werden auf teils skrupellose Weise vermarktet und geben vor, eine Therapie ersetzen zu können. Realistisch betrachtet sind die meisten dieser Bots nicht nur nutzlos, sondern teils brandgefährlich.

KI soll auch unsere Arbeitswelt revolutionieren, wissenschaftliches Arbeiten unterstützen, menschliche Kommunikation optimieren. Dabei machen sich die Hersteller kaum die Mühe zu zeigen, wie genau sie diese Versprechen einlösen wollen.

Unausweichliche KI

netzpolitik.org: Was hat dieses Marketing für Folgen?

Maren Behrensen: Diese Versprechen rufen eine gesellschaftliche Erwartungshaltung hervor. Das wiederum baut sozialen Druck auf, KI-Produkte zu nutzen und zu kaufen. Denn man will ja nichts versäumen. Dabei geht der Blick dafür verloren, welchen Zweck die Technologie eigentlich erfüllen soll.

Diese Unausweichlichkeitslogik, nach der es alle irgendwie nutzen und sich damit auseinandersetzen müssen, erweitert die Nutzerbasis.

Ein gutes Beispiel sind Universitäten: Dort heißt es, wir könnten gar nicht darum herumkommen, KI in die Lehre oder Forschung zu integrieren. Also werden Taskforces eingerichtet, Fortbildungen angekündigt, Lehrpläne angepasst – obwohl noch gar nicht klar ist, wo und wie genau KI einen echten Nutzen bringt. Das ist weniger eine sachliche Entscheidung als eine durch Marketing erzeugte Dynamik.

netzpolitik.org: Es ist interessant, dass Unternehmer wie OpenAI-Chef Sam Altman es geschafft haben, dass alle über ihr Produkt sprechen, und davon ausgehen, dass Menschen es wie selbstverständlich nutzen. Wissen KI-Unternehmer, wofür Universitäten oder Privatpersonen ihr Produkt einsetzen sollten?

KI für ganz spezifische Zwecke

Maren Behrensen: Ich glaube, das wissen sie häufig nicht. Es gibt natürlich Bereiche, in denen KI einen klaren Nutzen hat – aber das sind meist sehr eng umrissene Felder. Ein Beispiel ist die Astrophysik: Dort gibt es gewaltige Datenmengen – zum Beispiel Millionen Aufnahmen von anderen Galaxien –, die von Menschen unmöglich alle gesichtet werden können. KI kann Muster darin erkennen und Vergleichsarbeit leisten, die Forschung in diesem Umfang überhaupt erst möglich macht.

Ein anderes Beispiel ist die Proteinforschung in der Biologie. KI kann dort Simulationen durchführen, Vorschläge machen und so Prozesse beschleunigen, die sonst Jahre dauern würden. Das ersetzt nicht die Arbeit im Labor, aber es eröffnet neue Kapazitäten.

Muster in großen Datenmengen zu erkennen, das ist ein Anwendungsbereich, in dem KIs dem Menschen klar überlegen sind und für den sie projektspezifisch trainiert werden. Diese Nutzung unterscheidet sich allerdings sehr deutlich davon, wie KI für Privatnutzer vermarktet wird, nämlich als Alltagstechnologie oder Allzwecklösung.

Menschen mit Optimierungsbedarf

netzpolitik.org: Welche Rolle spielt das Nützlichkeitsprinzip in der Vermarktung von KI?

Maren Behrensen: Das Nützlichkeitsprinzip steht im Zentrum der meisten Vermarktungsstrategien. Ein Beispiel ist die Grammarly-Werbung. Sie verspricht: „Wir schreiben dir deine Hausarbeit“ oder „Wir machen deine E-Mails verständlich“. Die Unterstellung ist hier: Der Mensch an sich kann wenig und dann kommt die KI, die aus dem unfähigen Menschen ein optimiertes Wesen macht.

In dieser Logik wird der Mensch wie eine kleine Maschine gesehen, die sich ständig selbst verbessern soll. Sein Wert bemisst sich daran, wie nützlich, effizient oder produktiv er ist.

Alles netzpolitisch Relevante

Drei Mal pro Woche als Newsletter in deiner Inbox.

Das zeigt sich auch besonders bei Tools wie Kalender- oder Gesundheits-Apps, wo es heißt: „Mit KI bringst du endlich Ordnung in dein Leben.“

netzpolitik.org: Was genau ist daran problematisch?

Die Mensch-Maschine

Maren Behrensen: Das ist ein sehr reduziertes Menschenbild. Es blendet vieles aus, was menschliches Leben eigentlich ausmacht – Beziehungen, Kreativität, auch einfach das Recht, einmal nicht effizient zu sein.

Das KI-Marketing versteht Menschen als Maschinen unter anderen Maschinen.

netzpolitik.org: Menschen als Maschinen zu verstehen – gibt es dafür Vorläufer in der Philosophiegeschichte?

Maren Behrensen: Es erinnert an René Descartes, ein französischer Philosoph der frühen Neuzeit, wobei er nicht den Menschen, sondern lediglich Tiere als Maschinen betrachtet hat. Daneben gibt es materialistische Philosophien. Sie brechen den Menschen auf seine Existenz als Körper herunter, der bestimmte Dinge braucht: Nahrungsmittel, Schlaf und so weiter. In der Regel versuchen sie, auch das Gefühlsleben des Menschen – oder das, was man vielleicht theologisch verbrämt Seelenleben nennen würde – auf rein materielle Fragen zu reduzieren.

Dem etwas überspitzten Ausdruck Mensch-Maschine-Denken kommt aber wohl der Behaviorismus in der Psychologie am nächsten. Da gibt es auch unterschiedliche Denkschulen, aber der Grundgedanke ist: Menschliches Verhalten ist auf Input und Output ausgerichtet. Menschliches Verhalten wird durch äußere Reize bestimmt. Die Idee dahinter ist, dass man Menschen quasi programmieren kann, wenn man die richtigen Inputs kennt. Dieses Denken wurde unter anderem auf Kindererziehung angewendet.

Nützlichkeitsprinzip auf die Spitze getrieben

netzpolitik.org: Eine Facette des Nützlichkeitsprinzips im KI-Marketing sind Philosophien, denen bekannte KI-Player anhängen, ein Beispiel ist der Longtermismus. Er steht in der Tradition des Utilitarismus, einer Art Nützlichkeitsethik. Was besagt er?

Maren Behrensen: Der Longtermismus argumentiert in etwa so: Menschliches Leben oder auch positive Erfahrungen, die Menschen im Laufe eines Lebens machen können, haben einen bestimmten intrinsischen Wert. Daher steigert sich dieser Wert umso mehr, je mehr Menschen es gibt.

Hinzu kommt die Vorstellung, dass wir es durch eine technologisch vermittelte Zukunft schaffen, uns über die Galaxie auszubreiten. Damit würden irgendwann die natürlichen Grenzen dafür wegfallen, wie viele menschliche Leben zeitgleich existieren können. Im Moment müssen wir davon ausgehen, dass es eine solche Grenze auf der Erde gibt, dass also nicht beliebig viele Menschen auf der Erde leben können.

Daneben müssen wir dafür sorgen, dass nicht irgendein katastrophales Ereignis uns alle gleichzeitig auslöscht.

netzpolitik.org: Menschliches Leben in der Zukunft schützen zu wollen, klingt doch eigentlich ganz gut.

Maren Behrensen: Mein größtes Problem mit der Argumentation des Longtermismus ist, dass es menschliche Bedürfnisse hier und jetzt vollkommen vernachlässigt, auf eine meines Erachtens völlig fahrlässige Weise. Longtermisten formulieren Zukunftsversprechen, von denen völlig unklar ist, ob sie jemals so eintreten.

Moralische Katastrophen kann der Longtermismus nicht einordnen. Ein Genozid oder eine schwere Epidemie, die viele Menschen tötet, wäre im Longtermismus nicht weiter erwähnenswert, solange die Menschheit als solche weiter besteht. Er abstrahiert völlig von den Bedürfnissen und der Not der jetzt lebenden Menschen.

netzpolitik.org: Wie kommen Menschen als Maschinenwesen ins Spiel?

Maren Behrensen: Manche Longtermisten träumen davon, dass wir irgendwann gar nicht mehr als körperliche Wesen existieren, sondern einfach als virtuelle Wesen in einer Cloud. Wenn es so käme, dann würden damit viele Bedürfnisse wegfallen, die Menschen als körperliche Wesen haben. Schlaf oder Essen wären wahrscheinlich obsolet.

netzpolitik.org: Ist das für uns als Nutzer*innen der Technologie ein Problem, dass viele KI-Hersteller uns als potenzielle Maschinenwesen verstehen?

Wir sind communityfinanziert

Unterstütze auch Du unsere Arbeit mit einer Spende.

Maren Behrensen: Zum einen zeigt sich in der longtermistischen Ideologie ein entwürdigender, oft rassistischer, sexistischer und ableistischer Blick auf Menschen. Wenn Menschen, die einer solchen Ideologie anhängen, uns nicht nur ihre Produkte verkaufen, sondern ihren Reichtum auch dazu nutzen, direkten politischen Einfluss auszuüben, wie das etwa Peter Thiel und Elon Musk in der USA tun – dann droht gleichzeitig ein faschistoider Umbau der politischen Verhältnisse.

Die Angst des Philosophen

netzpolitik.org: Wie wirkt sich das aus, wenn Nutzer*innen dem Marketing von der KI als Alleskönner auf den Leim gehen?

Maren Behrensen: Es schürt falsche Erwartungen. Menschen missverstehen ChatGPT zum Beispiel als ein Programm, das direkt Informationen liefern kann. Das ist eine falsche Annahme.

Wenn man das Missverständnis von KI als Suchmaschine ins Gesellschaftliche weiterdenkt, dann landet man bei dem, was man als die Angst des Philosophen beschreiben könnte: Menschen lassen ChatGPT für sich denken. Aber ChatGPT macht kritisches Denken nicht automatisch obsolet.

Das Ganze erinnert an das Taschenrechner-Problem: Als der Taschenrechner in die Klassenzimmer kam, gab es auch diese Sorge, dass man den jungen Menschen Mathematik nicht mehr vermitteln kann. Doch einen Taschenrechner kann ich erst dann sinnvoll und effizient nutzen, wenn ich schon Ahnung von Mathe habe, und wenn ich weiß, welche Probleme ich mit ihm lösen soll. ChatGPT und andere KI-Tools kann ich auch dann gewinnbringender nutzen, wenn ich eine klare Vorstellung davon habe, was ich erfragen oder erreichen will.

netzpolitik.org: Das heißt, die Sorge ist unbegründet?

Maren Behrensen: Ich halte die Sorge für übertrieben. Sie sagt mehr über die Menschen aus, die KI als alternativlose Allzwecklösung anpreisen und gleichzeitig von einem radikalen Umbau der Gesellschaft fantasieren. Faschisten käme es sehr gelegen, wenn KI das kritische Denken ersetzen würde – aber das heißt nicht, dass jegliche Nutzung von KI einer Aufgabe des Denkens gleichkommt.

Nutzer*innen widersetzen sich Marketing

Umso interessanter ist es, dass viele Menschen KI-Systeme auf eine Weise nutzen, die sich dem Nützlichkeitsprinzip widersetzt. Ich denke hier insbesondere an eine Form der Nutzung, die KI als eine Art Dialogpartnerin begreift – als interaktives Tagebuch oder Hilfe beim Sortieren von Gedanken oder Routinen.

Natürlich kann auch das gefährlich sein: wenn jemand sich durch den Umgang mit KI weiter in Wahnvorstellungen hineinsteigert. Aber wenn Menschen KIs als Dialogpartnerin behandeln, wählen sie eine andere Herangehensweise als die der reinen Selbstoptimierung durch den Umgang mit einem Werkzeug.

Und das finde ich spannend: Was kann eigentlich menschliche Kreativität aus und mit diesem Ding machen? Das meine ich wertneutral, aber es zeigt meines Erachtens, dass Menschen einen kreativen Zugang zu KI haben, der über die Marketingnarrative „kann alles“, „weiß alles“, „ist eh unausweichlich“ oder „kann alles besser als du“ hinausgeht.

Wenn nur noch der Chatbot zuhört

netzpolitik.org: Was sind die Risiken, wenn Menschen KI-Tools unreflektiert nutzen?

Maren Behrensen: Wenn sie beispielsweise ChatGPT als Gesprächspartner*innen und als echte Person wahrnehmen oder den Output des Programms unhinterfragt glauben, birgt das die Gefahr, Illusionen zu verstärken. Es zeigt aber auch: Es gibt viele Menschen, die sich sonst nicht gehört fühlen – und die dieses Zuhören nun in der Maschine finden.

Das kann wie gesagt gefährlich sein: In den USA beginnt gerade ein Rechtsstreit gegen OpenAI, in dem es darum gehen wird, ob ChatGPT einen jungen Menschen in den Suizid getrieben hat.

Chatbots imitieren Sprachhandeln

netzpolitik.org: Wie kommt es zu dieser Dynamik?

Maren Behrensen: Chatbots sind nicht auf Wahrheitssuche ausgelegt, sondern darauf, menschliches Sprachhandeln zu imitieren. Das hat oft wenig damit zu tun, Argumente oder Evidenz auszutauschen und kritisch zu hinterfragen. Vielmehr geht es darum, einen Konsens herzustellen, einen gemeinsamen Entschluss zu fassen oder gemeinsame Glaubenssätze zu formulieren.

Je besser Chatbots darin werden, menschliches Sprachhandeln zu imitieren, desto größer wird auch die Gefahr, dass sie als Autorität wahrgenommen werden. Und Autoritäten können toxisch sein, sie können ihre Macht ausnutzen. Dabei unterstelle ich natürlich nicht, dass KI eine Intelligenz wäre, die dies bewusst tut. Aber wie bei toxischen menschlichen Autoritäten gilt: Es liegt an uns, ob wir ihnen diese Macht über uns geben oder nicht.

KI-Programme haben ja keinen Personenstatus, geschweige denn Bewusstsein. Sie fungieren häufig wie Echokammern, ähnlich Social Media, aber eben nicht nur.

Zu „gibt es dafür Vorläufer in der Philosophiegeschichte?“

Weizenbaum: „Die Frage „Ist das Gehirn lediglich eine Maschine aus Fleisch?“ ist typisch für die Art von Fragen, die aus einer technologischen Mentalität formuliert und tatsächlich nur in ihr formulierbar sind. Sobald sie als rechtmäßig zugelassen ist, beginnen Streitgespräche, was ein Computer „im Prinzip“ kann oder nicht kann, und diese Streitgespräche werden dann selbst rechtmäßig. Aber die Zulässigkeit der technologischen Frage braucht nicht von vornherein anerkannt zu werden. Statt dessen kann eine menschliche Frage gestellt werden.“

Anmerkung: Weizenbaum wusste mit Sicherheit sehr genau, was Computer können und wo die Grenzen der Berechenbarkeit liegen. Gerade deshalb (IMHO) diese Aussage.

Weizenbaum stellt weiter fest (mit „sie“ sind Programmierer, Softwarefirmen gemeint): „Aber sie arbeiten in einer gewöhnlich als Performanz-Modus bezeichneten Arbeitsweise. Darin zählt nicht die Ausarbeitung einer Theorie, sondern die Leistung von Systemen.“

Es geht also nicht darum, etwas „gutes“ oder „brauchbares“, gar wissenschaftliches zu schaffen. Es geht um Erfolg, Geld und Reputation. Dazu ist jeder „Schein“ und aus meiner Sicht jede Verzerrung der Wirklichkeit und jede Manipulation recht.

Zu glauben AI wäre ein Klon der von F. Nietzsche eingeführte Chimäre des Übermenschen ist m.E. schon verwegen genug, zumal bereits die Nationalsozialisten versuchten ihn zu persiflieren. Doch zu hoffen, dass man durch Mittelung einer AI mehr als besseren Durchschnitt abbilden könnte, ist als ob man ernsthaft glauben würde, eine Drehorgel könne eine/n Musiker/in ersetzen.

In einigen Firmen wurden 20% der Programmierer durch KI ersetzt. Die wurden damals schon nach Indiej ge-outsourced insb. im SAP-Umfeld mit ABAP.

KI wird besser werden und dagegen nur zu schimpfen und es als lächerlich hinzustellen hilft keinem.

Dass Firmen sich dazu entscheiden, Programmierer durch KI zu ersetzen, heißt natürlich nicht notwendigerweise, dass die KI so gut ist (im Sinn von „kann den Job eines Programmierers hinreichend erfüllen“). Es ist erstmal einfach eine Business-Entscheidung.

Exakt.

Und KI wird nicht besser. Bei diesen Sachen derzeit kaum ein Stück.

D.h. es wird drum herum gebaut, special casing etc. Das System wird jew. etwas besser, ist aber gegebenenfalls längst an der Wand angekommen. Nicht die KI!

Als nächstes hat einer was anderes erforscht und das wird dann gebaut und so viel besser – versprochen! Ach nee, meinte vielleicht, vielleicht, vielleicht…

Will sagen, die SICH verbessernden Systeme sucht man mit einer Lupe. DICH verbessernde Systeme sind wohl nicht mal geplant, trotz aller Beteuerungen im PR-Zirkus. Was ist ein Katalysator wert, wenn man ihn nicht reproduzieren kann? Richtig, es kann nur Religion daraus werden! Gar nicht so abfällig gemeint, wie es vielleicht klingt.

>“Ein anderes Beispiel ist die Proteinforschung in der Biologie. KI kann dort Simulationen durchführen, Vorschläge machen“

Dies stimmt so nicht.

Es ist nicht die „KI“ die von sich aus, auf Ergebnisse kommt. Es wurde zuvor eine Aufgabe einprogrammiert oder gefordert, um ein Ziel zu erreichen unter Berücksichtigung von Faktoren und Ideen, so wie jedes andere Programm. Also muss es nicht eine so genannte „KI“ sein, aber „KI“ klingt halt besser und mit dem Hype kann man mehr Geld abkassieren.

>“ und so Prozesse beschleunigen, die sonst Jahre dauern würden.“

Dies stimmt so nicht.

Eine Frage von Rechenleistung „Cluster“, die in anderen Bereichen auch zum Ziel führen würde, ohne ein „KI“ Label dran.

Ohne den Menschen seiner Ideen, ist die sogenannte „KI“ eine volle Niete! Und hier freuen sich die „KI“ Unternehmen, es gibt reichlich zahlende Menschen, die die Programmierung dann auch noch erweitern.

Das möchte ich unterstützen.

KI ist kein Zauberstab. Jetzt sollten alle mal ein paar Minuten in ne Tüte atmen und wieder auf den Teppich kommen.

KI folgt einem ganz simplen Mechanismus. Ja, die Ergebnisse sind überraschend und beeindruckend. Nein, sie bricht damit nicht aus dem simplen Mechanismus aus.

Wenn die beeindruckenden Ergebnisse eines beweisen, dann wie wenig Menschen das Konzept „Information“ verstehen.

Also, was ist dieser simple Mechanismus? KI ist ein Suchverfahren, Punkt. Nicht mehr, nicht weniger. Im Gegensatz zu vielen bekannten und diskutierten Verfahren ist es ein statistisches Verfahren, welches zu dem noch auf einer statistischen Datenbasis arbeitet. Das heißt, weder die Ergebnisse sind definitiv (nur wahrscheinlich), noch sind in der Datengrundlage Fakten gespeichert (nur Auftrittswahrscheinlichkeiten von abstrakten Aspekten).

Diese Randbedingungen machen das Verfahren erstmal in allen Belangen schlechter(!) als herkömmliche Verfahren. Warum will man sowas also überhaupt haben? Antwort: Weil man KI parallelisieren kann, klassische Suchverfahren jedoch nicht. Das hat folgende Konsequenz, die bis heute alle beeindruckt und immer wieder überrascht, weil das nicht absehbar war: Wenn ich die Datenbasis extrem übersteigert groß mache und extrem viele verschiedene Aspekte in mein Suchkriterium aufnehme (und noch andere clevere Tricks anwende, die meine eigentliche KI auszeichnen), dann kann ich die Erfolgswahrscheinlichkeit, das richtige Ergebnis bei meiner Suche zu finden, extrem in die Höhe drücken. Das Erzeugt den überraschenden Effekt, dass die KI scheinbar auf jede Frage eine sinnvolle Antwort weiß und das in kürzester Zeit.

Unser Planet soll schöner werden. Doch die „KI“ hinterlässt uns zum Leben bald nur Asche!

Es gibt Menschen die jede 30 Sekunden aufs Smartphone schauen, obwohl sie kein Beep gehörthaben, schauen sie nocheinmal. Die Angst etwas zu verpassen… Es könnte ja… So sind die Menschen grad im Hype der „KI“ gefesselt, wir könnten ja was verpassen. US Zolldruck und die Vereinbarung mehr Import zu leisten auch in digitaler Form. Jetzt wird man von allen seiten mit der „KI nutzen muss“ auch von Gerätehersteller genötigt.

Wenn ein Produkt aus Kostengründen nicht unterhaltsam ist, muss man Subventionen finden um Grundunterhalt und die Weiterentwicklung voran zu treiben. Also mache man es den Menschen und den Firmen mit irre Werbung schmackhaft… Teils mit Lügen wie (nutzt es Kostenlos!), dabei zahlen alle unbewusst mit deren Daten und treiben dabei die Entwicklung unbewusst auch weiter. Man tritt auch die Grundsätze und AGB mit Füßen, um das Ziel zu erreichen. Siehe Lageentwicklung von Open AI und 5GHz usw. usw.

5G ≠ 5GHz, sollte das unklar sein.

5G (Mobilfunk) arbeitet heutzutage auf denselben Funkbändern wie 4G.

Modernes WiFi hingegen arbeitet oft auf 5GHz und auch mit viel höherer lokaler Leistung als Mobilfunk.

Das nur mal so zur Klarstellung, Auch wenn der OP mit dem Artikel nicht viel zu tun hat.

Eine KI wird nicht programmiert sondern dressiert ! Soll heissen : Wir nehmen ein hinreichend komplexes System und lassen es Input verarbeiten – dann belohnen und bestrafen wir das System so lange, bis wir mit dem Output zufrieden sind. Nur weil ein Elefantenführer in Indien einen Elefanten dazu gebracht hat einen schweren Baumstamm zu bewegen, glauben wir noch lange nicht an die baldige Weltherrschaft der Elefanten, und das Elefanten stärker sind als wir, dass wussten wir vorher. Analog werden Computer Zeichen immer schneller verarbeiten können als wir, weshalb man sie auch als „Hochgeschwindigkeitstrottel“ bezeichnet. Das Problem sind die Dompteure, die gewollt oder ungewollt ihre persönlichen Vorstellungen und Vorurteile in die Dressur einfliessen lassen – uns aber glauben lassen, die Antwort der KI sei ultimativ richtig. Dagegen hilft nur eine Diversität der KI – also so ziemlich das Gegenteil von dem was gerade weltweit abläuft.