Twitter ist nun also auch dabei. Wie das Unternehmen nun bekanntgegeben hat, wird es bald Microsofts PhotoDNA System benutzen, um Bilder in Tweets auf Kindermissbrauchs-Dokumentation zu untersuchen. Neben Twitter benutzen auch Facebook, die Dänische und die Neuseeländische Polizei und natürlich Microsofts Bing, Skydrive und Hotmail Dienste das System. Was wird da gemacht?

Hany Farid, Professor am Dartmouth College und Entwickler von PhotoDNA, startete 2008 die Entwicklung mit der Idee, dass man sich darauf konzentrieren sollte, bereits bekannte Bilder von Kindermissbrauchs-Dokumentation wiederzuerkennen.

“My idea was, don’t try to go after things you haven’t seen before — go after the things you have seen before,” Farid said. “Go after the images that you know are child porn, that you know are horrible, that you know who the victims are and that you know people keep trafficking.”

![]()

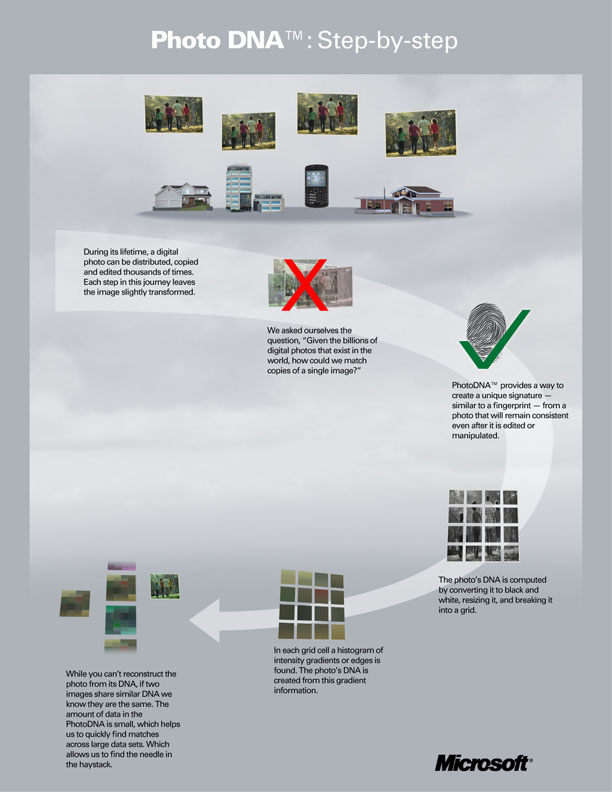

Um ein Bild wiederzuerkennen erstellt PhotoDNA einen ‚digitalen Fingerabdruck‘ des Photos. Hierzu wird das Bild in ein 12×12 Raster aufgeteilt und in Graustufen umgerechnet. Dann wird für jede Zelle der Hash (Prüfsumme) errechnet. Durch dieses ‚Robust Hashing‘ kann PhotoDNA auch Bilder wiederkennen, selbst wenn diese skaliert oder anderweitig bearbeitet wurden. Von jedem Bild was zu Twitter hochgeladen oder verlinkt wird, wird auch selbiger Hash erstellt und gegen eine Hash-Datenbank abgegleicht. Hat das hochgeladene Bild denselben Hash, wie eines aus der Datenbank ist die Wahrscheinlichkeit sehr hoch, dass es sich um Kindermissbrauchs-Dokumentation handelt. Nach eigenen Aussagen ist die Chance auf einen False Positive (das System sagt, es ist Kindermissbrauchs-Dokumentation, obwohl es gar keine ist) 1/Milliarde. Außerdem erkenne es ein Bild zu 98%, wenn es in der Datenbank ist. Microsoft hat PhotoDNA dann vor einigen Jahren dem National Center for Missing & Exploited Children (NCMEC) gespendet. Seitdem kooperieren rund 13 Unternehmen freiwillig mit NCMECs Datenbank um die Verbreitung von Kindermissbrauchs-Dokumentation zu verhindern.

Um ein Bild wiederzuerkennen erstellt PhotoDNA einen ‚digitalen Fingerabdruck‘ des Photos. Hierzu wird das Bild in ein 12×12 Raster aufgeteilt und in Graustufen umgerechnet. Dann wird für jede Zelle der Hash (Prüfsumme) errechnet. Durch dieses ‚Robust Hashing‘ kann PhotoDNA auch Bilder wiederkennen, selbst wenn diese skaliert oder anderweitig bearbeitet wurden. Von jedem Bild was zu Twitter hochgeladen oder verlinkt wird, wird auch selbiger Hash erstellt und gegen eine Hash-Datenbank abgegleicht. Hat das hochgeladene Bild denselben Hash, wie eines aus der Datenbank ist die Wahrscheinlichkeit sehr hoch, dass es sich um Kindermissbrauchs-Dokumentation handelt. Nach eigenen Aussagen ist die Chance auf einen False Positive (das System sagt, es ist Kindermissbrauchs-Dokumentation, obwohl es gar keine ist) 1/Milliarde. Außerdem erkenne es ein Bild zu 98%, wenn es in der Datenbank ist. Microsoft hat PhotoDNA dann vor einigen Jahren dem National Center for Missing & Exploited Children (NCMEC) gespendet. Seitdem kooperieren rund 13 Unternehmen freiwillig mit NCMECs Datenbank um die Verbreitung von Kindermissbrauchs-Dokumentation zu verhindern.

Google hat ein ähnliches System, den ‚Bedspread Detector‘ (Tagesdecken Aufspürer). Der Name spielt darauf an, dass eine NCMEC-Mitarbeiterin zwei Kindesmissbrauchs-Fälle auf denselben Täter zurückführen konnte, da auf verschiedensten Bildern immer dieselbe Tagesdecke zu sehen war. So ist Googles Ansatz auch, nach markanten Mustern und anderen Besonderheiten (Tattoos, Räumlichkeiten, etc.) zu suchen, um dasselbe Opfer oder denselben Täter in verschiedenen Bildern wiederzuerkennen.

Von der Idee her klingen beide Systeme zunächst sehr sinnvoll und unterstützenswert im Kampf gegen Kindesmissbrauchs-Dokumentation online. Vor allem, wenn man zum einen bedenkt, dass die ‚manuelle‘ Analyse der Bilddaten schier unmöglich ist und emotional sehr strapaziös für die Beamten sein kann.

[NCMEC] found 17.3m images of abuse in 2011 – and since 2002 has reviewed more than 65m images and videos of child sexual exploitation reported by the authorities.

Und zum anderen, dass ‚Notice and Takedown‘ – also das Benachrichtigen des Administrators oder Providers, dass auf einem bestimmten Server Bilder und Videos von Kindesmissbrauch liegt – alleine nicht mehr ausreicht, da nach kurzer Zeit die Inhalte einfach an einem neuen Standort hochgeladen werden.

A senior FBI agent described notice and take down as „wackamole“. A notice is issued, the hosting company removes the image then, sometimes within minutes, the same picture will pop up somewhere else. And so on ad infinitum.

Wenn man sich dazu vergegenwärtigt, dass NCMEC schon 2009 jede Woche 250.000 Bilder potentiellen Kindesmissbrauchs beurteilen musste, ist es verständlich, dass Ernie Allen (Präsident und CEO von NCMEC) diese graphischen Analyse-Systeme als wichtiges Mittel im Kampf gegen die Verbreitung von Kindermissbrauchs-Dokumentation sieht.

While there won’t be miraculous changes overnight, the bottom line is, because of these tools, we’re making headway.

Klingt gut, oder? Fast. Wodurch sich diese Systeme noch auszeichnen, ist die Tatsache, dass sie so wenig wie möglich über die internen Mechanismen preisgeben – aus Angst, dass Pädophile versuchen die Schwachstellen in den Algorithmen auszunutzen. So warnt European Digital Rights (EDRI) davor diese stark eingreifende Technik unkritische als ‚Best Practice‘ zu übernehmen. Es gibt keine unabhängigen Analysen zur Effizienz dieser Systeme. Außerdem wurde bisher nicht untersucht, ob es nicht auch negative Auswirkungen geben könnte.

What happens when somebody tries to do this? [kinderpornographische Bilder hochladen] Nobody knows. What happens if a criminal tries to upload innocent parts of images as a way of filtering his/her own collection of illegal images to identify images unknown to the police? We don’t know. How big is the risk that this could lead to incentives to creating new illegal images and new abuse? We don’t know.

Diese Bedenken sind mehr als berechtigt, bei einem System bzw. einer Technik, die bei immer mehr Diensten und Ländern zum Einsatz kommt. Es ist verständlich, dass für die schiere Masse an Bilddaten heutzutage automatisierte Systeme zum Einsatz kommen müssen. Außerdem scheint der Ansatz, nach bekannten Bildern von Kindesmissbrauch zu suchen, sinnvoll, da so – im besten Falle – aktuelle Fälle schneller erkannt werden. Gleichzeitig muss man kritisch bleiben und Nachfragen dürfen nicht unterbunden werden, nur weil es „um unsere Kinder geht“. Bei Filtersystemen besteht immer die Gefahr, dass – einmal etabliert – der Fokus ausgeweitet wird und nicht mehr nur Kindermissbrauchs-Dokumentation blockiert wird. Gerade deswegen sollte es eine neutrale Instanz geben, die diese Systeme evaluiert, denn bisher handelt es sich lediglich um ‚Best Practice‘ von Microsoft, Google und Co. Außerdem muss unterschieden werden, ob so ein System bei einem Dienst, wie Twitter oder Facebook eingesetzt wird, oder gar auf ISP-Ebene, wo es wesentlich eingreifender wäre.

Microsofts PhotoDNA und Googles Bedspread Detector sind gute und sinnvolle Systeme, die ein wichtiges Problem versuchen zu lösen. Nun sollte es aber auch darum gehen, diese Systeme nicht ‚im Dunkeln‘ einzusetzen, sondern Effizienz, mögliche nachteilige Auswirkungen und sinnvolle Implementationen kritisch zu hinterfragen. Und wie EDRI verdeutlicht, sind uns NCMEC, Microsoft und Google vielleicht noch ein paar Antworten schuldig – es geht schließlich um unsere Kinder.

Seid ihr etwa gegen das Bekämpfen von Kindermissbrauch!

DENKT DOCH AUCH MAL AN DIE KINDER!

Mich freut es natürlich wenn der Schund weg kommt… aber wie üblich wird das Programm selber missbräuchlich eingsetzt werden und „normale“ Pornographie löschen lassen…

Und wieder unbeantwortet bleibt die Frage nach der Definition „Kind“. Könnten die Autoren das nachholen?

Das verlinkte Interview mit Hany Farid, dem Entwickler/Erfinder von PhotoDNA beantwortet deine Frage:

„The photos that PhotoDNA identify are “the worst of the worst,” Allen said. These “crime scene photos,” are of prepubescent children under the age of 12 being violently sexually abused, according to Allen.“ (Ernie Allen, Chief Executive Officer von NCMEC)

http://thedartmouth.com/2011/05/24/news/farid

Die Problematik, die du ansprichst, ist dadurch natürlich nicht gelöst. Unterschiedliche Länder haben unterschiedliche Gesetzgebung bzgl. „Kindesmissbrauch“ und der Altersgrenze. NCMEC hat hier sicherlich versucht eine ‚untere Schranke‘ zu finden.

Hätten Regierungen wirklich ein Interesse daran, Kinderpornographie zu unterbinden, würden Sie eine MD5, SHA1 oder sonstwas DBn anbieten, die sich dann z.B. Forennutzer runterladen und mit Dateien abgleichen könnten.

Ähnlich einer Virusdatenbank.

Dies wäre schon seit Jahren möglich und daran sieht man, wie ernst es den Politikern wirklich ist.

Eine reine Scheindiskussion zur emotionalen Aufwirbelung, um Menschen die Tyrannei angenehm erscheinen zu lassen. Mehr nicht.

Dieser Ansatz wäre aber auch nicht ohne Risiko. Wie willst du verhindern, dass diese Hash-DBs dann als ‚Benchmark‘ genommen werden, um Bild/Videosammlungen so abzuändern, dass das Bild noch „brauchbar“ ist, sich aber der Hash verändert und somit kein Matching mit der DB mehr möglich ist!?

Man wird nie eine technische Lösung für ein gesellschaftliches Problem finden…

Du sagst es ja.

Und genau darin besteht das Problem eben auch dieser „DNA“.

Aber da MD5 etc.pp. heute als Standard im Bereich der Datenverifikation genutzt werden, wäre dies eben ein Anfang.

Mir geht es lediglich darum, darzustellen warum es sich um Scheinargumente und Scheindiskussionen handelt.

Und das Abändern von Bildern um 1 Pixel umd einen neune MD5 zu generieren besteht ja auch heute schon. Von Kollissionssicherheit ganz zu schweigen….

Nur als Anmerkung: PhotoDNA benutzt ‚Robust Hashing‘ – Bilder werden erkannt, auch wenn sie skaliert, beschnitten oder anderweitig (in gewissen Grenzen) bearbeitet wurden.

Übliche Hashing-Verfahren sind für diesen Zweck eben nicht geeignet, da sie auch bei der kleinsten Abweichung einen anderen Hash liefern. Jede noch so geringe Änderung eines Bildes macht die Datenbank damit wertlos. Genau deshalb ist das verwendete Verfahren ja deutlich aufwendiger.

Und der Einwand von Jan-Peter Kleinhans ist natürlich ebenfalls wichtig – wäre so eine DB öffentlich dann wäre das ein willkommenes Werkzeug, um Bildmaterial so lange zu bearbeiten, bis es nicht mehr erkannt wird. Daher macht eine gewisse Geheimhaltung hier durchaus Sinn.

Der Tenor des Autors ist, dass alle Zweifel daran ausgeräumt sind, dass die Wahrnehmung von dokumentiertem Kindesmissbrauch Menschen zu Kindsvergewaltigern macht, die Opfer ein weiteres Mal geschädigt werden und kein einziger Rezipient gewillt ist, solche Bilder zu melden, um ihren Takedown zu veranlassen. Wo kann ich die entsprechenden Studien nachlesen?

Tut mir Leid, das ist nicht der Tenor des Autors – falls Sie damit mich meinen. Wie kommen Sie darauf? Ein paar Aussagen aus dem Text und den verlinkten Artikeln:

– Notice and Takedown alleine reicht nicht aus.

– Masse an Bildern zu groß, als dass man sie manuell auswerten könnte.

– Hash-basiertes Identifizieren von Kindesmissbrauchs Dokumentation keine ‚Wunderwaffe‘, sondern eine von vielen Maßnahmen

– Unkritisches Implementieren von PhotoDNA u.ä. nicht der richtige Weg, Notwendigkeit für Verifizierung und Evaluation durch unabhängige Instanz.

Das ist der Tenor des Autors.

Die Technik wird gelobt, einzig deren Überwachung müsse sichergestellt sein. Wohin das führen kann, haben wir bereits mit von der Leyen und Guttenberg erfahren müssen. Dass die ganzen Prämissen falsch sein könnten und diese Technik damit überflüssig sein könnte, wird mit keinem Wort besprochen. Oder übersehe ich da was?

Ich verstehe ihre Bedenken, gleichzeitig sollte man aber nicht das Kind mit dem Bade ausschütten. Die NCMEC besteht schon seit 1984 und PhotoDNA ist nur ein Teilbereich ihrer Tätigkeit. Wie gesagt, sie sehen es selbst nicht als Wunderwaffe, sondern als weiteres, nötiges Mittel. Dass es nicht überflüssig ist, kann man anhand der Tatsache herleiten, dass NCMEC mit Service-Providern zusammenarbeitet und 2012 113.000 Hinweise von Providern bzgl. Kindesmissbrauchs-Dokumentation auf deren Servern erhalten hat. (http://arstechnica.com/information-technology/2013/03/how-verizon-found-a-child-pornographer-in-its-cloud/)

Es wäre schöner, wenn es auf diesem Gebiet mehr Transparenz und mehr unabhängige Untersuchungen bzgl. Wirkzusammenhängen gebe. Keine Frage. Gleichzeitig fände ich es überstürzt die gesamte Maßnahme zu verteufeln. Diese Balance versucht der Artikel zu verdeutlichen.

Was geschieht im Falle eines Alarms?

Wird nur das Bild gelöscht?

Werden die Behörden, wenn ja, welche, benachrichtigt?

Eine solche Software ist sicher sinnvoll, aber nicht in den Händen von Unternehmen, sondern bei den Strafverfolgungsbehörden. Wer kontrolliert die NCMEC Datenbank, wer die Software?

Genau das sind die Fragen von EDRI, die wir auch gerne beantwortet hätten.