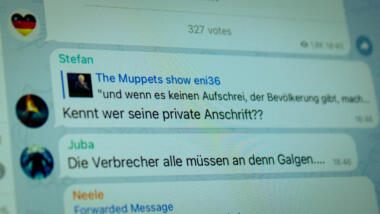

Ein rassistischer Kommentar über einen Politiker, ein Aufruf zur Maskenverweigerung, ein Lied über einen Rundfunk-Kommentator, der darin als „Nazi-Sau“ bezeichnet wird. Mit diesen und 20 weiteren rechtlichen Grenzfällen hat sich in den vergangenen zwölf Monaten die Freiwillige Selbstkontrolle Multimedia-Diensteanbieter e. V. (FSM) befasst, das geht aus dem Jahresbericht des Vereins hervor.

Ist dieser Inhalt rechtswidrig? Soziale Netzwerke hatten in den 23 Fällen die Entscheidung über diese Frage an die FSM weitergegeben. Diese Möglichkeit sieht das Netzwerkdurchsetzungsgesetz (NetzDG) für rechtlich schwierige Fälle vor. Seit März 2020 prüft ein Expert:innengremium der FSM als unabhängige Instanz solche Inhalte – allerdings nur, wenn die jeweiligen Unternehmen die Entscheidung über die Rechtswidrigkeit eines Beitrags von sich aus abgeben.

Beleidigung als häufigste Straftat

Von den 23 Beschwerden, mit denen sich das Gremium im vergangenen Jahr beschäftigte, wurden acht als rechtswidrig und damit löschungspflichtig bewertet. Der Straftatbestand, der dabei am häufigsten erfüllt wurde, war in vier Fällen die Beleidigung nach § 185 des Strafgesetzbuches (StGB). In zwei Fällen kam das Gremium zu dem Schluss, dass es sich um öffentliche Aufforderungen zu Straftaten (§ 111 StGB) handelte.

Zwei weitere Beiträge fielen unter die Straftatbestände „Verletzung des höchstpersönlichen Lebensbereichs“ (§ 201a StGB) und „Verwenden von Kennzeichen verfassungswidriger Organisationen“(§ 86, 86a StGB). Besonders auffällig sei gewesen, wie häufig die gemeldeten Beiträge inhaltlich im Zusammenhang mit der Pandemie standen, heißt es in der Pressemitteilung der FSM.

Das NetzDG schreibt vor, dass Plattformen wie Facebook, Twitter oder YouTube rechtswidrige Inhalte, die ihnen gemeldet werden, innerhalb von 24 Stunden löschen müssen. Handelt es sich um „nicht offensichtlich“ rechtswidrige Inhalte, haben die Unternehmen sieben Tage Zeit, diese zu prüfen. Eine weitere Option ist die Weiterleitung solcher Grenzfälle an eine vom Justizministerium dafür zugelassene externe Prüfstelle. Eine solche Zulassung hat bisher nur die FSM. Wird eine Entscheidung an die Stelle weitergegeben, so muss der Sieben-Tage-Zeitraum nicht mehr eingehalten werden. Die Entscheidung der FSM ist für die Unternehmen dann allerdings bindend.

Einzige unabhängige und zugelassene Prüfinstanz

Ein wesentlicher Kritikpunkt am NetzDG ist, dass es die Entscheidung darüber, was gelöscht wird, an die Plattformen überträgt und damit die Gefahr besteht, dass mehr gelöscht wird als notwendig wäre. Die FSM als unabhängige Instanz für schwere Entscheidungen hält oftmals als Gegenargument her. Doch wenn die FSM in zwölf Monaten nur 23 Fälle prüfen musste, heißt das auch: Die Plattformen entscheiden offenbar in der Praxis fast immer selbst. Als Grund für die geringe Zahl der behandelten Fälle führte die FSM die neue Etablierung des Prozesses und die Corona-Pandemie an.

Die FSM ist ursprünglich als Selbstkontrolleinrichtung im Bereich Jugendmedienschutz gestartet. Das Expert:innengremium der FSM, das für die NetzDG-Fälle zuständig ist, setzt sich aus 46 Jurist:innen zusammen, die nach dem Umlaufverfahren in dreiköpfigen Ausschüssen entscheiden.

„Die Entscheidung der FSM ist für die Unternehmen dann allerdings bindend.“

Man fragt sich bei solchen Gesetzen dann natürlich macnhmal auch wie lange es noch dauert bis die Entscheidungen einer FSM auch für deutsche Gerichte bindend sein wird …

Möglicher Grund: Es findet derzeit massives Overblocking statt!

Anhaltspunkt: Historisch hochbezahlte Faktchecker kommen zum Einsatz.

Laufen die vorgesehenen Schutzmaßnahmen nicht sowieso ins Leere, da Plattformen Inhalte im Zweifelsfall wegen „Verstoß gegen die AGB“ löschen, ohne genauere Gründe an zu geben?

Irgendein KI-Bot findet irgendein Wort, dass problematisch sein könnte, und sperrt den Post „wegen AGB-Verstoß“, der Nutzer kann sich beschweren und bekommt vom selben Bot 94 Seiten Kleingedrucktes zugeschickt und die Warnung, bei weiteren Rückfragen oder Verstößen werde das Konto gesperrt.

Klagen aussichtslos, weil die Plattformbetreiber Hausrecht haben.