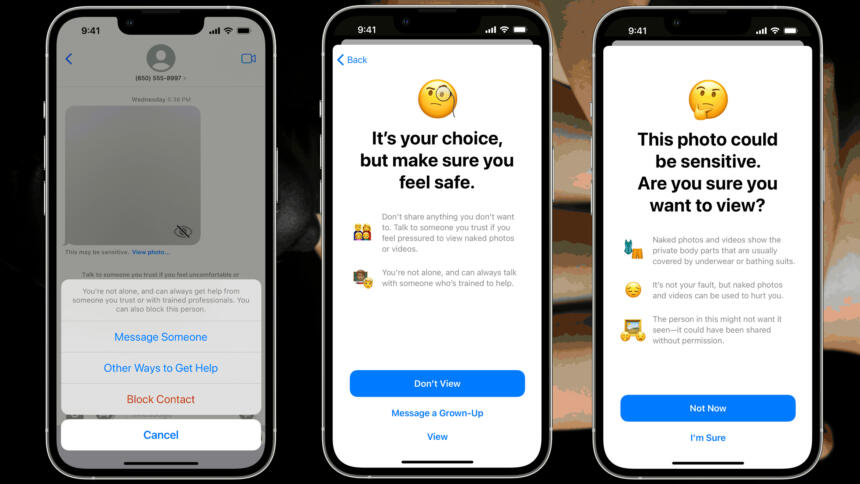

Apple hat angekündigt, dass auf seinen Endgeräten in mehreren Ländern eine neue Kinderschutzfunktion aktiviert werden kann. Ist die als „Communication Safety in Messages“ benannte Funktion angeschaltet, dann untersucht das Gerät bei Nutzung von Apples Messenger eingehende und ausgehende Fotos auf Nacktheit. Das US-Magazin The Verge berichtet, dass das Feature in Großbritannien, Kanada, Australien und Neuseeland eingeführt werden soll.

Sobald die Technologie Nacktheit erkennt, wird demnach das Bild unscharf gemacht und eine Warnmeldung an das Kind ausgespielt. Das Kind kann dann entscheiden, ob es die sendende Person blockt, sich an eine Kinderschutzorganisation wendet oder jemand anderes ins Vertrauen setzt. Alternativ kann das Kind sich das mutmaßliche Nacktbild dennoch anzeigen lassen. Nicht mehr vorgesehen ist die ursprünglich geplante Warnmeldung an die Eltern, die scharfe Kritik ausgelöst hatte. Die Jugend- und Kinderschutzidee hinter der Technik ist, dass Kinder weder Nacktfotos von sich verschicken noch diese empfangen sollten.

Daten bleiben auf Endgerät

Im Gegensatz zu der heftig umstrittenen „Chatkontrolle“ sollen bei diesem System keine Daten außerhalb des Endgerätes verglichen werden. Das Scannen soll nur auf dem Gerät mittels einer Bilderkennungssoftware stattfinden. Es soll weder Benachrichtigungen an die Eltern geben, noch an Apple oder sonstige Stellen.

„Messages analysiert Bildanhänge und stellt fest, ob ein Foto Nacktheit enthält, während die Ende-zu-Ende-Verschlüsselung der Nachrichten beibehalten wird“, so das Unternehmen in einer Erklärung, die die britische Zeitung Guardian zitiert. „Die Funktion ist so konzipiert, dass kein Hinweis auf die Erkennung von Nacktheit jemals das Gerät verlässt. Apple erhält keinen Zugriff auf die Nachrichten, und es werden keine Benachrichtigungen an die Eltern oder andere Personen gesendet.“

Apple hatte schon im vergangenen Jahr diese und andere Funktionen angekündigt, den Rollout aber nach massiven Protesten vorerst auf Eis gelegt. Geplant war damals auch, dass Bilder von Nutzer:innen durchsucht und mit Datenbanken bekannter Darstellungen von Kindesmissbrauch abgeglichen werden. Diese andere Form des Client-Side-Scannings führt Apple nun vorerst nicht ein. Es ist unklar, ob die Kinderschutzfunktion generell die Akzeptanz von Client-Side-Scanning erhöhen könnte.

Pläne für Chatkontrolle in der EU

Die EU-Kommission plant derzeit ein Gesetzespaket, das möglicherweise Internetanbieter dazu verpflichten wird, Inhalte auf den Smartphones von unbescholtenen Bürger:innen auf Darstellungen von Kindesmissbrauch zu durchsuchen – und zwar bevor sie Messenger wie WhatsApp nutzen. Diese Pläne werden in der öffentlichen Debatte als „Chatkontrolle“ bezeichnet, Fachleute sprechen auch von Client-Side-Scanning. Die EU-Kommission will sie am 11. Mai der Öffentlichkeit vorstellen.

Der Meta-Konzern, zu dem WhatsApp, Facebook und Instagram gehören, stellt sich gegen solche Pläne. Meta hält es derzeit für ausgeschlossen, Technologien wie die „Chatkontrolle“ einzuführen, ohne die Ende-zu-Ende-Verschlüsselung zu schwächen oder zu brechen. Der Konzern sieht die negativen Auswirkungen auf Privatsphäre, Meinungsfreiheit und andere Rechte als so gravierend und unverhältnismäßig an, dass ein Durchsuchen von Inhalten auf den Smartphones der Nutzer:innen „nicht weiterverfolgt werden“ sollte – selbst wenn es technisch möglich wäre.

ich kenn mich mit apple produkten nicht aus: woher weiss das smartfon denn dass es von einem kind benutzt wird? (ist der account irgendwie mit den accounts der eltern verbunden?)

Servus Anonymous,

die Altersverifikation ist sehr einfach. So einem Smartphone liegen eben mehrere Datenquelle zu Grunde die sich bei der Verwendung abgreifen lassen. Die Sensoren der Kreiselkompasse zur Neigungsorientierung, damit lässt sich sehr genau die Beschleunigung und Neigung als auch der Winkel des Gerätes erfassen. Das lässt Rückschlüsse zu auf die Handflächen, die Armlänge, den Schrittabstand, ob jemand sitzt, steht, liegt usw. Dazu dann noch der Helligkeitssensor mit dem sich bestimmte Positionen in Räumen zu einer Jahreszeit bestimmen lassen, oder Klang-Effekte übers Mikrofon. Bei Geräten mit Biometriedaten, also Gesichtserkennung oder Fingerabdruck zum Entsperren eben der das Gesicht, was eben Augenabstand, Nase Mund und Wangenknochen vermisst und eben auch sehr schnell das Alter bestimmen kann. Dann kommen noch so triviale Daten hinzu wie Mimik in diesem Gesicht, bestimmte Muskelzüge die sich erfassen lassen, auch bei dem Betrachten von Videos, Werbung und anderen Inhalten.

Die Überwachungskapitalisten verarbeiten sollte Daten auf Systemeben des Betriebssystems und verknüpfen diese Information letztlich indirekt, in dem die KI auf dem Gerät selber die Stimmung beschreibt und auswertet ob andere (neue) Inhalte eine bestimmte Stimmung unter dieser Zielgruppe hervorrufen. Dazu erden natürlich individuelle Avatare zu jeder Person im Haushalt angelegt. Ich bezeichne dies gerne als Personalisierung.

Dieser Vorgang ist sehr wichtig, weil es das Geschäftsmodell der modernen Unternehmen ist. Sie möchten eine Beeinflussung von Verhalten für jedes Individuum möglichst präzise Vorhersagen können. Daher ist es erforderlich die Telemetriedaten genau zu kennen, auch weil sich nur so die Nutzer:innen über mehrere Geräte hinweg zuordnen lassen.

Dazu kommt halt auch noch die Daten von Nutzer:innen Verhalten aus den 1995 Jahren. Browserverlauf, oft besuchte Links, Cookies, Lesegeschwindigkeit, Interessensgruppen usw., doch das ist einfach nicht so genau.

Ja, genau. Du kannst mehrere iCloud Accounts zu einer Familie zusammenschließen, und angeben wer die Eltern und wer die Kinder sind. Für Kinder lassen sich dann Beschränkungen vornehmen, zum Beispiel auch App Store Käufe und so.

Das ist doch mal ein Schritt in die richtige Richtung! Ein stark begrenzter Einsatzbereich, Verarbeitung auf dem Gerät, selbstbestimmter Umgang mit dem Inhalt statt Exfiltration an Dritte.

Andererseits ist damit der Fuß in der Tür. Den Plänen der Kommission sollte weiterhin standhaft entgegen getreten werden.

„Daten bleiben auf Endgerät“

Ist das nicht eine sehr gewagte Aussage? Weil den Source Code habt ihr doch nicht untersucht oder? Zudem ist Apple und Google dafür bekannt die Daten mit der eigenen Cloud zu synchronisieren und vor allem die Personalisierung und Weiterentwicklung der Neuronalen Netzwerke, die sowohl die Bildbearbeitung verbessern als auch die Bilderkennung. Eben auch ein Grund warum die Geräte selber diese Bilder mit viel haut erkennen und Verpixeln können.

Ist schon bekannt ob es mit allen Haut-Typen gut funktioniert oder nur auf „helle“ Haut beschränkt?

Werden zur Optimierung der Algorithmen das Material Dritten zur Verfügung gestellt um die Erkennung zu verbessern? Gab es ja schon bei den Cleaners (Meta), aber auch bei den Sprach-Erkennungsprogrammen von Amazon, Apple und Google.

Ich bin hier sehr skeptisch und vermute das diese Aussage komplett falsch ist. Weil halt schon auf Systemebene die Daten abfließen und sich so ein neuronales zum „Träumen“ und kreieren von Inhalten verwenden lässt.

Danke für eure gute Arbeit.

Eine solche Funktion ist vollkommen ok – solange NICHTS irgendwie vom Handy abfliesst!

Einerseits das. Andererseits haben wir vielleicht bald eine Generation von Jugendlichen, die von der Pike auf gelernt haben, was falsche Positive sind. Das sich könnte positiv auf die Medienkompetenz auswirken.

Und was werden die Kinder von heute in 20 oder 30 Jahren sagen und klagen, wenn man damit Ihren Missbrauch hätte verhindern können? Ähnliche nachgelagerte Verfolgungsmuster gibt es ja bereits in anderen Bereichen, wie Sexualstrafrecht, Naziverfolgung, Linke Meinungen, die man bis 40 Jahre lang als Anschlagsplanung auslegen kann, um nur einige Fälle zu nennen.

In englischen Sprachrum habe die Schulen etc. jedenfalls kein Problem über die Schul-Laptops präventiv die Familien abzuhören, allein aus Vorbeugung.

Allerdings halte ich das ganze letztendlich für ein Anfixen. Irgendwann werden Eltern oder Schutzvereine kommen und fragen, warum das nicht direkt zur Kripo gesendet wurde?

Gruß

Ralf

Nehmen wir an, es käme tatsächlich dazu dass „Internetanbieter dazu verpflichten wird, Inhalte auf den Smartphones von unbescholtenen Bürger:innen auf Darstellungen von Kindesmissbrauch zu durchsuchen – und zwar bevor sie Messenger wie WhatsApp nutzen.“

Und dazu die Information „Das Scannen soll nur auf dem Gerät mittels einer Bilderkennungssoftware stattfinden. “

Dann frage ich mich, wie diese Software auf das Smartphone kommen soll. Wenn ein Internetanbieter eine Software installieren kann, dann kann der jede Software installieren. Aktuell kann ich verhindern, dass Google Änderungen an meinem Phone durchführt. Aber irgend ein Internetanbieter? Das wäre ein Scheuentor von Sicherheitslücke, dazu noch gesetzlich vorgeschrieben. Da kann man doch gleich besser alle Daten in der Cloud lagern und die Dinge dort „untersuchen“ (auf werbeträchtige Hinweise; jo, hätten die gerne)

Zudem droht hier die Förderung des sowieso vorhandenen Apple/Google Monopols, weil so eine vorgeschriebene Software für ein neues/anderes System erst einmal geschrieben werden müsste.

Und wer erfährt von illegalen Inhalten? Was sind illegale Inhalte jetzt und was in Zukunft?

Und was rauchen die eigentlich?

Das ist zunächst ein Offlinescan, der noch aktiviert werden muss, zudem muss es ja wohl eine Art Zugangsschutz für die Verwaltenden geben, so dass hier schon ein gewisses Können und Machen im Spiel sein muss.

Was kann schiefgehen?

– Bilder von Hautreaktionen oder falsche Positive bei Notlagen – Patient tot!

– Unbill.

– Allgemeine Fehlfunktionen zur Belustigung aller.

Wird es ausgeweitet?

– Scan grundsätzlich für alle Geräte? Nur bei nackter Haut sinnlos. Vielleicht aber für Terror und Kindesmißbrauch? Da könnten die aber mit ähnlicher Begründung auch die Mikrofone aktivieren….

– Scan verhindert Versenden UND Speichern von Dateien. Da freut sich der Freelancer. Auf dem Dateisystem wird’s nämlich kriminell, da ja alle Dateien gescannt werden müssen, und falsche Positive ab da dein persönlicher militärischer Feind sein werden.

„Das ist zunächst ein Offlinescan..“

Du darfst dich nicht von den Taschenspielertricks verwirren lassen. Denn die Informationen des Offlineservice, wandern natürlich zum Upstream um dort die neuronalen Netze zu verbessern. Damit bist du und dein Verhalten in der Vergangenheit, natürlich in der Cloud/dem Cloudalgroithmus vertreten.

Das ist als würde dein ganzer Browserverlauf geteilt, aber es findet unter dem Deckmantel der Anonymisierung statt. Leider Informationskrümel deines Verhaltens aus, um dich genau zu identifizieren. Wie beim Fingerabdruck.

Offline ist leider nur so lange richtig, bis du mit anderen Menschen oder Maschinen welche dein Verhalten beobachten oder diese Erfahrung des Beobachtens teilen, in Kontakt trittst.

Edit: @Ralf

„die Kinder von heute in 20 oder 30 Jahren sagen“

Es spielt keine Rolle, weil die Algorithmen sich in Echtzeit an die jungen Menschen anpassen und deren Wahrheit in Echtzeit anpassen. Schau dir nur an wie du in der Gegenwart das Internet verwendest und stell dir vor, das für die Jungend-Inhalte in Echtzeit personalisiert werden mit der Berücksichtigung des Kapitalmarktes für zukünftige Ereignisse.

Die meisten nehmen diese Anpassungen und Zukunftsprognosen einfach nur als Gegeben hin. Es scheinen selbst erfüllende Prophezeiungen.

Machen die Hersteller was sie wollen, und scherten sie sich nicht um Gesetze, wäre das bereits jetzt so.

Zunächst ist der Vorschlag aber ein Scan auf dem Endgerät ohne Hochladen, auch nicht zum Trainieren. Hier ging es noch um Hashes, deren Verfahren einigermaßen verstanden sind.

Der neue Verstoß auf EU-Ebene geht vielleicht so weit, allgemeine Bilderkennung, also Maschinendeslernen zu fordern, so dass wir um den totalen Upload auf absehbare Zeit nicht herumkommen würden.

Clientseitige Scans sind Schwachsinn. Auch mit Cloudupload. Kann und wird einfach dann eben Biene Maja hochgeladen.

Hier kommt dann die Nachbesserungskannonade: Die Cloud meldet an den Empfänger den Hash des Bildes (…), so dass in der Masse der soziale Zwang siegt, das offizielle Protokoll zu verwenden.

Etabliert sich das, wird keiner mehr verstehen, was Ende-zu-Ende-Verschlüsselung ist, weil die Politik das Wort für ihre Ruhmesreden entdeckt haben wird.