Zehntausende Menschen sichten für Plattformen wie Facebook, TikTok und YouTube Inhalte, die nicht online sein sollen. Das sind teils verstörende Aufnahmen, die Gewalt, Nacktheit, Hass und Volksverhetzung zeigen. Die Tätigkeit heißt Content Moderation, Inhaltsmoderation. Zahlreiche Berichte zeigen: Diese Arbeit ist schier endlos, viele Angestellte klagen über psychische Belastungen durch die schiere Flut an Inhalten.

Auch die deutsche Medienaufsicht betreibt inzwischen eine Art Content Moderation. Der Vergleich drängt sich auf, seitdem die Aufsicht das Netz auch automatisiert durchforstet. Das geschieht mithilfe einer Software namens KIVI. In ihrem Ticketsystem erscheinen reihenweise Verdachtsmeldungen, die Sichter*innen dann abarbeiten.

Der Name KIVI setzt sich zusammen aus „Künstliche Intelligenz“, dem Modewort für flotte Rechenprogramme, und dem lateinischen Wort „vigilare“, zu Deutsch: überwachen. Entwickelt wurde KIVI vom Berliner IT-Unternehmem Condat AG und der Landesmedienanstalt Nordrhein-Westfalen (NRW).

Es gibt jedoch große Unterschiede zur Content Moderation durch Konzerne. Bei der Medienaufsicht sind nicht etwa Heerscharen von Zehntausenden Moderator*innen im Einsatz, sondern eine niedrige zweistellige Zahl, wie ein Sprecher mitteilt. Im Dezember sind das etwa bei der Landesmedienanstalt in Nordrhein-Westfalen neun studentische Hilfskräfte, die acht bis 20 Stunden in der Woche arbeiten, sowie fünf Jurist*innen, begleitet und geführt durch drei weitere Personen. Darüber hinaus arbeiten in den Medienanstalten der anderen Bundesländer weitere Beschäftigte mit KIVI.

Öffentlich-rechtliche Inhaltskontrolle

Dabei nimmt die Medienaufsicht allerlei Websites und Plattformen zugleich in den Blick, darunter YouTube, Twitter und Telegram. Und die Finanzierung kommt von allen Menschen, die in Deutschland den Rundfunkbeitrag zahlen, denn die Landesmedienanstalten sind öffentlich-rechtlich. Das bedeutet, wir alle zahlen für die amtliche Inhaltskontrolle. Der Anteil, der vom monatlichen Rundfunkbeitrag an die Medienanstalten fließt, beträgt allerdings nur 35 Cent, und die Aufsicht hat auch zahlreiche andere Aufgaben.

Grundlage für die Kontrollen der Medienaufsicht sind nicht etwa Community-Richtlinien, sondern deutsche Gesetze. Entdeckte Inhalte kann die Medienaufsicht nicht selbst löschen, sondern nur den Anbietern melden oder bei der Staatsanwaltschaft zur Anzeige bringen. Wir haben darüber mit einer Person gesprochen, die selbst mit KIVI arbeitet. Sie findet den Vergleich mit Content Moderation weniger treffend. „Ich komme mir eher vor wie ein Internet-Polizist“, sagt sie, und bittet darum, im Artikel nicht namentlich genannt zu werden.

In Sachen Transparenz gibt es einen weiteren Unterschied zur kommerziellen Content Moderation: Private Anbieter lassen sich kaum in die Karten schauen. Vieles, was man heute über die Schufterei bei Facebook oder TikTok weiß, stammt von Whistleblower*innen. Die Medienaufsicht dagegen muss Rede und Antwort stehen. Nach einer Anfrage mit Bezug auf das Informationsfreiheitsgesetz (IFG) hat die Aufsicht also das Handbuch für die Software offengelegt, mit deren Hilfe Sichter*innen im offiziellen Auftrag das öffentlich zugängliche Netz kontrollieren.

Das 234 Seiten umfassende Dokument erlaubt erstmals Einblicke in das beispiellose Vorhaben amtlicher Inhaltskontrolle.

Danach sucht die Medienaufsicht im Netz

Das Überwachungs-Tool KIVI durchsucht Websites und Plattformen nach drei Oberkategorien von verdächtigen Inhalten, wie aus dem Handbuch hervorgeht. Die erste davon ist „Hassrede“. Dazu gehören Volksverhetzung und Holocaustleugnung sowie das Verbreiten von Kennzeichen und Propagandamitteln verfassungswidriger und terroristischer Organisationen. Ein anschauliches Beispiel sind Hakenkreuze. All das wird als „Politischer Extremismus“ zusammengefasst. Zu „Hassrede“ gehören außerdem Gewaltdarstellungen.

Die zweite Oberkategorie ist Jugendschutz. Dazu gehören laut Handbuch klassische Pornografie und auch Hentai, also gezeichnete oder animierte Pornos. Ohne strenge Alterskontrolle dürfen solche Inhalte eigentlich nicht in Deutschland abrufbar sein. Ebenso unter Jugendschutz fällt „Entwicklungsbeeinträchtigung“, damit gemeint sind laut Handbuch „Erotik“, die Verherrlichung von Drogen und „Selbstgefährdung“. Zu Letzterem dürften zum Beispiel Inhalte gehören, die Suizid verherrlichen. Eine für Laien weniger bekannte Kategorie ist „Offensichtlich schwere Jugendgefährdung“. Damit sind Dinge gemeint, die „gravierende sozial-ethische Desorientierung“ auslösen können und dem „unbefangenen Betrachter ins Auge springen“, wie die zuständige Bundeszentrale erklärt.

Die letzte Oberkategorie ist für Werbung vorgesehen, denn die Medienaufsicht kontrolliert auch Werbekennzeichnung im Netz. Sie schreitet ein, wenn beispielsweise Influencer*innen gegen Geld für Seife werben, ohne das transparent zu machen.

Diese Orte will die Medienaufsicht überwachen

Die Medienaufsicht hat sich viel vorgenommen. Zunächst soll KIVI reihenweise Inhalte auf Websites kontrollieren. Zumindest ein paar Websites darf KIVI dabei ausdrücklich meiden, weil sie als unbedenklich gelten. Welche das sind, hat die Medienaufsicht in Folge einer IFG-Anfrage verraten. Keine KIVI-Überwachung gibt es demnach unter anderem auf den Online-Auftritten der Bundesländer und der Medienanstalten selbst.

Darüber hinaus möchte die Medienaufsicht das Geschehen unter anderem auf YouTube, Twitter, TikTok, Telegram und der russischen Facebook-Alternative VKontakte überwachen. Um nicht Inhalte aus aller Welt zu finden, konzentriere sich KIVI auf deutschsprachige Suchbegriffe und Accounts, wie ein Sprecher auf Anfrage erklärt.

Die deutsche Medienaufsicht ist nach Bundesländern aufgeteilt, und das gilt auch für die Verdachtsmeldungen bei KIVI. So durchsucht KIVI etwa das Impressum von Websites oder die Beschreibung von YouTube-Kanälen nach geografischen Hinweisen. Als Beispiel nennt das Handbuch einen YouTube-Kanal, in dessen Beschreibung das Wort „Köln“ steht. Entsprechend ordnet KIVI die Verdachtsmeldung der Landesmedienanstalt NRW zu.

Das passiert mit den Funden der Medienaufsicht

Das Handbuch beschreibt, wer die verdächtigen Inhalte in welcher Reihenfolge sichtet und überprüft. So landen automatisch von KIVI entdeckte Inhalte zunächst bei einem Monitoring-Team. Die Sichter*innen können zusätzliche Informationen und Screenshots händisch hinzufügen. Das Handbuch erwähnt außerdem „Referenten und Juristen“, die daraufhin die Verdachtsmeldungen überprüfen.

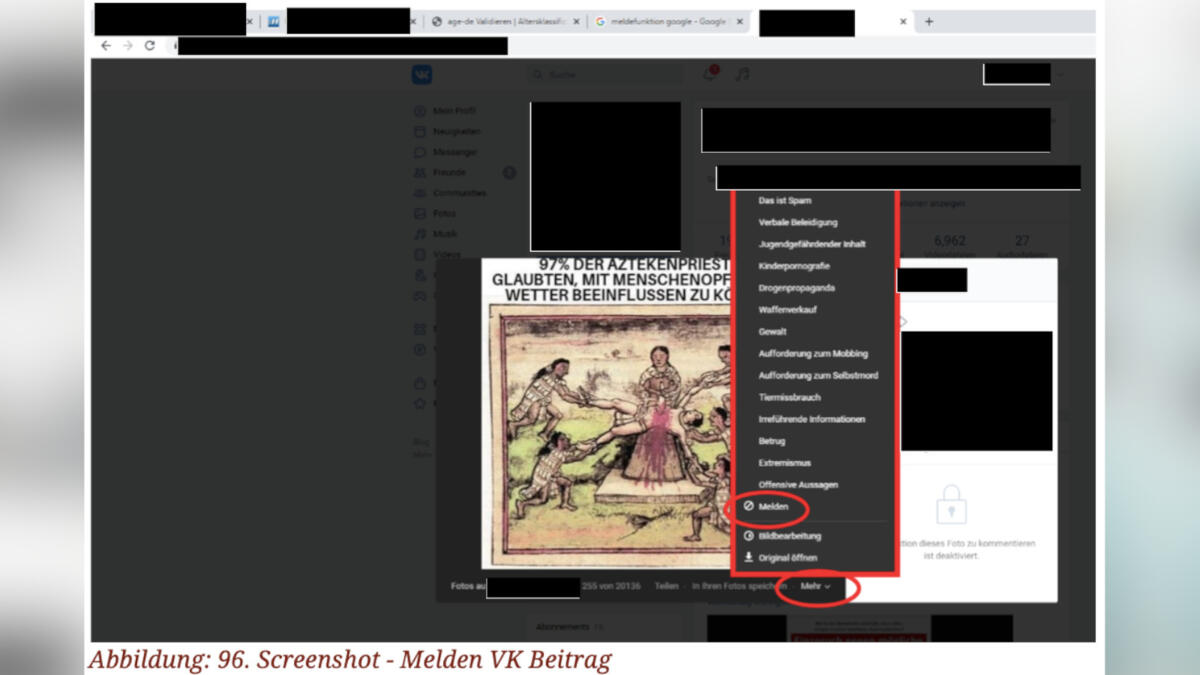

Wenn sich verdächtige Inhalte als problematisch herausstellen, müssen die Sichter*innen handeln. Das Handbuch beschreibt anhand von Screenshots, wie Sichter*innen Inhalte bei Twitter, YouTube, VKontakte und Telegram melden können. Solche Meldungen landen dann bei den Support-Teams der jeweiligen Unternehmen.

Als Beispiel für einen solchen Beitrag zeigt das Handbuch einen Screenshot aus dem Netzwerk VKontakte. Er zeigt eine Zeichnung, die laut Beschreibungstext ein Menschenopfer der Azteken darstellen soll. Eine blutende Person mit einem Messer im Bauch liegt auf einem Tisch, andere zerren an ihren Gliedmaßen.

Für Sichter*innen kommen auch Anzeigen bei der Staatsanwaltschaft infrage, das dürfte beispielsweise bei Holocaustleugnungen der Fall sein. Für solche und andere Anzeigen ist bei KIVI eine laut Handbuch neue Funktion vorgesehen, die zunächst in NRW zum Einsatz komme. Mit ihr lassen sich Eckdaten für eine Anzeige direkt bei KIVI bündeln und als PDF-Datei speichern.

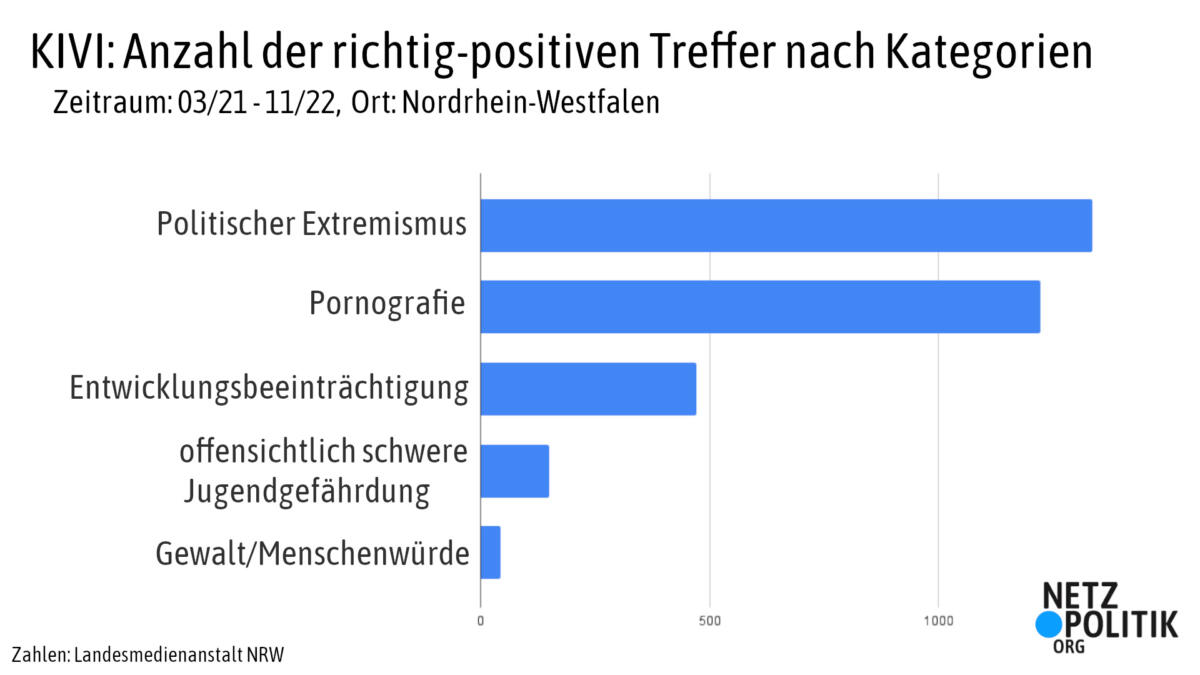

So viel findet die Medienaufsicht im Netz

Auf Anfrage von netzpolitik.org hat die Landesmedienanstalt NRW offengelegt, wie viele Ergebnisse das Überwachungs-Tool KIVI bisher geliefert hat. Die Zahlen beziehen sich auf den Zeitraum März 2021, also dem Start von KIVI, bis November 2022. Sie stammen allein aus Nordrhein-Westfalen – hier ist KIVI am längsten im Einsatz.

Insgesamt 2.835 Verstöße haben Sichter*innen demnach mithilfe von KIVI entdeckt, die meisten davon fielen unter „Politischen Extremismus“ und „Pornografie“. Die Funde zu „Politischem Extremismus“ hätten seitdem zu 591 Strafanzeigen geführt, wobei zu einer einzelnen Strafanzeige auch mehrere Treffer von KIVI gehören können. Bei Pornografie waren es laut Medienanstalt 25 Strafanzeigen.

Die Anzahl der Meldungen bei Online-Anbietern selbst sei eher gering, sie betrage nur 50. Der Grund: Beim Thema „Politischer Extremismus“ wolle die Medienaufsicht nicht die Ermittlungen der Staatsanwaltschaft behindern, wie ein Sprecher mitteilt. Bei Meldungen von pornografischen Inhalten würden Anbieter schlicht nicht reagieren, deshalb gehe die Medienaufsicht stattdessen gegen die Pornoseiten selbst vor – mehr darüber berichten wir hier.

So erkennt das Überwachungs-Tool Inhalte

KIVI kann etwa Texte, Bilder und Videos kontrollieren. Um verdächtige Texte zu erkennen, sucht KIVI nach Stichworten. Administrator*innen verwalten laut Handbuch eine „Liste von Stichworten, die häufig in regelwidrigen Texten vorkommen“. Bislang bekannt sind nur Beispielswörter wie „Terror“, „Mord“, „Islam“, „Juden“, „Christen“. Die vollständige Liste möchte die Medienaufsicht auf Anfrage nicht offenlegen. Sie befürchtet, dass Menschen dann diese Worte gezielt vermeiden, um nicht entdeckt zu werden, wie die Pressestelle der Landesmedienanstalt NRW mitteilt.

Videos zerlegt KIVI laut Handbuch in einzelne Bilder, sogenannte Frames, und diese wiederum untersucht das Tool per Bilderkennung. Sichter*innen können sich durch die Liste von Frames scrollen, während sie verdächtige Videos prüfen. Details zur Technologie hinter der Text- und Bilderkennung liefert das Handbuch nicht.

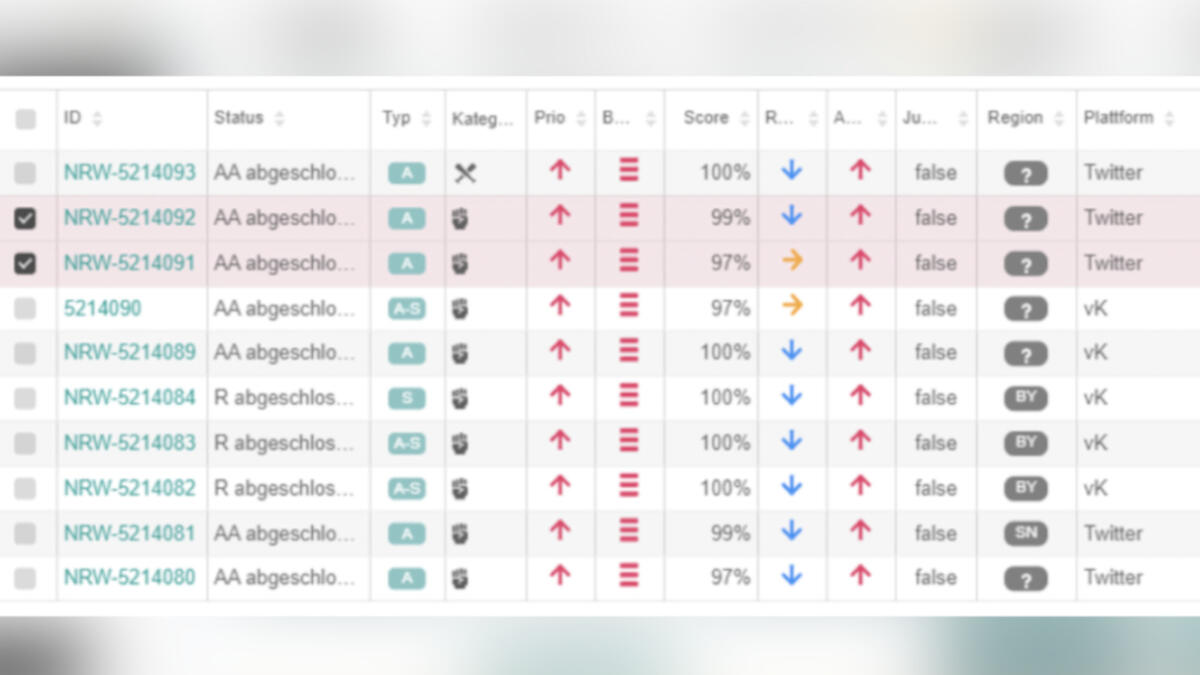

Zumindest ordnet KIVI verdächtigen Inhalten bereits eine Kategorie zu, etwa „Pornografie“. Außerdem versieht sie Treffer mit einem Score. Dieser Score drückt aus, inwiefern sich das Tool sicher ist, einen Inhalt korrekt erkannt zu haben. Ein Score von 0,9 bedeutet zum Beispiel 90 Prozent Sicherheit. Bunte Pfeile drücken aus, ob ein verdächtiger Inhalt eine hohe, mittlere oder niedrige Reichweite hat.

So soll das Überwachungs-Tool besser werden

Ein Screenshot aus dem Handbuch zeigt eine beispielhafte Verdachtsmeldung bei KIVI. Demnach hat KIVI ein verdächtiges YouTube-Video mit 3.500 Views erkannt. Es beinhalte mit 100-prozentiger Sicherheit Pornografie und sei zu 56 Prozent jugendgefährdend.

KIVI kann sich irren, deshalb müssen Sichter*innen solche Meldungen mit eigenen Augen prüfen und das Ergebnis händisch eintragen. Das Feedback der Sichter*innen soll das Überwachungs-Tool mit der Zeit verbessern.

Im Handbuch heißt es hierzu: „Es ist am Anfang etwas mühsam, erleichtert aber in Zukunft Ihre Arbeit (hoffentlich)“. Das Wörtchen „hoffentlich“ zeigt: Ganz so sicher sind sich die Verfasser*innen offenbar selbst nicht, ob die KI mit der Zeit besser wird.

Warum Künstliche Intelligenz Facebooks Moderationsprobleme nicht lösen kann, ohne neue zu schaffen

So will die Medienaufsicht ihre Sichter*innen schonen

Verdächtige Inhalte zu sichten, kann belastend sein, wie zahlreiche Berichte traumatisierter Content Moderator*innen zeigen. Das spiegelt sich auch im Handbuch der Medienaufsicht wider. Dort werden die Sichter*innen ausdrücklich vor den „Gefahren für Ihr psychisches Wohlbefinden“ gewarnt. Um dem entgegenzuwirken, zeigt KIVI verdächtige Bilder zunächst nur unscharf. Sichter*innen können den Unschärfe-Filter mit einem Schieberegler verstärken oder entfernen. „Benutzen Sie diesen Filter!“, warnt das Handbuch. „Überschätzen Sie sich nicht.“

Außerdem rät das Handbuch den Sichter*innen, zunächst einen Blick auf die Kategorie zu werfen, die KIVI einem Inhalt zugeordnet hat. Gegebenenfalls könne man die Aufgabe an ein anderes Team-Mitglied geben. Darüber hinaus gibt es weitere Maßnahmen, wie ein Sprecher der Landesmedienanstalt NRW erklärt. Sichter*innen könnten regelmäßig an einer Supervision teilnehmen und jederzeit psychologische Beratung in Anspruch nehmen.

„Die Arbeit mit belastenden Inhalten im Monitoring wird grundsätzlich nur vom Büro aus und nicht im Homeoffice durchgeführt“, schreibt der Sprecher weiter. Die räumliche Distanz helfe den Kolleg*innen, die belastenden Inhalte auf der Arbeit zu lassen. Der Schichtplan werde so gestaltet, dass immer möglichst mehrere Personen im Büro sind und mit dem Tool arbeiten. Nicht einzeln abgefragt haben wir, welche Maßnahmen die anderen Landesmedienanstalten treffen.

So lässt sich die Überwachung skalieren

Die Anzahl der amtlichen Sichter*innen ist derzeit sehr überschaubar. Die Anweisungen in dem 234-Seiten-Dokument dagegen liefern die Grundlage für weitaus größere Teams.

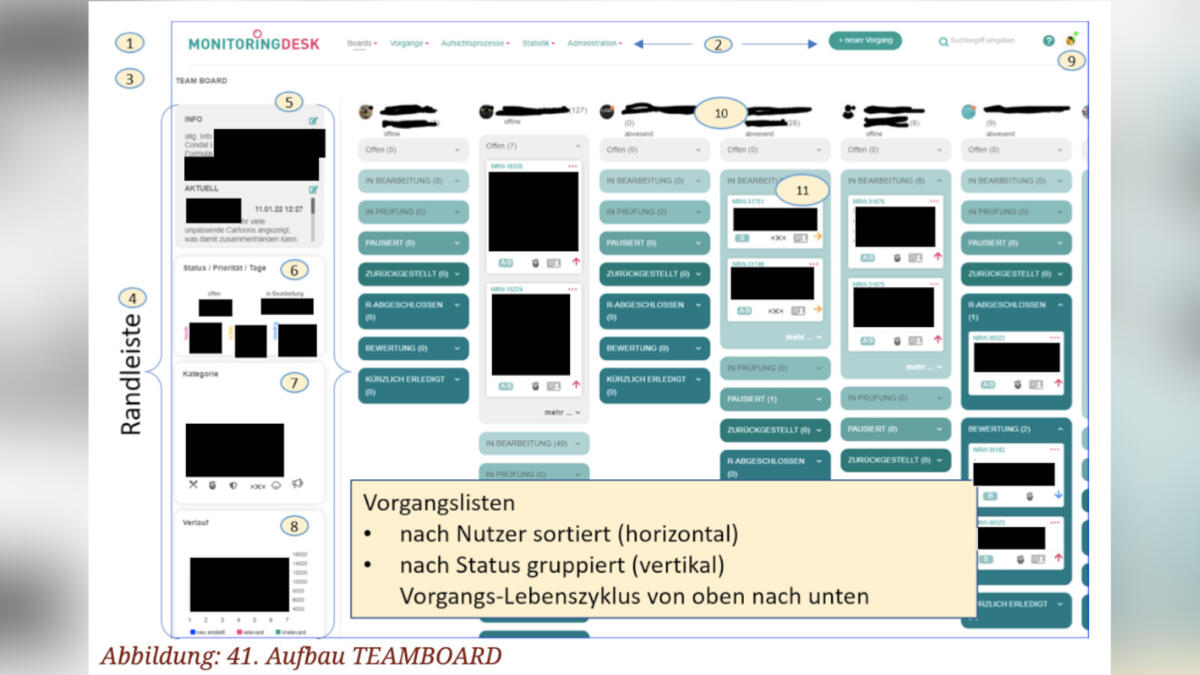

So haben Sichter*innen bei KIVI ein eigenes Profil und können auch die Profile anderer Team-Mitglieder sehen, wie aus einem Screenshot im Handbuch hervorgeht. Dort können sie ablesen, wer gerade besonders fleißig ist, und wer nicht. Konkret angezeigt wird pro Mitglied, wie viele Vorgänge unter anderem „offen“ sind, wie viele „in Bearbeitung“, „pausiert“ oder „kürzlich erledigt“. Insgesamt nennt das Handbuch zwölf solcher Status-Kategorien.

Offenbar ist KIVI darauf angelegt, dass auch deutlich mehr Sichter*innen wie am Fließband verdächtige Inhalte prüfen und verwalten können. Bei Abwesenheiten etwa durch Krankheit sollen Sichter*innen unkompliziert die Aufgaben von anderen übernehmen können, heißt es im Handbuch.

Das können die Mühen der Medienaufsicht bewirken

Wohl niemand kann per Ticketsystem die Flut an illegalen Inhalten im Netz bewältigen – das weiß auch die Medienaufsicht. Offenbar ist das aber auch nicht das Ziel. Anschaulich macht das ein Doppel-Interview mit dem Direktor der Landesmedienanstalt NRW, Tobias Schmid, das die Bundeszentrale für politische Bildung geführt hat. Zur Transparenz muss erwähnt werden: Der zweite Gast des Interviews war der Autor dieses Textes. Auf die Frage, ob der Einsatz von KIVI bloß einen symbolischen Nutzen habe, sagte Schmid: „Es ist wichtig, dass Täterinnen und Täter wissen, dass sie erwischt werden können.“ Konkret sprach er von „Generalprävention“.

Generalprävention ist ein Fachbegriff, der erklären soll, warum Menschen überhaupt bestraft werden. Dahinter steckt der Gedanke, dass Strafen nicht nur etwas für die Täter*innen selbst bedeuten, sondern auch für den Rest der Gesellschaft. Demnach können Strafen für Einzelne auch andere potenzielle Täter*innen abschrecken, während die Gesellschaft Vertrauen in die Rechtsordnung gewinnt. Einen solchen Zweck verfolgt die Medienaufsicht laut Schmid also mit KIVI. Die automatisierte Inhaltskontrolle per Ticketsystem wäre dafür allerdings nicht unbedingt notwendig.

Die Medienaufsicht ist von dem Ansatz offenbar überzeugt: Zuerst wurde KIVI in NRW getestet, seit dem Frühjahr ist das Tool deutschlandweit im Einsatz. Und das soll nur der Anfang sein. Die Landesmedienanstalt NRW und der Anbieter Condat AG wollen die Software künftig im EU-Ausland vermarkten – Belgien und Österreich zum Beispiel sind bereits interessiert.

Offenlegung: netzpolitik.org-Gründer Markus Beckedahl ist seit 2010 Mitglied des Medienrats der Medienanstalt Berlin-Brandenburg (mabb).

Wenn KIVI durch öffentliche Gelder (Teile der Rundfunkzwangsabgabe) entwickelt wurde, ist der Quellcode dann auch von den Bezahlern (=jedem der Rundfunkbeiträge bezahlt) einsehbar?

Public money, public code usw…

Ich hab vor 1 paar Tagen über FragDenStaat einen Bericht zu einem sehr ähnlichen Programm (DeToX) von u.a. dem hessischen Innenministerium bekommen. Automatisierte Erkennung und Klassifikation von Social Media Posts: https://fragdenstaat.de/anfrage/unterlagen-hessengegenhetze-vorklassifizierungs-ki/828667/anhang/abschlussbericht-detox.pdf

Und die sind bestimmt nicht die Einzigen. Automatisierte digitale Strafverfolgung scheint bei uns gerade in Mode zu kommen.