Auf einmal waren da diese merkwürdigen Tickets. Mika* arbeitet in Essen beim Dienstleister CCC und moderiert dort im Auftrag von Facebook Posts, Videos und Bilder, die gegen die Regeln des Konzerns verstoßen könnten. Schon in normalen Wochen bekommen die Moderator:innen viele Meldungen vorgelegt, die bei ihnen Stirnrunzeln auslösen. An diesem Tag wirkten die Posts besonders wahllos zusammengewürfelt: Oft war an ihnen überhaupt nichts auszusetzen, außer dass ein bestimmtes Wort doppeldeutig war. „Proactive Queue“ heißt Ticket-Warteschlage, in der diese merkwürdigen Inhalte zur Moderation vorgelegt wurden.

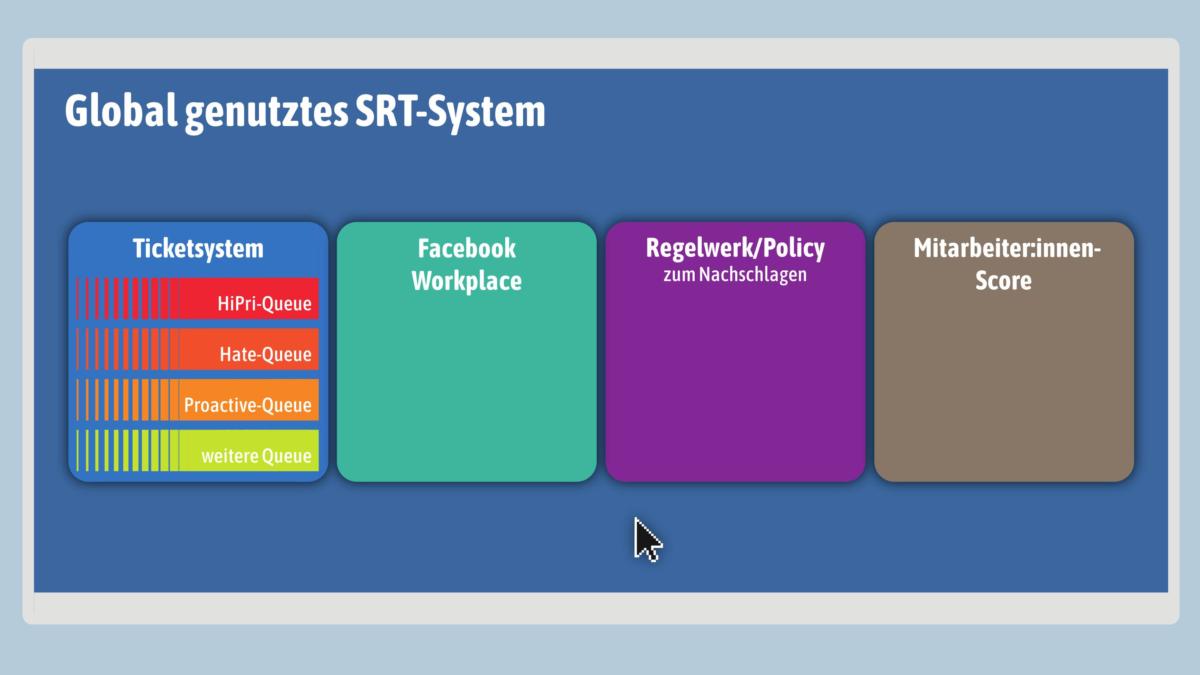

Es dauerte eine Weile, bis Mika und den Kolleg:innen dämmerte, womit sie es zu tun hatten: Proaktiv – das heißt, dass Facebooks Software selbst Inhalte sucht und zur Löschung vorschlägt, die sie für verdächtig hält. Heute setzt der Weltkonzern im großen Stil auf diese automatisierte Erkennung unerwünschter Inhalte. Es ist ein qualitativer Sprung: Lange wurden die Beiträge, über die die Moderator:innen zu entscheiden hatten, nur von Menschen gemeldet. Sie markieren etwa ein Bild als anstößig, gewalttätig oder obszön, so dass es als Ticket in einem Kanal landet und auf dem Bildschirm von Content-Moderator:innen wie Mika aufschlägt.

Künstliche Intelligenz soll es richten

Wann immer Facebook-Chef Mark Zuckerberg bei den Anhörungen im US-Senat im vergangenen Jahr auf Probleme mit Hetze und anderen unerwünschten Inhalten auf seiner Plattform angesprochen wurde, hatte er für die Politik eine einfache Antwort parat: „AI will fix this“, Künstliche Intelligenz wird es richten. Doch immer mehr Expert:innen melden Zweifel daran an, dass Automatisierung Facebooks Probleme tatsächlich lösen kann. Gleichzeitig können wir beobachten, wie die automatische Vormoderation die digitale Öffentlichkeit schon heute verändert.

Mehr als zwei Milliarden Menschen nutzen laut Unternehmensangaben die von Facebook bereitgestellten Dienste für ihre Kommunikation. Sie diskutieren, streiten, lieben, hassen auf den Plattform des Konzerns. Man findet auf Facebook alles, was das Menschsein ausmacht. Auch Tod und Gewalt in allen Variationen. „Es gibt nichts, was nicht geteilt wird“, erzählt Mika lakonisch. Damit Videos von Vergewaltigungen und Enthauptungen nicht online bleiben, beschäftigt Facebook über Drittfirmen ein Heer von Moderator:innen – und ein Heer von Maschinen.

Nur für den Dienstgebrauch: Content-Moderation als Staatsgeheimnis

Wie genau das System funktioniert, soll die Öffentlichkeit nicht erfahren. Der Konzern zieht seine Maßnahmen für die Content Moderation auf wie ein Staatsgeheimnis, Moderator:innen müssen Geheimhaltungsverträge unterschreiben. Und gerade beim Thema KI lässt sich Mark Zuckerberg ungern in die Karten schauen.

Bekannt ist, dass der Konzern neben digitalen Fingerabdrücken zur automatischen Wiedererkennung bereits gesperrter Inhalte auf maschinelles Lernen setzt. Ein algorithmisches System erkennt hierbei Muster in Trainingsdaten und trifft auf Basis der daraus abgeleiteten Regeln Prognosen zur Bewertung neuer Fälle. Sehr vereinfacht gesagt heißt das: Wenn Post X und Post Y gegen die Gemeinschaftsstandards verstoßen haben, dann tut es Post Z, der ähnliche Eigenschaften aufweist wie X und Y, mit hoher Wahrscheinlichkeit auch.

Durch die schiere Menge zur Verfügung stehender Daten und die gestiegenen Rechenkapazitäten hat diese Form der „Künstlichen Intelligenz“ in den vergangenen Jahren enorme Fortschritte gemacht. Sie hilft bei der Diagnose von Krebs, ermöglicht Autos, die fast autonom fahren und Sprachassistenten, die uns zehn Minuten eher wecken, wenn auf dem Weg zur Arbeit Stau herrscht. Doch bei menschlichen Sprache und der komplexen Abwägung, welche auf einer Plattform legitim sind und welche nicht, stößt die Technologie an ihre Grenzen.

Kultur ist nicht maschinenlesbar

Die merkwürdigen Meldungen, über die Mika und Kolleg:innen sich wunderten, kamen dadurch zustande, dass das System sich auf bestimmte Schlagworte gestürzt hat, die häufig problematisch waren. In einem anderen Kontext, etwa eine in einen Scherz oder Satire eingebette Beleidung, war ihre Verwendung jedoch vollkommen unproblematisch. „Am Anfang kam da ziemlich viel Schwachsinn,“ sagt Mika über die Proactive Queue. Mit der Zeit sei das System dann besser geworden. „Wir trainieren die KI, indem wir ihre Vorschläge als richtig oder falsch bewerten.“ Anfangs häufig wiederkehrende Fehlalarme seien nach einer Weile nicht mehr passiert. Dafür seien neue Fehler aufgetaucht.

Das Problem ist, dass die Unterscheidung dessen, was erlaubt und was verboten ist, in liberalen Gesellschaften eine komplexe Angelegenheit ist. Oft entscheidet der Kontext – und der ist für Maschinen schwer zu erfassen. Meinungsfreiheit ist ein relationales und fluides soziales Konstrukt, dass sich nicht in Formeln übersetzen lässt. Aus diesem Grund bekommen menschliche Moderator:innen bei der Bearbeitung von gemeldeten Chatnachrichten Mika zufolge nicht nur die eine Nachricht, sondern auch einen Ausschnitt des Nachrichtenverlaufs zu sehen.

Bei Bildern funktioniert die Automatisierung besser: „Pornographie erkennt die Software inzwischen ziemlich zuverlässig“, erzählt Mika. Etwa 96 Prozent der wegen Nacktheit wegmoderierten Bilder sind laut Facebook-Angaben durch „Erkennungstechnologie“ entdeckt worden. Wie Fehleranfällig KI aber auch in diesem Bereich ist, verdeutlicht der Versuch der Blogplattform Tumblr, pornographische Inhalte automatisiert löschen zu lassen. Neben harmlosen Comics sperrte das System auch ein Foto des ehemaligen US-Vizepräsidenten Joe Biden. Viel hängt davon ab, wie gut die KI trainiert ist – dass sie jemals zuverlässig legitime und illegtime Inhalte auseinanderhalten kann, darf bezweifelt werden.

Facebook selbst pflegt neben der Geschichte von KI als Rettung deshalb ein zweites Narrativ, das inzwischen noch häufiger betont wird: Am Ende würden alle relevanten Entscheidungen von Menschen getroffen. Die Software mache zwar Vorschläge zur Moderation, aber die Entscheidungshoheit liege bei den Moderator:innen. Niemand soll den Eindruck bekommen, Maschinen würden über das hohe Gut der Meinungsfreiheit entscheiden.

Technische Lösungen für soziale Probleme

Doch selbst, wenn jede Moderationsentscheidung am Ende durch einen Menschen geprüft wird, hat die Ausbreitung der Maschinen in der Content Moderation einen profunden Einfluss auf die digitale Öffentlichkeit. Er bedeutet nicht weniger als die Umkehr eines der Grundgesetze des Internets: Bisher durften auch unerwünschte Inhalte auf Plattformen so lange online bleiben, bis sie von irgendwem beim Betreiber einer Seite gemeldet werden. Auch für illegale Inhalte tragen Hoster erst dann eine Verantwortung, wenn sie darauf hingewiesen wurden und den Post trotzdem nicht löschen.

Dieses „Notice and Takedown“ genannte Prinzip ist in der EU in der E-Commerce-Richtlinie verankert und konstituierend für ein freies Internet. Bei Plattformbetreibern wie Facebook, Youtube und Twitter hat es lange Zeit zu Verantwortungslosigkeit im Umgang mit verletzenden Inhalten geführt. Aber es hat auch einen Teil der anarchischen Freiheit früher Internettage in die Welt der Plattformmonopole gerettet: Selbst in den Gruppen und Chats von Facebook war Raum für Inhalte, die gegen Regeln wie das rigide Nacktheitsverbot verstoßen.

Mit dem großflächigen Einsatz von Erkennungssoftware kommt Facebook der EU-Kommission zuvor, die derzeit darauf drängt, automatische Erkennung auszuweiten. Die hochumstrittene neue Urheberrechtsrichtlinie wird zur Folge haben, dass Plattformen Inhalte proaktiv und vor deren Veröffentlichung auf Urheberrechtsverletzungen untersuchen. In Anbetracht der täglich von Nutzer:innen veröffentlichten Inhalte ist dies nur durch automatische Systeme möglich. Auch für „terroristische Inhalte“ will die EU ähnliche Regeln. Was als verboten eingestuft wird, soll nicht nur erkannt werden, sondern gar nicht mehr gepostet werden dürfen. Trotz der bekannten Probleme bei der automatisierten Erkennung des kulturellen Kontextes von Inhalten setzt die EU auf technische Lösungen für soziale Probleme.

Wird diese Logik jedoch ausgeweitet, werden die unerwünschten Nebeneffekte zunehmen. Immer wieder werden Vorwürfe laut, das System schieße über das Ziel hinaus. Die Nichtregierungsorganisation Reporter Ohne Grenzen etwa machte 2016 auf den Fall des französischen Journalisten und Terrorexperten David Thomson aufmerksam. Sein Account wurde gesperrt, weil auf einem mehrere Jahre alten Bild die Flagge der Terrorgruppe Islamischer Staat/Daesh zu sehen war. Dass ein Mensch sich an dem von Thomson eingeordneten und damals noch nicht verbotenen Symbol störte, ist eher unwahrscheinlich. Stattdessen dürfte der Post in den Schleppnetzen von Facebooks Algorithmus gelandet sein.

Welche Öffentlichkeit wollen wir?

Tatsächlich könnte die automatische Inhalteerkennung sogar noch ausgeweitet werden: In einer vielbeachteten Petition fordert die Kampagnenorganisation Avaaz Mark Zuckerberg auf, automatische Filter auch in den bisher verschlüsselten WhatsApp-Chats zu installieren. Vor dem Hintergrund des von Falschnachrichten geprägten brasilianischen Präsidentschaftswahlkampfes soll dies gegen Desinformation helfen.

Kann Facebook also sein Moderationsprobleme mit Künstlicher Intelligenz lösen? Nur zu einem hohen Preis. Wenn wir über die Zukunft der digitalen Öffentlichkeit nachdenken, sollten wir deshalb gut überlegen, welche Bereiche wir tatsächlich an Maschinen auslagern wollen. Mark Zuckerberg sagt, seine Systeme seien in fünf bis zehn Jahren soweit, jegliche Inhalte sauber zu moderieren. Auch Mika selbst rechnet fest damit, auf Kurz oder Lang von der Software ersetzt zu werden: „Irgendwann sind wir überflüssig.“

Über diese Recherche und die Quellen:

Unser Wissen über die Organisation des Löschzentrums in Essen beruht auf einem mehrstündigen Gespräch von drei Redakteuren von netzpolitik.org mit einer Quelle bei Competence Call Center, die wir im Text geschlechterneutral Mika nennen. Wir können und wollen die Quelle, die wir für glaubwürdig halten, aus Gründen des Informantenschutzes nicht näher beschreiben. Wir sind uns der Probleme und des Risikos bewusst, dass wir uns in Teilen dieser Recherche nur auf eine Quelle stützen können. Deswegen haben wir weite Teile des Artikels durch andere Quellen, auch von anderen Facebook-Dienstleistern verifizieren und bestätigen lassen. Durch diese Quellen können wir heute sagen, dass bei allen Dienstleistern sehr ähnliche oder gar gleiche Systeme eingesetzt werden. Weite Teile dieser Recherche hat außerdem Facebook uns gegenüber bestätigt, die Dienstleister selbst gaben kein Statement ab.

Ergänzen könnte diesen Beitrag ein wenigstens kleiner Hinweis auf die andere Seite, etwa Opfer. Es hat ja irgendeinen Grund, dass dieser ganze Aufwand betrieben wird, der FB und alle Content Moderierenden echtes und viel Geld kostet. Die hier genannten Extrembeispiele der sendenden Seite könnten dann durch Extrembeispiele der Empfänger ergänzt werden, z.B. der Hinterbliebenen von Kindern der Schule Sandy Hook, die sich jahrelang als Schauspieler und Lügner usw. diffamieren lassen mussten. Man kann natürlich auch sagen, Gutjahr, Myanmar etc. sind hinzunehmende unvermeidliche Kollateralschäden, weil es technisch nicht 100% perfekt lösbar ist. Mit diesem Argument könnte man allerdings auch auf Sicherheitsgurte verzichten….

Ich stimme dir zu, diese Perspektive hätte dem Artikel gut getan!

Als Argument gegen die hier dargestellte Problematik funktioniert das aber nicht, finde ich: Die Alternative zu „alles wird automatisch erkannt und (am besten noch vor Veröffentlichung) gefiltert“ ist nicht „anything goes“. Die Alternative dazu lautet „notice and takedown“. Dort, wo Verstöße gemeldet werden, müssen sie zügig und sauber moderiert werden – egal ob die Meldung durch Mensch oder Maschine erfolgt.

Ergänzendes „Ja“, dass die Methode noch weit schlechter funktioniert als Sicherheitsgurte (Zuckerberg nannte vergangenes Jahr mal eine – möglicherweise aber absichtlich arg niedrig angegebene – Trefferquote von nur 52% bei „Hatespeech“) . Die schwierige Optimierung gerade in den Grauzonen klappt aber halt besser, wenn man nicht nur von den Wünschen der Sendenden nach möglichst unbeeinträchtigtem Tun ausgeht, sondern beide Ziele Meinungsfreiheit und (berechtige) Schutzansprüche im Auge hat.

Die Message macht halt immer der Empfänger. Es ist aber schon auch interessant wie weit sich heutzutage „freie Bürger“ übergeordneten maschinellen oder auch obrigkeitsstaatlich organisierten Kontrollen unterziehen. Ohne auch nur ansatzweise die Rechtmäßigkeit zu hinterfragen. Es gäbe ja auch die Möglichkeit, dass man einfach davon ausgeht, dass es mündige Menschen sind, die selbstbestimmt wählen können welchen Schwachsinn sie sich anschauen oder nicht. Auch als Opfer muss man sich nicht zwanghaft jede abstruse, oder gar unflätige Meinung anderer reinziehen. Auf der anderen Seite, darf man hoffentlich trotzdem weiter der Meinung sein, dass Elvis lebt oder, dass Jesus über Wasser gehen konnte. Das Konzept der Meinungsfreiheit steht einfach diametral entgegen allen Arten von Wertungsfiltern oder kulturellen Übereinkünften von Teilgruppen – noch dazu bei einer global agierenden Plattform. Gallileo Gallilei wäre auch durch KI zensiert worden ob mit oder ohne menschlicher Nachkontrolle. Im deutschsprachigen Raum haben sich die aufklärerisch-libertären Ideologien leider nie sonderlich durchgesetzt und neue Automatisierungskonzepte wie Maschinenlernen werden hier widerspruchslos zur Installation von zentralistischen, obrigkeitsstaatlichen Kontroll- und Filtersystemen eingeführt. Die Funktion der Kontroll- und Filterprozesse unterscheidet sich vom Layout nicht sonderlich von denen in der ehemaligen DDR, außer eben automationsgestützt. Sozusagen eine Impfpflicht gegen falsche Meinungen. Franzosen ziehen sich da schnell mal ein gelbes Jackerl an.