Technologien auf Basis von maschinellem Lernen werden immer häufiger für staatliche Überwachung genutzt, etwa beim Einsatz von Videoüberwachung mit automatisierter Gesichtserkennung. Die Europäische Union soll dieser Entwicklung entgegenwirken, sagt nun eine Expert:innengruppe.

Die Vertreter:innen aus Forschung und Industrie hatten von der EU-Kommission vergangenes Jahr den Auftrag erhalten, Empfehlungen für künftige Gesetzgebung zu Künstlicher Intelligenz (KI) auszuarbeiten. Ihr 48-seitiger Bericht stellt Forderungen für den Umgang mit KI-Anwendungen auf. Die Expert:innen formulieren darin nicht nur ethische Bedenken, sondern fordern auch Milliardeninvestitionen in die Forschung und die Entwicklung von Künstlicher Intelligenz.

Schärfer im Ton

Die Empfehlungen zum Umgang mit KI fielen dabei deutlich stärker formuliert aus als jene in den ethischen Leitlinien der Gruppe, die bereits im April vorgestellt wurden. Damals tilgte die Gruppe auf Druck von Industrievertreter:innen die Formulierung „rote Linien“ aus den Entwürfen: nicht verhandelbare Einsatzfelder für die Technologie wie etwa autonome Waffensysteme oder das so genannte Citizen Scoring, wie es China betreibt. In den Leitlinien hieß es lediglich, der Einsatz automatischer Gesichtserkennung müsse „legal und verhältnismäßig“ sein.

Die aktuellen Empfehlungen legen der EU-Kommission nahe, genau solche roten Linien mit Grenzen für mögliche KI-Anwendungen festzulegen. Beim Thema Gesichtserkennung formulieren sie eine deutlich schärfere Warnung als in den Leitlinien vom April. Sie stellen sich gegen eine „unverhältnismäßige und massenhafte Überwachung von Individuen“. Im Bericht heißt es: „Es mag zwar eine starke Versuchung für Regierungen geben, mithilfe von auf KI aufgebauten, allumfassenden Überwachungssystemen die ‚Gesellschaft sicher zu machen‘, dies wäre aber extrem gefährlich […]“

Die Ethikrichtlinien enthielten nur ein Set von nicht-bindenden Leitlinien für Unternehmen und Politiker:innen, doch nun geht es um gesetzliche Regulierung. Allerdings sind auch die im Papier enthaltenen 33 Empfehlungen zur Gesetzgebung nicht bindend.

Die Kommission werde in den nächsten sechs Monaten gemeinsam mit den Mitgliedstaaten prüfen, wie die Empfehlungen geändert oder gestärkt werden sollen, sagte EU-Kommissarin Mariya Gabriel in Brüssel. „Dann werden wir stichhaltige Erkenntnisse darüber haben, wo wir noch strategischer vorgehen oder gewisse Dinge stärken müssen, bevor wir über Regulierung entscheiden.“ Die nächste Kommission könnte dann bis Anfang 2020 die Empfehlungen evaluieren und danach konkrete Vorschläge machen.

Kommission soll erst eine Bestandsaufnahme machen

Die Expert:innen raten der Kommission in den Empfehlungen, eine Bestandsaufnahme zu machen, bevor sie aktiv wird: Welche Gesetze sind bereits in Kraft, etwa zu Verbraucherschutz, Anti-Diskriminierung, Datenschutz oder zivilrechtlicher Haftung? Und wie können diese an neue KI-Szenarien angepasst werden?

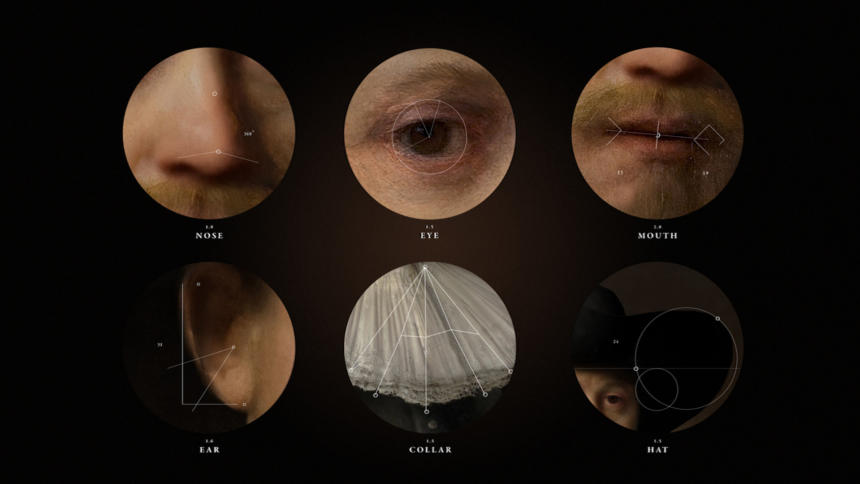

Darüber hinaus sollte laufend überprüft werden, ob KI-Anwendungen neue Risiken bergen, die bisher nicht gesetzlich abgedeckt sind. Konkret warnt der Bericht vor KI-gestützten Methoden zur physischen oder mentalen Überwachung und Identifizierung, etwa emotionales Tracking, DNA-, Iris- oder Verhaltensanalysen, Stimm- und Gesichtserkennung. Solchen Methoden sollte niemand ausgesetzt werden. Sollten sie dennoch eingesetzt werden, etwa für die nationale Sicherheit, so müsse ihr Einsatz evidenzbasiert, angemessen und im Einklang mit Grundrechten erfolgen, empfehlen die Expert:innen.

Neue Gesetzgebung empfiehlt die Gruppe auch für die Überwachung von autonomen Waffensystemen. Mitgliedstaaten sollen sich für ein Moratorium in der Entwicklung solcher Technologien einsetzen. Für Kinder empfiehlt die Gruppe die Einführung eines „Daten-Neustarts“: Alle Daten von Kindern, die vor einer noch nicht definierten Altersgrenze gesammelt wurden, müssten dann gelöscht werden.

Sanfte Hand oder harte Regulierung?

Expert:innen und Organisationen wie Algorithm Watch oder AI Now warnen seit Jahren vor den Risiken, die KI-Systeme – genauer gesagt automatisierte Entscheidungssysteme – für den Einzelnen und die Gesellschaft bedeuten. Dies bezieht sich nicht nur auf die ungeahnten Möglichkeiten staatlicher Überwachung, wie sie China derzeit vorführt. Kritiker:innen verweisen auch auf die unbeabsichtigten Folgen. Die heutigen Systeme arbeiten vorwiegend mit Mustererkennung in großen Datenmengen, dabei sind sie erwiesenermaßen fehleranfällig und neigen zur Diskriminierung von Minderheiten.

Sie benachteiligen Frauen im Bewerbungsprozess, erkennen weiße Gesichter besser als Schwarze und neigen dazu, in den Daten angelegten Rassismus und Sexismus zu reproduzieren oder gar zu verstärken.

Vor diesem Hintergrund streiten Wissenschaftlerinnen, Politiker und die Industrie derzeit auf der ganzen Welt darüber, ob und wie harte Regulierung nötig ist, um den Einsatz dieser Systeme zu steuern. Wer sollte die Regeln festlegen? Die betroffenen Firmen selbst, in Form von Selbstverpflichtungen? Oder doch die Gesetzgeber als bindende Regulierung, inklusive Strafen bei Verstößen? EU-Justizkommissarin Vera Jourová sprach in diesem Zusammenhang davon, die EU verfolge bisher einen eher sanften Ansatz: „Wir wollen Innovation nicht mit Regulierung töten.“

Die 52 Mitglieder der Expert:innengruppe sprechen sich für eine härtere Hand aus, zumindest in kritischen Bereichen: Firmen, deren Produkte dazu geeignet sind, das Leben von Menschen maßgeblich zu beeinflussen oder die Sicherheit zu gefährden, empfehlen sie eine verpflichtende Einschätzung zu den Auswirkungen, bevor das Produkt eingesetzt werden darf. Solche Systeme müssten ihre Entscheidungen nachvollziehbar begründen, überprüfbar handeln und bei nachgewiesenen Fehlern und Rechtsverletzungen sofort angepasst werden können.

Davor, KI-Systeme zu eigenen Personen im rechtlichen Sinn zu erklären, warnt die Gruppe explizit. Dies sei eine fundamentale Abkehr von den Prinzipien menschlicher Handlungsfähigkeit und Verantwortung und aus moralischer Sicht gefährlich, schreiben die Expert:innen. Zuvor hatte das EU-Parlament im Jahr 2017 in einem Entschließungsantrag an die Kommission ähnliches vorgeschlagen und gefordert, „langfristig einen speziellen rechtlichen Status für Roboter zu schaffen, damit zumindest für die ausgeklügeltesten Roboter ein Status als elektronische Person festgelegt werden könnte“. Dies betrifft vor allem autonome Fahrzeuge, bei denen sich in Zukunft die Frage stellt, wer haftet: die passiven Fahrer:innen, der Hersteller oder gar das Fahrzeug selbst?

Reicht regulierung hier wirklich aus oder wäre nicht ein konsequentes Verbot besser ?

Nehmen wir mal an Facebook bringt eine KI auf den Markt welche Bewerber für Stellengesuche vorsortiert. Nehmen wir nun mal an 90% der Firmen und Behörden verwenden diese KI dann um Bewerber vorzusortieren. Nur wer den KI Filter erfolgreich durchläuft wird dann von einem Personaler genauer angesehen.

Wer dann z.B. einen Lebenslauf hat welcher der KI nicht gefällt würde dann automatisch bei allen Bewerbungen abgelehnt werden da ja quasi überall die gleiche KI entscheidet. Langzeitarbeitslosigkeit oder Abrutschen in unterqualifizierte Jobs könnte die Folge sein. Die Leute müssten sich dann also auf eine Weise qualifizieren und fortbilden welche dem Konzernalgorythmus gefällt, oder aber hinnehmen das Sie keine Chance mehr haben.

Bei menschlichen Personalern wäre das ja noch anders, da diese individuell sind und unterschiedlich handeln. Eine Software welche in jedem Fall zu identischen Entscheidungen neigt könnte hier eine ganz neue Form von Klassengesellschaft schaffen welche den gesellschaftlichen Aufstieg für Menschen welche vom Standard abweichen sehr viel schwieriger machen würde.

In gewissen Bereichen sollte daher KI niemals zur Anwendung kommen und besser verboten werden.

Expert:innen sticht aus der Headline heraus. Ist das der Gesslerhut vor dem sich die Netz-Community verbeugen soll?

Zunächst vielen Dank an Netzpolitik.org für die Thematisierung und vor allem für die Verlinkung des Original-Berichts. Selber lesen macht klug.

Doch wer sind die ominösen Expert:innen? Die Personen-Liste findet man am Ende des pdf:

Vertreter:innen aus Forschung und Industrie sind sogenannte Stakeholder, die stark Industrie-lastig sind

Zalando

Airbus

Orange

Nokia Bell Labs

Telenor (Telekom Norwegen)

Bosch

IBM

Bayer (die Monsanto-Übernehmer)

STMicroelectronics

Google (braucht man hier solche Experten??)

AXA (Versicherung)

OKRA Technologies (The OKRA AI engine transforms complex datasets into evidence-based predictions, in real time.)

Lobbyisten:

BDI (Bund Deutscher Industrie)

Orgalim (represents Europe’s technology industries)

So zusammengesetzte Kommissionen sind bessere Lobbyisten-Vereinigungen, die die Belange der Bürger nur alibihaft am Rande ein wenig zu Wort kommen lassen. Zweck solcher Veranstaltungen ist es, der ökonomischen Verwertung die Barrieren aus dem Weg zu räumen, in einer Weise dass man zumindest behaupten kann, man habe sich um Fairness bemüht. Fairness für die Industrie, versteht sich. Bürgerbeteiligung sieht anders aus und brächte auch andere Resultate, wobei ich noch bemerken möchte, dass versteuerte Mindestlöhne eben auch nicht wenig beitragen um notleidende Monopolisten zu subventionieren.